16.19: Inversión de Tiempo en Cadenas de Tiempo Continuas

- Page ID

- 152011

\(\newcommand{\P}{\mathbb{P}}\)\(\newcommand{\E}{\mathbb{E}}\)\(\newcommand{\R}{\mathbb{R}}\)\(\newcommand{\N}{\mathbb{N}}\)\(\newcommand{\Z}{\mathbb{Z}}\)\(\newcommand{\bs}{\boldsymbol}\)\( \newcommand{\cl}{\text{cl}} \)

Anteriormente, estudiamos la inversión de tiempo de las cadenas de Markov de tiempo discreto. En tiempo continuo, los temas son básicamente los mismos. En primer lugar, la propiedad de Markov declaró en la forma que el pasado y el futuro son independientes dado el presente, esencialmente trata el pasado y el futuro simétricamente. No obstante, existe una falta de simetría en el hecho de que en la formulación habitual, tenemos un tiempo inicial 0, pero no un tiempo terminal. Si introducimos un tiempo terminal, entonces podemos ejecutar el proceso hacia atrás en el tiempo. En esta sección, nos interesan las siguientes preguntas:

- ¿El nuevo proceso sigue siendo Markov?

- Si es así, ¿cómo se relacionan los diversos parámetros de la cadena invertida de Markov con los de la cadena original?

- ¿En qué condiciones las cadenas de Markov hacia adelante y hacia atrás son estocásticamente iguales?

La consideración de estas preguntas lleva a cadenas invertidas, una parte importante e interesante de la teoría de las cadenas de Markov en el tiempo continuo. Como siempre, también nos interesa la relación entre las propiedades de una cadena de tiempo continua y las correspondientes propiedades de su cadena de salto de tiempo discreto. En esta sección veremos que existen conexiones simples y elegantes entre la inversión de tiempo de una cadena de tiempo continua y la inversión de tiempo de la cadena de salto.

Teoría Básica

Cadenas invertidas

Nuestro punto de partida es una cadena de Markov de tiempo continuo (homogénea)\( \bs X = \{X_t: t \in [0, \infty)\} \) con espacio estatal (contable)\( S \). Supondremos que eso\( \bs X \) es irreducible, para que cada estado en\( S \) conduzca a cada otro estado, y para evitar trivialidades, asumiremos que hay al menos dos estados. El supuesto de irreductibilidad no implica ninguna pérdida grave de generalidad ya que de otra manera podríamos simplemente restringir nuestra atención a una clase de equivalencia irreducible de estados. Con nuestra notación habitual, dejaremos\( \bs{P} = \{P_t: t \in [0, \infty)\} \) denotar el semigrupo de matrices de transición de\( \bs X \) y\( G \) el generador infinitesimal. Dejar\( \lambda(x) \) denotar el parámetro exponencial para el tiempo de retención en estado\( x \in S \) y\( Q \) la matriz de transición para la cadena de salto de tiempo discreto\( \bs{Y} = (Y_0, Y_1, \ldots) \). Por último, vamos a\( \bs U = \{U_\alpha: \alpha \in [0, \infty)\} \) denotar la colección de matrices potenciales de\( \bs X \). Supondremos que la cadena\( \bs X \) es regular, lo que nos da las siguientes propiedades:

- \( P_t(x, x) \to 1 \)en\( t \downarrow 0 \) cuanto a\( x \in S \).

- No hay estados instantáneos, así que\( \lambda(x) \lt \infty \) para\( x \in S \).

- Los tiempos de transición\( (\tau_1, \tau_2, \ldots) \) satisfacen\( \tau_n \to \infty \) como\( n \to \infty \).

- Podemos suponer que la cadena\( \bs X \) es derecha continua y tiene límites a la izquierda.

El supuesto de regularidad descarta diversos tipos de comportamientos raros que, si bien matemáticamente posibles, no suelen ser apropiados en las aplicaciones. Si\( \bs X \) es uniforme, una suposición más fuerte que la regularidad, tenemos las siguientes propiedades adicionales:

- \( P_t(x, x) \to 1 \)como\( t \downarrow 0 \) uniformemente en\( x \in S \).

- \( \lambda \)está acotado.

- \( P_t = e^{t G} \)para\( t \in [0, \infty) \).

- \( U_\alpha = (\alpha I - G)^{-1} \)para\( \alpha \in (0, \infty) \).

Ahora vamos\( h \in (0, \infty) \). Pensaremos en el tiempo terminal o horizonte temporal por lo que las cadenas en nuestra primera discusión se definirán en el intervalo de tiempo\( [0, h] \).\( h \) Notacionalmente, no nos molestaremos en indicar la dependencia de\( h \), ya que en última instancia el horizonte temporal no importará. Definir\( \hat X_t = X_{h-t} \) para\( t \in [0, h] \). Así, el proceso adelante en el tiempo es\( \bs X = \{X_t: t \in [0, h]\} \) mientras que el proceso hacia atrás en el tiempo es\[ \hat{\bs X} = \{\hat X_t: t \in [0, h]\} = \{X_{h-t}: t \in [0, h]\} \] Similarmente dejar\[\hat{\mathscr F}_t = \sigma\{\hat X_s: s \in [0, t]\} = \sigma\{X_{h-s}: s \in [0, t]\} = \sigma\{X_r: r \in [h - t, h]\}, \quad t \in [0, h]\] Así\( \hat{\mathscr{F}}_t \) es la\( \sigma \) -álgebra de eventos del proceso\( \hat{\bs X} \) hasta el tiempo\( t \), que por supuesto, es también la\( \sigma \) -álgebra de eventos\( \bs X \) de tiempo en\( h - t \) adelante. Nuestro primer resultado es que la cadena invertida en el tiempo sigue siendo Markov

El proceso\( \hat{\bs X } = \{\hat X_t: t \in [0, h]\} \) es una cadena de Markov, pero en general no es homogéneo en el tiempo. Para\( s, \, t \in [0, h] \) con\( s \lt t \), la matriz de transición de\( s \) a\( t \) es\[ \hat{P}_{s, t}(x, y) = \frac{\P(X_{h - t} = y)}{\P(X_{h - s} = x)} P_{t - s}(y, x), \quad (x, y) \in S^2 \]

Prueba

Dejar\( A \in \hat{\mathscr{F}}_s \) y\( x, \, y \in S \). Entonces\ comienza {alinear*}\ P (\ hat x_t = y\ mediados\ hat x_s = x, A) & =\ frac {\ P (\ hat x_t = y,\ hat x_s = x, A)} {\ P (\ hat x_s = x, A)} =\ frac {\ P (X_ {h - t} = y, X_ {h - s} = x, A)} {\ P (X_ {h - s} = x, A)}\\ & =\ frac {\ P (A\ mediados X_ {h - t} = y, X_ {h - s} = x)\ P (X_ {h - s} = x\ mediados X_ {h - t} = y)\ P (X_ {h - t} = y)} {\ P (A\ mid X_ {h - s} = x)\ P (X_ {h - s} = x)}\ end {align*} Pero\( A \in \sigma\{X_r: r \in [h - s, h]\} \) y\( h - t \lt h - s \), así por la propiedad de Markov para\( \bs X \),\[ \P(A \mid X_{h - t} = y, X_{h - s} = x) = \P(A \mid X_{h - s} = x) \] Por la homogeneidad de tiempo de\( \bs X \),\(\P(X_{h - s} = x \mid X_{h - t} = y) = P_{t - s}(y, x)\). Sustitución y simplificación da\[ \P(\hat X_t = y \mid \hat X_s = x, A) = \frac{\P(X_{h - t} = y)}{\P(X_{h - s} = x)} P_{t - s}(y, x) \]

Sin embargo, la cadena al revés será homogénea en el tiempo si\( X_0 \) tiene una distribución invariante.

Supongamos que\( \bs X \) es recurrente positivo, con función de densidad de probabilidad (única) invariante\( f \). Si\( X_0 \) tiene la distribución invariante, entonces\( \hat{\bs X} \) es una cadena de Markov homogénea en el tiempo. La matriz de transición en el momento\( t \in [0, \infty) \) (para cada tiempo terminal\( h \ge t \)), viene dada por\[ \hat P_t(x, y) = \frac{f(y)}{f(x)} P_t(y, x), \quad (x, y) \in S^2 \]

Prueba

Esto se desprende del resultado anterior. Recordemos que si\( X_0 \) tiene PDF\( f \), entonces\( X_{h - t} \) y\( X_{h - s} \) también tener PDF\( f \).

El resultado anterior se mantiene en el límite del tiempo terminal, independientemente de la distribución inicial.

Supongamos nuevamente que\( \bs X \) es recurrente positivo, con función de densidad de probabilidad (única) invariante\( f \). Independientemente de la distribución de\( X_0 \),\[\P(\hat X_{s+t} = y \mid \hat X_s = x) \to \frac{f(y)}{f(x)} P_t(y, x) \text{ as } h \to \infty\]

Prueba

Esto se desprende de la probabilidad condicional anterior y nuestro estudio del comportamiento limitante de las cadenas de Markov en el tiempo continuo. Ya que\( \bs X \) es irreducible y positivo recurrente,\( \P(X_{h - s} = x) \to f(x) \) y\( \P(X_{h - t} = y) \to f(y) \) como\( h \to \infty \) para cada\( x, \, y \in S \).

Estos tres resultados son la motivación para la definición que sigue. Podemos generalizar definiendo la inversión de una cadena irreducible de Markov, siempre y cuando exista una función positiva e invariante. Recordemos que una función invariante positiva define una medida positiva sobre\( S \), pero por supuesto no en general una medida de probabilidad.

Supongamos que\( g: S \to (0, \infty) \) es invariante para\( \bs X \). La inversión de\( \bs X \) con respecto a\( g \) es la cadena de Markov\( \hat{\bs X} = \{\hat X_t: t \in [0, \infty)\} \) con semigrupo de transición\( \hat{\bs{P}} \) definida por\[\hat P_t (x, y) = \frac{g(y)}{g(x)} P_t(y, x), \quad (x, y) \in S^2, \; t \in [0, \infty)\]

Justificación

Necesitamos demostrar que la definición tiene sentido, es decir, que\( \hat{\bs P} \) define un semigrupo de transición para una cadena de Markov que\( \hat{\bs X} \) satisfaga los mismos supuestos a los que nos hemos impuesto\( \bs X \). Primero vamos\( t \in [0, \infty) \). Ya que\( g \) es invariante para\( \bs X \),\[\sum_{y \in S} \hat P_t(x, y) = \frac{1}{g(x)} \sum_{y \in S} g(y) P_t(y, x) = \frac{g(x)}{g(x)} = 1, \quad x \in S\] Por lo tanto\( \hat P_t \) es una matriz de transición válida. A continuación mostramos que las ecuaciones de Chapman-Kolmogorov (la propiedad semigrupo) se mantienen. Dejar\( s, \, t \in [0, \infty) \) y\( x, \, z \in S \). Entonces\ comienza {alinear*}\ hat P_s\ hat P_t (x, z) & =\ sum_ {y\ en S}\ hat P_s (x, y)\ hat P_t (y, z) =\ sum_ {y\ en S}\ frac {g (y)} {g (x)} P_s (y, x)\ frac {g (z)} {g (y)} P_t (z, y)\\ & =\ frac {g (z)} {g (x)}\ sum_ {y\ en S} P_t (z, y) P_s (y, x) =\ frac {g (z)} {g (x)} P_ {s+t} (z, x) =\ hat P_ {s+t} (x, z)\ end {align*} Siguiente tenga en cuenta que\( \hat P_t(x, x) = P_t(x, x) \) para cada\( x \in S \). De ahí que en\( \hat P_t(x, x) \to 1 \)\( t \downarrow 0 \) cuanto a\( x \), también lo\( \hat{\bs P} \) es un semigrupo de transición estándar. Tenga en cuenta también que si\( \bs P \) es uniforme, entonces también lo es\( \hat{\bs P} \). Por último, ya que\( \bs X \) es irreducible,\( P_t(x, y) \gt 0 \) para todos\( (x, y) \in S^2 \) y\( t \in (0, \infty) \). Ya que\( g \) es positivo, se deduce que\( \hat P_t(y, x) \gt 0 \) para cada\( (x, y) \in S^2 \) y\( t \in (0, \infty) \), y por lo tanto también\( \hat{\bs X} \) es irreducible.

Recordemos que si\( g \) es una función invariante positiva para\( \bs X \) entonces también lo es\( c g \) para cada constante\( c \in (0, \infty) \). Obsérvese eso\( g \) y\( c g \) genere la misma cadena invertida. Entonces consideremos los casos:

Supongamos nuevamente que\( \bs X \) es una cadena de Markov que satisface los supuestos anteriores.

- Si\( \bs X \) es recurrente, entonces\( \bs X \) siempre tiene una función invariante positiva\( g \), única hasta la multiplicación por constantes positivas. De ahí que la inversión de una cadena recurrente\( \bs X \) siempre exista y sea única, y así podemos referirnos a la inversión de\( \bs X \) sin referencia a la función invariante.

- Aún mejor, si\( \bs X \) es recurrente positiva, entonces existe una función de densidad de probabilidad invariante única, y la inversión de\( \bs X \) puede interpretarse como la inversión de tiempo (relativa a un horizonte de tiempo) cuando\( \bs X \) tiene la distribución invariante, como en el motivador resultado anterior.

- Si\( \bs X \) es transitorio, entonces puede existir o no una función invariante positiva, y si existe una, puede que no sea única (hasta la multiplicación por constantes positivas). Por lo que una cadena transitoria puede no tener reversiones o más de una.

Sin embargo, la definición general es natural, porque la mayoría de las propiedades importantes de la cadena invertida se derivan de la ecuación de equilibrio básico que relaciona los semigrupos de transición\( \bs{P} \) y\( \hat{\bs{P}} \), y la función invariante\( g \):\[ g(x) \hat P_t(x, y) = g(y) P_t(y, x), \quad (x, y) \in S^2, \; t \in [0, \infty) \] Veremos la ecuación de equilibrio repetido para otros objetos asociados con las cadenas de Markov.

Supongamos nuevamente que\( g: S \to (0, \infty) \) es invariante para\( \bs X \), y esa\( \hat{\bs X} \) es la inversión de tiempo de\( \bs X \) con respecto a\( g \). Entonces

- \( g \)también es invariante para\( \hat{\bs X} \).

- \( \bs X \)es la inversión de tiempo de\( \hat{\bs X} \) con respecto a\( g \).

Prueba

- Para\( y \in S \),\[ g \hat P_t(y) = \sum_{x \in S} g(x) \hat P_t(x, y) = \sum_{x \in S} g(y) P_t(y, x) = g(y) \sum_{x \in S} P_t(y, x) = g(y) \]

- Esto se desprende de la simetría de la ecuación fundamental:\( g(x) \hat P_t(x, y) = g(y) P_t (y, x) \) para\( (x, y) \in S^2 \) y\( t \in [0, \infty) \).

En la ecuación de balance para los semigrupos de transición, no es realmente necesario saber a priori que la función\( g \) es invariante, si conocemos los dos semigrupos de transición.

Supongamos que\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y las cadenas de Markov\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a\( g \) si y solo si\[ g(x) \hat P_t(x, y) = g(y) P_t(y, x), \quad (x, y) \in S^2, \; t \in [0, \infty) \]

Prueba

Todo lo que queda por mostrar es que la ecuación de equilibrio implica que\( g \) es invariante. El cálculo es exactamente el mismo que en el último resultado:\[ g P_t(x) = \sum_{y \in S} g(y) P_t(y, x) = \sum_{y \in S} g(x) \hat P_t (x, y) = g(x) \sum_{y \in S} \hat P_t(x, y) = g(x), \quad x \in S \]

Aquí hay una versión un poco más complicada (pero equivalente) de la ecuación de balance para las probabilidades de transición.

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y las cadenas\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a\( g \) si y sólo si\[ g(x_1) \hat P_{t_1}(x_1, x_2) \hat P_{t_2}(x_2, x_3) \cdots \hat P_{t_n}(x_n, x_{n+1}) = g(x_{n+1}) P_{t_n}(x_{n+1}, x_n) P_{t_{n-1}}(x_n, x_{n-1}) \cdots P_{t_1}(x_2, x_1) \] para todos\( n \in \N_+ \),\( (t_1, t_2, \ldots, t_n) \in [0, \infty)^n \), y\( (x_1, x_2, \ldots, x_{n+1}) \in S^{n+1} \).

Prueba

Todo lo que se necesita es demostrar que la ecuación de equilibrio básico implica la ecuación de equilibrio en el teorema. Cuando\( n = 1 \), tenemos la ecuación del balance básico en sí:\[g(x_1) \hat P_{t_1}(x_1, x_2) = g(x_2) P_{t_1}(x_2, x_1)\] Para\( n = 2 \),\[g(x_1) \hat P_{t_1}(x_1, x_2) \hat P_{t_2}(x_2, x_3) = g(x_2)P_{t_1}(x_2, x_1) \hat P_{t_2}(x_2, x_3) = g(x_3)P_{t_2}(x_3, x_2) P_{t_1}(x_2, x_1)\] Continuar de esta manera (o usando inducción) da el resultado general.

La ecuación de equilibrio se mantiene para las matrices potenciales.

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y las cadenas\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a\( g \) si y solo si las matrices potenciales satisfacen\[ g(x) \hat U_\alpha(x, y) = g(y) U_\alpha(y, x), \quad (x, y) \in S^2, \; \alpha \in [0, \infty) \]

Prueba

Solo tenemos que demostrar que la ecuación de balance para los semigrupos de transición es equivalente a la ecuación de balance anterior para las matrices potenciales. Supongamos primero\( g(x) \hat P_t(x, y) = g(y) P_t(y, x) \) para\( t \in [0, \infty) \) y\( (x, y) \in S^2 \). Entonces\ comienza {alinear*} g (x)\ hat U_\ alfa (x, y) & = g (x)\ int_0^\ infty e^ {-\ alpha t}\ hat p_t (x, y) dt =\ int_0^\ infty e^ {-\ alpha t} g (x)\ hat p_t (x, y) dt\ & =\ int_0^\ infty e^ {-\ alpha t} g (y) P_t (y, x) dt = g (y)\ int_0^\ infty e^ {-\ alpha t} P_t (y, x) dt = g (y) U_\ alpha (y, x)\ end {align*} Por el contrario, supongamos que\( g(x) \hat U_\alpha(x, y) = g(y) U_\alpha(y, x) \) para\( (x, y) \in S^2 \) y\( \alpha \in [0, \infty) \). Como arriba,\[ g(x) \hat U_\alpha(x, y) = \int_0^\infty e^{-\alpha t} g(x) \hat P_t(x, y) dt \] Así para fijo\( (x, y) \in S^2 \), la función\( \alpha \mapsto g(x) \hat U_\alpha(x, y) \) es la transformada de Laplace de la función de tiempo\( t \mapsto g(x) \hat P_t(x, y) \). De igual manera,\( \alpha \mapsto g(y) U_\alpha(x, y) \) es la transformación de Laplace de la\( t \mapsto g(y) P_t(x, y) \). La transformación de Laplace de una función continua determina de manera única la función por lo que sigue que\( g(x) \hat P_t(x, y) = g(y) P_t(y, x) \) para\( t \in [0, \infty) \) y\( (x, y) \in S^2 \).

Como corolario, las cadenas de tiempo continuas que son inversiones de tiempo son del mismo tipo.

Si\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo, entonces\( \bs X \) y\( \hat{\bs X} \) son del mismo tipo: transitorias, recurrentes nulas o recurrentes positivas.

Prueba

Supongamos que\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a la función invariante\( g: S \to (0, \infty) \). Después del resultado anterior,\( \hat U(x, x) = U(x, x) \) para\( x \in S \). Las cadenas son transitorias si el potencial común es finto para cada una\( x \in S \) y recurrentes si el potencial es infinito para cada una\( x \in S \). Supongamos que las cadenas son recurrentes. Entonces\( g \) es único hasta la multiplicación por constantes positivas y las cadenas son ambas positivas recurrentes si\( \sum_{x \in S} g(x) \lt \infty \) y ambas nulas recurrentes si\( \sum_{x \in S} g(x) = \infty \).

La ecuación de equilibrio se extiende a las matrices generadoras infinitesimales.

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y las cadenas de Markov\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo si y solo si los generadores infinitesimales satisfacen\[ g(x) \hat G(x, y) = g(y) G(y, x), \quad (x, y) \in S^2 \]

Prueba

Necesitamos demostrar que la ecuación de balance para los semigrupos de transición es equivalente a la ecuación de equilibrio para los generadores. Supongamos primero que\(g(x) \hat P_t(x, y) = g(y) P_t(y, x)\) para\(t \in [0, \infty)\) y\((x, y) \in S^2\). Tomando derivados con respecto\( t \) y usando la ecuación hacia atrás de Kolmogorov da\( g(x) \hat G \hat P_t(x, y) = g(y) G P_t(y, x) \) para\( t \in [0, \infty) \) y\( (x, y) \in S^2\). Evaluando en\( t = 0 \) da\( g(x) \hat G(x, y) = g(y) G(y, x)\). Por el contrario, supongamos que\(g(x) \hat G(x, y) = g(y) G(y, x)\) para\( (x, y) \in S^2 \). Después la aplicación repetida (o inducción) demuestra que\( g(x) \hat G^n(x, y) = g(y) G^n(y, x) \) para cada\( n \in \N \) y\((x, y) \in S^2\). Si las matrices de transición son uniformes, podemos expresarlas como exponenciales de los generadores. De ahí para\( t \in [0, \infty) \) y\( (x, y) \in S^2 \),\ begin {alinear*} g (x)\ hat P_t (x, y) & = g (x) e^ {t\ hat G (x, y)} = g (x)\ sum_ {n=0} ^\ infty\ frac {t^n} {n!} \ hat g^n (x, y) =\ suma_ {n=0} ^\ infty\ frac {t^n} {n!} g (x)\ sombrero g^n (x, y)\\ & =\ sum_ {n=0} ^\ infty\ frac {t^n} {n!} g (y) g^n (y, x) = g (y)\ suma_ {n=0} ^\ infty\ frac {t^n} {n!} g^n (y, x) = g (y) e^ {t G (y, x)} = g (y) P_t (y, x)\ final {alinear*}

Esto conduce a más resultados y conexiones:

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a\( g \) si y solo si

- \( \hat{\bs X} \)y\( \bs X \) tienen la misma función parmeter exponencial\( \lambda \).

- Las cadenas de salto\( \bs Y \) y\( \hat{\bs Y} \) son (discretas) inversiones de tiempo con respecto a\( \lambda g \).

Prueba

Las funciones de parámetros exponenciales están relacionadas con las matrices generadoras por\( \lambda(x) = - G(x, x) \) y\( \hat \lambda(x) = -\hat G(x, x) \) para\( x \in S \). Las matrices de transición para las cadenas de salto están relacionadas con las matrices generadoras por\( Q(x, y) = G(x, y) / \lambda(x) \) y\( \hat Q(x, y) = \hat G(x, y) / \hat \lambda(x) \) para\( (x, y) \in S^2 \) con\( x \ne y \). De ahí que las condiciones (a) y (b) sean equivalentes a\[ g(x) \hat G(x, y) = g(y) G(y, x), \quad (x, y) \in S^2 \] Recall también de la teoría general, que si\( g \) es invariante para\( \bs X \) entonces\( \lambda g \) es invariante para la cadena de salto\( \bs Y \).

En nuestra discusión original sobre la inversión del tiempo en el caso recurrente positivo, podríamos haber argumentado que los resultados anteriores deben ser ciertos. Si ejecutamos la cadena recurrente positiva\( \bs X = \{X_t: t \in [0, h]\} \) hacia atrás en el tiempo para obtener la cadena inversa de tiempo\( \hat{\bs X} = \{\hat X_t: t \in [0, h]\} \), entonces los parámetros exponenciales para\( \hat{\bs X} \) deben ser los mismos que los de\( \bs X \), y la cadena de salto\( \hat{\bs Y} \) para\( \hat{\bs X} \) debe ser la inversión de tiempo de la cadena de salto\( \bs Y \) para \( \bs X \).

Cadenas Reversibles

Claramente, un caso especial interesante es cuando la inversión temporal de una cadena de Markov en el tiempo continuo es estocásticamente la misma que la cadena original. Una vez más, asumimos que tenemos una cadena regular de Markov\( \bs X = \{X_t: t \in [0, \infty)\} \) que es irreducible en el espacio estatal\( S \), con semigrupo de transición\( \bs P = \{P_t: t \in [0, \infty)\} \). Como antes,\( \bs U = \{U_\alpha: \alpha \in [0, \infty)\} \) denota la colección de matrices potenciales, y\( G \) el generador infinitesimal. Finalmente,\( \lambda \) denota la función de parámetro exponencial,\( \bs Y = \{Y_n: n \in \N\} \) la cadena de salto, y\( Q \) la matriz de transición de\( \bs Y \). Aquí está la definición de reversibilidad:

Supongamos que\( g: S \to (0, \infty) \) es invariante para\( \bs X \). Entonces\( \bs X \) es reversible con respecto a\( g \) si la cadena invertida de tiempo\( \hat{\bs X} = \{\hat X_t: t \in [0, \infty)\} \) también tiene semigrupo de transición\( \bs P \). Es decir,\[ g(x) P_t(x, y) = g(y) P_t(y, x), \quad (x, y) \in S^2, \; t \in [0, \infty) \]

Claramente si\( \bs X \) es reversible con respecto a\( g \) entonces\( \bs X \) es reversible con respecto a\( c g \) para cada\( c \in (0, \infty) \). Entonces aquí hay otra revisión de los casos:

Supongamos que\( \bs X \) es una cadena de Markov que satisface los supuestos anteriores.

- Si\( \bs X \) es recurrente, entonces existe una función invariante\( g: S \to (0, \infty) \) que es única hasta la multiplicación por constantes positivas. Entonces\( \bs X \) es reversible o no, y no tenemos que hacer referencia a la función invariante.

- Aún mejor, si\( \bs X \) es recurrente positivo, entonces existe una función de densidad de probabilidad invariante única\( f \). Nuevamente,\( \bs X \) es reversible o no, pero si lo es, entonces con la distribución invariante, la cadena\( \bs X \) es estocásticamente igual, hacia adelante en el tiempo o hacia atrás en el tiempo.

- Si\( \bs X \) es transitoria, entonces puede existir o no una función invariante positiva. Si tal función existe, puede que no sea única, hasta la multiplicación por constantes positivas. Entonces, en el caso transitorio,\( \bs X \) puede ser reversible con respecto a una función invariante pero no con respecto a otras.

Los siguientes resultados son corolarios de los resultados anteriores para reversiones de tiempo. Primero, no necesitamos saber a priori que la función\( g \) es invariante.

Supongamos que\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si\[ g(x) P_t(x, y) = g(y) P_t(y, x), \quad (x, y) \in S^2, \; t \in [0, \infty) \]

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si\[ g(x_1) P_{t_1}(x_1, x_2) P_{t_2}(x_2, x_3) \cdots P_{t_n}(x_n, x_{n+1}) = g(x_{n+1}) P_{t_n}(x_{n+1}, x_n) P_{t_{n-1}}(x_n, x_{n-1}) \cdots P_{t_1}(x_2, x_1) \] para todos\( n \in \N_+ \),\( (t_1, t_2, \ldots, t_n) \in [0, \infty)^n \), y\( (x_1, x_2, \ldots, x_{n+1}) \in S^{n+1} \).

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si\[ g(x) U_\alpha(x, y) = g(y) U_\alpha(y, x), \quad (x, y) \in S^2, \; \alpha \in [0, \infty) \]

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si\[ g(x) G(x, y) = g(y) G(y, x), \quad (x, y) \in S^2 \]

Supongamos otra vez eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible si y sólo si la cadena de salto\( \bs Y \) es reversible con respecto a\( \lambda g \).

Recordemos que\( \bs X \) es recurrente si y sólo si la cadena de salto\( \bs Y \) es recurrente. En este caso, las funciones invariantes para\( \bs X \) y\( \bs Y \) existen y son únicas hasta constantes positivas. Entonces en este caso, el teorema anterior afirma que\( \bs X \) es reversible si y sólo si\( \bs Y \) es reversible. En el caso recurrente positivo (el caso más importante), el siguiente teorema da una condición para la reversibilidad que no hace referencia directa a la distribución invariante. La condición se conoce como la condición del ciclo Kolmogorov, y lleva el nombre de Andrei Kolmogorov

Supongamos que\( \bs X \) es positivo recurrente. Entonces\( \bs X \) es reversible si y solo si por cada secuencia de estados distintos\( (x_1, x_2, \ldots, x_n) \),\[ G(x_1, x_2) G(x_2, x_3) \cdots G(x_{n-1}, x_n) G(x_n, x_1) = G(x_1, x_n) G(x_n, x_{n-1}) \cdots G(x_3, x_2) G(x_2, x_1) \]

Prueba

Supongamos que\( \bs X \) es reversible, y vamos a\( f \) denotar el PDF invariante de\( \bs X \). Entonces\( G(x, y) = \frac{f(y)}{f(x)} G(x, y) \) para\( (x, y) \in S^2 \). La sustitución da la condición del ciclo Kolmogorov. Por el contrario, supongamos que la condición del ciclo de Kolmogorov se mantiene para\( \bs X \). Recordemos eso\( G(x, y) = \lambda(x) Q(x, y) \) para\( (x, y) \in S^2 \). Sustituir en la condición de ciclo para\( \bs X \) da la condición de ciclo para\( \bs Y \). De ahí\( \bs Y \) que sea reversible y por lo tanto también lo es\( \bs X \).

Obsérvese que la condición del ciclo de Kolmogorov establece que la tasa de transición de los estados visitantes\( (x_2, x_3, \ldots, x_n, x_1) \) en secuencia, comenzando en estado\( x_1 \) es la misma que la tasa de transición de los estados visitantes\( (x_n, x_{n-1}, \ldots, x_2, x_1) \) en secuencia, comenzando en estado\( x_1 \). La condición de ciclo también se conoce como la ecuación de equilibrio para ciclos.

Aplicaciones y ejercicios

La cadena de dos estados

La cadena de dos estados de tiempo continuo ha sido estudiada en nuestras secciones anteriores sobre cadenas de tiempo continuas, por lo que, naturalmente, nos interesa la inversión del tiempo.

Considere la cadena de Markov\( \bs{X} = \{X_t: t \in [0, \infty)\} \) en tiempo continuo\( S = \{0, 1\} \) con tasa\( a \in (0, \infty) \) de transición de 0 a 1 y tasa\( b \in (0, \infty) \) de transición de 1 a 0. Demostrar que\( \bs X \) es reversible

- Usando el semigrupo de transición\( \bs P = \{P_t: t \in [0, \infty)\} \).

- Usando el resolvent\( \bs U = \{U_\alpha: \alpha \in (0, \infty)\} \).

- Usando la matriz generadora\( G \).

Soluciones

Primera nota que\( \bs X \) es irreducible desde\( a \gt 0 \) y\( b \gt 0 \). Ya que\( S \) es finito,\( \bs X \) es positivo recurrente.

- Recordemos que\[ P_t = \frac{1}{a + b} \left[\begin{matrix} b & a \\ b & a \end{matrix} \right] - \frac{1}{a + b} e^{-(a + b)t} \left[\begin{matrix} -a & a \\ b & -b\end{matrix}\right], \quad t \in [0, \infty) \] Todo lo que tenemos que hacer es encontrar una función positiva\( g \) en\( S \) con la propiedad que\( g(0) P_t(0, 1) = g(1) P_t(1, 0) \). Las demás condiciones se cumplen trivialmente. Tenga en cuenta que\( g(0) = b \),\( g(1) = a \) satisface la propiedad. De ello se deduce que\( g \) es invariante para\( \bs X \), único hasta la multiplicación por constantes positivas, y eso\( \bs X \) es reversible.

- Recordemos que\[ U_\alpha = \frac{1}{\alpha (a + b)} \left[\begin{matrix} b & a \\ b & a \end{matrix}\right] - \frac{1}{(\alpha + a + b)(a + b)} \left[\begin{matrix} -a & a \\ b & -b\end{matrix}\right], \quad \alpha \in (0, \infty) \] Una vez más, solo necesitamos encontrar una función positiva\( g \) sobre\( S \) con la propiedad que\( g(0) U_\alpha(0, 1) = g(1) U_\alpha(1, 0) \). Las demás condiciones se cumplen trivialmente. La función\( g \) en la parte (a) satisface, la condición, que por supuesto debe ser el caso.

- Recordemos eso\( G = \left[\begin{matrix} -a & a \\ b & -b \end{matrix} \right] \). Una vez más, solo necesitamos encontrar una función positiva\( g \) en\( S \) con la propiedad que\( g(0) G(0, 1) = g(1) G(1, 0) \). La función\( g \) dada en (a) satisface la condición. Tenga en cuenta que este procedimiento es el más fácil de los tres.

Por supuesto, el PDF invariante\( f \) es\( f(0) = b / (a + b) \),\( f(1) = a / (a + b) \).

Ejercicios Computacionales

La cadena de Markov en el siguiente ejercicio también se ha estudiado en secciones anteriores.

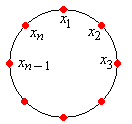

Considere la cadena de Markov\( \bs X = \{X_t: t \in [0, \infty)\} \) encendida\( S = \{0, 1, 2\} \) con función de parámetro exponencial\( \lambda = (4, 1, 3) \) y matriz de transición de salto\[ Q = \left[\begin{matrix} 0 & \frac{1}{2} & \frac{1}{2} \\ 1 & 0 & 0 \\ \frac{1}{3} & \frac{2}{3} & 0\end{matrix}\right] \] Dar cada uno de los siguientes para la cadena inversa de tiempo\( \hat{\bs X} \):

- La gráfica estatal.

- El semigrupo de matrices de transición\( \hat{\bs P} = \{\hat P_t: t \in [0, \infty)\} \).

- La resolución de matrices potenciales\( \hat{\bs U} = \{\hat U_\alpha: \alpha \in (0, \infty)\} \).

- La matriz generadora\( \hat G \).

- La matriz de transición de la cadena de salto\( \hat{\bs Y} \).

Soluciones

Obsérvese que la cadena es irreducible, y ya que\( S \) es finita, recurrente positiva. Anteriormente se encontró que una función invariante (única hasta la multiplicación por constantes positivas) es\( g = (3, 10, 2) \).

- El conjunto de bordes es\( \hat E = \{(1, 0), (2, 0), (0, 1), (0, 2), (1, 2)\} \). La función de parámetro exponencial\( \lambda = (4, 1, 3) \) es la misma que para\( \bs X \).

- La matriz de transición en\( t \in [0, \infty) \) es\[ \hat P_t = \frac{1}{15} \left[\begin{matrix} 3 + 12 e^{-5 t} & 10 - 10 e^{-5 t} & 2 - 2 e^{-5 t} \\ 3 - 3 e^{-3 t} & 10 + 5 e^{-3 t} & 2 - 2 e^{-3 t} \\ 3 - 18 e^{-5 t} + 15 e^{-3 t} & 10 + 15 e^{-5 t} - 25 e^{-3 t} & 2 + 3 e^{-5 t} + 10 e^{-3 t} \end{matrix}\right] \]

- La matriz potencial en\( \alpha \in (0, \infty) \) es\[ \hat U_\alpha = \frac{1}{15 \alpha + 8 \alpha^2 + \alpha^3} \left[\begin{matrix} 3 + 4 \alpha + \alpha^2 & 10 + \frac{10}{3} \alpha & 2 + \frac{2}{3} \alpha \\ 3 + \frac{3}{5} \alpha & 10 + 7 \alpha + \alpha^2 & 2 + \frac{2}{5} \alpha \\ 3 + 3 \alpha & 10 & 2 + 5 \alpha + \alpha^2\end{matrix}\right]\]

- La matriz del generador es\[ \hat G = \left[\begin{matrix} -4 & \frac{10}{3} & \frac{2}{3} \\ \frac{3}{5} & -1 & \frac{2}{5} \\ 3 & 0 & -3 \end{matrix}\right] \]

- La matriz de transición de la cadena de salto es\[ \hat Q = \left[ \begin{matrix} 0 & \frac{5}{6} & \frac{1}{6} \\ \frac{3}{5} & 0 & \frac{2}{5} \\ 1 & 0 & 0 \end{matrix} \right] \]

Modelos Especiales

Lea la discusión sobre la inversión del tiempo para cadenas subordinadas al proceso de Poisson.

Lea la discusión sobre la inversión del tiempo para las cadenas de nacimiento-muerte en tiempo continuo.