16.7: Inversión de Tiempo en Cadenas Discretas de Tiempo

- Page ID

- 152017

El inmueble de Markov, declarado en la forma de que el pasado y el futuro son independientes dado el presente, trata esencialmente el pasado y el futuro simétricamente. No obstante, existe una falta de simetría en el hecho de que en la formulación habitual, tenemos un tiempo inicial 0, pero no un tiempo terminal. Si introducimos un tiempo terminal, entonces podemos ejecutar el proceso hacia atrás en el tiempo. En esta sección, nos interesan las siguientes preguntas:

- ¿El nuevo proceso sigue siendo Markov?

- Si es así, ¿cómo se relaciona la nueva matriz de probabilidad de transición con la original?

- ¿Bajo qué condiciones son los procesos hacia adelante y hacia atrás estocásticamente iguales?

La consideración de estas preguntas lleva a cadenas invertidas, una parte importante e interesante de la teoría de las cadenas de Markov.

Teoría Básica

Cadenas invertidas

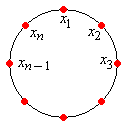

Nuestro punto de partida es una cadena de Markov discreto-tiempo (homogénea)\( \bs X = (X_0, X_1, X_2, \ldots) \) con espacio de estado (contable)\( S \) y matriz de probabilidad de transición\( P \). \( m \)Sea un entero positivo, que pensaremos como el tiempo terminal o horizonte temporal finito. No nos molestaremos en indicar la dependencia de\( m \) notaciones, ya que en última instancia el tiempo terminal no va a importar. Definir\( \hat X_n = X_{m-n} \) para\( n \in \{0, 1, \ldots, m\} \). Así, el proceso adelante en el tiempo es\( \bs X = (X_0, X_1, \ldots, X_m) \) mientras que el proceso hacia atrás en el tiempo es\[ \hat{\bs X} = (\hat X_0, \hat X_1, \ldots, \hat X_m) = (X_m, X_{m-1}, \ldots, X_0) \]

Para\( n \in \{0, 1, \ldots, m\} \), vamos a\[ \hat{\mathscr F}_n = \sigma\{\hat X_0, \hat X_1, \ldots, \hat X_n\} = \sigma\{X_{m-n}, X_{m - n + 1}, \ldots, X_m\} \] denotar el\( \sigma \) álgebra de los eventos del proceso\( \hat{\bs X} \) hasta el tiempo\( n \). Entonces, por supuesto, un evento\( \hat{\bs X} \) hasta el tiempo\( n \) es un evento para\( \bs X \) de vez en\( m - n \) adelante. Nuestro primer resultado es que el proceso invertido sigue siendo una cadena de Markov, pero no homogéneo en el tiempo en general.

El proceso\( \hat{\bs X} = (\hat X_0, \hat X_1, \ldots, \hat X_m) \) es una cadena de Markov, pero en general no es homogéneo en el tiempo. La matriz de transición de un paso en el momento\( n \in \{0, 1, \ldots, m - 1\} \) viene dada por\[ \P(\hat X_{n+1} = y \mid \hat X_n = x) = \frac{\P(X_{m - n - 1} = y)}{\P(X_{m - n} = x)} P(y, x), \quad (x, y) \in S^2\]

Prueba

Dejar\( A \in \hat{\mathscr F}_n \) y\( x, \, y \in S \). Entonces\ comienza {alinear*}\ P (\ hat X_ {n+1} = y\ mediados\ sombrero x_n = x, A) & =\ frac {\ P (\ hat X_ {n+1} = y,\ hat x_n = x, A)} {\ P (\ hat x_n = x, A)} =\ frac {\ P (X_ {m - n - 1} = y, X_ {m - n} = x, A)} {\ P (X_ {m - n} = x, A)}\\ & =\ frac {\ P (A\ mediados X_ {m - n - 1} = y, X_ {m - n} = x)\ P (X_ {m - n} = x\ mediados X_ {m - n - 1} = y)\ P (X_ {m - n - 1} = y)} {\ P (A\ mid X_ {m - n} = x)\ P (X_ {m - n} = x)}\ end {align*} Pero\( A \in \sigma\{X_{m - n}, \ldots, X_m\} \) y así por la propiedad Markov para\( \bs X \),\[ \P(A \mid X_{m - n - 1} = y, X_{m - n} = x) = \P(A \mid X_{m - n} = x) \] Por la homogeneidad de tiempo de\( \bs X \),\(\P(X_{m - n} = x \mid X_{m - n - 1} = y) = P(y, x)\). Sustitución y simplificación da\[ \P(\hat X_{n+1} = y \mid \hat X_n = x, A) = \frac{\P(X_{m - n - 1} = y)}{\P(X_{m - n} = x)} P(y, x) \]

Sin embargo, la cadena al revés será homogénea en el tiempo si\( X_0 \) tiene una distribución invariante.

Supongamos que\( \bs X \) es irreducible y recurrente positivo, con función de densidad de probabilidad (única) invariante\( f \). Si\( X_0 \) tiene la distribución de probabilidad invariante, entonces\( \hat{\bs X} \) es una cadena de Markov homogénea en el tiempo con matriz de transición\( \hat P \) dada por\[ \hat P(x, y) = \frac{f(y)}{f(x)} P(y, x), \quad (x, y) \in S^2 \]

Prueba

Esto se desprende del resultado anterior. Recordemos que si\( X_0 \) tiene PDF\( f \), entonces\( X_k \) tiene PDF\( f \) para cada uno\( k \in \N \).

Recordemos que una cadena de Markov de tiempo discreto es ergódica si es irreducible, recurrente positiva y aperiódica. Para una cadena ergódica, el resultado anterior se mantiene en el límite del tiempo terminal.

Supongamos que\( \bs X \) es ergódico, con función de densidad de probabilidad (única) invariante\( f \). Independientemente de la distribución de\( X_0 \),\[\P(\hat X_{n+1} = y \mid \hat X_n = x) \to \frac{f(y)}{f(x)} P(y, x) \text{ as } m \to \infty\]

Prueba

Esto se desprende de la probabilidad condicional anterior y nuestro estudio del comportamiento limitante de las cadenas de Markov. Ya que\( \bs X \) es ergódica,\( \P(X_k = x) \to f(x) \) como\( k \to \infty \) para cada\( x \in S \).

Estos tres resultados son la motivación para la definición que sigue. Podemos generalizar definiendo la inversión de una cadena irreducible de Markov, siempre y cuando exista una función positiva e invariante. Recordemos que una función invariante positiva define una medida positiva sobre\( S \), pero por supuesto no en general una distribución de probabilidad.

Supongamos que\( \bs X \) es una cadena irreducible de Markov con matriz de transición\( P \), y eso\( g: S \to (0, \infty) \) es invariante para\( \bs X \). La inversión de\( \bs X \) con respecto a\( g \) es la cadena de Markov\( \hat{\bs X} = (\hat X_0, \hat X_1, \ldots) \) con matriz de probabilidad de transición\( \hat P \) definida por\[\hat P(x, y) = \frac{g(y)}{g(x)} P(y, x), \quad (x, y) \in S^2\]

Prueba

Necesitamos demostrar que\( \hat P \) es una matriz de probabilidad de transición válida, para que la definición tenga sentido. Dado que\( g \) es invariante para\( \bs X \),\[\sum_{y \in S} \hat P(x, y) = \frac{1}{g(x)} \sum_{y \in S} g(y) P(y, x) = \frac{g(x)}{g(x)} = 1, \quad x \in S\]

Recordemos que si\( g \) es una función invariante positiva para\( \bs X \) entonces también lo es\( c g \) para cada constante positiva\( c \). Obsérvese eso\( g \) y\( c g \) genere la misma cadena invertida. Entonces consideremos los casos:

Supongamos que\( \bs X \) es una cadena irreducible de Markov en\( S \).

- Si\( \bs X \) es recurrente, entonces\( \bs X \) siempre tiene una función invariante positiva que es única hasta la multiplicación por constantes positivas. De ahí que la inversión de una cadena recurrente\( \bs X \) siempre exista y sea única, y así podemos referirnos a la inversión de\( \bs X \) sin referencia a la función invariante.

- Aún mejor, si\( \bs X \) es recurrente positiva, entonces existe una función de densidad de probabilidad invariante única, y la inversión de\( \bs X \) puede interpretarse como la inversión de tiempo (con respecto a un tiempo terminal) cuando\( \bs X \) tiene la distribución invariante, como en el motivador ejercicios anteriores.

- Si\( \bs X \) es transitorio, entonces puede existir o no una función invariante positiva, y si existe una, puede que no sea única (hasta la multiplicación por constantes positivas). Por lo que una cadena transitoria puede no tener reversiones o más de una.

Sin embargo, la definición general es natural, porque la mayoría de las propiedades importantes de la cadena invertida se derivan de la ecuación de equilibrio entre las matrices de transición\( P \) y\( \hat P \), y la función invariante\( g \):\[ g(x) \hat P(x, y) = g(y) P(y, x), \quad (x, y) \in S^2 \] Veremos esta ecuación de equilibrio repetida con otros objetos relacionados con las cadenas de Markov.

Supongamos que\( \bs X \) es una cadena irreducible de Markov con función invariante\( g: S \to (0, \infty) \), y esa\( \hat{\bs X} \) es la reversión de\( \bs X \) con respecto a\( g \). Para\( x, \, y \in S \),

- \( \hat P(x, x) = P(x, x) \)

- \( \hat P(x, y) \gt 0 \)si y solo si\( P(y, x) \gt 0 \)

Prueba

Estos resultados siguen inmediatamente de la ecuación de equilibrio\( g(x) \hat P(x, y) = g(y) P(y, x) \) para\( (x, y) \in S^2 \).

De la parte (b) se deduce que las gráficas estatales de\( \bs X \) y\( \hat{\bs X} \) son reversas unas de otras. Es decir, para pasar de la gráfica estatal de una cadena a la gráfica estatal de la otra, simplemente invertir la dirección de cada borde. Aquí hay una versión más complicada (pero equivalente) de la ecuación de balance para cadenas de estados:

Supongamos nuevamente que\( \bs X \) es una cadena irreducible de Markov con función invariante\( g: S \to (0, \infty) \), y esa\( \hat{\bs X} \) es la reversión de\( \bs X \) con respecto a\( g \). Para todas\( n \in \N_+ \) y cada una de las secuencias de estados\( (x_1, x_2, \ldots, x_n, x_{n+1}) \in S^{n+1} \),\[ g(x_1) \hat P(x_1, x_2) \hat P(x_2, x_3) \cdots \hat P(x_n, x_{n+1}) = g(x_{n+1}) P(x_{n+1}, x_n) \cdots P(x_3, x_2) P(x_2, x_1) \]

Prueba

Esto se deduce de repetidas aplicaciones de la ecuación básica. Cuando\( n = 1 \), tenemos la ecuación del balance en sí:\[g(x_1) \hat P(x_1, x_2) = g(x_2) P(x_2, x_1)\] Para\( n = 2 \),\[g(x_1) \hat P(x_1, x_2) \hat P(x_2, x_3) = g(x_2)P(x_2, x_1)\hat P(x_2, x_3) = g(x_3)P(x_3, x_2)P(x_2, x_1)\] Continuar de esta manera (o usando inducción) da el resultado general.

La ecuación de equilibrio se mantiene para las potencias de la matriz de transición:

Supongamos nuevamente que\( \bs X \) es una cadena irreducible de Markov con función invariante\( g: S \to (0, \infty) \), y esa\( \hat{\bs X} \) es la reversión de\( \bs X \) con respecto a\( g \). Para todos\( (x, y) \in S^2 \) y\( n \in \N \),\[ g(x) \hat P^n(x, y) = g(y) P^n (y, x) \]

Prueba

Cuando\( n = 0 \), los lados izquierdo y derecho son\( g(x) \) si\( x = y \) y son 0 en caso contrario. Cuando\( n = 1 \), tenemos la ecuación de equilibrio básico:\( g(x) \hat P(x, y) = g(y) P(y, x) \). En general, for\( n \in \N_+ \), por el resultado anterior tenemos\ begin {align*} g (x)\ hat P^n (x, y) &=\ sum_ {(x_1,\ ldots, x_ {n-1})\ in S^ {n-1}} g (x)\ hat P (x, x_1)\ hat P (x_1)\ hat P (x_1, x_2)\ cdots\ hat P (x_ {n-1}, y)\\ &=\ suma_ {(x_1,\ ldots, x_ {n-1})\ en S^ {n-1}} g (y) P (y, x_ {n-1}) P (x_ {n-1}, x_ {n-2})\ cdots P (x_1, x) = g (y) P^n (y, x)\ final {alinear*}

Ahora podemos generalizar el resultado simple anterior.

Supongamos nuevamente que\( \bs X \) es una cadena irreducible de Markov con función invariante\( g: S \to (0, \infty) \), y esa\( \hat{\bs X} \) es la reversión de\( \bs X \) con respecto a\( g \). Para\( n \in \N \) y\( (x, y) \in S^2 \),

- \( P^n(x, x) = \hat P^n(x, x) \)

- \( \hat P^n(x, y) \gt 0 \)si y solo si\( P^n(y, x) \gt 0 \)

En términos de las gráficas de estado, la parte (b) tiene un significado obvio: Si existe una ruta de longitud\( n \) de\( y \) a\( x \) en la gráfica de estado original, entonces existe una ruta de longitud\( n \) de\( x \) a\( y \) en la gráfica de estado invertido. La definición de inversión de tiempo es simétrica con respecto a las dos cadenas de Markov.

Supongamos nuevamente que\( \bs X \) es una cadena irreducible de Markov con función invariante\( g: S \to (0, \infty) \), y esa\( \hat{\bs X} \) es la reversión de\( \bs X \) con respecto a\( g \). Entonces

- \( g \)también es invariante para\( \hat{\bs X} \).

- \( \hat{\bs X} \)también es irreducible.

- \( \bs X \)es la reversión de\( \hat{\bs X} \) con respecto a\( g \).

Prueba

- Para\( y \in S \), usando la ecuación de balance,\[\sum_{x \in S} g(x) \hat P(x, y) = \sum_{x \in S} g(y) P(y, x) = g(y)\]

- Supongamos\( (x, y) \in S^2 \). Ya que\( \bs X \) es irreducible, existen\( n \in \N \) con\( P^n(y, x) \gt 0 \). Pero luego a partir del resultado anterior,\( \hat P^n(x, y) \gt 0 \). De ahí\( \hat{\bs X} \) que también sea irreducible.

- Esto queda claro a partir de la relación simétrica en el resultado fundamental.

La ecuación de equilibrio también se mantiene para las matrices potenciales.

Supongamos que\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a la función invariante\( g: S \to (0, \infty) \). Para\( \alpha \in (0, 1] \), las matrices\( \alpha \) potenciales están relacionadas por\[ g(x) \hat R_\alpha(x, y) = g(y) R_\alpha(y, x), \quad (x, y) \in S^2 \]

Prueba

Esto se desprende fácilmente del resultado anterior y la definición de las matrices potenciales:\ begin {align*} g (x)\ hat R_\ alpha (x, y) & = g (x)\ sum_ {n=0} ^\ infty\ alpha^n\ hat p^n (x, y) =\ sum_ {n=0} ^\ infty\ alpha^n g (x)\ hat p^n (x, y)\\ & =\ suma_ {n=0} ^\ infty\ alfa^n g (y) p^n (y, x) = g (y)\ suma_ {n= 0} ^\ infty\ alfa^n p^n (y, x) = g (y) R_\ alfa (y, x)\ final {alinear*}

Las cadenas de Markov que son inversiones de tiempo comparten muchas propiedades importantes:

Supongamos que\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo. Entonces

- \( \bs X \)y\( \hat{\bs X} \) son del mismo tipo (transitorio, recurrente nulo o recurrente positivo).

- \( \bs X \)y\( \hat{\bs X} \) tener el mismo periodo.

- \( \bs X \)y\( \hat{\bs X} \) tener el mismo tiempo medio de retorno\( \mu(x) \) para cada\( x \in S \).

Prueba

Supongamos que\( \bs X \) y\( \hat{\bs X} \) son inversiones de tiempo con respecto a la función invariante\( g: S \to (0, \infty) \).

- El número esperado de visitas a un estado\( x \in S \), a partir de\( x \), es el mismo para ambas cadenas:\( \hat R(x, x) = R(x, x) \). De ahí que ambas cadenas sean transitorias (si el potencial común es finito) o ambas cadenas son recurrentes (si el potencial común es infinito). Si ambas cadenas son recurrentes entonces la función invariante\( g \) es única hasta la multiplicación por constantes positivas, y ambas son nulas recurrentes si\( \sum_{x \in S} g(x) = \infty \) y ambas son positivas recurrentes si\( \sum_{x \in S} g(x) \lt \infty \).

- Esto sigue ya que\( P^n(x, x) = \hat P^n(x, x) \) para todos\( n \in \N \) y\( x \in S \).

- Si ambas cadenas son transitorias o ambas son nulas recurrentes, entonces\( \mu(x) = \hat \mu(x) = \infty \) para todas\( x \in S \). Si ambas cadenas son recurrentes positivas, entonces para todos\( n \in \N \) y\( x \in S \), tenemos\[\frac{1}{n} \sum_{k = 1}^n P^k(x, x) = \frac{1}{n} \sum_{k = 1}^n \hat P^k(x, x)\] El lado izquierdo converge a\( 1 / \mu(x) \) como\( n \to \infty \) mientras el lado derecho converge a\( 1 / \hat \mu(x) \) as\( n \to \infty \).

El punto principal del siguiente resultado es que no necesitamos saber a priori que\( g \) es invariante para\( \bs X \), si podemos adivinar\( g \) y\( \hat P \).

Supongamos nuevamente que\( \bs X \) es irreducible con la matriz de probabilidad de transición\( P \). Si existe una función a\( g: S \to (0, \infty) \) y una matriz de probabilidad de transición\( \hat P \) tal que\( g(x) \hat P(x, y) = g(y) P(y, x) \) para todos\( (x, y) \in S^2 \), entonces

- \( g \)es invariante para\( \bs X \).

- \( \hat P \)es la matriz de transición de la inversión de\( \bs X \) con respecto a\( g \).

Prueba

- Dado que\( \hat P \) es una matriz de probabilidad de transición, tenemos el mismo cálculo que hemos visto antes:\[g P(x) = \sum_{y \in S} g(y) P(y, x) = \sum_{y \in S} g(x) \hat P(x, y) = g(x), \quad x \in S\]

- Esto se desprende de (a) y la definición.

Como corolario, si existe una función de densidad de probabilidad\( f \) sobre\( S \) y una matriz de probabilidad de transición\( \hat P \) tal que\( f(x) \hat P(x, y) = f(y) P(y, x) \) para todos\( (x, y) \in S^2 \) entonces además de las conclusiones anteriores, sabemos que las cadenas\( \bs X \) y\( \hat{\bs X} \) son recurrentes positivas.

Cadenas Reversibles

Claramente, un caso especial interesante ocurre cuando la matriz de transición de la cadena invertida resulta ser la misma que la matriz de transición original. Una cadena de este tipo podría ser utilizada para modelar un proceso físico que es estocásticamente el mismo, hacia adelante o hacia atrás en el tiempo.

Supongamos nuevamente que\( \bs X = (X_0, X_1, X_2, \ldots) \) es una cadena irreducible de Markov con matriz de transición\( P \) y función invariante\( g: S \to (0, \infty) \). Si la inversión de\( \bs X \) con respecto a\( g \) también tiene matriz de transición\( P \), entonces\( \bs X \) se dice que es reversible con respecto a\( g \). Es decir,\( \bs X \) es reversible con respecto a\( g \) si y solo si\[ g(x) P(x, y) = g(y) P(y, x), \quad (x, y) \in S^2 \]

Claramente si\( \bs X \) es reversible con respecto a la función invariante\( g: S \to (0, \infty) \) entonces\( \bs X \) es reversible con respecto a la función invariante\( c g \) para cada\( c \in (0, \infty) \). Entonces nuevamente, revisemos los casos.

Supongamos que\( \bs X \) es una cadena irreducible de Markov en\( S \).

- Si\( \bs X \) es recurrente, existe una función invariante positiva que es única hasta la multiplicación por constantes positivas. Entonces\( \bs X \) es reversible o no, y no tenemos que hacer referencia a la función invariante\( g \).

- Si\( \bs X \) es positivo recurrente entonces existe una función de densidad de probabilidad invariante única\( f: S \to (0, 1) \), y nuevamente, o bien\( \bs X \) es reversible o no. Si\( \bs X \) es reversible, entonces\( P \) es la matriz de transición de\( \bs X \) hacia adelante o hacia atrás en el tiempo, cuando la cadena tiene la distribución invariante.

- Si\( \bs X \) es transitorio, puede existir o no funciones invariantes positivas. Si hay dos o más funciones invariantes positivas que no son multiplicaciones entre sí,\( \bs X \) podrían ser reversibles con respecto a una función pero no a las otras.

El simple paseo aleatorio no simétrico\( \Z \) cae en el último caso. Utilizando el último resultado en la subsección anterior, podemos decir si\( \bs X \) es reversible con respecto a\( g \) sin saber a priori que\( g \) es invariante.

Supongamos nuevamente que\( \bs X \) es irreducible con matriz de transición\( P \). Si existe una función\( g: S \to (0, \infty) \) tal que\( g(x) P(x, y) = g(y) P(y, x) \) para todos\( (x, y) \in S^2 \), entonces

- \( g \)es invariante para\( \bs X \).

- \( \bs X \)es reversible con respecto a\( g \)

Si tenemos razones para creer que una cadena de Markov es reversible (basada en consideraciones de modelado, por ejemplo), entonces la condición en el teorema anterior se puede utilizar para encontrar las funciones invariantes. Este procedimiento suele ser más fácil que usar la definición de invarianza directamente. Los siguientes dos resultados son generalizaciones menores:

Supongamos otra vez que eso\( \bs X \) es irreducible y eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si por todas\( n \in \N_+ \) y cada una de las secuencias de estados\( (x_1, x_2, \ldots x_n, x_{n+1}) \in S^{n+1} \),\[ g(x_1) P(x_1, x_2) P(x_2, x_3) \cdots P(x_n, x_{n+1}) = g(x_{n+1}) P(x_{n+1}, x_n), \cdots P(x_3, x_2) P(x_2, x_1) \]

Supongamos otra vez que eso\( \bs X \) es irreducible y eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si por cada\( (x, y) \in S^2 \) y\( n \in \N_+ \),\[ g(x) P^n(x, y) = g(y) P^n(y, x) \]

Aquí está la condición para la reversibilidad en términos de las matrices potenciales.

Supongamos otra vez que eso\( \bs X \) es irreducible y eso\( g: S \to (0, \infty) \). Entonces\( g \) es invariante y\( \bs X \) es reversible con respecto a\( g \) si y solo si\[ g(x) R_\alpha(x, y) = g(y) R_\alpha(y, x), \quad \alpha \in (0, 1], \, (x, y) \in S^2 \]

En el caso recurrente positivo (el caso más importante), el siguiente teorema da una condición para la reversibilidad que no hace referencia directa a la distribución invariante. La condición se conoce como la condición del ciclo Kolmogorov, y lleva el nombre de Andrei Kolmogorov

Supongamos que\( \bs X \) es irreducible y recurrente positivo. Entonces\( \bs X \) es reversible si y solo si por cada secuencia de estados\( (x_1, x_2, \ldots, x_n) \),\[ P(x_1, x_2) P(x_2, x_3) \cdots P(x_{n-1}, x_n) P(x_n, x_1) = P(x_1, x_n) P(x_n, x_{n-1}) \cdots P(x_3, x_2) P(x_2, x_1) \]

Prueba

Supongamos que eso\( \bs X \) es reversible. La aplicación del resultado de la cadena anterior a la secuencia\( (x_1, x_2, \ldots, x_n, x_1) \) da la condición del ciclo de Kolmogorov. Por el contrario, supongamos que la condición del ciclo de Kolmogorov mantiene, y vamos a\( f \) denotar la función de densidad de probabilidad invariante de\( \bs X \). De la condición del ciclo que tenemos\( P(x, y) P^k(y, x) = P(y, x)P^k(x, y) \) para cada\( (x, y) \in S \) y\( k \in \N_+ \). Averaging over\( k \) from 1 to\( n \) gives\[ P(x, y) \frac{1}{n} \sum_{k=1}^n P^k(y, x) = P(y, x) \frac{1}{n} \sum_{k = 1}^n P^k(x, y), \quad (x, y) \in S^2, \; n \in \N_+ \] Letting\( n \to \infty \) gives\(f(x) P(x, y) = f(y) P(y, x) \) for\( (x, y) \in S^2 \), so\( \bs X \) is reversible.

Obsérvese que la condición del ciclo de Kolmogorov establece que la probabilidad de visitar estados\( (x_2, x_3, \ldots, x_n, x_1) \) en secuencia, comenzando en estado\( x_1 \) es la misma que la probabilidad de visitar estados\( (x_n, x_{n-1}, \ldots, x_2, x_1) \) en secuencia, comenzando en estado\( x_1 \). La condición de ciclo también se conoce como la ecuación de equilibrio para ciclos.

Ejemplos y Aplicaciones

Cadenas Finitas

Recordemos la cadena general de dos estados\( S = \{0, 1\} \) con\( \bs X \) la matriz de probabilidad de transición\[ P = \left[ \begin{matrix} 1 - p & p \\ q & 1 - q \end{matrix} \right] \] donde\( p, \, q \in (0, 1) \) están los parámetros. La cadena\( \bs X \) es reversible y la función de densidad de probabilidad invariante es\( f = \left( \frac{q}{p + q}, \frac{p}{p + q} \right) \).

Prueba

Todo lo que tenemos que hacer es señalar que\[\left[\begin{matrix} q & p \end{matrix}\right] \left[ \begin{matrix} 1 - p & p \\ q & 1 - q \end{matrix} \right] = \left[\begin{matrix} q & p \end{matrix}\right]\]

Supongamos que\( \bs X \) es una cadena de Markov en un espacio de estado finito\( S \) con matriz de probabilidad de transición simétrica\( P \). Así\( P(x, y) = P(y, x) \) para todos\( (x, y) \in S^2 \). La cadena\( \bs X \) es reversible y que la distribución uniforme\( S \) es invariante.

Prueba

Todo lo que tenemos que hacer es señalar que\( \bs{1}(x) P(x, y) = \bs{1}(y) P(y, x) \) donde\( \bs{1} \) está la función constante 1 on\( S \).

Considere la cadena de Markov\( S = \{a, b, c\} \) con\( \bs X \) la matriz de probabilidad de transición\( P \) dada a continuación:

\[ P = \left[ \begin{matrix} \frac{1}{4} & \frac{1}{4} & \frac{1}{2} \\ \frac{1}{3} & \frac{1}{3} & \frac{1}{3} \\ \frac{1}{2} & \frac{1}{2} & 0 \end{matrix} \right] \]- Dibuja la gráfica de estado de\( \bs X \) y anote que la cadena es irreducible.

- Encuentra la función de densidad de probabilidad invariante\( f \).

- Encuentra el tiempo medio de retorno a cada estado.

- Encuentra la matriz de probabilidad de transición\( \hat P \) de la cadena de tiempo invertido\( \hat{\bs X} \).

- Dibuja la gráfica estatal de\( \hat{\bs X} \).

Contestar

-

Gráfica estatal de\( \bs X \)

- \( f = \left( \frac{6}{17}, \frac{6}{17}, \frac{5}{17}\right) \)

- \( \mu = \left( \frac{17}{6}, \frac{17}{6}, \frac{17}{5} \right) \)

- \( \hat P = \left[ \begin{matrix} \frac{1}{4} & \frac{1}{3} & \frac{5}{12} \\ \frac{1}{4} & \frac{1}{3} & \frac{5}{12} \\ \frac{3}{5} & \frac{2}{5} & 0 \end{matrix} \right] \)

-

Gráfica estatal de\( \hat{\bs X} \)

Modelos Especiales

Lee la discusión de reversibilidad para las cadenas Ehrenfest.

Lee la discusión de reversibilidad para la cadena Bernoulli-Laplace.

Lea la discusión de reversibilidad para las caminatas aleatorias sobre gráficas.

Lea la discusión sobre la inversión de tiempo para las cadenas de confiabilidad.

Lea la discusión sobre la reversibilidad para las cadenas de nacimiento y muerte.