6.7: Teorema de capacidad de canal ruidoso

- Page ID

- 82039

La capacidad de canal de un canal ruidoso se define en términos de la información mutua\(M\). Sin embargo, en general\(M\) depende no solo del canal (a través de las probabilidades de transferencia\(c_{ji}\)) sino también de la entrada

distribución de probabilidad\(p(A_i)\). Es más útil definir la capacidad del canal para que dependa únicamente del canal, por lo que\(M_{\text{max}}\), se utiliza la máxima información mutua que resulta de cualquier posible distribución de probabilidad de entrada. En el caso del canal binario simétrico, este máximo ocurre cuando las dos probabilidades de entrada son iguales. En términos generales, alejarse del caso simétrico ofrece pocas o ninguna ventaja en los sistemas de ingeniería, y en particular los límites fundamentales dados por los teoremas de este capítulo no pueden ser evadidos a través de tales técnicas. Por lo tanto, el caso simétrico da la comprensión intuitiva correcta.

La capacidad del canal se define como

\(C = M_{\text{max}}W \tag{6.29}\)

donde\(W\) es la velocidad máxima a la que el estado de salida puede seguir los cambios en la entrada. Así\(C\) se expresa en bits por segundo.

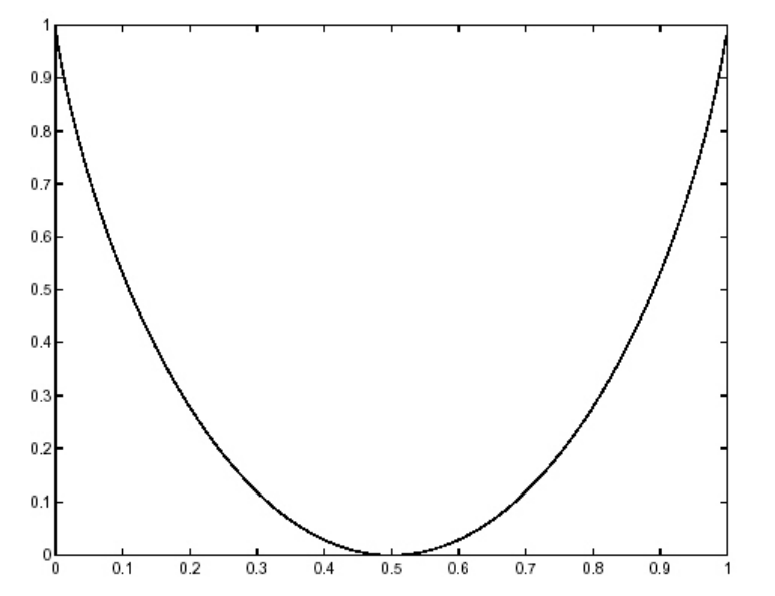

El teorema de la capacidad del canal fue probado por primera vez por Shannon en 1948. Da un límite fundamental a la velocidad a la que la información puede transmitirse a través de un canal. Si la tasa de información de entrada en bits por segundo\(D\) es menor que\(C\) entonces es posible (tal vez tratando con largas secuencias de entradas juntas) codificar los datos de tal manera que la tasa de error sea tan baja como se desee. Por otro lado, si\(D > C\) entonces esto no es posible; de hecho la velocidad máxima a la que se puede inferir información sobre la entrada a partir del aprendizaje de la salida es\(C\). Este resultado es exactamente el mismo que el resultado para el canal sin ruido, mostrado en la Figura 6.4.

Este resultado es realmente bastante notable. Se definió una cifra de capacidad, que depende únicamente del canal, y luego el teorema establece que se puede encontrar un código que da rendimiento arbitrariamente cercano a esta capacidad. En conjunto con el teorema de codificación de origen, implica que un canal de comunicación puede diseñarse en dos etapas: primero, la fuente se codifica de manera que la longitud promedio de las palabras de código sea igual a su entropía, y segundo, este flujo de bits se puede transmitir a cualquier velocidad hasta la capacidad del canal con error arbitrariamente bajo. La capacidad del canal no es la misma que la velocidad nativa a la que la entrada puede cambiar, sino que se degrada a partir de ese valor debido al ruido.

Desafortunadamente, la prueba de este teorema (que no se da aquí) no indica cómo ir para encontrar tal código. Es decir, no se trata de una prueba constructiva, en la que se prueba la aseveración al exhibir el código. En el medio siglo desde que Shannon publicó este teorema, ha habido numerosos descubrimientos de mejores y mejores códigos, para satisfacer una variedad de necesidades de comunicación de datos de alta velocidad. Sin embargo, todavía no existe ninguna teoría general de cómo diseñar códigos desde cero (como el procedimiento Huffman prevé la codificación fuente).

Claude Shannon (1916-2001) es considerado con razón como la figura más grande de las comunicaciones en toda la historia. \(^2\)Estableció todo el campo de la investigación científica conocido hoy en día como teoría de la información. Realizó este trabajo mientras estaba en Laboratorios Bell, luego de graduarse del MIT con su S.M. en ingeniería eléctrica y su doctorado en matemáticas. Fue él quien reconoció al dígito binario como el elemento fundamental en todas las comunicaciones. En 1956 regresó al MIT como miembro de la facultad. En su vida posterior padecía la enfermedad de Alzheimer y, lamentablemente, no pudo asistir a un simposio celebrado en el MIT en 1998 en honor al 50 aniversario de su ponencia seminal.

\(^2\)See a biography of Shannon at http://www-groups.dcs.st-andrews.ac....s/Shannon.html