6.3: Las ecuaciones diferenciales de Kolmogorov

- Page ID

- 86251

\(P_{ij} (t)\)Sea la probabilidad de que un proceso de Markov {\(X(t); t \geq 0\)} esté en estado en\(j\) el momento\(t\) dado que\(X(0) = i\),

\[ P_{ij}(t) = P\{X(t)=j|X(0)=i \} \nonumber \]

\(P_{ij} (t)\)es análogo a las probabilidades de transición de\(n^{th}\) orden\(P_{ij}^n\) para las cadenas de Markov. Ya lo hemos visto\(\lim_{t\rightarrow \infty} P_{ij} \ref{t} = p_j\) para el caso donde la cadena incrustada es positiva recurrente y\(\sum_i \pi_i/\nu_i < \infty\). Aquí queremos encontrar el comportamiento transitorio, y comenzamos por derivar las ecuaciones de Chapman-Kolmogorov para los procesos de Markov. Dejemos\(s\) y\(t\) sean tiempos arbitrarios,\(0 < s < t\). Al incluir el estado en el momento\(s\), podemos reescribir (6.3.1) como

\[ \begin{align} P_{ij}(t) \quad &= \quad \sum_k \text{Pr}\{X(t)=j, \, X(s)=k|X(0)=i \} \nonumber \\ &= \quad \sum_k \text{Pr} \{X(s)=k | X(0)=i\} \, \, \text{Pr}\{X(t)=j |X(s)=k \} ; \qquad \text{all }i,j \end{align} \nonumber \]

donde hemos usado la condición de Markov, (6.1.3). Dado eso\(X(s) = k\), el tiempo residual hasta la siguiente transición posterior\(s\) es exponencial con tasa\(\nu_k\), y así el proceso que inicia en tiempo\(s\) en estado\(k\) es estadísticamente idéntico al que comienza en el tiempo 0 en estado\(k\). Así, para cualquier\(s\)\(0 \leq s \leq t\), tenemos

\[ P\{ X(t)=j | X(s)=k \} = P_{kj} (t-s) \nonumber \]

Sustituyendo esto en (6.3.2), tenemos las ecuaciones de Chapman-Kolmogorov para un proceso de Markov,

\[ P_{ij}(t) = \sum_k P_{ik}(s)P_{kj}(t-s) \nonumber \]

Estas ecuaciones corresponden a\ ref {3.8} para las cadenas de Markov. Ahora usamos estas ecuaciones para derivar dos tipos de conjuntos de ecuaciones dierenciales para\(P_{ij} (t)\). Las primeras se denominan ecuaciones diferenciales hacia adelante de Kolmogorov, y las segundas las ecuaciones diferenciales hacia atrás de Kolmogorov. Las ecuaciones hacia adelante se obtienen dejando\(s\) acercarse\(t\) desde abajo, y las ecuaciones hacia atrás se obtienen al dejar\(s\) acercarse a 0 desde arriba. Primero derivamos las ecuaciones hacia adelante.

Para\(t- s\) pequeños y positivos,\(P_{kj} (t- s)\) en (6.3.3) se puede expresar como\((t-s)q_{kj} + o(t-s)\) para\(k \neq j\). De igual manera, se\(P_{jj} (t- s)\) puede expresar como\(1 -(t-s)\nu_j + o(s)\). Así (6.3.3) se convierte

\[ P_{ij}(t)=\sum_{k\neq j} [P_{ik}(s)(t-s) q_{kj}] + P_{ij}(s)[1-(t-s)\nu_j] + o(t-s) \nonumber \]

Queremos expresar esto, en el límite\(s \rightarrow t\), como una ecuación diferencial. Para ello, restar\(P_{ij} (s)\) de ambos lados y dividir por\(t- s\).

\[ \dfrac{P_{ij}(t)-P_{ij}(s)}{t-s} = \sum_{k\neq j} (P_{ik}(s)q_{kj})-P_{ij}(s)\nu_j+\dfrac{o(s)}{s} \nonumber \]

Tomando el límite como\(s \rightarrow t\) desde abajo, 1 obtenemos las ecuaciones hacia adelante de Kolmogorov,

\[ \dfrac{dP_{ij}(t)}{dt} = \sum_{k\neq j} (P_{ik}(t)q_{kj})-P_{ij}(t)\nu_j \nonumber \]

El primer término en el lado derecho de (6.3.5) es la velocidad a la que las transiciones ocurren\(j\) al estado en el tiempo\(t\) y el segundo término es la velocidad a la que las transiciones ocurren fuera de estado\(j\). Por lo tanto, la diferencia de estos términos es la tasa neta a la que ocurren las transiciones hacia\(j\), que es la velocidad a la que\(P_{ij} (t)\) está aumentando en el momento\(t\).

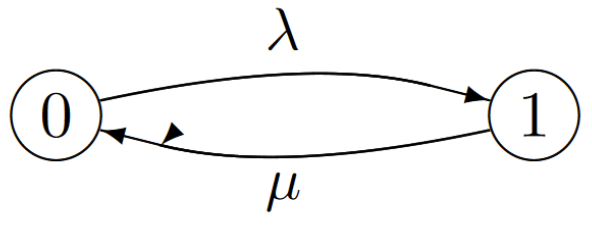

Ejemplo 6.3.1 (Una cola M/M/1 sin cola) Considere el siguiente proceso de Markov de 2 estados donde\(q_{01} = \lambda\) y\(q_{10} = µ\).

Esto se puede ver como un modelo para una cola M/M/1 sin almacenamiento para clientes en espera. Cuando el sistema está vacío (estado 0), los clientes sin memoria llegan a la tarifa\(\lambda\), y cuando el servidor está ocupado, un servidor exponencial opera a la velocidad\(µ\), con el sistema volviendo al estado 0 cuando se completa el servicio.

Para encontrar\(P_{01}(t)\), la probabilidad de estado 1 en tiempo\(t\) condicional al estado 0 en el tiempo 0, usamos las ecuaciones hacia adelante de Kolmogorov para\(P_{01}(t)\), obteniendo

\[ \dfrac{dP_{01}(t)}{dt} = P_{00}(t) q_{01}-P_{01}(t)\nu_1 = P_{00}(t)\lambda -P_{01}(t)\mu \nonumber \]

Usando el hecho de que\(P_{00}(t) = 1 -P_{01}(t)\), esto se convierte

\[ \dfrac{dP_{01}(t)}{dt} = \lambda -P_{01}(t)(\lambda+\mu) \nonumber \]

Usando la condición de límite\(P_{01}(0) = 0\), la solución es

\[ P_{01}(t) = \dfrac{\lambda}{\lambda+\mu}\left[ 1-e^{-(\lambda+\mu)t}\right] \nonumber \]

Así\(P_{01}(t)\) es 0 en\(t = 0\) y aumenta en cuanto\(t \rightarrow \infty\) a su valor de estado estacionario en el estado 1, que es\(\lambda/( \lambda+ µ)\).

En general, para cualquier estado de inicio dado\(i\) en un proceso de Markov con\(\mathsf{M}\) estados, (6.3.5) proporciona un conjunto de ecuaciones diferenciales lineales\(\mathsf{M}\) simultáneas, una para cada uno\(j\),\(1\leq j \leq \mathsf{M}\). Como vimos en el ejemplo, uno de estos es redundante porque\(\sum^{\mathsf{M}}_{j=1} P_{ij} \ref{t} = 1\). Esto deja ecuaciones diferenciales lineales\(\mathsf{M}- 1\) simultáneas por resolver.

Para más de 2 o 3 estados, es más conveniente expresar (6.3.5) en forma de matriz. Dejar\([P(t)]\) (para cada uno\(t > 0\)) ser una\(\mathsf{M}\) matriz\(\mathsf{M}\) por cuyo\(i\),\(j\) elemento es\(P_{ij} (t)\). Dejar\([Q]\) ser una\(\mathsf{M}\) matriz\(\mathsf{M}\) por cuyo\(i\),\(j\) elemento es\(q_{ij}\) para cada uno\(i \neq j\) y\(-\nu_j\) para\(i = j\). Entonces (6.3.5) se convierte

\[ \dfrac{d[P(t)]}{dt} = [P(t)][Q] \nonumber \]

Para el Ejemplo 6.3.1, se\(P_{ij} (t)\) puede calcular para cada uno\(i\),\(j\) como en (6.3.6), resultando en

\[ [P(t)] = \left[ \begin{array}{cc} \dfrac{\mu}{\lambda+\mu}+\dfrac{\lambda}{\lambda+\mu} e^{-(\lambda+\mu)t} & \dfrac{\lambda}{\lambda+\mu}-\dfrac{\lambda}{\lambda+\mu}e^{-(\lambda+\mu)t} \\ \dfrac{\mu}{\lambda+\mu} +\dfrac{\lambda}{\lambda+\mu}e^{-(\lambda+\mu)t} & \dfrac{\lambda}{\lambda+\mu}-\dfrac{\lambda}{\lambda+\mu}e^{-(\lambda+\mu)t} \end{array} \right] \qquad [Q] = \left[ \begin{array}{cc} -\lambda & \lambda \\ \\ \mu & -\mu \end{array} \right] \nonumber \]

Con el fin de proporcionar una idea de la solución general de (6.3.7), nos remontamos a la aproximación temporal muestreada de un proceso de Markov. Con un incremento de tamaño\(\delta\) entre muestras, la probabilidad de una transición de\(i\) a\(j\),\(i \neq j\), es\(q_{ij}\delta + o(\delta)\), y la probabilidad de permanecer en estado\(i\) es\(1-\nu_i\delta +o(\delta)\). Así, en términos de la matriz\([Q]\) de tasas de transición, la matriz de probabilidad de transición en el modelo de tiempo muestreado es\([I] + \delta[Q]\), donde\([I]\) está la matriz de identidad. Denotamos esta matriz por\([W_{\delta}] = [I]+\delta[Q]\). Tenga en cuenta que\(\lambda\) es un valor propio de\([Q]\) si y solo si\(1+\lambda\delta\) es un valor propio de\([W_{\delta}]\). También los vectores propios de estos valores propios correspondientes son los mismos. Es decir, si\(\boldsymbol{\nu}\) es un vector propio derecho de\([Q]\) con valor propio\(\lambda\), entonces\(\boldsymbol{\nu}\) es un vector propio derecho de\([W_{\delta}]\) con autovalor\(1 +\lambda \delta \), y a la inversa. Del mismo modo, si\(\boldsymbol{p}\) es un vector propio izquierdo de\([Q]\) con valor propio\(\lambda\), entonces\(\boldsymbol{p}\) es un vector propio izquierdo de\([W_{\delta}]\) con autovalor\(1 +\lambda\delta \), y a la inversa.

Vimos en la Sección 6.2.5 que el vector\(\boldsymbol{p}\) de probabilidad en estado estacionario de un proceso de Markov es el mismo que el de cualquier aproximación de tiempo muestreado. Ahora hemos visto que, además, todos los vectores propios son iguales y los valores propios están simplemente relacionados. Así, el estudio de estas ecuaciones dierenciales puede ser reemplazado en gran medida por el estudio de la aproximación de tiempo muestreado.

El siguiente teorema utiliza nuestro conocimiento de los valores propios y vectores propios de matrices de transición como\([W_{\delta}]\) en la Sección 3.4, para ser más específicos sobre las propiedades de\([Q]\).

Teorema 6.3.1 Considerar un proceso irreducible de Markov en estado finito con\(\mathsf{M}\) estados. Entonces la matriz\([Q]\) para ese proceso tiene un valor propio\(\lambda\) igual a 0. Ese valor propio tiene un vector propio derecho\(e = (1, 1, . . . , 1)^{\mathsf{T}}\) que es único dentro de un factor de escala. Tiene un vector propio izquierdo\(\boldsymbol{p} = (p_1, . . . , p_{\mathsf{M}})\) que es positivo, suma a 1, satisface (6.2.17), y es único dentro de un factor de escala. Todos los demás valores propios de\([Q]\) tienen partes reales estrictamente negativas.

Prueba: Dado que todos los\(\mathsf{M}\) estados se comunican, la cadena de tiempo muestreada es recurrente. Del Teorema 3.4.1,\([W_{\delta}]\) tiene un valor propio único\(\lambda= 1\). El vector propio derecho correspondiente es\(e\) y el vector propio izquierdo es el vector de probabilidad de estado estacionario\(\boldsymbol{p}\) como se indica en (3.9). Dado que\([W_{\delta}]\) es recurrente, los componentes de\(\boldsymbol{p}\) son estrictamente positivos. De la equivalencia de (6.2.17) y (6.2.18)\(\boldsymbol{p}\), dada por (6.2.17), se encuentra el vector de probabilidad en estado estacionario del proceso. Cada valor propio\(\lambda_{\delta}\) de\([W_{\delta}]\) corresponde a un valor propio\(\lambda\) de\([Q]\) con la correspondencia\(\lambda_{\delta}= 1+\lambda\delta\),\(i.e.\),\(\lambda= (\lambda_{\delta}-1)/\delta\). Así, el valor propio 1 de\([W_{\delta}]\) corresponde al valor propio 0 de \([Q]\). Ya que\(|\lambda_{\delta}| \leq 1\) y\(\lambda_{\delta}\neq 1\) para todos los demás valores propios, los demás valores propios de\([Q]\) todos tienen partes reales estrictamente negativas, completando la prueba.

\(\square\)

Completamos esta sección derivando las ecuaciones hacia atrás de Komogorov. Para\(s\) pequeños y positivos, las ecuaciones de Chapman-Kolmogorov en (6.3.3) se convierten

\[ \begin{aligned} P_{ij}(t) \quad &= \quad \sum_kP_{ik}(s)P_{kj}(t-s) \\ &= \quad \sum_{k\neq i} sq_{ik}P_{kj} (t-s)+(1-s\nu_i)P_{ij}(t-s)+o(s) \end{aligned} \nonumber \]

restando\(P_{ij} (t -s)\) de ambos lados y dividiendo por\(s\),

\[ \begin{align} \dfrac{P_{ij}(t)-P_{ij}(t-s)}{s} \quad &= \quad \sum_{k\neq i}q_{ik}P_{kj}(t-s)-\nu_iP_{ij}(t-s)+ \dfrac{o(s)}{s} \nonumber \\ \dfrac{dP_{ij}(t)}{dt} \quad &= \quad \sum_{k\neq i} q_{ik}P_{kj}(t)-\nu_iP_{ij}(t) \end{align} \nonumber \]

En forma de matriz, esto se expresa como

\[ \dfrac{d[P(t)]}{dt} = [Q][P(t)] \nonumber \]

Al comparar (6.3.9) y (6.3.7), vemos que\([Q][P(t)] = [P(t)][Q]\),\(i.e.\), que las matrices\([Q]\) y\([P(t)]\) conmutan. Las ecuaciones diferenciales lineales simultáneas aparecen en tantas aplicaciones que dejamos la exploración adicional de estas ecuaciones hacia adelante y hacia atrás como temas simples de ecuaciones diferenciales en lugar de temas que tienen propiedades especiales para los procesos de Markov.

_____________________________________________________________

- Hemos asumido que la suma y el límite en (6.1.3) pueden ser intercambiados. Esto ciertamente es válido si el espacio estatal es finito, que es el único caso que analizamos en lo que sigue.