5.1: Cadenas Contables de Markov del Estado

- Page ID

- 86230

Las cadenas de Markov con un espacio de estado infinitamente contable (más brevemente, cadenas de Markov de estado contable) exhiben algunos tipos de comportamiento que no son posibles para cadenas con un espacio de estado finito. Con la excepción del primer ejemplo a seguir y la sección sobre procesos de ramificación, etiquetamos los estados por los enteros no negativos. Esto es apropiado al modelar cosas como el número de clientes en una cola, y no causa pérdida de generalidad en otros casos.

Los siguientes dos ejemplos dan una idea de los nuevos temas planteados por los espacios estatales contables.

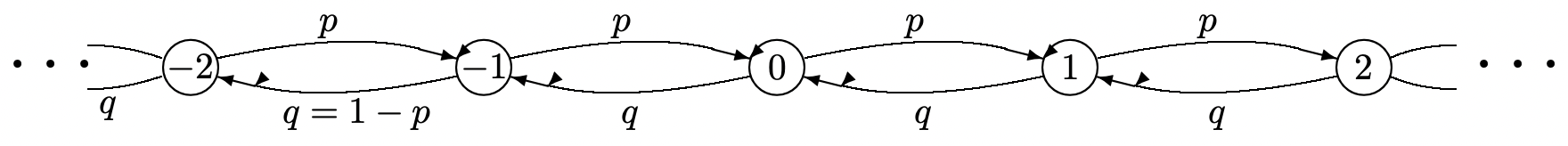

Considere el proceso familiar de Bernoulli\(\left\{S_{n}=X_{1}+\cdots X_{n} ; n \geq 1\right\}\) donde\(\left\{X_{n} ; n \geq 1\right\}\) es una secuencia binaria IID con\(\mathrm{p}_{X}(1)=p\) y\(\mathrm{p}_{X}(-1)=(1-p)=q\). La secuencia\(\left\{S_{n} ; n \geq 1\right\}\) es una secuencia de variables aleatorias enteras (rv) donde\(S_{n}=S_{n-1}+1\) con probabilidad p y\(S_{n}=S_{n-1}-1\) con probabilidad\(q\). Esta secuencia puede ser modelada por la cadena de Markov en la Figura 5.1.

Utilizando la notación de cadenas de Markov,\(P_{0 j}^{n}\) es la probabilidad de estar en estado\(j\) al final de la transición\(n\) th, condicional a partir del estado 0. El estado final\(j\) es el número de transiciones positivas\(k\) menos el número de transiciones negativas\(n-k\), es decir,\(j=2 k-n\). Así, utilizando la fórmula binomial,

\ [P_ {0 j} ^ {n} =\ izquierda (\ begin {array} {l}

n\\

k

\ end {array}\ derecha) p^ {k} q^ {n-k}\ quad\ texto {donde} k=\ frac {j+n} {2};\ quad j+n\ texto {par.}\ etiqueta {5.1}\]

Todos los estados de esta cadena de Markov se comunican con todos los demás estados, y así están en la misma clase. La fórmula deja claro que esta clase, es decir, todo el conjunto de estados de la cadena Markov, es periódica con el periodo 2. Para\(n\) par, el estado es par y para\(n\) impar, el estado es impar.

Lo que es más importante que la periodicidad, sin embargo, es lo que le sucede a las probabilidades estatales para grandes\(n\). Como vimos en\ ref {1.88} mientras probamos el teorema del límite central para el caso binomial,

\[P_{0 j}^{n} \sim \frac{1}{\sqrt{2 \pi n p q}} \exp \left[\frac{-(k-n p)^{2}}{2 p q n}\right]^\} \quad \text { where } k=\frac{j+n}{2} ; \quad j+n \text { even.} \label{5.2} \]

En otras palabras,\(P_{0 j}^{n}\), en función de\(j\), parece una forma cuantificada de la densidad gaussiana para grandes\(n\). Los términos significativos de esa distribución son cercanos a\(k=n p\), es decir, a\(j=n(2 p-1)\). Para\(p>1 / 2\), el estado aumenta con el incremento\(n\). Su distribución se centra en\(n(2 p-1)\), pero la distribución también se está extendiendo como\(\sqrt{n}\). Para\(p<1 / 2\), el estado disminuye de manera similar y se extiende. El caso más interesante es\(p=1 / 2\), donde la distribución permanece centrada en 0, pero debido a la propagación, el PMF se acerca a 0 como\(1 / \sqrt{n}\) para todos\(j\).

Para este ejemplo, entonces, la probabilidad de cada estado se acerca a cero como\(n \rightarrow \infty\), y esto se mantiene para todas las elecciones de\(p\),\(0<p<1\). Si intentamos definir una probabilidad de estado estacionario como 0 para cada estado, entonces estas probabilidades no suman a 1, por lo que no pueden verse como una distribución en estado estacionario. Así, para las cadenas de Markov de estado contable, las nociones de recurrencia y probabilidades de estado estacionario deberán modificarse a partir de las de las cadenas finitestadas de Markov. El mismo tipo de situación ocurre siempre que\(\left\{S_{n} ; n \geq 1\right\}\) se trate de una secuencia de sumas de rv arbitrarias con valor entero de IID.

La mayoría de las cadenas de Markov de estado contable que son útiles en aplicaciones son bastante dierentes del Ejemplo 5.1.1, y en cambio son bastante similares a las cadenas de Markov de estado finito. El siguiente ejemplo guarda una estrecha semejanza con el Ejemplo 5.1.1, pero al mismo tiempo es una cadena de Markov de estado contable que seguirá reapareciendo en un gran número de contextos. Se trata de un caso especial de un proceso de nacimiento-muerte, que estudiamos en la Sección 5.2.

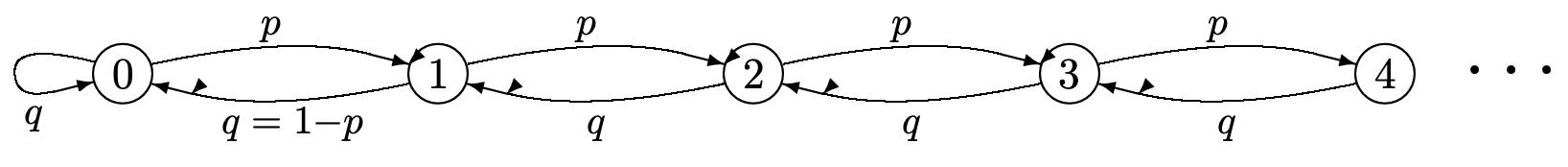

La Figura 5.2 es similar a la Figura 5.1 excepto que se han eliminado los estados negativos. Una secuencia de rv binarios IID\(\left\{X_{n} ; n \geq 1\right\}\), con\(\mathrm{p}_{X}(1)=p\) y\(\mathrm{p}_{X}(-1)=q=1-p\), controla las transiciones de estado. Ahora, sin embargo,\(S_{n}=\max \left(0, S_{n-1}+X_{n}\right.\), así que eso\(S_{n}\) es un rv no negativo. Todos los estados vuelven a comunicarse, y debido a la autotransición en el estado 0, la cadena es aperiódica.

Para\(p>1 / 2\), las transiciones a la derecha ocurren con mayor frecuencia que las transiciones a la izquierda. Así, razonando heurísticamente, esperamos que el estado\(S_{n}\) en el momento\(n\) se deslice hacia la derecha con el aumento\(n\). Dado\(S_{0}=0\), la probabilidad\(P_{0 j}^{n}\) de estar en estado en\(j\) el momento\(n\), debería entonces tender a cero para cualquier fijo\(j\) con incremento\(n\). Al igual que en el Ejemplo 5.1.1, vemos que no existe un estado estacionario. En términos más poéticos, el estado deambula hacia el azul salvaje allá.

Una forma de entender mejor esta cadena es mirar qué sucede si la cadena se trunca. El truncamiento de la Figura 5.2 a\(k\) estados se analiza en el Ejercicio 3.9. La solución ahí define\(\rho=p / q\) y muestra que si\(\rho \neq 1\), entonces\(\pi_{i}=(1-\rho) \rho^{i} /\left(1-\rho^{k}\right)\) para cada uno\(i\),\(0 \leq i<k\). Para\(\rho=1\),\(\pi_{i}=1 / k\) para cada uno\(i\). Para\(\rho<1\), el comportamiento limitante tal\(k \rightarrow \infty\) cual\(\pi_{i}=(1-\rho) \rho^{i}\). Así pues\(\rho<1(p<1 / 2)\), las probabilidades de estado estacionario para la cadena truncada de Markov se aproximan a un límite que posteriormente interpretamos como las probabilidades de estado estacionario para la cadena no truncada. Porque\(\rho>1(p>1 / 2)\), por otro lado, las probabilidades de estado estacionario para el caso truncado son geométricamente decrecientes desde la derecha, y los estados con probabilidad significativa siguen moviéndose hacia la derecha a medida que\(k\) aumenta. Aunque la probabilidad de cada estado fijo\(j\) se acerca a 0 a medida que\(k\) aumenta, la cadena truncada nunca se parece a la cadena no truncada.

Quizás el caso más interesante es ahí donde\(p=1 / 2\). Las probabilidades de transición de orden\(n\) th, se\(P_{0 j}^{n}\) pueden calcular exactamente para este caso (ver Ejercicio 5.3) y son muy similares a las del Ejemplo 5.1.1. En particular,

\ [P_ {0 j} ^ {n} =\ begin {cases}\ left (\ begin {array} {c}

n\\

(j+n)/2

\ end {array}\ right) 2^ {-n} &\ text {for} j\ geq 0, (j+n)\ text {par}\\

\\}\

\ left (\ underset {(j+n+1)/2} {n}\ derecha) 2^ {-n} &\ texto {para} j\ geq 0, (j+n)\ texto { impar}\ fin {casos}\ etiqueta {5.3}\]

\[\sim \sqrt{\frac{\}2}{\pi n}} \exp \left[\frac{-j^{2}}{2 n}\right] \quad \text { for } j \geq 0\label{5.4} \]

Vemos que\(P_{0 j}^{n}\) para grandes\(n\) se aproxima por el lado positivo de una distribución gaussiana cuantificada. Parece el lado positivo del PMF de\ ref {5.1} excepto que ya no es periódico. Para grandes\(n\),\(P_{0 j}^{n}\) se concentra en una región de ancho\(\sqrt{n}\) alrededor\(j = 0\), y el PMF va a 0 como\(1 / \sqrt{n}\) para cada\(j\) como\(n \rightarrow \infty\).

Afortunadamente, el extraño comportamiento de la Figura 5.2 cuando no\(p \geq q\) es típico de las cadenas de interés de Markov para la mayoría de las aplicaciones. Para las cadenas típicas de Markov en estado contable, existe un estado estacionario, y las probabilidades de estado estacionario de todos menos un número finito de estados (el número dependiendo de la cadena y la aplicación) casi pueden ignorarse para los cálculos numéricos.

Usando la teoría de la renovación para clasificar y analizar las cadenas de Markov

El enfoque matricial utilizado para analizar las cadenas de Markov de estado finito no se generaliza fácilmente al caso de estado contable. Afortunadamente, la teoría de la renovación es ideal para este propósito, especialmente para analizar el comportamiento a largo plazo de las cadenas estatales contables de Markov. Primero debemos revisar la definición de estados recurrentes. La definición de cadenas de Markov de estado finito no se aplica aquí, y veremos que, bajo la nueva definición, la cadena de Markov en la Figura 5.2 es recurrente para\(p \leq 1 / 2\) y transitoria para\(p>1 / 2\). Para\(p=1 / 2\), la cadena se denomina nulo recurrente, como se explica más adelante.

En general, encontraremos que para un estado recurrente\(j\), la secuencia de entradas posteriores a estado\(j\), condicionadas a comenzar en\(j\), forma un proceso de renovación. Los teoremas de renovación especifican entonces el tiempo-promedio relativo-frecuencia de estado\(j\), la probabilidad limitante de\(j\) con el tiempo creciente y una serie de otras relaciones.

También queremos entender la secuencia de épocas en las que se ingresa un estado\(j\), digamos, condicionado a iniciar la cadena en algún otro estado, digamos\(i\). Veremos eso, sujeto a la clasificación de los estados\(i\) y\(j\), esto da lugar a un proceso de renovación retrasado. Al prepararnos para estudiar estos procesos de renovación y proceso de renovación retardada, necesitamos comprender los intervalos entre renovaciones. Las funciones de masa de probabilidad (PMF) de estos intervalos se denominan probabilidades de primer paso en la notación de cadenas de Markov.

La probabilidad de primer paso-tiempo\(f_{i j}(n)\),, de una cadena de Markov es la probabilidad, condicional\(X_{0}=i\), de que la primera entrada posterior al estado\(j\) ocurra en época discreta\(n\). Es decir,\(f_{i j}(1)=P_{i j}\) y para\(n \geq 2\),

\[f_{i j}(n)=\operatorname{Pr}\left\{X_{n}=j, X_{n-1} \neq j, X_{n-2} \neq j, \ldots, X_{1} \neq j \mid X_{0}=i\right\}\label{5.5} \]

La distinción entre\(f_{i j}(n)\) y\(P_{i j}^{n}=\operatorname{Pr}\left\{X_{n}=j \mid X_{0}=i\right\}\) es que\(f_{i j}(n)\) es la probabilidad de que la primera entrada a\(j\) (después del tiempo 0) ocurra en el tiempo\(n\), mientras que\(P_{i j}^{n}\) es la probabilidad de que cualquier entrada\(j\) se produzca en el momento\(n\), ambas condicionales a comenzar en estado \(i\)a la hora 0. La definición en\ ref {5.5} también se aplica para\(j = i\);\(f_{i i}(n)\) es así la probabilidad, dada\(X_{0}=i\), de que la primera ocurrencia de estado\(i\) después del tiempo 0 ocurra en el tiempo\(n\). Dado que las probabilidades de transición son independientes del tiempo, también\(f_{k j}(n-1)\) es la probabilidad, dada\(X_{1}=k\), de que la primera ocurrencia posterior de estado\(j\) ocurra en el momento\(n\). Así podemos calcular\(f_{i j}(n)\) a partir de las relaciones iterativas

\[f_{i j}(n)=\sum_{k \neq j} P_{i k} f_{k j}(n-1) ; \quad n>1 ; \quad f_{i j}(1)=P_{i j}\label{5.6} \]

Obsérvese que la suma excluye\(k=j\), ya que\(P_{i j} f_{j j}(n-1)\) es la probabilidad de que el estado\(j\) ocurra primero en la época 1 y siguiente en la época\(n\). Obsérvese también de la ecuación Chapman-Kolmogorov que\(P_{i j}^{n}=\sum_{k} P_{i k} P_{k j}^{n-1}\). En otras palabras, la única dierencia entre las expresiones iterativas a calcular\(f_{i j}(n)\) y\(P_{i j}^{n}\) es la exclusión de\(k=j\) en la expresión for\(fij (n)\).

Con este enfoque iterativo, las probabilidades de primer paso-tiempo\(fij(n)\) para un dado\(n\) deben calcularse para todos\(i\) antes de proceder a calcularlas para el siguiente valor mayor de\(n\). Esto también nos da\(fjj(n)\), aunque no\(fjj(n)\) se usa en la iteración.

Que\(\mathrm{F}_{i j}(n)\), para\(n \geq 1\), sea la probabilidad, dada\(X_{0}=i\), que el estado\(j\) ocurra en algún momento entre 1 e\(n\) inclusive. Así,

\[\left.\mathrm{F}_{i j}(n)=\sum_{m=1}^{n}\right\} f_{i j}(m)\label{5.7} \]

Para cada uno\(i\),\(j\),\(Fij(n)\) es no decreciente en n y (ya que es una probabilidad) está delimitado por la parte superior por 1. Así\(\mathrm{F}_{i j}(\infty)\) (es decir,\(\lim _{n \rightarrow \infty} \mathrm{F}_{i j}(n)\)) debe existir, y es la probabilidad, dada\(X_{0}=i\), de que el estado j ocurra alguna vez. Si\(\mathrm{F}_{i j}(\infty)=1\), entonces, dado\(X_{0}=i\), es cierto (con probabilidad 1) que la cadena finalmente entrará en estado\(j\). En este caso, podemos definir una variable aleatoria (rv)\(T_{i j}\), condicional\(X_{0}=i\), como el tiempo de primer paso de\(i\) a\(j\). Entonces\(f_{i j}(n)\) es el PMF de\(T_{i j}\) y\(\mathrm{F}_{i j}(n)\) es la función de distribución de\(T_{i j}\). Si\(\mathrm{F}_{i j}(\infty)<1\), entonces\(T_{i j}\) es un rv defectuoso, ya que, con alguna probabilidad distinta de cero, no hay primer paso a\(j\). Los rv defectuosos no se consideran rv (en los teoremas aquí o en otro lugar), pero sí tienen muchas de las propiedades de los rv.

El primer tiempo\(T_{j j}\) de paso de un estado de\(j\) regreso a sí mismo es de particular importancia. Tiene el PMF\(f_{j j}(n)\) y la función de distribución\(\mathrm{F}_{j j}(n)\). Es un rv (a diferencia de un rv defectuoso) si\(F_{j j}(\infty)=1\), es decir, si el estado finalmente vuelve al estado\(j\) con probabilidad 1 dado que comienza en estado\(j\). Esto lleva a la definición de recurrencia.

Un estado j en una cadena de Markov de estado contable es recurrente si\(\mathrm{F}_{j j}(\infty)=1\). Es transitorio si\(\mathrm{F}_{j j}(\infty)<1\).

Así, cada estado\(j\) en una cadena de Markov de estado contable es recurrente o transitorio, y es recurrente si y solo si se produce un eventual retorno a\(j\) (condicional\(X_{0}=j\)) con probabilidad 1. Equivalentemente,\(j\) es recurrente si y sólo si\(T_{j j}\), el tiempo del primer retorno a\(j\), es un rv. Obsérvese que para el caso especial de las cadenas de Markov de estado finito, esta definición es congruente con la del Capítulo 3. Para un espacio de estado contablemente-infinito, sin embargo, la definición anterior no es adecuada. Un ejemplo lo proporciona el caso de\(p>1 / 2\) la Figura 5.2. Aquí\(i\) y\(j\) comunicar para todos los estados\(i\) y\(j\), pero es intuitivamente obvio (y se muestra en el Ejercicio 5.2, y se explica con más detalle en la Sección 5.2) que cada estado es transitorio.

Si el estado inicial\(X_{0}\) de una cadena de Markov es un estado recurrente\(j\), entonces\(T_{j j}\) es el tiempo entero de la primera recurrencia del estado\(j\). A esa recurrencia, la cadena de Markov se encuentra en el\(j\) mismo estado en que comenzó en, y el intervalo discreto desde\(T_{j j}\) hasta la siguiente ocurrencia de estado\(j\), digamos,\(T_{j j, 2}\) tiene la misma distribución que\(T_{j j}\) y es claramente independiente de\(T_{j j}\). De manera similar, la secuencia de intervalos de recurrencia sucesivos,\(T_{j j}, T_{j j, 2}, T_{j j, 3}, \ldots\) es una secuencia de IID rv, esta secuencia de intervalos de recurrencia 1 es entonces la secuencia de intervalos inter-renovación de un proceso de renovación, donde cada intervalo de renovación tiene la distribución de\(T_{j j}\). Estos intervalos entre renovaciones tienen el PMF\(f_{j j}(n)\) y la función de distribución\(\mathrm{F}_{j j}(n)\).

Dado que los resultados sobre las cadenas de Markov dependen en gran medida de si los estados son recurrentes o transitorios, analizaremos cuidadosamente las probabilidades\(\mathrm{F}_{i j}(n)\). Sustituyendo\ ref {5.6} en (5.7), obtenemos

\[\left.\mathrm{F}_{i j}(n)=P_{i j}+\sum_{k \neq j}\right\} P_{i k} \mathrm{~F}_{k j}(n-1) ; \quad n>1 ; \quad \mathrm{F}_{i j}(1)=P_{i j}\label{5.8} \]

Para entender la expresión\(P_{i j}+\sum_{k \neq j} P_{i k} \mathrm{~F}_{k j}(n-1)\), tenga en cuenta que el primer término\(P_{i j}\),, es\(f_{i j}\)\ ref {1} y el segundo término,\(\sum_{k \neq j} P_{i k} \mathrm{~F}_{k j}(n-1)\), es igual a\(\sum_{\ell=2}^{n} f_{i j}(\ell)\).

Hemos visto que\(\mathrm{F}_{i j}(n)\) es no decreciente en n y superior delimitada por 1, por lo que el límite\(\mathrm{F}_{i j}(\infty)\) debe existir. De igual manera,\(\sum_{k \neq j} P_{i k} \mathrm{~F}_{k j}(n-1)\) es no decreciente en\(n\) y superior delimitada por 1, por lo que también tiene un límite, igual a\(\sum_{k \neq j} P_{i k} \mathrm{~F}_{k j}(\infty)\). Así

\[\left.\mathrm{F}_{i j}(\infty)=P_{i j}+\sum_{k \neq j}\right\} P_{i k} \mathrm{~F}_{k j}(\infty)\label{5.9} \]

Para cualquier dado\(j\),\ ref {5.9} puede verse como un conjunto de ecuaciones lineales en las variables\(\mathrm{F}_{i j}(\infty)\) para cada estado\(i\). No siempre hay una solución única a este conjunto de ecuaciones. De hecho, el conjunto de ecuaciones

\[x_{i j}=P_{i j}+\sum_{k \neq j} P_{i k} x_{k j} ; \quad \text { all states } i\label{5.10} \]

siempre tiene una solución en la que\(x_{i j}=1\) para todos\(i\). Si el estado\(j\) es transitorio, sin embargo, hay otra solución en la que\(x_{i j}\) está el verdadero valor de\(\mathrm{F}_{i j}(\infty)\) y\(\mathrm{F}_{j j}(\infty)<1\). El ejercicio 5.1 muestra que si\ ref {5.10} se satisface con un conjunto de números no negativos\(\left\{x_{i j} ; 1 \leq i \leq J\right\}\), entonces\(\mathrm{F}_{i j}(\infty) \leq x_{i j}\) para cada uno\(i\).

Hemos definido un estado j para que sea recurrente si\(\mathrm{F}_{j j}(\infty)=1\) y hemos visto que si\(j\) es recurrente, entonces los retornos al estado\(j\), dado\(X_{0}=j\) forman un proceso de renovación. Todos los resultados de la teoría de la renovación se pueden aplicar entonces a la secuencia aleatoria de tiempos enteros en la que\(j\) se ingresa. Los principales resultados de la teoría de la renovación que necesitamos se exponen en el siguiente lema.

\(\left\{N_{j j}(t) ; t \geq 0\right\}\)Sea el proceso de conteo de ocurrencias del estado j hasta el tiempo\(t\) en una cadena de Markov con\(X_{0}=j\). Las siguientes condiciones son entonces equivalentes.

- estado\(j\) es recurrente.

- \(\lim _{t \rightarrow \infty} N_{j j}(t)=\infty\)con probabilidad 1.

- \(\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t)\right]=\infty\)

- \(\lim _{t \rightarrow \infty} \sum_{1 \leq n \leq t} P_{j j}^{n}=\infty\)

- Prueba

-

Primero supongamos que\(j\) es recurrente, es decir, eso\(\mathrm{F}_{j j}(\infty)=1\). Esto implica que los tiempos de interrenovación entre ocurrencias de\(j\) son IID rv, y en consecuencia\(\left\{N_{j j}(t) ; t \geq 1\right\}\) es un proceso de conteo de renovación. Recordemos del Lema 4.3.1 del Capítulo 4 que, sea o no el tiempo de inter-renovación esperado\(\mathrm{E}\left[T_{j j}\right]\) es finito,\(\lim _{t \rightarrow \infty} N_{j j}(t)=\infty\) con probabilidad 1 y\(\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t)\right]=\infty\).

A continuación supongamos que el estado\(j\) es transitorio. En este caso, el tiempo de inter-renovación no\(T_{j j}\) es un rv, por lo que no\(\left\{N_{j j}(t) ; t \geq 0\right\}\) es un proceso de renovación. Un eventual retorno al estado\(j\) ocurre solo con probabilidad\(\mathrm{F}_{j j}(\infty)<1\), y, dado que los rendimientos posteriores son independientes, el número total de retornos al estado\(j\) es una rv geométrica con media\(\mathrm{F}_{j j}(\infty) /\left[1-\mathrm{F}_{j j}(\infty)\right]\). Así, el número total de retornos es finito con probabilidad 1 y el número total esperado de retornos es finito. Esto establece las tres primeras equivalencias.

Finalmente, tenga en cuenta que\(P_{j j}^{n}\), la probabilidad de una transición a estado\(j\) en tiempo entero\(n\), es igual a la expectativa de una transición a\(j\) en tiempo entero\(n\) (es decir, una sola transición ocurre con probabilidad\(P_{j j}^{n}\) y 0 ocurre de otra manera). Dado que\(N_{j j}(t)\) es la suma del número de transiciones a\(j\) lo largo de los tiempos 1 a\(t\), tenemos

\(\left.\mathrm{E}\left[N_{j j}(t)\right]=\sum_{1 \leq n \leq t}\right\} P_{j j}^{n},\)

que establece la equivalencia final.

Nuestro siguiente objetivo es mostrar que todos los estados de la misma clase que un estado recurrente también son recurrentes. Recordemos que dos estados están en la misma clase si se comunican, es decir, cada uno tiene un camino hacia el otro. Para las cadenas de Markov de estado finito, el hecho de que o bien todos los estados de la misma clase sean recurrentes o todos transitorios era relativamente obvio, pero para las cadenas de Markov de estados contables, se ha cambiado la definición de recurrencia y el hecho anterior ya no es obvio.

Si el estado\(j\) es recurrente y los estados\(i\) y\(j\) están en la misma clase, es decir,\(i\) y\(j\) comunicarse, entonces el estado i también es recurrente.

- Prueba

-

De Lemma 5.1.1, estado\(j\) satisface\(\lim _{t \rightarrow \infty} \sum_{1 \leq n \leq t} P_{j j}^{n}=\infty\). Desde\(j\) y\(i\) comunicarse, hay enteros\(m\) y\(k\) tal que\(P_{i j}^{m}>0\) y\(P_{j i}^{k}>0\). Por cada caminata del estado\(j\) a\(j\) en n pasos, hay una caminata correspondiente de\(i\) a\(i\) en\(m+n+k\) pasos, pasando de\(i\) a\(j\) en\(m\) pasos,\(j\) a\(j\) en\(n\) pasos, y de\(j\) regreso a\(i\) en \(k\)pasos. Así

\ (\ begin {alineado}

P_ {i i} ^ {m+n+k} &\ geq P_ {i j} ^ {m} P_ {j j} ^ {n} P_ {j i} ^ {k}\\

\ izquierda. \ sum_ {n=1} ^ {\ infty}\ derecha\} P_ {i i} ^ {n} &\ izquierda. \ izquierda. \ geq\ suma_ {n=1} ^ {\ infty}\ derecha\} P_ {i i} ^ {m+n+k}\ geq P_ {i j} ^ {m} P_ {j i} ^ {k}\ sum_ {n=1} ^ {\ infty}\ derecho\} P_ {j j} ^ {n} =\ infty

\ fin {alineado}\)Así, de Lemma 5.1.1,\(i\) es recurrente, completando la prueba.

Dado que cada estado en una cadena de Markov es recurrente o transitorio, y dado que, si un estado en una clase es recurrente, todos los estados de esa clase son recurrentes, vemos que si un estado en una clase es transitorio, todos lo son. Así podemos referirnos a cada clase como recurrente o transitoria. Este resultado muestra que el Teorema 3.2.1 también se aplica a las cadenas de Markov de estado contable. Declaramos este teorema por separado aquí para que sea específico.

Para una cadena de Markov de estado contable, o todos los estados de una clase son transitorios o todos son recurrentes.

A continuación nos fijamos en el proceso de conteo retrasado\(\left\{N_{i j}(n) ; n \geq 1\right\}\). Si se trata de un proceso de conteo de renovación retrasada, entonces podemos usar procesos de renovación retrasada para estudiar si el efecto del estado inicial eventualmente se extingue. Si el estado\(j\) es recurrente, sabemos que\(\left\{N_{j j}(n) ; n \geq 1\right\}\) es un proceso de conteo de renovación. Además,\(\left\{N_{i j}(n) ; n \geq 1\right\}\) para que sea un proceso de conteo de renovación retrasada, es necesario que el tiempo de primer paso sea un rv, es decir,\(F_{i j}(\infty)\) para ser 1.

Dejar estados\(i\) y\(j\) estar en la misma clase recurrente. Entonces\(F_{i j}(\infty)=1\).

- Prueba

-

Ya que\(i\) es recurrente, el número de visitas a\(i\) por tiempo\(t\), dado\(X_{0}=i\), es un proceso de recuento de renovación\(N_{i i}(t)\). Hay un camino de\(i\) a\(j\), digamos de probabilidad\(\alpha>0\). Así, la probabilidad de que el primer retorno a\(i\) ocurra antes de la visita\(j\) es como mucho\(1-\alpha\). La probabilidad de que el segundo retorno ocurra antes de visitar\(j\) es así como máximo\((1-\alpha)^{2}\) y la probabilidad de que el\(n\) th ocurra sin visitar\(j\) es como máximo\((1-\alpha)^{n}\). Dado que\(i\) se visita infinitamente a menudo con probabilidad 1 as\(n \rightarrow \infty\), la probabilidad de que\(j\) nunca se visita es 0. Así\(\mathrm{F}_{i j}(\infty)=1\).

\(\left\{N_{i j}(t) ; t \geq 0\right\}\)Sea el proceso de conteo para las transiciones al estado\(j\) hasta el tiempo\(t\) para una cadena de Markov dada\(X_{0}=i \neq j\). Entonces si\(i\) y\(j\) están en la misma clase recurrente,\(\left\{N_{i j}(t) ; t \geq 0\right\}\) es un proceso de renovación retrasada.

- Prueba

-

A partir de Lemma 5.1.3\(T_{i j}\),, el tiempo hasta la primera transición a\(j\), es un rv. También\(T_{j j}\) es un rv por definición de recurrencia, y los intervalos subsiguientes entre ocurrencias de estado\(j\) son IID, completando la prueba.

Si\(\mathrm{F}_{i j}(\infty)=1\), hemos visto que el tiempo de primer paso de\(i\) a\(j\) es un rv, es decir, es finito con probabilidad 1. En este caso,\(i\) es de interés el tiempo medio\(\overline{T}_{i j}\) para ingresar primero al estado a\(j\) partir del estado. Dado que\(T_{i j}\) es una variable aleatoria no negativa, su expectativa es la integral de su función de distribución complementaria,

\[\overline{T}_{i j}=1+\sum_{n=1}^{\infty}\left(1-\mathrm{F}_{i j}(n)\right)\label{5.11} \]

Es posible tener\(\mathrm{F}_{i j}(\infty)=1\) pero\(\overline{T}_{i j}=\infty\). Como se mostrará en la Sección 5.2, la cadena de la Figura 5.2 satisface\(\mathrm{F}_{i j}(\infty)=1\) y\(\overline{T}_{i j}<\infty\) para\(p<1 / 2\)\(\mathrm{F}_{i j}(\infty)=1\) y\(\overline{T}_{i j}=\infty\) para\(p=1 / 2\). Como se discutió anteriormente,\(F_{i j}(\infty)<1\) para\(p>1 / 2\). Esto nos lleva a la siguiente definición.

Un estado\(j\) en una cadena de Markov de estado contable es positivo-recurrente si\(\mathrm{F}_{j j}(\infty)=1\) y\(\overline{T}_{j j}<\infty\). Es nulo recurrente si\(\mathrm{F}_{j j}(\infty)=1\) y\(\overline{T}_{j j}=\infty\).

Cada estado de una cadena de Markov se clasifica así como uno de los tres tipos siguientes: positivourgente, nulo recurrente o transitorio. Para el ejemplo de la Figura 5.2, la recurrencia nula se encuentra en un límite entre la recurrencia positiva y la fugacidad, y esta suele ser una buena manera de observar la recurrencia nula. La parte f) del Ejercicio 6.3 ilustra otro tipo de situación en la que puede ocurrir una recurrencia nula.

Supongamos que el estado\(j\) es recurrente y considera el proceso de renovación\(\left\{N_{j j}(t) ; t \geq 0\right\}\). Los teoremas limitantes para los procesos de renovación se pueden aplicar directamente. De la ley fuerte para los procesos de renovación, Teorema 4.3.1,

\[\lim _{t \rightarrow \infty} N_{j j}(t) / t=1 / \overline{T}_{j j} \quad \text { with probability } 1\label{5.12} \]

Del teorema de renovación elemental, Teorema 4.6.1,

\[\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t) / t\right]=1 / \overline{T}_{j j}\label{5.13} \]

Las ecuaciones\ ref {5.12} y\ ref {5.13} son válidas tanto si\(j\) es positivo-recurrente como nulo recurrente.

A continuación aplicamos el teorema de Blackwell a\(\left\{N_{j j}(t) ; t \geq 0\right\}\). Recordemos que el periodo de un estado dado\(j\) en una cadena de Markov (ya sea que la cadena tenga un número contable o finito de estados) es el mayor divisor común del conjunto de enteros\(n>0\) tal que\(P_{j j}^{n}>0\). Si este periodo es\(d\), entonces\(\left\{N_{j j}(t) ; t \geq 0\right\}\) es aritmética con span\(\lambda\) (es decir, las renovaciones ocurren solo en momentos que son múltiplos de\(\lambda\). Del teorema de Blackwell en la forma aritmética de (4.61),

\[\lim _{n \rightarrow \infty} \operatorname{Pr}\left\{X_{n \lambda}=j \mid X_{0}=j\right\}=\lambda / \overline{T}_{j j}\label{5.14} \]

Si el estado\(j\) es aperiódico (i.e.,\(\lambda=1\)), esto dice eso\(\lim _{n \rightarrow \infty} \operatorname{Pr}\left\{X_{n}=j \mid X_{0}=j\right\}=1 / \overline{T}_{j j}\). Las ecuaciones\ ref {5.12} y\ ref {5.13} sugieren que\(1 / \overline{T}_{j j}\) tiene algunas de las propiedades asociadas a una probabilidad de estado estacionario\(j\), y\ ref {5.14} fortalece esto si\(j\) es aperiódico. Para una cadena de Markov que consiste en una sola clase de estados, todos positivo-recurrentes, fortaleceremos aún más esta asociación en el Teorema 5.1.4 al demostrar que existe una distribución única en estado estacionario,\(\left\{\pi_{j}, j \geq 0\right\}\) tal que\(\pi_{j}=1 / \overline{T}_{j j}\) para todos\(j\) y tal que\(\pi_{j}=\sum_{i} \pi_{i} P_{i j}\) para todos\(j \geq 0\) y \(\sum_{j} \pi_{j}=1\). El siguiente teorema inicia este desarrollo mostrando que (5.12-5.14) son independientes del estado de partida.

Dejar\(j\) ser un estado recurrente en una cadena de Markov y dejar que yo sea cualquier estado en la misma clase que\(j\). Dado\(X_{0}=i\), deja\(N_{i j}(t)\) ser el número de transiciones a estado\(j\) por tiempo\(t\) y dejar que\(\overline{T}_{j j}\) sea el tiempo de recurrencia esperado de estado\(j\) (ya sea finito o infinito). Entonces

\[\lim _{t \rightarrow \infty} N_{i j}(t) / t=1 / \overline{T}_{j j} \quad \text { with probability } 1\label{5.15} \]

\[\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{i j}(t) / t\right]=1 / \overline{T}_{j j}\label{5.16} \]

Si también\(j\) es aperiódica, entonces

\[\lim _{n \rightarrow \infty} \operatorname{Pr}\left\{X_{n}=j \mid X_{0}=i\right\}=1 / \overline{T}_{j j}\label{5.17} \]

- Prueba

-

Dado que i y j son recurrentes y en la misma clase, Lemma 5.1.4 asevera que\(\left\{N_{i j}(t) ; t \geq 0\right\}\) es un proceso de renovación retrasado para\(j \neq i\). Así\ ref {5.15} y\ ref {5.16} siguen de los Teoremas 4.8.1 y 4.8.2 del Capítulo 4. Si\(j\) es aperiódico, entonces\(\left\{N_{i j}(t) ; t \geq 0\right\}\) es un proceso de renovación retardada para el cual los intervalos entre renovaciones\(T_{j j}\) tienen span 1 y\(T_{i j}\) tienen un span entero. Así,\ ref {5.17} se desprende del teorema de Blackwell para los procesos de renovación retardados, Teorema 4.8.3. Para\(i=j\), (5.15-5.17) seguir de (5.12-5.14), completando la prueba.

Todos los estados de la misma clase de una cadena de Markov son del mismo tipo, ya sea todos positivo-recurrentes, todos nulos recurrentes o todos transitorios.

- Prueba

-

Dejar\(j\) ser un estado recurrente. Del Teorema 5.1.1, todos los estados de una clase son recurrentes o todos son transitorios. Siguiente supongamos que\(j\) es positivo-recurrente, así que eso\(1 / \overline{T}_{j j}>0\). Vamos a\(i\) estar en la misma clase que\(j\), y considerar el proceso de renovación-recompensa sobre el\(\left\{N_{j j}(t) ; t \geq 0\right\}\) cual\(R(t)=1\) cada vez que el proceso está en estado\(i\) (es decir, si\(X_{n}=i\), entonces\(R(t)=1\) para\(n \leq t<n+1\)). La recompensa es 0 siempre que el proceso se encuentre en algún estado que no sea\(i\). \(\mathrm{E}\left[\mathrm{R}_{n}\right]\)Sea la recompensa esperada en un intervalo entre renovaciones; esto debe ser positivo ya que i es accesible desde\(j\). De la ley fuerte para los procesos de renovación-recompensa, Teorema 4.4.1,

\(\lim _{t \rightarrow \infty} \frac{1}{t} \int_{0}^{\}t} R(\tau) d \tau=\frac{\mathrm{E}\left[\mathrm{R}_{n}\right]}{\overline{T}_{j j}} \quad \text { with probability } 1\).

El término de la izquierda es el número promedio de tiempo de transiciones a estado\(i\), dado\(X_{0}=j\), y este es\(1 / \overline{T}_{i i}\) de (5.15). Desde\(\mathrm{E}\left[\mathrm{R}_{n}\right]>0\) y\(\overline{T}_{j j}<\infty\), tenemos\(1 / \overline{T}_{i i}>0\), así\(i\) es positivo-recurrente. Así, si un estado es positivo-recurrente, toda la clase lo es, completando la prueba.

Si todos los estados en una cadena de Markov están en una clase nulo recurrente, entonces\(1 / \overline{T}_{j j}=0\) para cada estado, y uno podría pensar en\(1 / \overline{T}_{j j}=0\) como una probabilidad de “estado estacionario”\(j\) en el sentido de que 0 es tanto la tasa promedio en el tiempo de ocurrencia de\(j\) como la probabilidad limitante de\(j\). Sin embargo, estas “probabilidades” no suman 1, por lo que no existe una distribución de probabilidad en estado estacionario. Esto parece bastante paradójico al principio, pero el ejemplo de la Figura 5.2, con\(p=1 / 2\) ayudará a aclarar la situación. A medida que\(n\) aumenta el tiempo (comenzando en estado\(i\), digamos), la variable aleatoria\(X_{n}\) se extiende sobre más y más estados alrededor\(i\), y por lo tanto es menos probable que esté en cada estado individual. Para cada uno\(j\),\(\lim _{n \rightarrow \infty} P_{i j}(n)=0\). Así,\(\sum_{j}\left\{\lim _{n \rightarrow \infty} P_{i j}^{n}\right\}=0\). Por otro lado, para cada\(n\),\(\sum_{j} P_{i j}^{n}=1\). Este es uno de esos ejemplos insólitos donde un límite y una suma no pueden intercambiarse.

En el Capítulo 3, definimos la distribución en estado estacionario de una cadena de Markov en estado finito como un vector de probabilidad\(\pi\) que satisface\(\boldsymbol{\pi}=\boldsymbol{\pi}[P]\). Aquí definimos\(\left\{\pi_{i} ; i \geq 0\right\}\) de la misma manera, como un conjunto de números que satisfacen

\[\left.\pi_{j}=\sum_{i}\right\}_{\pi_{i} P_{i j}} \text { for all } j ; \quad \pi_{j} \geq 0 \quad \text { for all } j ; \quad \sum_{j} \pi_{j}=1\label{5.18} \]

Supongamos que se elige un conjunto de números que\(\left\{\pi_{i} ; i \geq 0\right\}\) satisfagan\ ref {5.18} como distribución de probabilidad inicial para una cadena de Markov, es decir, si es\(\operatorname{Pr}\left\{X_{0}=i\right\}=\pi_{i}\) para todos\(i\). Entonces\(\mathrm{Pr}\{X_1=j\}=\sum_{i} \pi_{i} P_{i j}=\pi_{j}\) para todos\(j\), y, por inducción,\(\operatorname{Pr}\left\{X_{n}=j\right\}=\pi_{j}\) para todos\(j\) y para todos\(n \geq 0\). El hecho de que\(\operatorname{Pr}\left\{X_{n}=j\right\}=\pi_{j}\) para todos\(j\) motiva la definición de distribución en estado estacionario anterior. El teorema 5.1.2 mostró que\(1 / \overline{T}_{j j}\) es una probabilidad 'de estado estacionario' para el estado\(j\), tanto en un sentido tiempo-promedio como en un sentido limitante ensemble-promedio. El siguiente teorema reúne estas ideas. Una cadena irreducible de Markov es una cadena de Markov en la que se comunican todos los pares de estados. Para las cadenas de estado finito, la irreductibilidad implicaba una sola clase de estados recurrentes, mientras que para las cadenas contablemente infinitas, una cadena irreducible es una sola clase que puede ser transitoria, nula recurrente o positiva recurrente.

Asumir una cadena de Markov irreducible con probabilidades de transición\(\left\{P_{i j}\right\}\). Si\ ref {5.18} tiene una solución, entonces la solución es única,\(\pi_{i}=1 / \overline{T}_{i i}>0\) para todos\(i \geq 0\), y los estados son positivo-recurrentes. Además, si los estados son positivo-recurrentes entonces\ ref {5.18} tiene una solución.

- Prueba

-

Dejar\(\left\{\pi_{j} ; j \geq 0\right\}\) satisfacer\ ref {5.18} y ser la distribución inicial de la cadena de Markov, es decir,\(\operatorname{Pr}\left\{X_{0}=j\right\}=\pi_{j}, j \geq 0\). Entonces, como se muestra arriba,\(\operatorname{Pr}\left\{X_{n}=j\right\}=\pi_{j}\) para todos\(n \geq 0, j \geq 0\). \(\tilde{N}_{j}(t)\)Sea el número de ocurrencias de cualquier estado dado\(j\) desde el tiempo 1 hasta\(t\). Equiparando\(\operatorname{Pr}\left\{X_{n}=j\right\}\) a la expectativa de una ocurrencia de\(j\) en el momento\(n\), tenemos,

\(\left.\left.(1 / t) \mathrm{E}\left[\tilde{N}_{j}(t)\right]\right\}=(1 / t) \sum_{1 \leq n \leq t}\right\} \operatorname{Pr}\left\{X_{n}=j\right\}=\pi_{j} \quad \text { for all integers } t \geq 1\)

Acondicionar esto a los posibles estados de partida i, y utilizando los procesos de conteo\(\left\{N_{i j}(t) ; t \geq0\right.\}\) definidos anteriormente,

\[\pi_{j}=(1 / t) \mathrm{E}\left[\tilde{N}_{j}(t)\right]^\}=\sum_{i} \pi_{i} \mathrm{E}\left[N_{i j}(t) / t\right] \quad \text { for all integer } t \geq 1\label{5.19} \]

Para cualquier estado dado\(i\),\(T_{i j}\) sea el momento de la primera ocurrencia de estado\(j\) dado\(X_{0}=i\). Entonces si\(T_{i j}<\infty\), tenemos\(N_{i j}(t) \leq N_{i j}\left(T_{i j}+t\right)\). Así, para todos\(t \geq 1\),

\[\mathrm{E}\left[N_{i j}(t)\right] \leq \mathrm{E}\left[N_{i j}\left(T_{i j}+t\right)\right]=1+\mathrm{E}\left[N_{j j}(t)\right]\label{5.20} \]

El último paso sigue ya que el proceso está en estado\(j\) en el momento\(T_{i j}\), y el número esperado de ocurrencias de estado\(j\) en los siguientes\(t\) pasos es\(\mathrm{E}\left[N_{j j}(t)\right]\).

Sustituyendo\ ref {5.20} en\ ref {5.19} para cada uno\(i\),\(\left.\pi_{j} \leq 1 / t+\mathrm{E}\left[N_{j j}(t) / t\right)\right]\). Tomando el límite como\(t \rightarrow \infty\) y usando (5.16),\(\pi_{j} \leq \lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t) / t\right]\). Ya que\(\sum_{i} \pi_{i}=1\), hay al menos un valor de\(j\) para el cual\(\pi_{j}>0\), y para ello\(j\),\(\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t) / t\right]>0\), y consecuentemente\(\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t)\right]=\infty\). Así, a partir de Lema 5.1.1, el estado\(j\) es recurrente, y del Teorema 5.1.2,\(j\) es positivo-recurrente. A partir del Teorema 5.1.3, todos los estados son entonces positivo-recurrentes. Para cualquier\(j\) entero\(M\),\ ref {5.19} implica que

\[\left.\pi_{j} \geq \sum_{i \leq M}\right\} \pi_{i} \mathrm{E}\left[N_{i j}(t) / t\right] \quad \text { for all } t\label{5.21} \]

Del Teorema 5.1.2,\(\lim _{t \rightarrow \infty} \mathrm{E}\left[N_{i j}(t) / t\right]=1 / \overline{T}_{j j}\) para todos\(i\). Sustituyendo esto en (5.21), obtenemos\(\pi_{j} \geq 1 / \overline{T}_{j j} \sum_{i \leq M} \pi_{i}\). Ya que\(M\) es arbitrario,\(\pi_{j} \geq 1 / \overline{T}_{j j}\). Desde que ya lo demostramos\(\pi_{j} \leq \lim _{t \rightarrow \infty} \mathrm{E}\left[N_{j j}(t) / t\right]=1 / \overline{T}_{j j}\), tenemos\(\pi_{j}=1 / \overline{T}_{j j}\) para todos\(j\). Esto demuestra tanto que\(\pi_{j}>0\) para todos\(j\) como que la solución a\ ref {5.18} es única. El Ejercicio 5.5 completa la prueba demostrando que si los estados son positivo-recurrentes, entonces elegir\(\pi_{j}=1 / \overline{T}_{j j}\) para todos\(j\) satisface (5.18).

En la práctica, suele ser fácil ver si una cadena es irreducible. También veremos por una serie de ejemplos que la distribución en estado estacionario a menudo se puede calcular a partir de (5.18). Teorema 5.1.4 dice entonces que la distribución calculada es única y que su existencia garantiza que la cadena sea recurrente positiva.

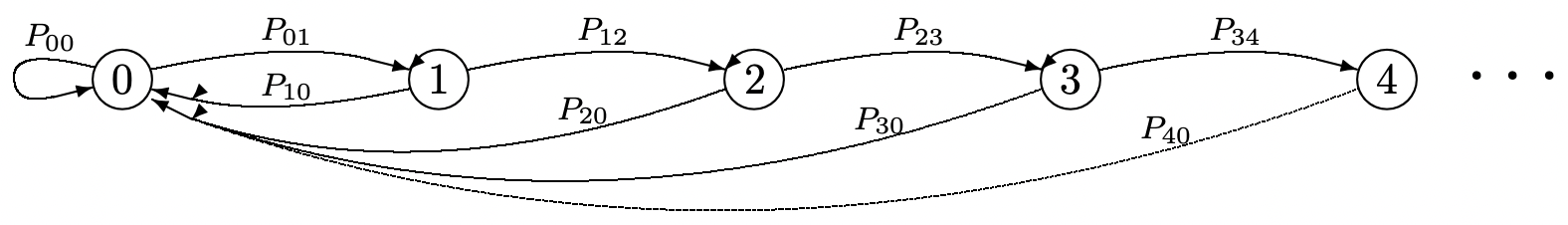

Considera un proceso de renovación\(\{N(t) ; t>0\}\) en el que las variables aleatorias entre renovaciones\(\left\{W_{n} ; n \geq 1\right\}\) son aritméticas con span 1. Utilizaremos una cadena de Markov para modelar la edad de este proceso (ver Figura 5.3). La probabilidad de que una renovación ocurra en un tiempo entero determinado depende del pasado solo a través del tiempo entero de regreso a la última renovación. El estado de la cadena de Markov durante un intervalo unitario se tomará como la edad del proceso de renovación al inicio del intervalo. Así, cada unidad de tiempo, la edad o bien aumenta en uno o se produce una renovación y la edad disminuye a 0 (es decir, si se produce una renovación en el momento\(t\), la edad en el momento\(t\) es 0).

Figura 5.3: Un modelo de cadena de Markov de la edad de un proceso de renovación.

Figura 5.3: Un modelo de cadena de Markov de la edad de un proceso de renovación.\(\operatorname{Pr}\{W>n\}\)es la probabilidad de que un intervalo entre renovaciones dure más de unidades de\(n\) tiempo. Suponemos que\(\operatorname{Pr}\{W>0\}=1\), de manera que cada intervalo de renovación dure al menos una unidad de tiempo. La probabilidad\(P_{n, 0}\) en la cadena de Markov es la probabilidad de que un intervalo de renovación tenga duración\(n+1\), dado que el intervalo excede\(n\). Así, por ejemplo,\(P_{00}\) es la probabilidad de que el intervalo de renovación sea igual a 1. \(P_{n, n+1}\)es\(1-P_{n, 0}\), que es\(\operatorname{Pr}\{W>n+1\} / \operatorname{Pr}\{W>n\}\). Entonces podemos resolver para las probabilidades de estado estacionario en la cadena: para\(n>0\),

\(\pi_{n}=\pi_{n-1} P_{n-1, n}=\pi_{n-2} P_{n-2, n-1} P_{n-1, n}=\pi_{0} P_{0,1} P_{1,2} \ldots P_{n-1, n}\).

La primera igualdad anterior resulta del hecho de que el estado\(n\), pues solo se\(n>0\) puede ingresar desde el estado\(n-1\). Las igualdades subsiguientes provienen de sustituir en la misma expresión por\(\pi_{n-1}\), entonces\(p_{n-2}\), y así sucesivamente.

\[\pi_{n}=\pi_{0} \frac{\operatorname{Pr}\{W>1\} \operatorname{Pr}\{W>2\}}{\operatorname{Pr}\{W>0\} \operatorname{Pr}\{W>1\}} \cdots \frac{\operatorname{Pr}\{W>n\}}{\operatorname{Pr}\{W>n-1\}}=\pi_{0} \operatorname{Pr}\{W>n\}\label{5.22} \]

Hemos cancelado todos los términos cruzados anteriores y utilizamos el hecho de que\(\operatorname{Pr}\{W>0\}=1\). Otra forma de ver eso\(\pi_{n}=\pi_{0} \operatorname{Pr}\{W>n\}\) es observar que el estado 0 ocurre exactamente una vez en cada intervalo entre renovaciones; el estado\(n\) ocurre exactamente una vez en esos intervalos entre renovaciones de duración\(n\) o más.

Dado que las probabilidades de estado estacionario deben sumar a 1,\ ref {5.22} se puede resolver para\(\pi_{0}\) como

\[\pi_{0}=\frac{1}{\sum_{n=0}^{\infty} \operatorname{Pr}\{W>n\}}=\frac{1}{\mathrm{E}[W]}\label{5.23} \]

La segunda igualdad sigue expresando E [W] como la integral de la función de distribución complementaria de W. Combinando esto con (5.22), las probabilidades de estado estacionario para\(n \geq 0\) son

\[\pi_{n}=\frac{\operatorname{Pr}\{W>n\}}{\mathrm{E}[W]}\label{5.24} \]

En cuanto al proceso de renovación,\(\pi_{n}\) es la probabilidad de que, en algún tiempo entero grande, la edad del proceso sea\(n\). Tenga en cuenta que si la edad del proceso en un tiempo entero es\(n\), entonces la edad aumenta hacia\(n+1\) en el siguiente tiempo entero, momento en el que o bien cae a 0 o continúa subiendo. Así se\(\pi_{n}\) puede interpretar como la fracción de tiempo entre la que se encuentra la edad del proceso\(n\) y\(n+1\). Recordemos de\ ref {4.28} (y el hecho de que la vida residual y la edad se distribuyen por igual) que la función de distribución de la edad promedio de tiempo viene dada por\(\mathrm{F}_{Z}(n)=\int_{0}^{n} \operatorname{Pr}\{W>w\} d w / \mathrm{E}[W]\). Así, la probabilidad de que la edad se encuentre entre\(n\) y\(n+1\) sea\(\mathrm{F}_{Z}(n+1)-\mathrm{F}_{Z}(n)\). Dado que W es una variable aleatoria entera, esto está\(\operatorname{Pr}\{W>n\} / \mathrm{E}[W]\) de acuerdo con nuestro resultado aquí.

El análisis aquí da una explicación nueva e intuitivamente satisfactoria de por qué la edad de un proceso de renovación es tan dierente desde el tiempo de inter-renovación. La cadena de Markov muestra los bucles cada vez mayores que dan lugar a una gran edad esperada cuando el tiempo de inter-renovación es de cola pesada (es decir, tiene una función de distribución que va a 0 lentamente con el tiempo creciente). Estos bucles pueden estar asociados con los triángulos isósceles de la Figura 4.7. La ventaja aquí es que podemos asociar los estados con probabilidades de estado estacionario si la cadena es recurrente. Incluso cuando la cadena de Markov es nula recurrente (es decir, el proceso de renovación asociado tiene una edad esperada infinita), parece más fácil visualizar el fenómeno de la edad esperada infinita.

1 Obsérvese que en el Capítulo 4 se denotaron los intervalos entre renovaciones\(X_{1}, X_{2}, \ldots\)\(X_{0}, X_{1}, \ldots\), mientras que aquí, está la secuencia de estados en la cadena de Markov y\(T_{j j}, T_{j j, 2}, \ldots\), es la secuencia de intervalos entre renovaciones.