5.2: Cadenas de Markov de nacimiento y muerte

- Page ID

- 86208

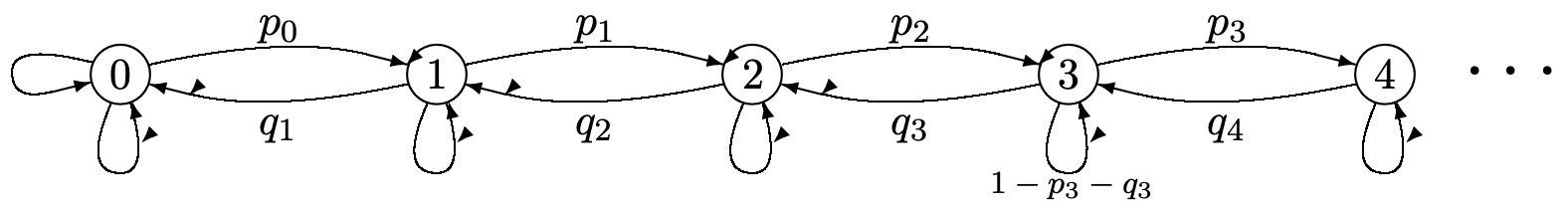

Una cadena de Markov de nacimiento-muerte es una cadena de Markov en la que el espacio estatal es el conjunto de enteros no negativos; para todos\(i \geq 0\), las probabilidades de transición satisfacen\(P_{i, i+1}>0\) y\(P_{i+1, i}>0\), y para todos\(|i-j|>1, P_{i j}=0\) (ver Figura 5.4). Una transición de estado\(i\) a\(i+1\) es considerada como nacimiento y otra de\(i+1\) a\(i\) como muerte. Así, la restricción de las probabilidades de transición significa que solo un nacimiento o muerte puede ocurrir en una unidad de tiempo. Muchas aplicaciones de los procesos de nacimiento-muerte surgen en la teoría de colas, donde el estado es el número de clientes, los nacimientos son llegadas de clientes y las muertes son salidas de clientes. La restricción a una sola llegada o salida a la vez parece bastante peculiar, pero generalmente dicha cadena es una aproximación finamente muestreada a un proceso de tiempo continuo, y los incrementos de tiempo son entonces lo suficientemente pequeños como para que sean improbables múltiples llegadas o salidas en un incremento de tiempo y puedan ignorarse en el límite.

Figura 5.4: Cadena Markov de nacimiento-muerte.

Figura 5.4: Cadena Markov de nacimiento-muerte.Denotamos\(P_{i, i+1}\) por\(p_{i}\) y\(P_{i, i-1}\) por\(q_{i}\). Así\(P_{i i}=1-p_{i}-q_{i}\). Hay una manera fácil de encontrar las probabilidades de estado estacionario de estas cadenas de nacimiento-muerte. En cualquier función de muestra del proceso, tenga en cuenta que el número de transiciones de estado\(i\) a\(i + 1\) difiere como máximo en 1 del número de transiciones de\(i + 1\) a\(i\). Si el proceso comienza a la izquierda\(i\) y termina a la derecha, entonces se produce una\(i \rightarrow i+1\) transición más que\(i+1 \rightarrow i\), etc. Así, si visualizamos un proceso de renovación-recompensa con renovaciones en ocurrencias de estado\(i\) y recompensa unitaria en transiciones de estado\(i\) a\(i+1\), el limitar el tiempo promedio número de transiciones por unidad de tiempo es\(\pi_{i} p_{i}\). De manera similar, el número limitante de tiempo promedio de transiciones por unidad de tiempo de\(i+1\) a\(i\) es\(\pi_{i+1} q_{i+1}\). Dado que estos dos deben ser iguales en el límite,

\[\pi_{i} p_{i}=\pi_{i+1} q_{i+1} \quad \text { for } i \geq 0\label{5.25} \]

La intuición en\ ref {5.25} es simplemente que la velocidad a la que ocurren las transiciones descendentes de\(i + 1\) a\(i\) debe ser igual a la tasa de transiciones ascendentes. Dado que este resultado es muy importante, tanto aquí como en nuestro estudio posterior de los procesos de nacimiento-muerte en tiempo continuo, mostramos que\ ref {5.25} también resulta del uso de las ecuaciones de estado estacionario en (5.18):

\[\pi_{i}=p_{i-1} \pi_{i-1}+\left(1-p_{i}-q_{i}\right) \pi_{i}+q_{i+1} \pi_{i+1} ; \quad i>0\label{5.26} \]

\[\pi_{0}=\left(1-p_{0}\right) \pi_{0}+q_{1} \pi_{1}\label{5.27} \]

Desde (5.27),\(p_{0} \pi_{0}=q_{1} \pi_{1}\). Para ver que\ ref {5.25} está satisfecho por\(i>0\), utilizamos inducción en\(i\), con\(i=0\) como base. Así supongamos, para un dado\(i\), eso\(p_{i-1} \pi_{i-1}=q_{i} \pi_{i}\). Sustituyendo esto en (5.26), obtenemos\(p_{i} \pi_{i}=q_{i+1} \pi_{i+1}\), completando así la prueba inductiva.

Es conveniente definir\(\rho_{i}\) como\(p_{i} / q_{i+1}\). Entonces tenemos\(\pi_{i+1}=\rho_{i} \pi_{i}\), e iterando esto,

\[\pi_{i}=\pi_{0} \prod_{j=0}^{i-1} \rho_{j} ; \quad \pi_{0}=\frac{1}{1+\sum_{i=1}^{\infty} \prod_{j=0}^{i-1} \rho_{j}}\label{5.28} \]

Si\(\sum_{i \geq 1} \prod_{0 \leq j<i} \rho_{j}<\infty\), entonces\(\pi_{0}\) es positivo y todos los estados son positivo-recurrentes. Si esta suma de productos es infinita, entonces ningún estado es positivo-recurrente. Si\(\rho_{j}\) se limita por debajo de 1, digamos\(\rho_{j} \leq 1-\epsilon\) para algunos fijos\(e>0\) y todos sucios grandes\(j\), entonces esta suma de productos convergerá y los estados serán positivo-recurrentes.

Para el simple proceso de nacimiento-muerte de la Figura 5.2, si definimos\(\rho=q / p\), entonces\(\rho_{j}=\rho\) para todos\(j\). Para\(\rho<1\),\ ref {5.28} simplifica a\(\pi_{i}=\pi_{o} \rho^{i}\) para todos\(i \geq 0\),\(\pi_{0}=1-\rho\), y\(\pi_{i}=(1-\rho) \rho^{i}\) por lo tanto para\(i \geq 0\). El ejercicio 5.2 muestra cómo encontrar\(F_{i j}(\infty)\) para todos\(i\),\(j\) en el caso donde\(\rho \geq 1\). Hemos visto que la cadena simple de nacimiento-muerte de la Figura 5.2 es transitoria si\(\rho>1\). Esto no es necesariamente así en el caso donde existen autotransiciones, pero la cadena sigue siendo transitoria o nula recurrente. Un ejemplo de ello surgirá en el Ejercicio 6.3.