2.4: El álgebra de Pauli

- Page ID

- 110078

2.4.1 Introducción

Consideremos el conjunto de todas las\(2 \times 2\) matrices con elementos complejos. Las definiciones habituales de adición matricial y multiplicación escalar por números complejos establecen este conjunto como un espacio vectorial de cuatro dimensiones sobre el campo de números complejos\(\mathcal{V}(4,C)\). Con la multiplicación matricial ordinaria, el espacio vectorial se convierte, lo que se denomina álgebra, en el sentido técnico explicado al final de la Sección 1.3. La naturaleza de la multiplicación matricial asegura que este álgebra, a denotar\(\mathcal{A}_{2}\), sea asociativo y no conmutativo, propiedades que están en línea con las aplicaciones teóricas grupales que tenemos en mente.

El nombre de “álgebra de Pauli” deriva, por supuesto, del hecho que\(\mathcal{A}_{2}\) fue introducido por primera vez en la física por Pauli, para encajar el espín electrónico en el formalismo de la mecánica cuántica. Desde entonces la aplicación de esta técnica se ha extendido a la mayoría de las ramas de la física.

Desde el punto de vista de las matemáticas,\(\mathcal{A}_{2}\) es meramente un caso especial del álgebra\(\mathcal{A}_{n}\) de\(n \times n\) matrices, por lo que estas últimas se interpretan como transformaciones sobre un espacio vectorial\(\mathcal{V}(n^{2}, C)\). Su reducción a formas canónicas es una parte hermosa del álgebra lineal moderna.

Mientras que los matemáticos no prestan especial atención al caso\(n = 2\), los físicos, que se ocupan del espacio-tiempo de cuatro dimensiones, tienen todas las razones para hacerlo, y resulta ser muy gratificante desarrollar procedimientos y pruebas para el caso especial en lugar de referirse a los teoremas matemáticos generales . La técnica para tal programa se ha desarrollado hace algunos años.

El formalismo resultante está estrechamente relacionado con el álgebra de cuaterniones complejos, y en consecuencia se ha denominado sistema de números hipercomplejos. El estudio de este último se remonta a Hamilton, pero la idea se ha desarrollado considerablemente en los últimos años. La sugerencia de que las matrices (1) deben considerarse simbólicamente como generalizaciones de números complejos que aún conservan propiedades “similares a números”, es atractiva, y haremos uso ocasional de la misma. Sin embargo, parece una multa convertir esto en el principio rector central. El uso de matrices armoniza mejor con la práctica habitual de la física y las matemáticas.

En el próximo desarrollo sistemático de este programa evidentemente cubriremos mucho terreno que es bien conocido, aunque algunas de las pruebas y conceptos de Whitney y Tisza no parecen ser utilizados en otros lugares. Sin embargo, la principal característica distintiva del presente enfoque es que no aplicamos el formalismo a teorías físicas que se supone dar, sino que desarrollamos las aplicaciones geométricas, cinemáticas y dinámicas en estrecha paralelo con la construcción del formalismo.

Dado que nuestra discusión está destinada a ser autónoma y económica, utilizamos las referencias solo con moderación. No obstante, en una etapa posterior señalaremos lo que sea necesario para facilitar la lectura de la literatura.

2.4.2 Definiciones y Procedimientos Básicos

Consideramos el conjunto\(\mathcal{A}_{2}\) de todas las matrices\(2 \times 2\) complejas

\[\begin{array}{c} {A = \begin{pmatrix} {a_{11}}&{a_{12}}\\ {a_{21}}&{a_{22}} \end{pmatrix}} \end{array} \label{EQ3.4.1}\]

Aunque se puede generar\(\mathcal{A}_{2}\) a partir de la base

\[\begin{array}{c} {e_{1} = \begin{pmatrix} {1}&{0}\\ {0}&{0} \end{pmatrix}} \end{array}\]

\[\begin{array}{c} {e_{2} = \begin{pmatrix} {0}&{1}\\ {0}&{0} \end{pmatrix}} \end{array}\]

\[\begin{array}{c} {e_{3} = \begin{pmatrix} {0}&{0}\\ {1}&{0} \end{pmatrix}} \end{array}\]

\[\begin{array}{c} {e_{4} = \begin{pmatrix} {0}&{0}\\ {0}&{1} \end{pmatrix}} \end{array}\]

en cuyo caso los elementos de la matriz son los coeficientes de expansión, a menudo es más conveniente generarlo a partir de una base formada por las matrices Pauli aumentadas por la matriz unitaria.

En consecuencia\(\mathcal{A}_{2}\) se llama álgebra de Pauli. Las matrices de base son

\[\begin{array}{c} {\sigma_{0} = I = \begin{pmatrix} {1}&{0}\\ {0}&{1} \end{pmatrix}} \end{array}\]

\[\begin{array}{c} {\sigma_{1} = \begin{pmatrix} {0}&{1}\\ {1}&{0} \end{pmatrix}} \end{array}\]

\[\begin{array}{c} {\sigma_{2} = \begin{pmatrix} {0}&{-i}\\ {i}&{0} \end{pmatrix}} \end{array}\]

\[\begin{array}{c} {\sigma_{3} = \begin{pmatrix} {1}&{0}\\ {0}&{-1} \end{pmatrix}} \end{array}\]

Las tres matrices Pauli satisfacen las conocidas reglas de multiplicación

\[\begin{array}{cc} {\sigma_{j}^2 = 1}&{j = 1,2,3} \end{array}\]

\[\begin{array}{cc} {\sigma_{j} \sigma_{k} = - \sigma_{k} \sigma_{j} = i \sigma_{l}}&{j k l = 1 2 3 \text{or an even permutation thereof}} \end{array} \label{EQ2.4.11}\]

Todas las matrices de base son hermitianas, o autoadjuntas:

\[\begin{array}{cc} {\sigma_{\mu}^{\dagger} = \sigma_{\mu}}&{\mu = 0,1,2,3} \end{array}\]

(Por convención, los índices romano y griego correrán de uno a tres y de cero a tres, respectivamente).

Representaremos la matriz A de la Ecuación\ ref {EQ2.4.1} como una combinación lineal de las matrices de base con el coeficiente de\(\sigma_{\mu}\) denotado por\(a_{\mu}\). Nos referiremos a los números\(a_{\mu}\) como los componentes de la matriz A. Como se puede inferir de las reglas de multiplicación, se obtienen de los elementos de la matriz por medio de la relación Ecuación\ ref {EQ2.4.11}, componentes de la matriz

\[\begin{array}{c} {a_{\mu} = \frac{1}{2}Tr(A \sigma_{\mu})} \end{array}\]

donde Tr significa rastro. En detalle,

\[\begin{array}{c} {a_{0} = \frac{1}{2}(a_{11}+a_{22})} \end{array}\]

\[\begin{array}{c} {a_{1} = \frac{1}{2}(a_{12}+a_{21})} \end{array}\]

\[\begin{array}{c} {a_{2} = \frac{1}{2}(a_{12}-a_{21})} \end{array}\]

\[\begin{array}{c} {a_{3} = \frac{1}{2}(a_{11}-a_{22})} \end{array}\]

En aplicaciones prácticas veremos a menudo que una matriz está mejor representada en un contexto por sus componentes, pero en otro por sus elementos. Es conveniente tener plena flexibilidad para elegir a voluntad entre los dos. Un conjunto de cuatro componentes\(a_{\mu}\), denotado por\(\{a_{\mu}\}\), a menudo se dividirá en un escalar complejo a0 y un complejo “vector”\(\{a_{1}, a_{2}, a_{3}\} = \vec{a}\). De igual manera, las matrices de base de se\(\mathcal{A}_{2}\) denotarán por\(\sigma_{0} = 1\) y\(\{\sigma_{1}, \sigma_{2}, \sigma_{3}\} = \vec{\sigma}\). Con esta notación,

\[\begin{array}{c} {A = \sum a_{\mu} \sigma_{\mu} = a_{0}1+\vec{a} \cdot \vec{\sigma}} \end{array}\]

\[\begin{array}{c} {= \begin{pmatrix} {a_{0}+a_{3}}&{a_{1}-ia_{2}}\\ {a_{1}+ia_{2}}&{a_{0}-a_{3}} \end{pmatrix}} \end{array}\]

Asociamos con .cada matriz la media traza y el determinante

\[\begin{array}{c} {\frac{1}{2} Tr A = a_{0}} \end{array}\]

\[\begin{array}{c} {|A| = a_{0}^{2}-\vec{a}^{2}} \end{array}\]

El grado en que estos números especifican las propiedades de la matriz A, será evidente a partir de la discusión de sus propiedades de invarianza en las dos subsecciones siguientes. La raíz cuadrada positiva del determinante es en cierto modo la norma de la matriz. Su no fuga:\(|A| \ne 0\), es el criterio para que A sea invertible.

Tales matrices pueden normalizarse para convertirse en unimodulares:

\[\begin{array}{c} {A \rightarrow |A|^{-1/2}A} \end{array}\]

El caso de las matrices singulares

\[\begin{array}{c} {|A| = a_{0}^{2}-\vec{a}^{2} = 0} \end{array}\]

pide comentarios. Llamamos matrices para las cuales\(|A| = 0\), pero\(A \ne 0\), matrices nulas. Por su ocurrencia, no\(\mathcal{A}_{2}\) es un álgebra de división. Esto contrasta, digamos, con el conjunto de cuaterniones reales que es un álgebra de división, ya que la norma se desvanece sólo para el cuaternión que se desvanece.

El hecho de que las matrices nulas son importantes, proviene en parte de la métrica indefinida de Minkowski. Sin embargo, se considerarán más adelante aplicaciones completamente diferentes.

Ahora enumeramos algunas reglas prácticas para las operaciones en\(\mathcal{A}_{2}\), presentándolas en términos de componentes de matriz en lugar de los elementos de matriz más familiares.

Para realizar multiplicaciones matriciales haremos uso de una fórmula implícita en las reglas de multiplicación, Ecuación\ ref {EQ3.4.11}:

\[\begin{array}{c} {(\vec{a} \cdot \vec{\sigma})(\vec{b} \cdot \vec{\sigma}) = \vec{a} \cdot \vec{b}I + i(\vec{a} \times \vec{b}) \cdot \sigma} \end{array}\]

donde\(\vec{a}\) y\(\vec{b}\) son vectores complejos.

Evidentemente, para cualquiera de dos matrices A y B

\[\begin{array}{c} {[A,B] = AB-BA = 2i(\vec{a} \times \vec{b}) \cdot \sigma} \end{array}\]

Las matrices A y B conmutan, si y solo si

\[\begin{array}{c} {\vec{a} \times \vec{b} = 0} \end{array} \label{EQ2.4.26}\]

es decir, si las partes vectoriales\(\vec{a}\) y\(\vec{b}\) son “paralelas” o al menos una de ellas desaparece

Además de las operaciones internas de suma y multiplicación, existen operaciones externas en\(\mathcal{A}_{2}\) su conjunto, las cuales son análogas a la conjugación compleja. Esta última operación es una involución, lo que significa que\((z^{*})^{*} = z\). De las tres involuciones, dos cualesquiera pueden considerarse independientes.

En\(\mathcal{A}_{2}\) tenemos dos involuciones independientes las cuales se pueden aplicar conjuntamente para producir una tercera:

\[\begin{array}{c} {A \rightarrow A = a_{0}I+\vec{a} \cdot \vec{\sigma}} \end{array}\]

\[\begin{array}{c} {A \rightarrow A^{\dagger} = a_{0}^{*}I+\vec{a}^{*} \cdot \vec{\sigma}} \end{array}\]

\[\begin{array}{c} {A \rightarrow \tilde{A} = a_{0}I-\vec{a} \cdot \vec{\sigma}} \end{array}\]

\[\begin{array}{c} {A \rightarrow \tilde{A}^{\dagger} = \bar{A} = a_{0}^{*}I+\vec{a}^{*} \cdot \vec{\sigma}} \end{array}\]

La matriz\(A^{\dagger}\) es el hermitiano colindante de A. Desafortunadamente, no hay ni un símbolo pactado, ni un término para\(\tilde{A}\). Whitney lo llamó conjugado de Pauli, otros términos son conjugado cuaterniónico o hiperconjugado\(A^{\ddagger}\) (ver Edwards, l.c.). Finalmente\(\bar{A}\) se llama reflexión compleja. Es fácil verificar las reglas

\[\begin{array}{c} {(AB)^{\dagger} = B^{\dagger}A^{\dagger}} \end{array}\]

\[\begin{array}{c} {(\tilde{AB}) = \tilde{B}\tilde{A}} \end{array}\]

\[\begin{array}{c} {(\bar{AB}) = \bar{B}\bar{A}} \end{array} \label{EQ2.4.33}\]

Según Equantion\ ref {EQ2.4.33} la operación de reflexión compleja mantiene la relación producto en\(\mathcal{A}_{2}\), es un automorfismo. En contraste, las conjugaciones Hermitian y Pauli son antiautomórficas.

Es de destacar que las tres operaciones\(\tilde{}, \dagger, \bar{}\), junto con el operador de identidad, forman un grupo (el de cuatro grupos, “Vierergruppe”). Esta es una marca de cierre: presumiblemente dejamos fuera a ningún operador importante en el álgebra.

En diversos contextos cualquiera de las tres conjugaciones aparece como una generalización de conjugaciones complejas ordinarias

Aquí hay algunas aplicaciones de las reglas de conjugación.

\[\begin{array}{c} {A\tilde{A} = (a_{0}^{2}-\vec{a}^{2})1 = |A|1} \end{array}\]

Para matrices invertibles

\[\begin{array}{c} {A^{-1} = \frac{\tilde{A}}{|A|}} \end{array}\]

Para matrices unimodulares tenemos la regla útil:

\[\begin{array}{c} {A^{-1} = \tilde{A}} \end{array} \label{EQ2.4.36}\]

Un marrix hermitiano\(A = A^{\dagger}\) tiene componentes reales\(h_{0}, \hat{h}\). Definimos una matriz para ser positiva si es hermitiana y tiene un rastro positivo y determinante:

\[\begin{array}{cc} {h_{0} > 0}&{|H| = (h_{0}^{2}-\vec{h}^2) > 0} \end{array}\]

Si H es positivo y unimodular, se puede parametrizar como

\[\begin{array}{c} {H = \cosh(\mu/2)1 + \sinh(\mu/2) \hat{h} \cdot \vec{\sigma} = \exp \{(\mu/2)h \cdot \vec{\sigma}\}} \end{array} \label{EQ2.4.38}\]

La matriz exponencial se define por una serie de potencias que reduce a la expresión trigonométrica. El factor 1/2 aparece sólo por conveniencia en la siguiente subsección.

En el álgebra de Pauli, la definición habitual\(U^{\dagger} = U^{-1}\) de una matriz unitaria toma la forma

\[\begin{array}{c} {u_{0}^{*}1+\vec{u}^{*} \cdot \vec{\sigma} = |\vec{U}|^{-1}(u_{0}1-\vec{u} \cdot \vec{\sigma})} \end{array}\]

Si U también es unimodular, entonces

\[\begin{array}{c} {u_{0} = u_{0}^{*} = \text{real}} \end{array}\]

\[\begin{array}{c} {\vec{u} = \vec{u} = \text{imaginary}} \end{array}\]

y

\[\begin{array}{c} {u_{0}^{2}-\vec{u} \cdot \vec{u} = u_{0}^{2}+\vec{u} \cdot \vec{u}^{*} = 1}\\ {U = \cos(\phi/2)1 − i \sin(\phi/2)\hat{u} \cdot \vec{\sigma} = \exp (-i(\phi/2)\hat{u} \cdot \vec{\sigma})} \end{array} \label{EQ2.4.42}\]

Una matriz unimodular unitaria se puede representar también en términos de elementos

\[\begin{array}{c} {\begin{pmatrix} {\xi_{0}}&{-\xi_{1}^{*}}\\ {\xi_{1}}&{\xi_{0}^{*}} \end{pmatrix}} \end{array}\]

con

\[\begin{array}{c} {|\xi_{0}|^2+|\xi_{1}|^2 = 1} \end{array}\]

donde\(\xi_{0}, \xi_{1}\), son los llamados parámetros Cayley-Klein. Veremos que tanto esta forma, como la representación eje-ángulo, Ecuación\ ref {EQ2.4.42}, son útiles en el contexto adecuado.

Pasamos ahora a la categoría de matrices normales N definida por la condición de que viajen con su hermitiano colindante:\(N^{\dagger}N = NN^{\dagger}\). Invocando la condición, Ecuación\ ref {EQ2.4.26}, tenemos

\[\begin{array}{c} {\vec{n} \times \vec{n}^{*} = 0} \end{array}\]

lo que implica que\(n^{∗}\) es proporcional a n, es decir todos los componentes de\(\vec{n}\) deben tener la misma fase. Por lo tanto, las matrices normales son de la forma

\[\begin{array}{c} {N = n_{0}1+n \hat{n} \cdot \vec{\sigma}} \end{array}\]

donde\(n_{0}\) y n son constantes complejas y hatn es un vector unitario real, al que llamamos el eje de N. En particular, cualquier matriz normal unimodular puede expresarse como

\[\begin{array}{c} {N = \cos(\kappa/2)1 + \sinh(\kappa/2)\hat{n} \cdot \vec{\sigma} = \exp ((\kappa/2)\hat{n} \cdot \vec{\sigma})} \end{array}\]

donde\(k = \mu-i \phi, -\infty < \mu < \infty, 0 ≤ \phi < 4\pi\), y\(\hat{n}\) es un vector de unidad real. Si\(\hat{n}\) apunta en la dirección “3”, tenemos

\[\begin{array}{c} {N_{0} = \exp ((\kappa/2) \sigma_{3}) = \begin{pmatrix} {\exp(\kappa/2)}&{0}\\ {0}&{\exp(-\kappa/2)} \end{pmatrix}} \end{array} \label{EQ3.4.48}\]

Así los exponenciales matriciales, Ecuaciones\ ref {EQ2.4.38},\ ref {EQ2.4.42} y\ ref {EQ2.4.48}, son generalizaciones de una matriz diagonal y esta última se distingue por el requisito de que el eje apunte en la dirección z.

Claramente la matriz normal, Ecuación\ ref {EQ2.4.48}, es un producto de desplazamiento de una matriz positiva como Ecuación\ ref {EQ2.4.38} con\(\hat{h} = \hat{n}\) y una matriz unitaria como Ecuación\ ref {EQ2.4.42}, con\(\hat{u} = \hat{n}\):

\[\begin{array}{c} {N = HU = UH} \end{array} \label{EQ2.4.49}\]

Las expresiones en la Ecuación\ ref {EQ2.4.49} se denominan las formas polares de N, siendo elegido el nombre para sugerir que la representación de N por H y U es análoga a la representación de un número complejo z por un número positivo r y un factor de fase:

\[\begin{array}{c} {z = r \exp(−i\phi/2)} \end{array}\]

Demostraremos que, de manera más general, cualquier matriz invertible tiene dos formas polares únicas

\[\begin{array}{c} {A = HU = UH'} \end{array} \label{EQ2.4.51}\]

pero solo las formas polares de las matrices normales muestran las siguientes características especiales equivalentes:

- H y U de viaje

- \(\hat{h} = \hat{u} = \hat{n}\)

- \(H' = H\)

Vemos del teorema de la descomposición polar que nuestro énfasis en las matrices positivas y unitarias está justificado, ya que todas las matrices de\(\mathcal{A}_{2}\) pueden producirse a partir de tales factores. Se procede ahora a probar el teorema expresado en la Ecuación\ ref {EQ2.4.51} mediante una construcción explícita.

Primero formamos la matriz\(AA^{\dagger}\), que es positiva por los criterios\ ref {EQ2.4.36}:

\[\begin{array}{c} {a_{0}a_{0}^{*} +\vec{a} \cdot \vec{a}^{*} > 0} \end{array}\]

\[\begin{array}{c} {|A||A^{\dagger}| > 0} \end{array}\]

\(AA^{\dagger}\)Sea expresado en términos de un eje\(\hat{h}\) y el ángulo hiperbólico\(\mu\):

\[\begin{array}{c} {AA^{\dagger} = b(\cosh \mu 1+\sinh \mu \hat{h} \cdot \hat{\sigma})}\\ {b \exp(\mu \hat{h} \cdot \hat{\sigma})} \end{array} \label{EQ2.4.54}\]

donde b es una constante positiva. Afirmamos que el componente hermitiano de A es la raíz cuadrada positiva de\ ref {EQ2.4.54}

\[\begin{array}{c} {H = (AA^{\dagger})^{1/2} = b^{1/2} \exp(\frac{\mu}{2} \hat{h} \cdot \hat{\sigma})} \end{array} \label{EQ2.4.55}\]

con

\[\begin{array}{cc} {U = H^{-1}A}&{A = HU} \end{array} \label{EQ2.4.56}\]

Que U es de hecho unitario se verifica fácilmente:

\[\begin{array}{cc} {U^{\dagger} = A^{\dagger}H^{-1}}&{U^{-1} = A^{-1}H} \end{array}\]

y estas expresiones son iguales por Ecuación\ ref {EQ3.4.55}. De la ecuación\ ref {EQ2.4.56} obtenemos

\(A = U(U^{-1}HU)\)

y

\[\begin{array}{ccc} {A =UH'}&{\text{with}}&{H' = U^{-1}HU} \end{array} \label{EQ2.4.58}\]

Queda por demostrar que las formas polares\ ref {EQ2.4.56} son únicas. Supongamos que efectivamente, que para una A en particular tenemos dos factorizaciones

\[\begin{array}{c} {A = HU = H_{1}U_{1}} \end{array}\]

entonces

\[\begin{array}{c} {AA^{\dagger} = H^2 = H_{1}^{2}} \end{array}\]

Pero, ya que\(AA^{\dagger}\) tiene una raíz cuadrada positiva única,\(H_{1} = H\), y

\[\begin{array}{cc} {U = H_{1}^{-1}A = H^{-1}A = U}&{q.e.d} \end{array}\]

Las formas polares son bien conocidas por existir para cualquier\(n \times n\) matriz, aunque las pruebas de singularidad generalmente se formulan para transformaciones abstractas más que para matrices, y requieren que las transformaciones sean invertibles.

2.4.3 El grupo restringido Lorentz

Habiendo concluido la clasificación de las matrices de\(\mathcal{A}_{2}\), estamos listos para interpretarlas como óperas y establecer una conexión con el grupo Lorentz. El procedimiento sencillo sería introducir un espacio vectorial complejo bidimensional\(\mathcal{V}(\in, C)\). Al usar el formalismo de braket familiar escribimos

\[\begin{array}{c} {A|\xi \rangle = |\xi' \rangle} \end{array} \label{EQ3.4.62}\]

\[\begin{array}{c} {A^{\dagger} \langle \xi| = \langle \xi' |} \end{array}\]

Los vectores complejos de dos componentes se denominan comúnmente espinores. Estudiaremos sus propiedades en detalle en la Sección 5. La razón de este retraso es que la interpretación física de las espinoras es un problema sutil con muchas ramificaciones. Se aconseja considerar al principio situaciones en las que el objeto que se va a operar pueda ser representado por una\(2 \times 2\) matriz.

La elección obvia es considerar matrices hermitianas, cuyos componentes se interpretan como cuatro vectores relativistas. La conexión entre cuatro vectores y matrices es tan cercana que a menudo es conveniente usar el mismo símbolo para ambos:

\[\begin{array}{c} {A = a_{0}1+\vec{a} \cdot \vec{\sigma}} \end{array}\]

\[\begin{array}{c} {A = \{a_{0}, \vec{a}\}} \end{array}\]

Tenemos

\[\begin{array}{c} {a_{0}^{2}-\vec{a}^{2} = |A| = Tr(A\bar{A})} \end{array}\]

o más generalmente

\[\begin{array}{c} {a_{0}b_{0}-\vec{a}\vec{b} = Tr(A\bar{B})} \end{array} \label{EQ2.4.66}\]

Una transformación de Lorentz se define como una transformación lineal

\[\begin{array}{c} {\{a_{0}, \vec{a}\} = \mathcal{L} \{a'_{0}, \vec{a}'\}} \end{array} \label{EQ2.4.67}\]

que deja la expresión\ ref {EQ2.4.67} y por lo tanto también\ ref {EQ2.4.66} invariante. Se requiere además que el signo del “componente de tiempo” a0 sea invariante (transformación ortócrona de Lorentz\(L^{\uparrow}\)), y que el determinante de la\(4 \times 4\) matriz L sea positivo (transformación propia de Lorentz\(L_{+}\)). Si se cumplen ambas\(\uparrow\) condiciones, hablamos del grupo restringido Lorentz\(L_{+}^{\uparrow}\). Este es el único que nos interesa actualmente, y hasta nuevo aviso “Grupo Lorentz” debe interpretarse en este sentido restringido.

Obsérvese que A puede interpretarse como cualquiera de los cuatro vectores discutidos en la Sección 3.2:\(R = \{r, \vec{r}\}\),

\[\begin{array}{cc} {K = \{k_{0}, \vec{k}\}}&{P = \{p_{0}, \vec{p}\}} \end{array}\]

Aunque estos vectores y sus equivalentes de matriz tienen propiedades de transformación idénticas, difieren en el posible rango de sus determinantes. Un negativo\(|P|\) puede surgir solo para una masa de descanso imaginaria no física. Por el contrario, una R positiva corresponde a un desplazamiento temporal que apunta hacia el futuro, una R con un desplazamiento negativo\(|R|\) a un espacio y\(|R| = 0\) se asocia con el cono de luz. Para el vector onda tenemos por definición\(|K| = 0\).

Para describir una transformación de Lorentz en el álgebra de Pauli probamos el “ansatz”

\[\begin{array}{c} {A' = VAW} \end{array}\]

con\(|V| = |W| = 1\) el fin de preservar\(|A|\). La realidad del vector, es decir, la hermiticidad de la matriz A se conserva si\(W = V^{\dagger}\) se cumple la condición adicional. Así la transformación

\[\begin{array}{c} {A' = VAV^{\dagger}} \end{array} \label{EQ2.4.72}\]

deja la expresión\ ref {EQ2.4.66} invariante. Es fácil demostrar que\ ref {EQ2.4.67} también es invariante.

La compleja reflexión A se transforma como

\[\begin{array}{c} {\bar{A}' = \bar{V}\bar{A}\tilde{V}} \end{array} \label{EQ2.4.73}\]

y el producto de dos cuatro vectores:

\[\begin{array}{cc} {(A\bar{B})' = VAV^{\dagger}\bar{V}\bar{B}\tilde{V}}\\ {= V(A\bar{B})V^{-1}} \end{array}\]

Se trata de una llamada transformación de similitud. Al tomar el rastro de la Ecuación\ ref {EQ2.4.73} confirmamos que el producto interno\ ref {EQ2.4.67} es invariante bajo\ ref {EQ2.4.72}. Tenemos que recordar que una permutación cíclica no afecta el rastro de un producto de matrices. Así, la Ecuación\ ref {EQ2.4.72} induce de hecho una transformación de Lorentz en el espacio de cuatro vectores de A.

Es bien sabido que la afirmación inversa también es cierta: a cada transformación del grupo restringido de Lorentz\(L_{+}^{\uparrow}\) se asocian dos matrices que difieren, solo por signo (sus parámetros\(\phi\) difieren en\(2 \pi\)) de tal manera que constituyen un homomorfismo de dos a uno entre los grupo de matrices unimodulares\(\mathcal{SL}(2, C)\) y el grupo\(L_{+}^{\uparrow}\). Se dice también que\(\mathcal{SL}(2, C)\) proporciona una representación de dos valores de\(L_{+}^{\uparrow}\). Demostraremos esta afirmación demostrando explícitamente la conexión entre las matrices V y las operaciones de grupo inducidas o asociadas.

Observamos primero que A y\(\bar{A}\) corresponden en el lenguaje tensor a la representación contravariante y covariante de un vector. Ilustramos el uso del formalismo dando una forma explícita para la inversa de\ ref {EQ2.4.72}

\[\begin{array}{c} {A = V^{-1}A'V^{\dagger -1} \equiv \tilde{V}A'\bar{V}} \end{array}\]

Invocamos el teorema de descomposición polar Ecuación\ ref {EQ2.4.49} de la Sección 2.4.2 y observamos que es suficiente establecer esta conexión para matrices unitarias y positivas respectivamente.

Considerar al principio

\[\begin{array}{c} {A' = UAU^{\dagger} \equiv UAU^{-1}} \end{array} \label{EQ2.4.75}\]

con

\(U (\hat{u}, \frac{\phi}{2}) \equiv \exp(-\frac{i \phi}{2} \hat{u} \cdot \vec{\sigma})\)

\[\begin{array}{cc} {u_{1}^{2}+u_{2}^{2}+u_{3}^{2} = 1}&{0 < \phi < 4\pi} \end{array} \label{EQ2.4.76}\]

El conjunto de todas las matrices unimodulares unitarias descritas por la Ecuación\ ref {EQ2.4.76} forman un grupo que comúnmente se llama\(\mathcal{SU}(2)\).

Descompongamos\(\vec{a}\):

\[\begin{array}{c} {\vec{a} = \vec{a}_{\parallel} +\vec{a}_{\perp}} \end{array}\]

\[\begin{array}{cc} {\vec{a}_{\parallel} =(\vec{a} \cdot \hat{u}) \hat{u}}&{\vec{a}_{\perp} = \vec{a}-\vec{a}_{\parallel} = \hat{u} \times (\vec{a} \times \hat{u})} \end{array}\]

Es fácil ver que la Ecuación\ ref {EQ2.4.75} deja\(a_{0}\) e\(a_{\parallel}\) invariante e induce una rotación alrededor\(\hat{u}\) por un ángulo\(\phi: R \{\hat{u}, \phi\}\).

Por el contrario, a cada rotación\(R \{\hat{u}, \phi\}\) le corresponden dos matrices:

\[\begin{array}{ccc} {U(\hat{u}, \phi)}&{\text{and}}&{U(\hat{u}, \phi+2\pi) = -U(\hat{u}, \phi)} \end{array}\]

Tenemos\(1 \rightarrow 2\) homomorfismo entre\(\mathcal{SO}(3)\) y\(\mathcal{SU}(2)\), se dice que este último es una representación de dos valores de la primera. Al establecer esta correspondencia hemos resuelto el problema de la parametrización formulado en la página 13. Los nueve parámetros de las\(3 \times 3\) matrices ortogonales se reducen a los tres independientes de\(U(\hat{u}, \frac{\phi}{2})\). Además tenemos el resultado simple

\[\begin{array}{c} {U^{n} = \exp(\frac{in \phi}{2} \hat{u} \cdot \vec{\sigma})} \end{array}\]

lo que reduce al teorema de Moivre si\(\hat{n} \cdot \vec{\sigma} = \sigma_{3}\).

Algún comentario está en orden respecto a la doble valorización de la\(\mathcal{SU}(2)\) representación. Esto se produce por el uso de medios ángulos en el formalismo algebraico que está profundamente arraigado en la estructura geométrica del grupo de rotación. (Véase el teorema de Rodrígues-Hamilton en la Sección 2.2.)

Considerando que la doble valorización de la\(\mathcal{SU}(2)\) representación no afecta a la transformación de la

Un vector basado en la expresión bilateral\ ref {EQ2.4.75}, la situación se verá diferente en la teoría espinorial basada en la Ecuación\ ref {EQ2.4.62}, ya que bajo ciertas condiciones el signo de la espinora\(|\xi \rangle\) es físicamente significativo.

La discusión anterior del grupo de rotación es incompleta incluso dentro de la teoría clásica. La rotación\(R \{\hat{u}, \frac{\phi}{2}\}\) deja los vectores a lo largo\(\hat{u}\) sin afectar. Un objeto más apropiado para ser girado es la tríada cartesiana, que se discutirá en la Sección 5.

Consideramos ahora el caso de una matriz positiva\(V = H\)

\[\begin{array}{c} {A' = HAH} \end{array}\]

con

\[\begin{array}{c} {H = \exp(\frac{\mu}{2} \hat{h} \cdot \sigma)} \end{array}\]

\[\begin{array}{cc} {h_{1}^{2}+h_{2}^{2}+h_{3}^{2} = 1}&{-\infty < \mu < \infty} \end{array}\]

Nos descomponemos\(\vec{a}\) como

\[\begin{array}{c} {\vec{a} = a \hat{h}+\vec{a}_{\perp}} \end{array}\]

y usando el hecho de que\((\vec{a} \cdot \vec{\sigma})\) y\((\vec{b} \cdot \vec{\sigma})\) viaje para\(\vec{a} \parallel \vec{b}\) y antiviaje para\(\vec{a} \perp \vec{b}\), obtenemos

\[\begin{array}{c} {A' = \exp(\frac{\mu}{2} \hat{h} \cdot \sigma)(a_{0}1+a \hat{h} \cdot \sigma+\vec{a}_{\perp} \cdot \sigma) \exp(\frac{\mu}{2} \hat{h} \cdot \sigma)} \end{array}\]

\[\begin{array}{c} {= \exp(\mu \hat{h} \cdot \sigma)(a_{0}1+a \hat{h} \cdot \sigma)+\vec{a}_{\perp} \cdot \sigma} \end{array}\]

De ahí

\[\begin{array}{c} {a'_{0} = \cosh \mu a_{0}+ \sinh \mu a} \end{array}\]

\[\begin{array}{c} {a' = \sinh \mu a_{0}+ \cosh \mu a_{0}} \end{array}\]

\[\begin{array}{c} {\vec{a}'_{\perp} = \vec{a}_{\perp}} \end{array}\]

Esto se va a comparar con el Cuadro 2.1, pero recordemos que hemos pasado de la interpretación pasiva a la activa, del alias a la coartada.

Las matrices positivas con un eje común forman un grupo (el “pequeño grupo” de Wigner), pero en general el producto de matrices hermitianas con diferentes ejes no son hermitianos. Surge un factor unitario, que es la base matemática de la famosa precesión de Tomás.

Consideremos ahora una matriz normal

\[\begin{array}{c} {V = N = H(\hat{k}, \frac{\mu}{2})U(\hat{k}, \frac{\phi}{2}) = \exp(\frac{\mu-i \phi}{2} \hat{n} \cdot \sigma)} \end{array}\]

donde tenemos el producto de desplazamiento de una rotación y una transformación Lorentz con el mismo eje\(\hat{n}\). Tal constelación se llama Lorentz de 4 tornillos

Una secuencia arbitraria de transformaciones puras de Lorentz y rotaciones puras se asocia con un par de matrices V y\(-V\), que en el caso general es de la forma

\[\begin{array}{c} {H(\hat{h}, \frac{\mu}{2})U(\hat{\mu}, \frac{\phi}{2}) = U(\hat{\mu}, \frac{\mu}{2})H'(\hat{h}', \frac{\phi}{2})} \end{array}\]

De acuerdo con la Ecuación\ ref {EQ2.4.58} de la Sección 2.4.2, H y H' están conectados por una transforación de similitud, que no afecta al ángulo\(\mu\), sino solo al eje de la transformación. (Ver la siguiente sección.)

Esta matriz depende de los 6 parámetros\(\hat{h}, \mu, \hat{u}, \phi\), y así hemos resuelto el problema general de parametrización mencionado anteriormente.

Para una matriz normal\(\hat{h} = \hat{u} = \hat{n}\) y el número de parámetros se reduce a 4.

Nuestro formalismo nos permite dar una forma cerrada para dos matrices normales arbitrarias y los correspondientes 4 tornillos.

\[\begin{array}{c} {[N, N'] = 2i \sinh \frac{\kappa}{2} \sinh \frac{\kappa}{2} (\hat{n} \times \hat{n}') \cdot \vec{\sigma}} \end{array}\]

donde\(\kappa = \mu-i \phi, \kappa' = \mu'-i \phi\).

En la literatura las relaciones de conmutación suelen darse en términos de operadores infinitesimales que se definen de la siguiente manera:

\[\begin{array}{c} {U(\hat{u}_{k}, \frac{d \phi}{2}) = 1-d \phi \sigma_{k} = 1+d \phi I_{k}} \end{array}\]

\[\begin{array}{c} {I_{k} = -\frac{i}{2} \sigma_{k}} \end{array}\]

\[\begin{array}{c} {H(\hat{h}_{k}, \frac{d \mu}{2}) = 1+\frac{d \mu}{2} \sigma_{k} = 1+d \mu L_{k}} \end{array}\]

\[\begin{array}{c} {L_{k} = \frac{1}{2} \sigma_{k}} \end{array}\]

Las relaciones de conmutación son

\[\begin{array}{c} {[I_{1},I_{2}] = I_{3}} \end{array}\]

\[\begin{array}{c} {[L_{1},L_{2}] = -I_{3}} \end{array}\]

\[\begin{array}{c} {[L_{1},I_{2}] = L_{3}} \end{array}\]

y permutaciones cíclicas.

Es un resultado bien conocido de la teoría Lie-Cartan del grupo continuo que estos generadores infinitesimales determinan todo el grupo. Desde que hemos representado a estos generadores en\(\mathcal{SL}(2,C)\), hemos completado la demostración de que todo el grupo\(L_{+}^{\uparrow}\) está contabilizado en nuestro formalismo.

3.4.4 Clases de similitud y formas canónicas de transformaciones activas

Es evidente que una transformación de Lorentz inducida por una matriz\(H(\hat{h}, \frac{\mu}{2})\) asume una forma particularmente simple si el eje z del sistema de coordenadas se coloca en la dirección de\(\hat{h}\). Se dice que la matriz diagonal\(H(\hat{z}, \frac{\mu}{2})\) es la forma canónica de la transformación. Esta afirmación es un caso especial del problema de las formas canónicas de transformaciones lineales, un capítulo importante en álgebra lineal.

Consideremos un mapeo lineal en un espacio vectorial. Una elección particular de base conduce a una representación matricial del mapeo, y las representaciones asociadas con diferentes marcos están conectadas por transformaciones de similitud. Que\(A_{1}\), sea una matriz arbitraria y S una invertible. Una transformación de similitud se efectúa en A, por

\[\begin{array}{c} {A_{2} = SA_{1}S^{-1}} \end{array} \label{EQ2.4.100}\]

Las matrices relacionadas por transformación de similitud se denominan similares, y las matrices similares entre sí constituyen una clase de similitud.

En la práctica habitual el mapeado se refiere a un espacio vectorial como en la Ecuación\ ref {EQ2.4.62} de la Sección 2.4.3:

\[\begin{array}{c} {A_{1} |\xi \rangle_{1} = | \xi' \rangle_{1}} \end{array} \label{EQ2.4.101}\]

El subíndice se refiere a la base “1”. Un cambio de base\(\sum_{1} \rightarrow \sum_{2}\) se expresa como

\[\begin{array}{cc} {|\xi \rangle_{2} = S|\xi \rangle_{1}}&{|\xi' \rangle_{2} = S|\xi' \rangle_{1}} \end{array}\]

Insertando en la Ecuación\ ref {EQ2.4.101} obtenemos

\[\begin{array}{c} {A_{1} S^{-1} |\xi \rangle_{2} = S^{-1} | \xi \rangle_{2}} \end{array}\]

y por lo tanto

\[\begin{array}{c} {A_{2} |\xi \rangle_{2} = | \xi \rangle_{2}} \end{array}\]

donde\(A_{2}\) se da de hecho por la Ecuación\ ref {EQ2.4.100}

El procedimiento que hemos seguido hasta ahora para representar las transformaciones de Lorentz\(A_{2}\) no sigue este patrón estándar.

Hemos estado considerando mapeos del espacio de cuatro vectores que a su vez fueron representados como matrices\(2 \times 2\) complejas. Así, tanto los operadores como los operandos son matrices de\(A_{2}\). A pesar de esta diferencia en la interpretación, las representaciones matriciales en diferentes marcos aún están relacionadas de acuerdo con la Ecuación\ ref {EQ2.4.100}.

Esto se puede mostrar de la siguiente manera. Consideremos una matriz unimodular A, que induce una transformación Lorentz en el espacio P, por lo que las matrices se refieren a la base\(\sum_{1}\):

\[\begin{array}{c} {P_{1}' = A_{1}P_{1}A_{1}^{\dagger}} \end{array} \label{EQ2.4.105}\]

Interpretamos la Ecuación\ ref {EQ2.4.105} en el sentido activo como un mapeo lineal del espacio P sobre sí mismo que corresponde físicamente a algún proceso dinámico que altera P de manera lineal.

Veremos en la Sección 4 que la fuerza de Lorentz que actúa sobre una partícula cargada durante el tiempo dt puede considerarse efectivamente como una transformación activa de Lorentz. (Véase también la página 26.)

El proceso tiene un significado físico independiente del marco del observador, pero las representaciones matriciales de\(P, P'\) y de A dependen del marco. Los cuatro momentos en los dos marcos están conectados por una transformación de Lorentz interpretada en el sentido pasivo:

\[\begin{array}{c} {P_{2} = SP_{1}S^{\dagger}} \end{array}\]

\[\begin{array}{c} {P_{2} = SP_{1}' S^{\dagger}} \end{array}\]

con\(|S| = 1\). Resolviendo\(P, P'\) e insertando en la Ecuación\ ref {EQ2.4.105}, obtenemos

\[\begin{array}{c} {S^{-1}P_{2}' \tilde{S}^{\dagger} = A_{1}S^{-1} P_{2} \tilde{S}^{\dagger} A_{1}^{\dagger}S} \end{array}\]

o

\[\begin{array}{c} {P_{2}' = A_{2}P_{2}A_{1}^{\dagger}} \end{array}\]

donde\(A_{2}\) y de nuevo\(A_{1}\) están conectados por la transformación de similitud\ ref {EQ2.4.100}.

Podemos aplicar el teorema de descomposición polar a la matriz S. En el caso especial de que S sea unitario, hablamos de una transformación de similitud unitaria correspondiente a la rotación del sistema de coordenadas discutido al inicio de esta sección. Sin embargo, el caso general nos llevará a aplicaciones físicas menos obvias.

Las consideraciones anteriores proporcionan suficiente motivación para examinar las clases de similitud de\(\mathcal{A}_{2}\). Veremos que todos ellos tienen aplicaciones físicas, aunque la interpretación de mapeos singulares se discutirá sólo más adelante.

Las clases de similitud se pueden caracterizar de varias maneras convenientes. Por ejemplo, se pueden usar dos invariantes de similitud independientes compartidas por todas las matrices\(A = a_{0}l+\vec{a} \cdot \vec{\sigma}\) de la clase. Nos resultará conveniente elegir

- el determinante\(|A|\), y

- la cantidad\(\vec{a}^2\)

El rastro también es una similitud invariante, pero no es independiente:\(a_{0}^{2} = |A|+\vec{a}\).

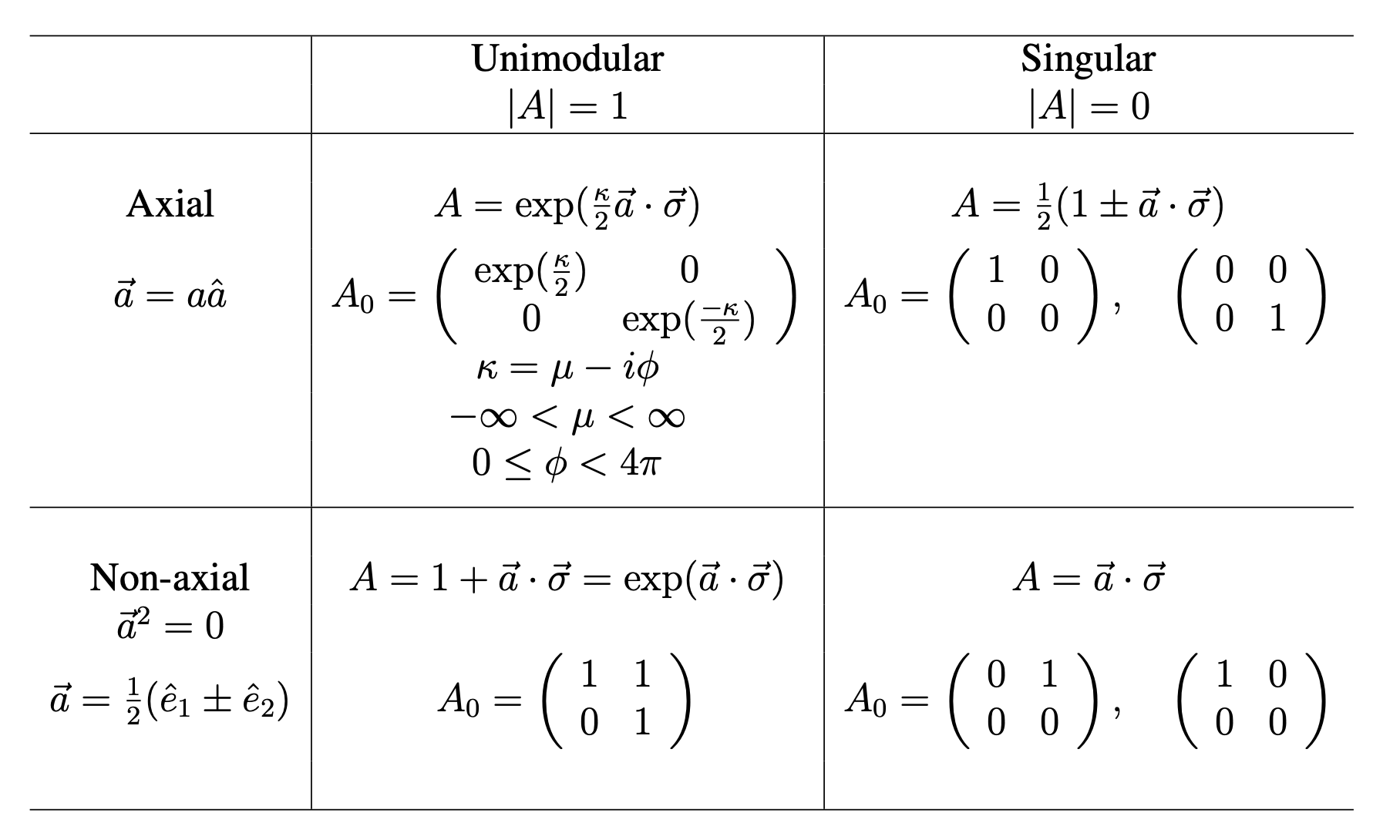

Alternativamente, se puede caracterizar a toda la clase por un miembro representativo de la misma, alguna matriz\(A_{0}\) llamada la forma canónica para la clase (Ver Tabla 2.2).

Se procede al principio a caracterizar las clases de similitud en términos de las invariantes 1 y 2. Recordamos que una matriz A es invertible si\(|A| \ne 0\) y singular si\(|A| = 0\). Sin pérdida significativa de generalidad, podemos normalizar las matrices invertibles de\(\mathcal{A}_{2}\) ser unimodulares, por lo que necesitamos discutir solo clases de matrices singulares y de matrices unimodulares. Como segunda invariante para caracterizar una clase, elegimos\(\vec{a} \cdot \vec{a}\), y decimos que una matriz A es axial si\(\vec{a} \cdot \vec{a} = 0\). En este caso, existe un vector unitario\(\hat{a}\) (posiblemente complejo) tal que\(\vec{a} = a \cdot \hat{a}\) donde a es una constante compleja. El vector unitario\(\hat{a}\) se denomina eje de A. Por el contrario, la matriz A es no axial si\(\vec{a} \cdot \vec{a} = 0\), el vector\(\vec{a}\) se llama isotrópico o un vector nulo, no puede expresarse en términos de un eje.

El concepto de eje como aquí se define es la generalización del eje real introducido en conexión con matrices normales en la página 33. La utilidad de este concepto es evidente a partir del siguiente teorema:

Para dos vectores unitarios cualesquiera\(\hat{v}_{1}\)\(\hat{v}_{2}\), y, reales o complejos, existe una matriz S tal que

\[\begin{array}{c} {\hat{v}_{2} \cdot \vec{\sigma} = S \hat{v}_{1} \cdot \vec{\sigma} S^1} \end{array}\]

- Prueba

-

Construimos una de esas matrices S a partir de las siguientes consideraciones. Si\(\hat{v}_{1}\), y\(\hat{v}_{2}\) son reales, entonces deja que S sea la matriz unitaria que gira cada vector en un ángulo π alrededor de un eje que biseca el ángulo entre\(\hat{v}_{1}\), y\(\hat{v}_{2}\):

\[\begin{array}{c} {S = -i \hat{s} \cdot \vec{\sigma}} \end{array} \label{EQ3.4.111}\]

donde

\[\begin{array}{c} {s = \frac{\hat{v}_{1}+\hat{v}_{2}}{\sqrt{2\hat{v}_{1} \cdot \hat{v}_{2}+2}}} \end{array} \label{EQ3.4.112}\]

Aunque\(\hat{v}_{1}\), y no\(\hat{v}_{2}\) sean reales, se verifica fácilmente que S como lo dan formalmente las Ecuaciones\ ref {EQ3.4.111} y\ ref {EQ3.4.112}, efectivamente envía\(\hat{v}_{1}\) a\(\hat{v}_{2}\). Naturalmente, S no es único; por ejemplo, cualquier matriz del

\[\begin{array}{c} {S = \exp \{(\frac{\mu_{2}}{2}-i \frac{\phi_{2}}{2}) \vec{v}_{2} \cdot \vec{\sigma}\}( -i \hat{s} \cdot \vec{\sigma}) \exp \{(\frac{\mu_{1}}{2}-i \frac{\phi_{1}}{2}) \vec{v}_{1} \cdot \vec{\sigma}\}.} \end{array}\]

se enviará\(\hat{v}_{1}\) a\(\hat{v}_{2}\).

Esta construcción falla solo si

\[\begin{array}{c} {\hat{v}_{1} \cdot \hat{v}_{2}+1 = 0} \end{array}\]

eso es para la transformación\(\hat{v}_{1} \rightarrow -\hat{v}_{2}\) En este caso trivial elegimos

\[\begin{array}{cc} {S = -i \hat{s} \cdot \vec{\sigma}}&{\hat{s} \perp \vec{v}_{1}} \end{array}\]

Ya que en el álgebra Pauli las matrices diagonales se caracterizan por el hecho de que su eje es\(\hat{x}_{3}\), hemos demostrado el siguiente teorema:

Todas las matrices axiales son diagonizables, pero las matrices normales y solo las normales son diagonizables por una transformación de similitud unitaria.

Las formas diagonales se determinan fácilmente tanto para los casos singulares como para los unimodulares. (Ver Cuadro 2.2.) Por su sencillez se les llama también formas canónicas. Tenga en cuenta que se pueden multiplicar por cualquier número complejo con el fin de obtener todas las matrices axiales de\(\mathcal{A}_{2}\).

La situación ahora es completamente clara: las formas canónicas muestran la naturaleza del mapeo; una transformación unitaria de similitud simplemente cambia la orientación geométrica del eje. El ángulo de rotación circular e hiperbólico especificado por\(a_{0}\) es invariante. Una transformación general complejiza el eje. Esta situación se produce si en la forma polar de la matriz\(A = HU\), los factores tienen ejes reales distintos, y por lo tanto no se conmutan.

Queda por tratar el caso de las matrices no axiales. Considera\(A = \vec{a} \cdot \vec{\sigma}\) con\(\vec{a}^{2} = 0\). Descompongamos el vector isotrópico\(\vec{a}\) en partes reales e imaginarias:

\[\begin{array}{c} {\vec{a} = \vec{\alpha}+i\beta} \end{array}\]

De ahí\(\vec{\alpha}^{2}-\vec{\beta}^2 = 0\) y\(\alpha \cdot \beta = 0\). Dado que las partes real e imaginaria de a son perpendiculares, podemos rotar estas direcciones mediante una transformación de similitud unitaria en las direcciones x e y respectivamente. La matriz transformada es

\[\begin{array}{c} {\frac{\alpha}{2} (\sigma_{1}+i\sigma_{2}) = \begin{pmatrix} {0}&{\alpha}\\{0}&{0} \end{pmatrix}} \end{array} \label{EQ3.4.117}\]

con un positivo. Otra transformación de similitud con

\[\begin{array}{c} {S = \begin{pmatrix} {\alpha^{-1/2}}&{0}\\{0}&{\alpha^{1/2}} \end{pmatrix}} \end{array}\]

transforma la Ecuación\ ref {EQ3.4.117} en la forma canónica dada en la Tabla 2.2.

Como hemos visto en la Sección 2.4.3 todas las matrices unimodulares inducen transformaciones de Lorentz en Minkowski, o espacio de cuatro momentos. De acuerdo con los resultados resumidos en la Tabla 2.2, los mapeos inducidos por matrices axiales pueden ser traídos por transformaciones de similitud en los llamados cuatro tornillos Lorentz consistentes en una rotación circular e hiperbólica alrededor del mismo eje, o en otras palabras: una rotación alrededor de un eje, y un impulso a lo largo del mismo eje.

¿Qué pasa con la transformación de Lorentz inducida por una matriz no axial? La naturaleza de estas transformaciones es muy diferente del caso común, y constituye una situación limitante inusual. Está justificado llamarlo una transformación excepcional de Lorentz. El estatus especial de estas transformaciones fue reconocido por Wigner en su trabajo fundamental sobre las representaciones del grupo Lorentz.

El enfoque actual es mucho más elemental que el de Wigner, tanto desde el punto de vista de la técnica matemática, como también el propósito en mente. Wigner utiliza la técnica algebraica estándar de divisores elementales para establecer la forma canónica Jordan de matrices. Utilizamos, en cambio, una técnica especializada adaptada a la situación muy sencilla en el álgebra de Pauli. Más importante aún, Wigner se preocupó por el problema de las representaciones del grupo no homogéneo de Lorentz, mientras que consideramos el problema mucho más simple de la propia estructura del grupo, principalmente en vista de su aplicación a la teoría electromagnética.

El significado intuitivo de las transformaciones excepcionales se reconoce mejor a partir de la forma polar de la matriz generadora. Esto se puede llevar a cabo mediante la aplicación directa del método discutido al final de la última sección. Sin embargo, es más instructivo expresar la solución en términos de trigonometría (circular e hiperbólica).

Pedimos las condiciones que deben satisfacer los factores polares para que la relación

\[\begin{array}{c} {1+\hat{a} \cdot \vec{\sigma} = H(\hat{h}, \frac{\mu}{2})U(\hat{u}, \frac{\phi}{2})} \end{array}\]

debe aguantar con\(\mu \ne 0, \phi \ne 0\). Dado que todas las matrices son unimodulares, basta con considerar la igualdad de las huellas:

\[\begin{array}{c} {\frac{1}{2} TrA = \cosh (\frac{\mu}{2}) \cos (\frac{\phi}{2})-i \sinh( \frac{\mu}{2}) \sin (\frac{\phi}{2}) \hat{h} \cdot \hat{u} = 1} \end{array}\]

Esta condición se cumple si y solo si

\[\begin{array}{c} {\hat{h} \cdot \hat{u} = 0} \end{array}\]

y

\[\begin{array}{c} {\cosh (\frac{\mu}{2}) \cos (\frac{\phi}{2}) = 1} \end{array}\]

Los ejes de rotación circular e hiperbólica son así perpendiculares, entre sí y los ángulos de estas rotaciones están relacionados de una manera única: la mitad del ángulo circular es la llamada función manniana de Guder de la mitad del ángulo hiperbólico

\[\begin{array}{c} {\frac{\phi}{2} = gd(\frac{\mu}{2})} \end{array}\]

Sin embargo, si\(\mu\) y\(\phi\) son infinitesimales, obtenemos

\[\begin{array}{c} {(1+\frac{\mu^2}{2}+\cdots)(1+\frac{\phi^2}{2}+\cdots) = 1, i.e.} \end{array}\]

\[\begin{array}{c} {\mu^2-\phi^2 = 0} \end{array}\]

Notamos finalmente que los productos de matrices excepcionales no necesitan ser excepcionales, de ahí que las transformaciones excepcionales de Lorentz no formen un grupo.

A pesar de su carácter especial, las matrices excepcionales tienen interesantes aplicaciones físicas, tanto en relación con el campo electromagnético como se discute en la Sección 4, como también para la construcción de representaciones del grupo inhomogeico Lorentz [Pae69, Wig39].

Concluimos señalando que las formas canónicas del Cuadro 3.2 se prestan para expresar los poderes\(A_{0}^{k}\) en forma simple.

Para la matriz axial singular tenemos

\[\begin{array}{c} {A_{0}^{2} = A} \end{array}\]

Estas matrices de proyección se denominan idempotentes. Las matrices singulares no axiales son nilpotentes:

\[\begin{array}{c} {A_{0}^{2} = 0} \end{array}\]

Las matrices excepcionales (unimodulares no axiales) se elevan a cualquier potencia k (incluso no real) por la fórmula

\[\begin{array}{c} {A^{k} = 1^{k}(1+k \vec{a} \cdot \vec{\sigma})} \end{array}\]

\[\begin{array}{c} {= 1^{k} \exp (k \vec{a} \cdot \vec{\sigma})} \end{array}\]

Para el entero k, el factor\(1^k\) se convierte en unidad. El caso unimodular axial es manejado por fórmulas que son generalizaciones de las conocidas fórmulas de Moivre:

\[\begin{array}{c} {A^{k} = 1^k \exp (k \frac{\kappa}{2} + kl2 \pi i)} \end{array} \label{EQ3.4.130}\]

donde l es un entero. Para el entero k, la ecuación\ ref {EQ3.4.130} se reduce a

\[\begin{array}{c} {A^k = \exp(k(\frac{\kappa}{2}) \vec{a} \cdot \vec{\sigma})} \end{array}\]

En relación con estas fórmulas, observamos que para A positiva (\(\phi = 0\)y una real), hay una raíz mth positiva única de A:

\[\begin{array}{c} {A = \exp \{(\frac{\mu}{2}) \hat{a} \cdot \vec{\sigma}\}} \end{array}\]

\[\begin{array}{c} {A^{1/m} = \exp \{(\frac{\mu}{2m}) \hat{a} \cdot \vec{\sigma}\}} \end{array}\]

Los resultados anteriores se resumen en la Tabla 2.2.

Cuadro 2.2: Formas canónicas para las clases de Simlarity de\(\mathcal{A}_{2}\).