4.8: ¿Qué representan las actividades de las unidades de producción?

- Page ID

- 143847

Cuando McCulloch y Pitts (1943) formalizaron el procesamiento de la información de las neuronas, lo hicieron explotando la ley de todo o ninguno. Como resultado, si una neurona respondió podría interpretarse como la asignación de un valor “verdadero” o “falso” a alguna proposición calculada sobre los resultados de la neurona. McCulloch y Pitts fueron capaces de diseñar neuronas artificiales capaces de actuar como 14 de las 16 posibles funciones primitivas sobre la lógica de dos valores descrita en el Capítulo 2.

McCulloch y Pitts (1943) formalizaron la ley de todo o ninguno usando la ecuación escalonada Heaviside como función de activación para sus neuronas artificiales. Las funciones modernas de activación como la ecuación logística proporcionan una aproximación continua de la función de paso. También es bastante común interpretar la función logística en términos digitales de función escalonada. Esto se hace interpretando una unidad moderna como “encendida” o “apagada” si su actividad es suficientemente extrema. Por ejemplo, en simulaciones realizadas con mi software de laboratorio (Dawson, 2005) es típico ver una unidad como “encendida” si su actividad es 0.9 o superior, o “off” si su actividad es 0.1 o menor.

Las funciones de activación digital, o interpretaciones digitales de funciones de activación continua, significan que el reconocimiento de patrones es una tarea primordial para las redes neuronales artificiales (Pao, 1989; Ripley, 1996). Cuando una red realiza reconocimiento de patrones, se entrena para generar una respuesta digital o binaria a un patrón de entrada, donde esta respuesta se interpreta como que representa una clase a la que el patrón de entrada está asignado de manera inequívoca.

¿Qué significa la actividad de una unidad en una red de conexionistas? Bajo la estricta interpretación digital descrita anteriormente, la actividad se interpreta como el valor de verdad de alguna proposición representada por la unidad. Sin embargo, las funciones modernas de activación como las ecuaciones logísticas o gaussianas tienen valores continuos, que permiten tipos de interpretación más flexibles. La actividad continua podría modelar la frecuencia con la que una unidad real (es decir, una neurona) genera potenciales de acción. Podría representar un grado de confianza al afirmar que una característica detectada está presente, o podría representar la cantidad de una característica que está presente (Waskan & Bechtel, 1997).

En esta sección se utiliza un análisis a nivel computacional para demostrar que, en el contexto de la teoría moderna del aprendizaje, la actividad unitaria continua puede interpretarse sin ambigüedades como una medida candidata del grado de confianza con probabilidad condicional (Waskan & Bechtel, 1997).

En la psicología experimental, algunas teorías de aprendizaje están motivadas por la naturaleza ambigua o ruidosa del mundo. Las señales en el mundo real no señalan los resultados con total certeza (Dewey, 1929). Se ha argumentado que los sistemas adaptativos abordan la incertidumbre mundana al convertirse en “estadísticos intuitivos”, ya sean humanos (Peterson & Beach, 1967) o animales (Gallistel, 1990; Shanks, 1995). Un agente que se comporta como un estadístico intuitivo detecta contingencia en el mundo, porque las señales señalan la probabilidad (y no la certeza) de que ocurran ciertos eventos (como ser recompensado) (Rescorla, 1967, 1968).

La evidencia indica que una variedad de organismos son estadísticos intuitivos. Por ejemplo, la ley de emparejamiento es un formalismo matemático que originalmente se utilizó para explicar variaciones en la frecuencia de respuesta. Afirma que la tasa de respuesta refleja la tasa de su refuerzo obtenido. Por ejemplo, si la respuesta A se refuerza dos veces más frecuentemente que la respuesta B, entonces A aparecerá dos veces más frecuentemente que B (Herrnstein, 1961). La ley de emparejamiento también predice cómo la fuerza de respuesta varía con la frecuencia de refuerzo (de Villiers & Herrnstein, 1976). Muchos resultados muestran que la ley de emparejamiento rige numerosas tareas en psicología y economía (Davison & McCarthy, 1988; de Villiers, 1977; Herrnstein, 1997).

Otro fenómeno que está formalmente relacionado (Herrnstein & Loveland, 1975) con la ley de emparejamiento es el emparejamiento de probabilidad, que se refiere a elecciones hechas por agentes frente a alternativas competidoras. Bajo el emparejamiento de probabilidad, la probabilidad de que un agente elija entre diferentes alternativas refleja la probabilidad asociada con el resultado o recompensa de esa elección (Vulkan, 2000). La coincidencia de probabilidad se ha demostrado en una variedad de organismos, incluyendo insectos (Fischer, Couvillon, &Bitterman, 1993; Keasar et al., 2002; Longo, 1964; Niv et al., 2002), peces (Behrend & Bitterman, 1961), tortugas (Kirk&Bitterman, 1965), palomas (Graf, Bullock, & Bitterman, 1964), y humanos (Estes&Straughan, 1954).

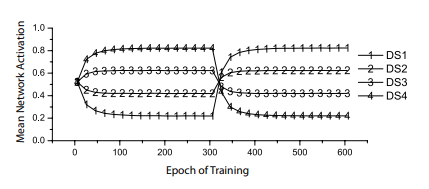

Los perceptrones también pueden coincidir con las probabilidades (Dawson et al., 2009). Dawson et al. utilizaron cuatro señales diferentes, o estímulos discriminativos (DSs), pero no los “recompensaron” al 100 por ciento del tiempo. En cambio, premiaron a un DS el 20 por ciento del tiempo, otro 40 por ciento, un tercio 60 por ciento y un cuarto 80 por ciento. Después de 300 épocas, donde cada época implicaba presentar cada cue solo 10 veces diferentes en orden aleatorio, estas contingencias fueron invertidas (es decir, restadas de 100). La medida dependiente fue la actividad perceptrónica cuando se presentó una señal; la función de activación empleada fue la logística. Algunos resultados de este experimento se presentan en la Figura 4-6. Muestra que después de un pequeño número de épocas, la actividad de la unidad de salida se vuelve igual a la probabilidad de que una señal presentada fuera recompensada. También muestra que las respuestas de perceptrones se reajustan rápidamente cuando las contingencias se modifican repentinamente, como lo demuestra el cambio en la Figura 4-6 alrededor de la época 300. En resumen, los perceptrones son capaces de igualar probabilidades.

Figura 4-6. Coincidencia de probabilidad por perceptrones. Cada línea muestra la activación del perceptrón cuando se presenta una señal diferente (o estímulo discriminativo, DS). Los niveles de actividad se vuelven rápidamente iguales a la probabilidad de que cada señal se refuerce (Dawson et al., 2009).

Que los perceptrones coincidan con las probabilidades los relaciona con la teoría de contingencia. Declaraciones formales de esta teoría formalizan la contingencia como contraste entre probabilidades condicionales (Allan, 1980; Cheng, 1997; Cheng & Holyoak, 1995; Cheng & Novick, 1990, 1992; Rescorla, 1967, 1968).

Por ejemplo, considere la situación simple en la que se puede presentar una señal, C, o no, ~C. Asociado a cualquiera de estos estados está un resultado (por ejemplo, una recompensa) que puede ocurrir, O, o no, ~O. En esta situación simple, involucrando una sola señal y un solo resultado, la contingencia entre la señal y el resultado se define formalmente como la diferencia en las probabilidades condicionales, ΔP, donde ΔP = P (O|C) — P (O|~C) (Allan, 1980). Modelos más sofisticados, como el modelo de contraste probabilístico (e.g., Cheng & Novick, 1990) o la teoría de la PC de potencia (Cheng, 1997), Época de Entrenamiento Media Activación de Red definen contrastes probabilísticos más complejos que son posibles cuando ocurren múltiples señales y pueden verse afectados por el contexto en el que se presentan.

Empíricamente, la coincidencia de probabilidad de perceptrones, ilustrada en la Figura 4-6, sugiere que su comportamiento puede representar ΔP. Cuando se presenta una señal, la actividad es igual a la probabilidad de que la señal señale refuerzo, es decir, P (O|C). Esto implica que la diferencia entre la actividad de un perceptrón cuando se presenta una señal y su actividad cuando una señal está ausente debe ser igual a ΔP. Pasemos ahora a un análisis computacional para probar esta afirmación.

¿Cuál es la relación formal entre las teorías formales de contingencia y las teorías del aprendizaje asociativo (Shanks, 2007)? Los investigadores han comparado las predicciones de un relato influyente del aprendizaje asociativo, el modelo Rescorla-Wagner (Rescorla & Wagner, 1972), con teorías formales de contingencia (Chapman & Robbins, 1990; Cheng, 1997; Cheng y Holyoak, 1995). Se ha demostrado que si bien en algunas instancias el modelo Rescorla-Wagner predice los contrastes condicionales definidos por una teoría formal de contingencia, en otras situaciones no logra generar estas predicciones (Cheng, 1997).

Las comparaciones entre el aprendizaje de contingencia y el aprendizaje de Rescorla-Wagner generalmente implican determinar los equilibrios del modelo de Rescorla-Wagner. Un equilibrio del modelo Rescorla-Wagner es un conjunto de fortalezas asociativas definidas por el modelo, en el punto en el que la asíntota de cambios en el error definida por el aprendizaje RescorlaWagner se acerca a cero (Danks, 2003). En el caso simple descrito anteriormente, que involucra una sola señal y un solo resultado, el modelo Rescorla-Wagner es idéntico a la teoría de contingencia. Esto se debe a que en el equilibrio, la fuerza asociativa entre la señal y el resultado es exactamente igual a ΔP (Chapman & Robbins, 1990).

También existe una relación formal establecida entre el modelo Rescorla-Wagner y el aprendizaje de la regla delta de un perceptrón (Dawson, 2008; Gluck & Bower, 1988; Sutton & Barto, 1981). Así, al examinar el estado de equilibrio de un perceptrón que enfrenta un simple problema de contingencia, podemos relacionar formalmente este tipo de red con la teoría de contingencia y llegar a una comprensión formal de lo que representa la actividad de la unidad de salida.

Cuando se usa una función de activación continua en un perceptrón, se puede usar cálculo para determinar el equilibrio del perceptrón. Hagámoslo para una situación de una sola señal en la que alguna señal, C, cuando se presenta, es recompensada una frecuencia de a veces, y no es recompensada una frecuencia de b veces. De igual manera, cuando no se presenta la señal, el perceptrón se recompensa una frecuencia de c veces y no se recompensa una frecuencia de d veces. Obsérvese que recompensar un perceptrón es entrenarlo para generar una respuesta deseada de 1, y que no recompensar un perceptrón es entrenarlo para generar una respuesta deseada de 0, porque la respuesta deseada indica la presencia o ausencia del estímulo no condicionado (Dawson, 2008).

Supongamos que cuando la señal está presente, la función de activación logística calcula un valor de activación que designamos como oc, y que cuando la señal está ausente devuelve el valor de activación designado como o~c. Ahora podemos definir el error total de respuesta para el perceptrón, es decir, su error total para el (a + b + c + d) número de patrones que representan una sola época, en la que cada instancia del problema de contingencia se presenta una vez. Por ejemplo, en un ensayo en el que se presenta C y se refuerza el perceptrón, el error del perceptrón para ese ensayo es la diferencia cuadrada entre la recompensa, 1, y o c. Al existir uno de estos ensayos, la contribución total de este tipo de ensayo al error general es a (1 — o c) 2. Aplicando esta lógica a los otros tres emparejamientos de cue y result, el error total E se puede definir de la siguiente manera:

E = a (1-o c) 2 + b (0-o c) 2 + c (1-o ~c) 2 + d (0-o ~c) 2

= a (1-o c) 2 + b (o c) 2 + c (1-o ~c) 2 + d (o ~c) 2

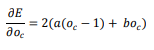

Para que un perceptrón esté en equilibrio, debe haber alcanzado un estado en el que se haya optimizado el error total, de manera que el error ya no se pueda disminuir utilizando la regla delta para alterar el peso del perceptrón. Para determinar el equilibrio del perceptrón para el problema de contingencia de una sola señal, comenzamos tomando la derivada de la ecuación de error con respecto a la actividad del perceptrón cuando la señal está presente, o c:

Una condición del perceptrón en equilibrio es que oc es un valor que hace que esta derivada sea igual a 0. La siguiente ecuación establece la derivada en 0 y resuelve para oc. El resultado es a/ (a + b), que es igual a la probabilidad condicional P (O|C) si el experimento de una sola señal se representa con una tabla de contingencia tradicional:

Del mismo modo, podemos tomar la derivada de la ecuación de error con respecto a la actividad del perceptrón cuando la señal no está presente, o~c: () () () () () () () () () ()) () () ()) Elementos de la Ciencia Cognitiva Conneccionista 157 Una segunda condición del perceptrón en equilibrio es que o~c es un valor que hace que la derivada anterior sea igual a 0. Como antes, podemos establecer la derivada en 0 y resolver para el valor de o~c. esta vez el resultado es c/ (c + d), que en una tabla de contingencia tradicional es igual a la probabilidad condicional P (O|~C): La implicación principal de las ecuaciones anteriores es que muestran que la actividad de perceptrón es literalmente un condicional probabilidad. Esto proporciona una prueba computacional para la hipótesis empírica sobre la actividad perceptrónica que se generó a partir del examen de la Figura 4-6. Una segunda implicación de la prueba es que ante el mismo problema de contingencia, el equilibrio de un perceptrón no es el mismo que el del modelo Rescorla-Wagner. En equilibrio, la fuerza asociativa para la cue C que está determinada por el entrenamiento de Rescorla-Wagner es literalmente ΔP (Chapman & Robbins, 1990). Este no es el caso del perceptrón. Para el perceptrón, ΔP debe calcularse tomando la diferencia entre su salida cuando la señal está presente y su salida cuando la señal está ausente. Es decir, ΔP no se representa directamente como un peso de conexión, sino que es la diferencia entre los comportamientos de perceptrón en diferentes situaciones de cue, es decir, la diferencia entre la probabilidad condicional generada por el perceptrón cuando está presente una señal y la salida de probabilidad condicional por el perceptron cuando la señal está ausente. Es importante destacar que a pesar de que el perceptrón y el modelo Rescorla-Wagner logran diferentes equilibrios para un mismo problema, es claro que ambos son sensibles a la contingencia cuando se define formalmente como ΔP. Las diferencias entre ambos reflejan un tema que se planteó en el Capítulo 2, que existen muchos algoritmos diferentes posibles para computar la misma función. Diferencias clave entre el perceptrón y el modelo Rescorla-Wagner —en particular, el hecho de que el primero realice una transformación no lineal sobre las señales internas, mientras que el segundo no— provoca que adopten estructuras muy diferentes, como lo indican diferentes equilibrios. Sin embargo, estos sistemas muy diferentes son igualmente sensibles a exactamente la misma contingencia. Esta última observación tiene implicaciones para el debate entre la teoría de contingencia y el aprendizaje asociativo (Cheng, 1997; Cheng & Holyoak, 1995; Shanks, 2007). En (()) () () (|) 158 Capítulo 4 la fase actual de este debate, se han propuesto teorías modernas de contingencia como alternativas al aprendizaje de Rescorla-Wagner. Mientras que en algunos casos los equilibrios para el modelo Rescorla-Wagner predicen los contrastes condicionales definidos por una teoría formal de contingencia como el modelo de PC de potencia, en otras situaciones este no es el caso (Cheng, 1997). Sin embargo, el resultado anterior indica que las diferencias en los equilibrios no necesariamente reflejan diferencias en las habilidades del sistema. Claramente, las diferencias de equilibrio no pueden utilizarse como única medida cuando se comparan diferentes teorías de contingencia.