3.13: Hacia una fuerte equivalencia

- Page ID

- 143771

La prueba de Turing ha tenido una larga e influyente historia (francés, 2000). No obstante, muchos estarían de acuerdo en que es defectuoso, tal vez porque se pasa con demasiada facilidad. Como consecuencia, algunos han argumentado que la investigación en inteligencia artificial es muy limitada (Weizenbaum, 1976). Otros han argumentado a favor de versiones más estrictas de la prueba de Turing, como la Prueba de Turing Total.

La ciencia cognitiva clásica reconoce que la prueba de Turing proporciona una medida necesaria, pero no suficiente, de la validez de un modelo. Esto se debe a que en realidad solo establece una equivalencia débil, al recolectar evidencia de que dos sistemas son computacionalmente equivalentes. Esto lo logra examinando únicamente los dos dispositivos a nivel de la relación entrada-salida. Esto sólo puede establecer una equivalencia débil, porque los sistemas que utilizan algoritmos y arquitecturas muy diferentes aún pueden calcular la misma función.

La ciencia cognitiva clásica tiene el objetivo de ir más allá de la equivalencia débil. Intenta hacerlo estableciendo relaciones adicionales entre modelos y sujetos, identidades entre algoritmos y arquitecturas. Esto es un intento de establecer lo que se conoce como fuerte equivalencia (Pylyshyn, 1984). Se dice que dos sistemas son fuertemente equivalentes si computan la misma función de entrada-salida (es decir, 98 Capítulo 3 si son débilmente equivalentes), logran esto con el mismo algoritmo y dan vida a este algoritmo con la misma arquitectura. Los científicos cognitivos están en el negocio de realizar observaciones que establezcan la fuerte equivalencia de sus modelos con los pensadores humanos.

La ciencia cognitiva clásica recopila estas observaciones midiendo comportamientos particulares que son consecuencias no deseadas del procesamiento de la información, y que por lo tanto pueden revelar la naturaleza del algoritmo que se está empleando. Newell y Simon (1972) nombraron estos comportamientos efectos de segundo orden; en el Capítulo 2 estos comportamientos se llamaron artefactos, para distinguirlos de las respuestas primarias o previstas de un procesador de información. En el Capítulo 2, discutí tres clases generales de evidencia relacionadas con el comportamiento artefacto: evidencia de estado intermedio, evidencia de complejidad relativa y evidencia de error.

Tenga en cuenta que aunque similar en espíritu, el uso de estos tres tipos diferentes de evidencia para determinar la relación entre los algoritmos utilizados por modelo y sujeto no es lo mismo que algo así como la Prueba de Turing Total. La ciencia cognitiva clásica no requiere correspondencia física entre modelo y sujeto. Sin embargo, las correspondencias algorítmicas establecidas al examinar artefactos de comportamiento ponen restricciones mucho más fuertes en la validación de la teoría que simplemente buscar correspondencias de estímulo-respuesta. Para ilustrar esto, consideremos algunos ejemplos de cómo la evidencia de estado intermedio, la evidencia de complejidad relativa y la evidencia de error pueden usarse para validar modelos.

Una fuente importante de información que puede ser utilizada para validar un modelo es la evidencia intermedia del estado (Pylyshyn, 1984). La evidencia estatal intermedia implica determinar los pasos intermedios que un manipulador de símbolos toma para resolver un problema, y luego recolectar evidencia para determinar si un sujeto modelado pasa por los mismos pasos intermedios. La evidencia de estado intermedio es notoriamente difícil de recopilar, porque los procesadores de información humanos son cajas negras; no podemos observar directamente el procesamiento cognitivo interno. Sin embargo, se pueden desarrollar paradigmas experimentales inteligentes para permitir inferir estados intermedios.

Un famoso ejemplo de evaluación de un modelo usando evidencia de estado intermedio se encuentra en algunas investigaciones clásicas y pioneras sobre la resolución de problemas humanos (Newell & Simon, 1972). Newell y Simon recolectaron datos de sujetos humanos a medida que resolvían problemas; su método de recolección de datos se conoce como análisis de protocolo (Ericsson & Simon, 1984). En el análisis de protocolo, se capacita a los sujetos para pensar en voz alta mientras trabajan. Un registro de lo que dice el sujeto se convierte en el dato primario de interés.

La lógica de recopilar protocolos verbales es que los procesos de pensamiento involucrados en la resolución activa de problemas probablemente se almacenen en la memoria a corto plazo de una persona (STM), o memoria de trabajo. Los psicólogos cognitivos han establecido que los elementos almacenados en dicha memoria se almacenan como un código articulatorio que permite la verbalización para mantener los elementos en la memoria (Baddeley, 1986, 1990; Conrad, 1964a, 1964b; Waugh & Norman, 1965). Como resultado, se presume que pedir a los sujetos que verbalicen sus pasos de pensamiento brinda acceso preciso al procesamiento cognitivo actual, y hacerlo con una interrupción mínima. “La verbalización no interferirá con los procesos en curso si la información almacenada en STM se codifica oralmente, de manera que se pueda activar fácilmente un código articulatorio”” (Ericsson & Simon, 1984, p. 68).

Para estudiar la resolución de problemas, Newell y Simon (1972) recolectaron protocolos verbales para problemas que eran lo suficientemente difíciles de involucrar a los sujetos y generar comportamientos interesantes, pero lo suficientemente simples como para ser resueltos. Por ejemplo, cuando se le pidió a un sujeto que decodificara el problema criptaritmético DONALD + GERALD = ROBERT después de que le dijeran que D = 5, resolvieron el problema en veinte minutos y produjeron un protocolo que tenía 2,186 palabras de longitud.

El siguiente paso en el estudio fue crear una gráfica de comportamiento problemático a partir del protocolo de un sujeto. Un gráfico de comportamiento de problemas es una red de nodos enlazados. Cada nodo representa un estado de conocimiento. Por ejemplo, en el problema criptaritmético tal estado podría ser la observación de que “R es impar”. Un enlace horizontal de un nodo a un nodo de su derecha representa la aplicación de una operación que cambió el estado del conocimiento. Una operación de ejemplo podría ser “Encontrar una columna que contenga una carta de interés y procese esa columna”. Un enlace vertical de un nodo a un nodo de abajo representa el retroceso. En muchos casos, un sujeto llegaría a un callejón sin salida en una línea de pensamiento y regresaría a un estado previo de conocimiento para explorar un enfoque diferente. El protocolo de 2,186 palabras produjo una gráfica de comportamiento de problemas que consistió en 238 nodos diferentes.

El nodo inicial en una gráfica de comportamiento problemático representa el estado inicial de conocimiento de un sujeto cuando se le da un problema. Un nodo cercano al final de la gráfica de comportamiento del problema representa el estado del conocimiento cuando se ha logrado una solución. Todos los demás nodos representan estados intermedios de conocimiento. Además, en la investigación de Newell y Simon (1972), estos estados intermedios representan elementos muy detallados de conocimiento sobre el problema a medida que se está resolviendo.

El objetivo del componente de simulación de la investigación de Newell y Simon (1972) era crear un modelo de computadora que generara su propio gráfico de comportamiento problemático. El modelo pretendía producir una mímica muy detallada del comportamiento del sujeto, se validó examinando el grado en que la gráfica de comportamiento de problemas de la simulación coincidía con la gráfica creada para el sujeto. La naturaleza meticulosa de dicha evidencia estatal intermedia proporcionó confianza adicional para el uso de protocolos verbales como datos científicos. “Para que cuanta más información se transmita en sus respuestas, más difícil se vuelve construir un modelo que produzca precisamente esas respuestas adventiciamente, de ahí que más confianza podamos poner en un modelo que sí las predice” (Ericsson & Simon, 1984, p. 7).

Newell y Simon (1972) crearon una simulación por computadora examinando el gráfico de comportamiento problemático de un sujeto, identificando los procesos básicos que reveló en sus vínculos entre nodos y codificando cada uno de estos procesos como una producción en un sistema de producción. Su modelo desarrollado a partir del protocolo para el problema DONALD + GERALD = ROBERT consistió en sólo 14 producciones. El comportamiento de este programa bastante pequeño pudo dar cuenta del 75 al 80 por ciento de la gráfica de comportamiento problemático del sujeto humano. “Todo este análisis muestra cómo un protocolo de pensamiento verbal en voz alta puede ser utilizado como materia prima para generar y probar una teoría del comportamiento de resolución de problemas” (Newell & Simon, 1972, p. 227).

Es imposible exagerar la contribución de la investigación de Newell y Simon (1972) a la ciencia cognitiva clásica. Uno de sus aportes centrales fue demostrar que la resolución de problemas humanos podría caracterizarse como buscar a través de un espacio problemático. Un espacio problemático consiste en un conjunto de estados de conocimiento —estado inicial, uno o más estados meta y un número potencialmente grande de estados intermedios— que representan cada uno conocimiento actual sobre un problema. Un vínculo entre dos estados del conocimiento muestra cómo la aplicación de una sola regla puede transformar el primer estado en el segundo. Un gráfico de comportamiento problemático es un ejemplo de un espacio problemático. Buscar en el espacio problemático implica encontrar una ruta, una secuencia de operaciones, que transformará el estado inicial en un estado objetivo. Desde esta perspectiva, la resolución de problemas se convierte en el dominio del control: encontrar de la manera más eficiente posible una secuencia aceptable de operaciones de resolución de problemas. Existe una enorme cantidad de estrategias de búsqueda diferentes (Knuth, 1997; Nilsson, 1980); establecer la fuerte equivalencia de un modelo de resolución de problemas requiere recolectar evidencia (por ejemplo, usando análisis de protocolo) para asegurar que la misma estrategia de búsqueda o control sea utilizada tanto por el modelo como por el agente.

Un segundo tipo de evidencia que se utiliza para investigar la validez de un modelo es la evidencia de complejidad relativa (Pylyshyn, 1984). La evidencia de complejidad relativa generalmente implica examinar la dificultad relativa de los problemas, para ver si los problemas que son difíciles (o fáciles) para un modelo son los mismos problemas que son difíciles (o fáciles) para un sujeto modelado. El tipo más común de evidencia de complejidad relativa recopilada por los científicos cognitivos es la latencia de respuesta (Luce, 1986; Posner, 1978). Se supone que el tiempo que tarda un sistema en generar una respuesta es un comportamiento artefactual que puede revelar propiedades de un algoritmo subyacente y ser utilizado para examinar la relación algorítmica entre modelo y sujeto.

Un dominio en el que las medidas de latencia de respuesta han jugado un papel importante es el estudio de la cognición visual (Kosslyn & Osherson, 1995; Pinker, 1985). La cognición visual implica resolver problemas de procesamiento de información que involucran relaciones espaciales o el diseño espacial de la información. Es un rico dominio de estudio porque parece involucrar tipos cualitativamente diferentes de procesamiento de información: la detección de características visuales basada en datos o preatenta (Marr, 1976; Richards, 1988; Treisman, 1985), la cognición de arriba hacia abajo o de alto nivel para vincular combinaciones de características visuales a semánticas interpretaciones o etiquetas (Jackendoff, 1983, 1987; Treisman, 1986, 1988), y procesamiento que implica atención visual o rutinas visuales que incluyen características tanto impulsadas por datos como de arriba hacia abajo, y que sirven como intermediario entre la detección de características y el reconocimiento de objetos (Cooper & Shepard, 1973a, 1973b ; Ullman, 1984; Wright, 1998).

Las tareas de búsqueda visual se utilizan con frecuencia para estudiar la cognición visual. En tal tarea, a un sujeto se le suele presentar una visualización que consiste en una serie de objetos. En la versión de hombre-impar de esta tarea, en la mitad de las pruebas uno de los objetos (el objetivo) es diferente de todos los demás objetos (los distractores). En la otra mitad de las pruebas, los únicos objetos presentes son los distractores. Los sujetos tienen que decidir con la mayor rapidez y precisión posible si un objetivo está presente en cada pantalla. Las medidas dependientes en tales tareas son las funciones de latencia de búsqueda, que representan el tiempo requerido para detectar la presencia o ausencia de un objetivo en función del número total de elementos de visualización.

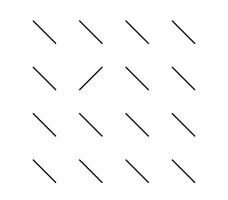

Un trabajo pionero en búsqueda visual descubrió el llamado efecto pop-out: el tiempo requerido para detectar la presencia de un objetivo que se caracteriza por uno de un pequeño número de características únicas (por ejemplo, color, orientación, contraste, movimiento) es en gran medida independiente del número de elementos distractores en una pantalla, produciendo una función de latencia de búsqueda que es esencialmente plana (Treisman & Gelade, 1980). Esto se debe a que, independientemente del número de elementos en la pantalla, cuando el objetivo está presente parece salir de la pantalla, llamándose inmediatamente la atención. Observe cómo el objetivo sale de la pantalla ilustrada en la Figura 3-11.

Figura 3-11. Las características únicas salen de las pantallas, independientemente del tamaño de la pantalla.

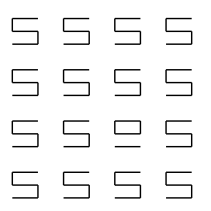

En contraste, el tiempo para detectar un objetivo definido por una combinación única de características generalmente aumenta con el número de elementos distractores, produciendo funciones de latencia de búsqueda con pendientes positivas. La Figura 3-12 ilustra la búsqueda visual en objetos que están conectados o no conectados (Dawson & Thibodeau, 1998); conectividad 102 Capítulo 3 es una propiedad que no es local, sino que solo se define por las relaciones entre múltiples características (Minsky & Papert, 1988). Cuanto mayor sea el número de elementos de visualización, más tiempo tardará en encontrar el objetivo cuando está presente en la pantalla. ¿Hay un objetivo en la Figura 3-12? Si es así, ¿es más difícil encontrar que el que estuvo presente en la Figura 3-11?

Figura 3-12. Las combinaciones únicas de características no aparecen.

Resultados de latencia de búsqueda como los descritos anteriormente, que revelaron que algunos objetos salen pero otros no, formaron la base para la teoría de integración de características (Treisman, 1985, 1986, 1988; Treisman & Gelade, 1980; Treisman & Gormican, 1988; Treisman, Sykes, & Gelade, 1977). La teoría de integración de características es un relato multietapa de la cognición visual. En el primer estado, los procesadores preatentos registran las ubicaciones de un pequeño conjunto de características visuales primitivas en mapas de características independientes. Estos mapas representan un pequeño número de propiedades (por ejemplo, orientación, color, movimiento de contraste) que también parecen ser transducidas por los primeros detectores visuales neuronales (Livingstone & Hubel, 1988). Si dicha entidad es exclusiva de una pantalla, entonces será la única ubicación activa en su mapa de entidades. Esto permite que ocurra el pop out, porque la ubicación de la característica primitiva única está disponible de manera preventiva.

Las combinaciones únicas de entidades no producen actividad única en un solo mapa de entidades y, por lo tanto, no pueden aparecer. En cambio, requieren procesamiento adicional para ser detectados. Primero, los recursos atencionales deben usarse para registrar los diversos mapas de características independientes con respecto a un mapa maestro de ubicaciones. Este mapa maestro de ubicaciones indicará qué combinaciones de entidades coexisten en cada ubicación del mapa. En segundo lugar, se utiliza un “foco” de atención para escanear el mapa maestro de ubicaciones en busca de un objeto único. Debido a que este foco de atención solo puede procesar una parte del mapa maestro en un momento dado, y debido a que debe escanearse de una ubicación a otra en el mapa maestro, lleva más tiempo encontrar combinaciones únicas de entidades. Además, la búsqueda del mapa maestro será cada vez más larga a medida que se llenen más de sus ubicaciones, explicando por qué la latencia para detectar combinaciones de características únicas se ve afectada por el número de distractores presentes.

La evidencia de complejidad relativa también se puede utilizar para explorar algunos de los componentes de la teoría de integración de características. Por ejemplo, varios investigadores han propuesto modelos de cómo se desplaza el foco atencional para detectar objetivos en una tarea de búsqueda visual (Fukushima, 1986; Gerrissen, 1991; Grossberg, 1980; Koch & Ullman, 1985; LaBerge, Carter, & Brown, 1992; Sandon, 1992). Si bien los detalles específicos de estos modelos difieren, su estructura general es bastante similar. En primer lugar, estos modelos representan la visualización que se busca como una matriz de procesadores cuyas actividades codifican la distinción visual de la ubicación que representa cada procesador (es decir, cuán diferente es en apariencia en relación con sus vecinos). En segundo lugar, estos procesadores participan en una competencia de ganador para llevar todo (WTA) (Feldman & Ballard, 1982) para identificar la ubicación más distintiva. Esta competencia se define por la inhibición lateral: cada procesador utiliza su actividad como señal inhibitoria en un intento de reducir la actividad de sus vecinos. En tercer lugar, se examina el elemento de visualización en la ubicación ganadora para ver si es o no el objetivo. Si es así, la búsqueda se detiene. Si no lo es, la actividad en este lugar o decae o se inhibe (Klein, 1988), y se utiliza una nueva competencia WTA para encontrar la siguiente ubicación más distintiva en la exhibición.

Este tipo de modelo proporciona una explicación directa de las funciones de latencia de búsqueda obtenidas para objetivos definidos por conjunciones únicas de características. También conducen a una predicción única: si los procesos inhibitorios son los responsables de dirigir el cambio del foco atencional, entonces las funciones de latencia de búsqueda deberían verse afectadas por la luminancia de adaptación general de la pantalla. Esto se debe a que existe un mayor grado de inhibición durante el procesamiento de pantallas visuales brillantes que en las pantallas con atenuación (Barlow, Fitzhugh, & Kuffler, 1957; Derrington & Lennie, 1982; Ransom-Hogg & Spillmann, 1980; Rohaly & Buchsbaum, 1989).

Se realizó un estudio de búsqueda visual para probar esta predicción (Dawson & Thibodeau, 1998). Modificando un paradigma utilizado para estudiar el efecto de la luminancia adaptativa sobre la percepción del movimiento (Dawson & Di Lollo, 1990), Dawson y Thibodeau (1998) hicieron que los sujetos realizaran una tarea de búsqueda visual mientras veían las pantallas a través de filtros de densidad neutra que modificaban la luminancia de visualización sin afectar a la relativa contraste de elementos. Hubo dos hallazgos principales que apoyaron los tipos de modelos de cambio atencional descritos anteriormente. Primero, cuando los objetivos salen, la latencia de respuesta de los sujetos no se vio afectada por la luminancia adaptativa. Esto es consistente con la teoría de integración de características, en el sentido de que no se requiere un foco atencional cambiante para que ocurra el pop out. Segundo, para los objetivos que no salieron, las funciones de latencia de búsqueda se vieron afectadas por el nivel de luminancia adaptativa. Para pantallas más oscuras, tanto la intercepción como la pendiente de las funciones de latencia de búsqueda aumentaron significativamente. Esto concuerda con la hipótesis de que esta manipulación interfiere con los procesos inhibitorios que guían los cambios de atención.

Un tercer enfoque para validar un modelo implica el uso de evidencia de error. Este enfoque asume que los errores son artefactos, en el sentido de que son una consecuencia natural del procesamiento de la información de un agente, y que no son un producto deliberado o previsto de este procesamiento.

Una fuente de errores artificiales es la forma en que el procesamiento de la información puede verse limitado por los límites de los recursos internos (memoria o atención) o por demandas externas (la necesidad de respuestas en tiempo real). Estas restricciones al procesamiento producen una racionalidad limitada (Simon, 1982). Otra razón para los errores de artefacto radica en las restricciones impuestas por el particular emparejamiento estructura-proceso empleado por un procesador de información. “Una herramienta también gana su poder por el hecho de que permite ciertas acciones y no otras. Por ejemplo, un martillo tiene que ser rígido. Por lo tanto, no se puede usar como cuerda” (Weizenbaum, 1976, p. 37). Al igual que una herramienta, un emparejamiento estructura-proceso particular puede no ser adecuado para algunas tareas y, por lo tanto, produce errores cuando se enfrentan a ellas.

Un ejemplo de la importancia de la evidencia de error se encuentra en la gran literatura sobre navegación humana, animal y robot (Cheng, 2005; Cheng & Newcombe, 2005; Healy, 1998; Jonsson, 2002; Milford, 2008). ¿Cómo encuentran los organismos su lugar en el mundo? Un enfoque para responder a esta pregunta es configurar entornos interiores pequeños y manejables. Estas “arenas” pueden proporcionar una variedad de señales a los animales que aprenden a navegar dentro de ellos. Si un agente es reforzado para visitar un lugar en particular, ¿qué señales utiliza para regresar a este lugar?

Un paradigma para abordar esta cuestión es la tarea de reorientación inventada por Ken Cheng (1986). En la tarea de reorientación, un agente normalmente se coloca dentro de una arena rectangular. El refuerzo se proporciona típicamente en una de las ubicaciones de esquina en la arena. Es decir, el agente es libre de explorar la arena y, finalmente, encuentra una recompensa en un lugar de interés; se entera de que esta es la “ubicación del objetivo”. Luego, el agente es retirado de la arena, desorientado y devuelto a una arena (a menudo diferente), con la tarea de usar las señales disponibles para reubicar la portería. De particular interés son las condiciones experimentales en las que la arena ha sido alterada de aquella en la que originalmente se entrenó al agente.

Una arena que se utiliza en la tarea de reorientación puede proporcionar dos tipos diferentes de información de navegación: señales geométricas y señales de características (Cheng y Newcombe, 2005). Las señales geométricas son relacionales, mientras que las señales de entidad no lo son.

Una propiedad geométrica de una superficie, línea o punto es una propiedad que posee en virtud de su posición con respecto a otras superficies, líneas y puntos dentro del mismo espacio. Una propiedad no geométrica es cualquier propiedad que no pueda describirse solo por la posición relativa. (Gallistel, 1990, p. 212)

En una arena rectangular, las propiedades métricas (por ejemplo, longitudes de pared, ángulos entre paredes) combinadas con la distinción de un agente entre izquierda y derecha (por ejemplo, la pared larga está a la izquierda de la pared corta) proporcionan señales geométricas. También se pueden agregar señales no geométricas o señales de características. Por ejemplo, una pared de arena puede tener un color diferente a las otras (Cheng, 1986), o se pueden colocar diferentes patrones de colores en cada esquina de la arena (Kelly, Spetch, & Heth, 1998).

Una cuestión de interés se refiere a las contribuciones relativas de estas diferentes señales para la reorientación. Esto se estudia al ver cómo el agente reorienta después de que ha sido devuelto a una arena en la que se han alterado las señales. Por ejemplo, es posible que las señales de entidad se hayan movido a nuevas ubicaciones. Esto coloca las señales de características en conflicto con las señales geométricas. ¿El agente se moverá a una ubicación definida por información geométrica, o se moverá a una ubicación diferente indicada por la información de la característica? El uso extensivo de la tarea de reorientación ha revelado algunas regularidades llamativas.

Algunas de las regularidades más interesantes encontradas en la tarea de reorientación se refieren a un error particular en la reorientación. En una arena sin señales de características únicas (sin un color de pared único, sin un patrón único en cada esquina), las señales geométricas son la única información disponible para reorientar. Sin embargo, las señales geométricas no pueden especificar de manera única una ubicación de objetivo en una arena rectangular. Esto se debe a que las señales geométricas en la ubicación de la meta (por ejemplo, ángulo de 90°, pared más corta a la izquierda y pared más larga a la derecha) son idénticas a las señales geométricas presentes en la esquina diagonalmente opuesta (a menudo llamada ubicación rotacional). Bajo estas condiciones, el agente producirá error rotacional (Cheng, 1986, 2005). Cuando ocurre un error rotacional, el agente entrenado va a la ubicación de la meta en niveles por encima del azar; sin embargo, el animal va a la ubicación rotacional con igual frecuencia. El error rotacional generalmente se toma como evidencia de que el agente se basa en las propiedades geométricas del entorno.

Cuando las señales de entidad están presentes en una arena rectangular, se puede especificar una ubicación de objetivo de manera única. De hecho, cuando hay señales presentes, un agente ni siquiera debería tener que prestar atención a las señales geométricas, porque estas señales no son relevantes. Sin embargo, la evidencia sugiere que las señales geométricas aún influyen en el comportamiento incluso cuando no se requieren tales señales para resolver la tarea.

Primero, en algunos casos los sujetos continúan cometiendo algunos errores rotacionales incluso cuando las señales de característica especifican la ubicación de la meta (Cheng, 1986; Hermer & Spelke, 1994). Segundo, cuando las señales de características presentes durante el entrenamiento se eliminan de la arena en la que ocurre la reorientación, los sujetos suelen volver a generar errores rotacionales (Kelly, Spetch y Heth, 1998; Sovrano, Bisazza, & Vallortigara, 2003). En tercer lugar, en estudios en los que las características locales se trasladan a nuevas ubicaciones en la nueva arena, existe un conflicto entre las señales geométricas y las características. En este caso, la reorientación parece verse afectada por ambos tipos de señales. Los animales no solo aumentarán su tendencia a visitar la esquina marcada por las señales de características que previamente señalaban el gol, sino que también producirán error rotacional para otras dos ubicaciones en la arena (Brown, Spetch, & Hurd, 2007; Kelly, Spetch, y Heth, 1998).

El error rotacional es un fenómeno importante en la literatura de reorientación, y se ve afectado por una compleja interacción entre las señales geométricas y características. Una creciente variedad de modelos de reorientación están apareciendo en la literatura, incluyendo modelos consistentes con el fundamental manipulador de símbolos de la ciencia cognitiva clásica (Cheng, 1986; Gallistel, 1990), modelos de redes neuronales que forman parte de la ciencia cognitiva conexionista (Dawson et al., 2010), y robots basados en el comportamiento que son el dominio de la ciencia cognitiva encarnada (Dawson, Dupuis, & Wilson, 2010; Nolfi, 2002). Todos estos modelos tienen dos cosas en común. En primer lugar, pueden producir error rotacional y muchos de sus matices. Segundo, este error se produce como un subproducto natural de un algoritmo de reorientación; los errores producidos por los modelos se utilizan en ayuda de su validación.