9.5: Semántica latente en la Coocurrencia de Palabras

- Page ID

- 123178

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

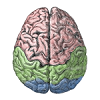

Completando nuestro recorrido más profundo por las principales vías en el modelo triangular de la lectura, ahora pasamos al tema de la semántica. ¿Cuál es la naturaleza de las representaciones semánticas que se muestran en la parte superior de la Figura 9.6? Un creciente cuerpo de datos respalda la idea mostrada en la Figura 9.9, donde el significado de palabras concretas está codificado por patrones de actividad dentro de áreas cerebrales específicas de dominio que procesan información sensorial y motora. Así, la semántica se distribuye a lo largo de una amplia franja del cerebro, y se materializa fundamentalmente y se fundamenta en las primitivas sensorio-motoras que primero adquirimos en la vida. Por lo tanto, el área única de “semántica” que se muestra en el modelo de triángulo es una simplificación importante en relación con la naturaleza real ampliamente distribuida del significado semántico en el cerebro.

Sin embargo, también hay evidencia creciente de que la punta anterior o “polo” del lóbulo temporal juega un papel particularmente importante en la representación de la información semántica, quizás lo más importante para palabras más abstractas que carecen de un fuerte correlato sensorial o motor. Una teoría es que esta área actúa como un “hub” central para coordinar la información semántica distribuida de otro modo (Patterson, Nestor, & Rogers, 2007).

¿Cómo aprendemos los significados de estas palabras más abstractas en primer lugar? A diferencia de las palabras más concretas que se muestran en la Figura 9.9, los significados de palabras más abstractas no pueden ser tan fácilmente empujados a las áreas sensoriales y motoras. Una idea convincente aquí es que las palabras obtienen su significado en parte de la compañía que mantienen: las estadísticas de coocurrencia de palabras a través del gran volumen de entrada verbal a la que estamos expuestos en realidad pueden proporcionar pistas sobre lo que significan las diferentes palabras. Un enfoque exitoso para capturar esta idea en un modelo funcional se llama Análisis Semántico Latente (LSA); consulte http://lsa.colorado.edu para obtener todos los detalles y acceder a este modelo.

LSA funciona registrando las estadísticas de la frecuencia con la que las palabras coocurren entre sí dentro de fragmentos de texto semánticamente relevantes, típicamente párrafos. Sin embargo, estas estadísticas de superficie en sí mismas no son suficientes, porque por ejemplo los sinónimos de palabras ocurren juntos relativamente raramente, en comparación con lo estrechamente relacionados que deberían estar. Y en general, hay mucha variabilidad en la elección de palabras e idiosincrasias de las elecciones de palabras que se reflejan en estas estadísticas detalladas. El paso clave que toma LSA para hacer frente a este problema es aplicar una técnica de reducción de dimensionalidad llamada Descomposición de Valor Singular (SVD), que está estrechamente relacionada con el Análisis de Componentes Principales (PCA), que a su vez está estrechamente relacionado con la autodeterminación hebbiana organizar el aprendizaje que realizan nuestros modelos de redes neuronales.

El resultado clave de este proceso SVD/PCA/Hebbian es extraer las agrupaciones o agrupaciones de palabras más fuertes que coocurren juntas, de una manera que se integre sobre muchos subconjuntos de grupos de palabras parcialmente superpuestos. Así, aunque los sinónimos no tienden a ocurrir entre sí, sí coocurren con muchos de los mismos conjuntos de palabras, y todo este grupo de palabras representa una fuerte agrupación estadística que será sacada por la reducción de dimensionalidad/proceso de aprendizaje autoorganizado hebbio.

Este proceso es exactamente el mismo que vimos con el modelo de campo receptivo V1 en el Capítulo de Percepción. En ese modelo, el aprendizaje hebbio extrajo la regularidad estadística de los bordes orientados a partir de un conjunto de imágenes naturales. Cualquier imagen dada normalmente contiene una versión ruidosa y parcial de un borde orientado, con quizás varios píxeles ocluidos o borrosos o distorsionados de otro modo. Sin embargo, a medida que el proceso de aprendizaje autoorganizado se integra sobre muchos de estos insumos, estas idiosincrasias desaparecen y las agrupaciones estadísticas más fuertes de características emergen como bordes orientados.

Sin embargo, a diferencia del modelo V1, los clústeres estadísticos individuales que emergen del modelo LSA (incluida nuestra versión hebbiana del mismo) no tienen ninguna interpretación clara equivalente a “bordes orientados”. Como verás en la exploración, normalmente puedes darle algún sentido a los pequeños subconjuntos de las palabras, pero no son evidentes elementos de significado general obvios. Pero esto no es un problema —lo que realmente importa es que el patrón general distribuido de actividad a través de la capa semántica capta apropiadamente los significados de las palabras. Y efectivamente este resulta ser el caso.

Exploración

- Semántica abierta para la exploración sem.proj del aprendizaje semántico de co-ocurrencias de palabras. El modelo aquí fue entrenado sobre un borrador temprano de la primera edición de este libro de texto, y así cuenta con conocimientos relativamente especializados, ojalá gran parte de los cuales ahora sea compartida por usted el lector.