8.10: Percepción Multimodal

- Page ID

- 144017

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\dsum}{\displaystyle\sum\limits} \)

\( \newcommand{\dint}{\displaystyle\int\limits} \)

\( \newcommand{\dlim}{\displaystyle\lim\limits} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\(\newcommand{\longvect}{\overrightarrow}\)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\(\newcommand{\avec}{\mathbf a}\) \(\newcommand{\bvec}{\mathbf b}\) \(\newcommand{\cvec}{\mathbf c}\) \(\newcommand{\dvec}{\mathbf d}\) \(\newcommand{\dtil}{\widetilde{\mathbf d}}\) \(\newcommand{\evec}{\mathbf e}\) \(\newcommand{\fvec}{\mathbf f}\) \(\newcommand{\nvec}{\mathbf n}\) \(\newcommand{\pvec}{\mathbf p}\) \(\newcommand{\qvec}{\mathbf q}\) \(\newcommand{\svec}{\mathbf s}\) \(\newcommand{\tvec}{\mathbf t}\) \(\newcommand{\uvec}{\mathbf u}\) \(\newcommand{\vvec}{\mathbf v}\) \(\newcommand{\wvec}{\mathbf w}\) \(\newcommand{\xvec}{\mathbf x}\) \(\newcommand{\yvec}{\mathbf y}\) \(\newcommand{\zvec}{\mathbf z}\) \(\newcommand{\rvec}{\mathbf r}\) \(\newcommand{\mvec}{\mathbf m}\) \(\newcommand{\zerovec}{\mathbf 0}\) \(\newcommand{\onevec}{\mathbf 1}\) \(\newcommand{\real}{\mathbb R}\) \(\newcommand{\twovec}[2]{\left[\begin{array}{r}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\ctwovec}[2]{\left[\begin{array}{c}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\threevec}[3]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\cthreevec}[3]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\fourvec}[4]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\cfourvec}[4]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\fivevec}[5]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\cfivevec}[5]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\mattwo}[4]{\left[\begin{array}{rr}#1 \amp #2 \\ #3 \amp #4 \\ \end{array}\right]}\) \(\newcommand{\laspan}[1]{\text{Span}\{#1\}}\) \(\newcommand{\bcal}{\cal B}\) \(\newcommand{\ccal}{\cal C}\) \(\newcommand{\scal}{\cal S}\) \(\newcommand{\wcal}{\cal W}\) \(\newcommand{\ecal}{\cal E}\) \(\newcommand{\coords}[2]{\left\{#1\right\}_{#2}}\) \(\newcommand{\gray}[1]{\color{gray}{#1}}\) \(\newcommand{\lgray}[1]{\color{lightgray}{#1}}\) \(\newcommand{\rank}{\operatorname{rank}}\) \(\newcommand{\row}{\text{Row}}\) \(\newcommand{\col}{\text{Col}}\) \(\renewcommand{\row}{\text{Row}}\) \(\newcommand{\nul}{\text{Nul}}\) \(\newcommand{\var}{\text{Var}}\) \(\newcommand{\corr}{\text{corr}}\) \(\newcommand{\len}[1]{\left|#1\right|}\) \(\newcommand{\bbar}{\overline{\bvec}}\) \(\newcommand{\bhat}{\widehat{\bvec}}\) \(\newcommand{\bperp}{\bvec^\perp}\) \(\newcommand{\xhat}{\widehat{\xvec}}\) \(\newcommand{\vhat}{\widehat{\vvec}}\) \(\newcommand{\uhat}{\widehat{\uvec}}\) \(\newcommand{\what}{\widehat{\wvec}}\) \(\newcommand{\Sighat}{\widehat{\Sigma}}\) \(\newcommand{\lt}{<}\) \(\newcommand{\gt}{>}\) \(\newcommand{\amp}{&}\) \(\definecolor{fillinmathshade}{gray}{0.9}\)Universidad Estatal de California, Fresno

La mayoría de las veces, percibimos el mundo como un paquete unificado de sensaciones desde múltiples modalidades sensoriales. Es decir, nuestra percepción es multimodal. Este módulo proporciona una visión general de la percepción multimodal, incluyendo información sobre su neurobiología y sus efectos psicológicos.

objetivos de aprendizaje

- Definir la terminología básica y los principios básicos de la percepción multimodal.

- Describir la neuroanatomía de la integración multisensorial y nombrar algunas de las regiones de la corteza y mesencéfalo que han sido implicadas en el procesamiento multisensorial.

- Explicar la diferencia entre fenómenos multimodales y fenómenos crossmodales.

- Dar ejemplos de efectos conductuales multimodales y crossmodales.

Percepción: Unificada

Si bien ha sido tradicional estudiar los diversos sentidos de forma independiente, la mayoría de las veces, la percepción opera en el contexto de la información suministrada por múltiples modalidades sensoriales al mismo tiempo. Por ejemplo, imagínese si fue testigo de una colisión automovilística. Se podría describir el estímulo generado por este evento considerando cada uno de los sentidos de forma independiente; es decir, como un conjunto de estímulos unimodales. Tus ojos serían estimulados con patrones de energía luminosa rebotando en los autos involucrados. Tus oídos serían estimulados con patrones de energía acústica que emanan de la colisión. Tu nariz podría incluso ser estimulada por el olor a goma o gasolina ardientes.

No obstante, toda esta información sería relevante para lo mismo: tu percepción de la colisión automovilística. En efecto, a menos que alguien te pida explícitamente que describas tu percepción en términos unimodales, lo más probable es que experimentes el evento como un paquete unificado de sensaciones desde múltiples sentidos. En otras palabras, tu percepción sería multimodal. La cuestión es si las diversas fuentes de información involucradas en este estímulo multimodal son procesadas por separado por el sistema perceptual o no.

Durante las últimas décadas, la investigación perceptual ha señalado la importancia de la percepción multimodal: los efectos sobre la percepción de eventos y objetos en el mundo que se observan cuando hay información de más de una modalidad sensorial. La mayor parte de esta investigación indica que, en algún momento del procesamiento perceptual, se integra la información de las diversas modalidades sensoriales. Es decir, la información se combina y se trata como una representación unitaria del mundo.

Preguntas sobre la Percepción Multimodal

Varios problemas teóricos son planteados por la percepción multimodal. Al fin y al cabo, el mundo es un “mundo floreciente y zumbante de confusión” que constantemente bombardea nuestro sistema perceptivo con luz, sonido, calor, presión, etc. Para complicar las cosas, estos estímulos provienen de múltiples eventos repartidos tanto en el espacio como en el tiempo. Para volver a nuestro ejemplo: Digamos que el accidente automovilístico que observaste ocurrió en la calle principal de tu pueblo. Tu percepción durante el accidente automovilístico podría incluir mucha estimulación que no fue relevante para el accidente automovilístico. Por ejemplo, también podrías escuchar la conversación de una pareja cercana, ver a un pájaro volando hacia un árbol o oler el delicioso aroma del pan recién horneado de una panadería cercana (¡o los tres!). No obstante, lo más probable es que no cometerías el error de asociar alguno de estos estímulos con el accidente automovilístico. De hecho, rara vez combinamos los estímulos auditivos asociados a un evento con los estímulos visuales asociados a otro (aunque, en algunas circunstancias únicas, como el ventrílocuo, lo hacemos). ¿Cómo es capaz el cerebro de tomar la información de modalidades sensoriales separadas y emparejarla adecuadamente, para que los estímulos que pertenecen juntos permanezcan juntos, mientras que los estímulos que no pertenecen juntos sean tratados por separado? Es decir, ¿cómo determina el sistema perceptual qué estímulos unimodales deben integrarse y cuáles no?

Una vez que los estímulos unimodales se han integrado adecuadamente, podemos preguntarnos sobre las consecuencias de esta integración: ¿Cuáles son los efectos de la percepción multimodal que no estarían presentes si el procesamiento perceptual fuera solo unimodal? Quizás el hallazgo más robusto en el estudio de la percepción multimodal se refiere a esta última pregunta. No importa si estás viendo las acciones de las neuronas o el comportamiento de los individuos, se ha encontrado que las respuestas a estímulos multimodales suelen ser mayores que la respuesta combinada a cualquiera de las modalidades de manera independiente. Es decir, si presentaras el estímulo en una modalidad a la vez y midieras la respuesta a cada uno de estos estímulos unimodales, encontrarías que sumarlos aún no equivaldría a la respuesta al estímulo multimodal. Este efecto superaditivo de la integración multisensorial indica que existen consecuencias derivadas del procesamiento integrado de estímulos multimodales.

El alcance del efecto superaditivo (a veces denominado potenciación multisensorial) está determinado por la fuerza de la respuesta a la modalidad de estímulo único con el mayor efecto. Para entender este concepto, imagina a alguien hablándote en un ambiente ruidoso (como una fiesta abarrotada). A la hora de discutir este tipo de estímulos multimodales, suele ser útil describirlo en términos de sus componentes unimodales: En este caso, existe un componente auditivo (los sonidos generados por el habla de la persona que te habla) y un componente visual (la forma visual de los movimientos faciales como la persona te habla). En la fiesta abarrotada, el componente auditivo del habla de la persona puede ser difícil de procesar (debido al ruido de la fiesta circundante). En esta situación, el potencial de información visual sobre el habla —el lipreading—para ayudar a comprender el mensaje del orador es, en esta situación, bastante grande. Sin embargo, si estuvieras escuchando a esa misma persona hablar en una biblioteca tranquila, la porción auditiva probablemente sería suficiente para recibir el mensaje, y la porción visual ayudaría muy poco, si acaso (Sumby & Pollack, 1954). En general, para un estímulo con componentes multimodales, si la respuesta a cada componente (por sí sola) es débil, entonces la oportunidad de realce multisensorial es muy grande. Sin embargo, si un componente, por sí mismo, es suficiente para evocar una respuesta fuerte, entonces la oportunidad de mejora multisensorial es relativamente pequeña. Este hallazgo se llama el Principio de Efectividad Inversa (Stein & Meredith, 1993) porque la efectividad de la mejora multisensorial está inversamente relacionada con la respuesta unimodal con mayor efecto.

Otra cuestión teórica importante sobre la percepción multimodal se refiere a la neurobiología que la sustenta. Después de todo, en algún momento, la información de cada modalidad sensorial está definitivamente separada (por ejemplo, la luz entra a través de los ojos, y el sonido entra por los oídos). ¿Cómo toma el cerebro la información de diferentes sistemas neuronales (óptico, auditivo, etc.) y la combina? Si nuestra experiencia del mundo es multimodal, entonces debe darse el caso de que en algún momento durante el procesamiento perceptual, se combine la información unimodal proveniente de órganos sensoriales separados, como los ojos, los oídos, la piel. Una pregunta relacionada es en qué parte del cerebro se lleva a cabo esta integración. Pasamos a estas preguntas en el siguiente apartado.

Bases Biológicas de la Percepción Multimodal

Neuronas multisensoriales y convergencia neuronal

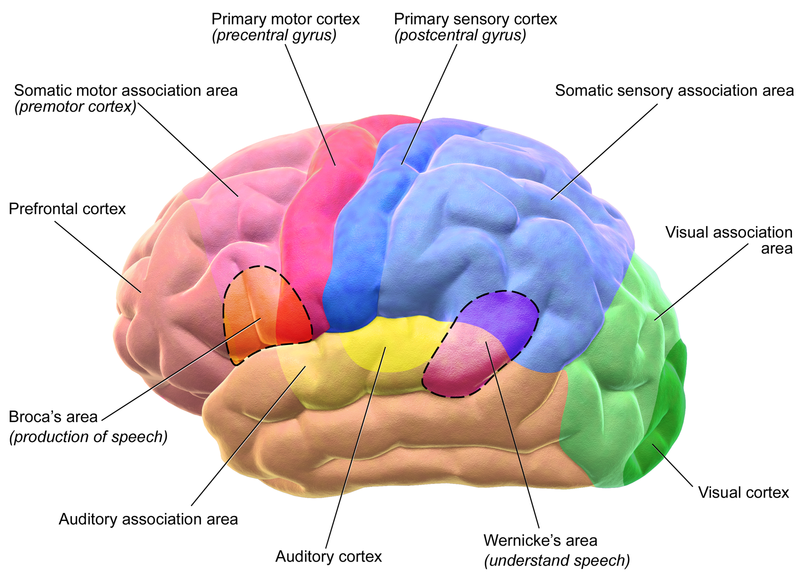

Un número sorprendentemente grande de regiones cerebrales en el mesencéfalo y la corteza cerebral están relacionadas con la percepción multimodal. Estas regiones contienen neuronas que responden a estímulos desde no solo una, sino múltiples modalidades sensoriales. Por ejemplo, una región llamada surco temporal superior contiene neuronas individuales que responden tanto a los componentes visuales como auditivos del habla (Calvert, 2001; Calvert, Hansen, Iversen, & Brammer, 2001). Estas zonas de convergencia multisensorial son interesantes, porque son una especie de intersección neuronal de información proveniente de los diferentes sentidos. Es decir, las neuronas que se dedican al procesamiento de un sentido a la vez —digamos visión o tacto— envían su información a las zonas de convergencia, donde se procesa conjuntamente.

Una de las zonas de convergencia multisensorial más estudiadas es el colículo superior (Stein & Meredith, 1993), que recibe entradas de muchas áreas diferentes del cerebro, incluyendo regiones involucradas en el procesamiento unimodal de estímulos visuales y auditivos (Edwards, Ginsburgh, Henkel, & Stein, 1979) . Curiosamente, el colículo superior está involucrado en la “respuesta orientadora”, que es el comportamiento asociado con mover la mirada del ojo hacia la ubicación de un estímulo visto u escuchado. Dada esta función para el colículo superior, no es de extrañar que allí se encuentren neuronas multisensoriales (Stein & Stanford, 2008).

Campos receptivos crossmodales

Los detalles de la anatomía y función de las neuronas multisensoriales ayudan a responder a la pregunta de cómo el cerebro integra adecuadamente los estímulos. Para entender los detalles, necesitamos discutir el campo receptivo de una neurona. En todo el cerebro, se pueden encontrar neuronas que responden únicamente a estímulos presentados en una región muy específica del espacio que rodea inmediatamente al perceptor. Esa región se llama campo receptivo de la neurona. Si se presenta un estímulo en el campo receptivo de una neurona, entonces esa neurona responde aumentando o disminuyendo su velocidad de disparo. Si un estímulo se presenta fuera del campo receptivo de una neurona, entonces no hay ningún efecto sobre la velocidad de disparo de la neurona. Es importante destacar que cuando dos neuronas envían su información a una tercera neurona, el campo receptivo de la tercera neurona es la combinación de los campos receptivos de las dos neuronas de entrada. A esto se le llama convergencia neuronal, porque la información de múltiples neuronas converge en una sola neurona. En el caso de las neuronas multisensoriales, la convergencia llega de diferentes modalidades sensoriales. Así, los campos receptivos de las neuronas multisensoriales son la combinación de los campos receptivos de neuronas localizadas en diferentes vías sensoriales.

Ahora bien, podría darse el caso de que la convergencia neuronal que da como resultado neuronas multisensoriales se establezca de una manera que ignore las ubicaciones de los campos receptivos de las neuronas de entrada. Sorprendentemente, sin embargo, estos campos receptivos crossmodales se superponen. Por ejemplo, una neurona multisensorial en el colículo superior podría recibir entrada de dos neuronas unimodales: una con un campo receptivo visual y otra con un campo receptivo auditivo. Se ha encontrado que los campos receptivos unimodales se refieren a las mismas ubicaciones en el espacio, es decir, las dos neuronas unimodales responden a estímulos en la misma región del espacio. Fundamentalmente, la superposición en los campos receptivos crossmodales juega un papel vital en la integración de estímulos crossmodales. Cuando la información de las modalidades separadas viene de dentro de estos campos receptivos superpuestos, entonces se trata como que proviene de la misma ubicación, y la neurona responde con una respuesta superaditiva (mejorada). Entonces, parte de la información que utiliza el cerebro para combinar entradas multimodales es la ubicación en el espacio de donde provienen los estímulos.

Este patrón es común en muchas neuronas multisensoriales en múltiples regiones del cerebro. Debido a esto, los investigadores han definido el principio espacial de la integración multisensorial: La mejora multisensorial se observa cuando las fuentes de estimulación están espacialmente relacionadas entre sí. Un fenómeno relacionado se refiere al momento de los estímulos intermodales. Los efectos de mejora se observan en las neuronas multisensoriales solo cuando las entradas de diferentes sentidos llegan dentro de poco tiempo entre sí (por ejemplo, Recanzone, 2003).

Procesamiento Multimodal en Corteza Unimodal

También se han observado neuronas multisensoriales fuera de las zonas de convergencia multisensorial, en áreas del cerebro que alguna vez se pensó que estaban dedicadas al procesamiento de una sola modalidad (corteza unimodal). Por ejemplo, durante mucho tiempo se pensó que la corteza visual primaria estaba dedicada al procesamiento de información exclusivamente visual. La corteza visual primaria es la primera parada en la corteza para obtener información que llega de los ojos, por lo que procesa información de muy bajo nivel como bordes. Curiosamente, se han encontrado neuronas en la corteza visual primaria que recibe información de la corteza auditiva primaria (donde se procesa la información sonora de la vía auditiva) y del surco temporal superior (zona de convergencia multisensorial mencionada anteriormente). Esto es notable porque indica que el procesamiento de la información visual está, desde una etapa muy temprana, influenciado por la información auditiva.

Puede haber dos formas de que ocurran estas interacciones multimodales. Primero, podría ser que el procesamiento de la información auditiva en etapas relativamente tardías del procesamiento retroalimenta para influir en el procesamiento de bajo nivel de la información visual en la corteza unimodal (McDonald, Teder-Sälejärvi, Russo, & Hillyard, 2003). Alternativamente, puede ser que áreas de corteza unimodal contacten entre sí directamente (Driver & Noesselt, 2008; Macaluso & Driver, 2005), de tal manera que la integración multimodal es un componente fundamental de todo procesamiento sensorial.

De hecho, el gran número de neuronas multisensoriales distribuidas alrededor de la corteza, en áreas de convergencia multisensorial y en córticas primarias, ha llevado a algunos investigadores a proponer que es necesaria una drástica reconceptualización del cerebro (Ghazanfar y Schroeder, 2006). Argumentan que la corteza no debe considerarse dividida en regiones aisladas que procesan sólo un tipo de información sensorial. Más bien, proponen que estas áreas solo prefieren procesar información de modalidades específicas pero se involucran en un procesamiento multisensorial de bajo nivel siempre que sea beneficioso para el perceptor (Vasconcelos et al., 2011).

Efectos conductuales de la percepción multimodal

Aunque los neurocientíficos tienden a estudiar interacciones muy simples entre neuronas, el hecho de que hayan encontrado tantas áreas transmodales de la corteza parece insinuar que la forma en que experimentamos el mundo es fundamentalmente multimodal. Como se discutió anteriormente, nuestras intuiciones sobre la percepción son consistentes con esto; no parece que nuestra percepción de los eventos esté limitada a la percepción de cada modalidad sensorial de forma independiente. Más bien, percibimos un mundo unificado, independientemente de la modalidad sensorial a través de la cual lo percibamos.

Probablemente requerirá muchos más años de investigación antes de que los neurocientíficos descubran todos los detalles de la maquinaria neuronal involucrada en esta experiencia unificada. Mientras tanto, los psicólogos experimentales han contribuido a nuestra comprensión de la percepción multimodal a través de investigaciones de los efectos conductuales asociados a la misma. Estos efectos se agrupan en dos clases amplias. La primera clase, los fenómenos multimodales, se refiere a la unión de entradas de múltiples modalidades sensoriales y los efectos de esta unión en la percepción. La segunda clase —fenómenos transmodales — se refiere a la influencia de una modalidad sensorial en la percepción de otra (Spence, Senkowski, & Roder, 2009).

Fenómenos Multimodales

Discurso Audiovisual

Los fenómenos multimodales se refieren a estímulos que generan información simultánea (o casi simultánea) en más de una modalidad sensorial. Como se discutió anteriormente, el discurso es un ejemplo clásico de este tipo de estímulos. Cuando un individuo habla, genera ondas sonoras que llevan información significativa. Si el perceptor también está mirando al hablante, entonces ese perceptor también tiene acceso a patrones visuales que llevan información significativa. Por supuesto, como sabe cualquiera que alguna vez haya intentado lispread, hay límites en lo informativo que es la información visual del habla. Aun así, el patrón visual del habla por sí solo es suficiente para una percepción del habla muy robusta. La mayoría de las personas asumen que los individuos sordos son mucho mejores en la lectura de labios que los individuos con audición normal. Puede ser una sorpresa saber, sin embargo, que algunos individuos con audición normal también son notablemente buenos para la reproducción de labios (a veces llamado “lectura del habla”). De hecho, existe una amplia gama de capacidad de lectura del habla tanto en poblaciones sordas como auditivas normales (Andersson, Lyxell, Rönnberg, & Spens, 2001). Sin embargo, las razones de esta amplia gama de desempeño no son bien entendidas (Auer & Bernstein, 2007; Bernstein, 2006; Bernstein, Auer, & Tucker, 2001; Mohammed et al., 2005).

¿Cómo interactúa la información visual sobre el habla con la información auditiva sobre el habla? Una de las primeras investigaciones de esta cuestión examinó la exactitud de reconocer las palabras habladas presentadas en un contexto ruidoso, al igual que en el ejemplo anterior sobre hablar en una fiesta abarrotada. Para estudiar este fenómeno experimentalmente, se presentó a los participantes algún ruido irrelevante (“ruido blanco” —que suena como una radio sintonizada entre estaciones). Incrustadas en el ruido blanco estaban las palabras habladas, y la tarea de los participantes era identificar las palabras. Hubo dos condiciones: una en la que solo se presentó el componente auditivo de las palabras (la condición “auditivo-solo”), y una en ambos componentes auditivo y visual (la condición “audiovisual”). Los niveles de ruido también fueron variados, de manera que en algunas pruebas, el ruido era muy fuerte en relación con el volumen de las palabras, y en otros ensayos, el ruido era muy suave en relación con las palabras. Sumby y Pollack (1954) encontraron que la precisión de identificar las palabras habladas era mucho mayor para la condición audiovisual que en la condición de auditorio solo. Además, el patrón de resultados fue consistente con el Principio de Efectividad Inversa: La ventaja obtenida por la presentación audiovisual fue mayor cuando el rendimiento de la condición de auditorio solo fue menor (es decir, cuando el ruido era más alto). A estos niveles de ruido, la ventaja audiovisual fue considerable: Se estimó que permitir que el participante viera al orador equivalía a bajar el volumen del ruido a más de la mitad. Claramente, la ventaja audiovisual puede tener efectos dramáticos sobre el comportamiento.

Otro fenómeno que utiliza el habla audiovisual es una ilusión muy famosa llamada el “efecto McGurk” (que lleva el nombre de uno de sus descubridores). En la formulación clásica de la ilusión, se graba una película de un hablante diciendo las sílabas “gaga”. Otra película está hecha del mismo orador diciendo las sílabas “baba”. Entonces, la porción auditiva de la película “baba” es doblada a la porción visual de la película “gaga”. Este estímulo combinado se presenta a los participantes, a quienes se les pide que informen lo que dijo el orador en la película. McGurk y MacDonald (1976) informaron que 98 por ciento de sus participantes reportaron haber escuchado la sílaba “dada” —que no estaba ni en los componentes visuales ni auditivos del estímulo. Estos resultados indican que cuando se integra la información visual y auditiva sobre el habla, puede tener profundos efectos en la percepción.

Interacciones táctiles/visuales en la propiedad corporal

Sin embargo, no todos los fenómenos de integración multisensorial conciernen al habla. Una ilusión multisensorial particularmente convincente implica la integración de información táctil y visual en la percepción de la propiedad corporal. En la “ilusión de la mano de goma” (Botvinick & Cohen, 1998), un observador se sitúa de manera que una de sus manos no sea visible. Una mano de goma falsa se coloca cerca de la mano oscurecida, pero en un lugar visible. Luego, el experimentador usa un pincel ligero para acariciar simultáneamente la mano oscurecida y la mano de goma en las mismas ubicaciones. Por ejemplo, si se está cepillando el dedo medio de la mano oscurecida, entonces también se cepillará el dedo medio de la mano de goma. Esto establece una correspondencia entre las sensaciones táctiles (provenientes de la mano oscurecida) y las sensaciones visuales (de la mano de goma). Después de poco tiempo (alrededor de 10 minutos), los participantes reportan sentir como si la mano de goma “les pertenezca”; es decir, que la mano de goma es parte de su cuerpo. Esta sensación puede ser tan fuerte que sorprender al participante golpeando la mano de goma con un martillo a menudo conduce a una retirada reflexiva de la mano oscurecida, aunque no esté en peligro alguno. Parece, entonces, que nuestra conciencia de nuestros propios cuerpos puede ser el resultado de la integración multisensorial.

Fenómenos Crossmodales

Los fenómenos crossmodales se distinguen de los fenómenos multimodales en que se refieren a la influencia que una modalidad sensorial tiene en la percepción de otra.

Influencia visual en la localización auditiva

Una famosa (y comúnmente experimentada) ilusión crossmodal se conoce como “el efecto ventriloquismo”. Cuando un ventrílocuo aparece para hacer hablar a un títere, engaña al oyente haciéndole pensar que la ubicación del origen de los sonidos del habla está en la boca del títere. Es decir, en lugar de localizar la señal auditiva (proveniente de la boca de un ventrílocuo) al lugar correcto, nuestro sistema perceptual la localiza incorrectamente (a la boca del títere).

¿Por qué podría suceder esto? Considere la información de que dispone el observador sobre la ubicación de los dos componentes del estímulo: los sonidos de la boca del ventrílocuo y el movimiento visual de la boca del títere. Si bien es muy obvio de dónde viene el estímulo visual (porque lo puedes ver), es mucho más difícil identificar la ubicación de los sonidos. En otras palabras, la ubicación visual muy precisa del movimiento de la boca aparentemente anula la ubicación menos especificada de la información auditiva. De manera más general, se ha encontrado que la ubicación de una amplia variedad de estímulos auditivos puede verse afectada por la presentación simultánea de un estímulo visual (Vroomen & De Gelder, 2004). Además, se ha demostrado el efecto ventriloquismo para objetos en movimiento: El movimiento de un objeto visual puede influir en la dirección percibida del movimiento de una fuente de sonido móvil (Soto-Faraco, Kingstone, & Spence, 2003).

Influencia auditiva en la percepción visual

Una ilusión relacionada demuestra el efecto contrario: donde los sonidos tienen un efecto sobre la percepción visual. En la ilusión de doble flash, se le pide a un participante que mire fijamente un punto central en un monitor de computadora. Al borde extremo de la visión del participante, una vez se resplandece brevemente un círculo blanco. También hay un evento auditivo simultáneo: ya sea un pitido o dos pitidos en rápida sucesión. Sorprendentemente, los participantes reportan haber visto dos destellos visuales cuando el flash va acompañado de dos pitidos; el mismo estímulo se ve como un solo destello en el contexto de un solo pitido o sin pitido (Shams, Kamitani, & Semojo, 2000). En otras palabras, ¡el número de pitidos escuchados influye en el número de destellos vistos!

Otra ilusión implica la percepción de colisiones entre dos círculos (llamados “bolas”) moviéndose uno hacia el otro y continuando uno a través del otro. Dichos estímulos pueden percibirse como dos bolas que se mueven una a través de la otra o como una colisión entre las dos bolas que luego rebotan entre sí en direcciones opuestas. Sekuler, Sekuler y Lau (1997) mostraron que la presentación de un estímulo auditivo en el momento del contacto entre las dos bolas influyó fuertemente en la percepción de un evento de colisión. En este caso, el sonido percibido influye en la interpretación del estímulo visual ambiguo.

Discurso Crossmodal

También se han descubierto varios fenómenos crossmodales para los estímulos del habla. Estos efectos de habla crossmodal usualmente muestran un procesamiento perceptual alterado de estímulos unimodales (por ejemplo, patrones acústicos) en virtud de la experiencia previa con el estímulo unimodal alterno (por ejemplo, patrones ópticos). Por ejemplo, Rosenblum, Miller y Sánchez (2007) realizaron un experimento examinando la capacidad de familiarizarse con la voz de una persona. Su primer hallazgo interesante fue unimodal: Al igual que lo que sucede cuando alguien escucha repetidamente a una persona hablar, los perceptores pueden familiarizarse con la “voz visual” de un hablante. Es decir, pueden familiarizarse con el estilo de hablar de la persona simplemente al ver a esa persona hablar. Aún más asombrosa fue su hallazgo crossmodal: La familiaridad con esta información visual también llevó a un mayor reconocimiento del habla auditiva del hablante, al que los participantes nunca habían tenido exposición.

De igual manera, se ha demostrado que cuando los perceptores ven una cara hablante, pueden identificar la voz (solo auditoria) de ese hablante, y viceversa (Kamachi, Hill, Lander, & Vatikiotis-Bateson, 2003; Lachs & Pisoni, 2004a, 2004b, 2004c; Rosenblum, Smith, Nichols, Lee, & Hale, 2006). Es decir, la forma visual de un hablante involucrado en el acto de hablar parece contener información sobre cómo debería sonar ese hablante. Quizás lo más sorprendente es que la forma auditiva del habla parece contener información sobre cómo debería ser el hablante.

Conclusión

En este módulo, hemos revisado algunas de las principales evidencias y hallazgos sobre el papel de la percepción multimodal en nuestra experiencia del mundo. Parece que nuestro sistema nervioso (y la corteza en particular) contiene una arquitectura considerable para el procesamiento de la información que llega de múltiples sentidos. Dada esta configuración neurobiológica, y la diversidad de fenómenos conductuales asociados a estímulos multimodales, es probable que la investigación de la percepción multimodal continúe siendo un tema de interés en el campo de la percepción experimental durante muchos años por venir.

Recursos Externos

- Artículo: Una revisión de la neuroanatomía y métodos asociados a la percepción multimodal:

- http://dx.doi.org/10.1016/j.neubiorev.2011.04.015

- Revista: Investigación Experimental del Cerebro Número especial: Procesamiento crossmodal

- www.springerlink.com/content/0014-4819/198/2-3

- Charla TED: Ilusiones ópticas

- http://www.ted.com/talks/beau_lotto_...how_how_we_see

- Vídeo: Demostración de McGurk

- Video: La ilusión de la mano de goma

- Web: Demostración de ilusión de doble flash

- http://www.cns.atr.jp/~kmtn/soundInd...llusoryFlash2/

Preguntas de Discusión

- La extensa red de áreas multisensoriales y neuronas en la corteza implica que mucho procesamiento perceptual ocurre en el contexto de múltiples entradas. ¿Podría alguna vez ser útil el procesamiento de información unimodal? ¿Por qué o por qué no?

- Algunos investigadores han argumentado que el Principio de Efectividad Inversa (PoIe) resulta de los efectos de techo: La mejora multisensorial no puede tener lugar cuando una modalidad es suficiente para el procesamiento porque en tales casos no es posible que se potencie el procesamiento (porque el rendimiento ya está en el” techo”). Por otro lado, otros investigadores afirman que el PoIe proviene de la capacidad del sistema perceptual para evaluar el valor relativo de las señales de estímulo, y utilizar las fuentes de información más confiables para construir una representación del mundo exterior. ¿Qué opinas? ¿Se podrían burlar alguna vez de estas dos posibilidades? ¿Qué tipo de experimentos se podría llevar a cabo para tratar de llegar a este tema?

- A finales del siglo XVII, un científico llamado William Molyneux le hizo al famoso filósofo John Locke una pregunta relevante para los estudios modernos del procesamiento multisensorial. La pregunta era esta: Imagínese a una persona que ha estado ciega desde su nacimiento, y que es capaz, en virtud del sentido del tacto, de identificar formas tridimensionales como esferas o pirámides. Ahora imagina que esta persona recibe de repente la capacidad de ver. ¿La persona, sin usar el sentido del tacto, sería capaz de identificar visualmente esas mismas formas? ¿Puede la investigación moderna en percepción multimodal ayudar a responder a esta pregunta? ¿Por qué o por qué no? ¿Cómo nos informan los estudios sobre fenómenos transmodales sobre la respuesta a esta pregunta?

El vocabulario

- Pelotas rebotando ilusión

- La tendencia a percibir dos círculos como rebotando entre sí si el momento de su contacto va acompañado de un estímulo auditivo.

- Fenómenos crossmodales

- Efectos que conciernen a la influencia de la percepción de una modalidad sensorial en la percepción de otra.

- Campo receptivo crossmodal

- Un campo receptivo que puede ser estimulado por un estímulo de más de una modalidad sensorial.

- Estímulo crossmodal

- Un estímulo con componentes en múltiples modalidades sensoriales que interactúan entre sí.

- Doble ilusión de flash

- La falsa percepción de dos destellos visuales cuando un solo destello se acompaña de dos pitidos auditivos.

- Integrado

- Proceso por el cual el sistema perceptual combina información derivada de más de una modalidad.

- Efecto McGurk

- Efecto en el que los componentes visuales y auditivos contradictorios de un estímulo del habla dan como resultado una percepción ilusoria.

- Multimodal

- De o pertenecientes a múltiples modalidades sensoriales.

- Percepción multimodal

- Los efectos que la estimulación concurrente en más de una modalidad sensorial tiene sobre la percepción de eventos y objetos en el mundo.

- Fenómenos multimodales

- Efectos que conciernen a la unión de entradas de múltiples modalidades sensoriales.

- Zonas de convergencia multisensorial

- Regiones en el cerebro que reciben entrada de múltiples áreas unimodales procesando diferentes modalidades sensoriales.

- Mejora multisensorial

- Ver “efecto superaditivo de la integración multisensorial”.

- Corteza auditiva primaria

- Una región de la corteza dedicada al procesamiento de información auditiva simple.

- Corteza visual primaria

- Una región de la corteza dedicada al procesamiento de información visual simple.

- Principio de Efectividad Inversa

- El hallazgo de que, en general, para un estímulo multimodal, si la respuesta a cada componente unimodal (por sí solo) es débil, entonces la oportunidad de realce multisensorial es muy grande. Sin embargo, si un componente, por sí mismo, es suficiente para evocar una respuesta fuerte, entonces el efecto sobre la respuesta obtenida al procesar simultáneamente los otros componentes del estímulo será relativamente pequeño.

- Campo receptivo

- La porción del mundo a la que responderá una neurona si ahí está presente un estímulo apropiado.

- Ilusión de mano de goma

- La falsa percepción de una mano falsa como perteneciente a un perceptor, debido a la información sensorial multimodal.

- Modalidades sensoriales

- Un tipo de sentido; por ejemplo, visión o audición.

- Principio espacial de integración multisensorial

- El hallazgo de que los efectos superaditivos de la integración multisensorial se observan cuando las fuentes de estimulación están espacialmente relacionadas entre sí.

- Efecto superaditivo de la integración multisensorial

- El hallazgo de que las respuestas a estímulos multimodales suelen ser mayores que la suma de las respuestas independientes a cada componente unimodal si se presentan por sí solo.

- Unimodal

- De o perteneciente a una sola modalidad sensorial.

- Componentes unimodales

- Las partes de un estímulo relevantes para una modalidad sensorial a la vez.

- Corteza unimodal

- Una región del cerebro dedicada al procesamiento de información desde una sola modalidad sensorial.

Referencias

- Andersson, U., Lyxell, B., Rönnberg, J., & Spens, K.-E. (2001). Correlatos cognitivos de la comprensión visual del habla en individuos con discapacidad auditiva. Revista de Estudios para Sordos y Educación para Sordos, 6 (2), 103—116. doi: 10.1093/sordo/6.2.103

- Auer, E. T., Jr., & Bernstein, L. E. (2007). Mejora de la percepción visual del habla en individuos con discapacidad auditiva de inicio temprano. Revista de Investigación del Habla, Lenguaje y Audición, 50 (5), 1157—1165. doi: 10.1044/1092-4388 (2007/080)

- Bernstein, L. E. (2006). Percepción visual del habla. En E. Vatikiotis-Bateson, G. Bailley, & P. Perrier (Eds.), Procesamiento de voz audiovisual. Cambridge, MA: Prensa MIT.

- Bernstein, L. E., Auer, E. T., Jr., & Tucker, P. E. (2001). Lectura del habla mejorada en adultos sordos: ¿Puede el entrenamiento/práctica a corto plazo cerrar la brecha para los adultos oyentes? Revista de Investigación del Habla, Lenguaje y Audición, 44, 5—18.

- Botvinick, M., & Cohen, J. (1998). Manos de goma /`sentimiento/' tocan que los ojos ven. [10.1038/35784]. Naturaleza, 391 (6669), 756—756.

- Calvert, G. A. (2001). Procesamiento crossmodal en el cerebro humano: Conocimientos a partir de estudios de neuroimagen funcional. Corteza Cerebral, 11, 1110—1123.

- Calvert, G. A., Hansen, P. C., Iversen, S. D., & Brammer, M. J. (2001). Detección de sitios de integración audiovisual en humanos mediante la aplicación de criterios electrofisiológicos al efecto negrita. NeuroImage, 14 (2), 427—438. doi: 10.1006/nimg.2001.0812

- Conductor, J., & Noesselt, T. (2008). La interacción multisensorial revela influencias crossmodales en las regiones cerebrales, las respuestas neuronales y los juicios “específicos de los sentidos”. Neurona, 57 (1), 11—23. doi: 10.1016/j.neuron.2007.12.013

- Edwards, S. B., Ginsburgh, C. L., Henkel, C. K., & Stein, B. E. (1979). Fuentes de proyecciones subcorticales al colículo superior en el gato. Revista de Neurología Comparada, 184 (2), 309—329. doi: 10.1002/cne.901840207

- Ghazanfar, A. A., & Schroeder, C. E. (2006). ¿El neocórtex es esencialmente multisensorial? TENDENCIAS en Ciencias Cognitivas, 10 (6), 278-285. doi: 10.1016/j.tics.2006.04.008

- Kamachi, M., Hill, H., Lander, K., & Vatikiotis-Bateson, E. (2003). “Poner la cara a la voz”: Emparejar la identidad a través de la modalidad. Biología Actual, 13, 1709—1714.

- Lachs, L., & Pisoni, D. B. (2004a). Identificación de fuentes transmodales en la percepción del habla. Psicología Ecológica, 16 (3), 159—187.

- Lachs, L., & Pisoni, D. B. (2004b). Información de origen crossmodal y reconocimiento de palabras habladas. Revista de Psicología Experimental: Percepción y Desempeño Humanos, 30 (2), 378—396.

- Lachs, L., & Pisoni, D. B. (2004c). Especificación de información de origen crossmodal en pantallas cinemáticas aisladas de voz. Revista de la Sociedad Acústica de América, 116 (1), 507—518.

- Macaluso, E., & Driver, J. (2005). Interacciones espaciales multisensoriales: Una ventana a la integración funcional en el cerebro humano. Tendencias en Neurociencias, 28 (5), 264—271. doi: 10.1016/j.tins.2005.03.008

- McDonald, J. J., Teder-Sälejärvi, W. A., Russo, F. D., & Hillyard, S. A. (2003). Sustratos neuronales de potenciación perceptual por atención espacial intermodal. Revista de Neurociencia Cognitiva, 15 (1), 10—19. doi: 10.1162/089892903321107783

- McGurk, H., & MacDonald, J. (1976). Escuchar labios y ver voces. Naturaleza, 264, 746—748.

- Mohammed, T., Campbell, R., MacSweeney, M., Milne, E., Hansen, P., & Coleman, M. (2005). La habilidad de lectura del habla y la sensibilidad visual al movimiento están relacionadas en lectores de voz sordos. Percepción, 34 (2), 205—216.

- Recanzone, G. H. (2003). Influencias auditivas en la percepción visual de la frecuencia temporal. Revista de Neurofisiología, 89 (2), 1078—1093. doi: 10.1152/jn.00706.2002

- Rosenblum, L. D., Miller, R. M., & Sánchez, K. (2007). Labio-léeme ahora, escúchame mejor después: Transferencia transmodal de efectos de familiaridad hablador. Ciencia Psicológica, 18 (5), 392—396.

- Rosenblum, L. D., Smith, N. M., Nichols, S. M., Lee, J., & Hale, S. (2006). Oír una cara: Coincidencia de hablante multimodal usando voz visible aislada. Percepción y Psicofísica, 68, 84—93.

- Sekuler, R., Sekuler, A. B., & Lau, R. (1997). El sonido altera la percepción visual del movimiento. [10.1038/385308a0]. Naturaleza, 385 (6614), 308—308.

- Shams, L., Kamitani, Y., & Shipó, S. (2000). Ilusiones. Lo que ves es lo que escuchas. Naturaleza, 408 (6814), 788. doi: 10.1038/35048669

- Soto-Faraco, S., Kingstone, A., & Spence, C. (2003). Contribuciones multisensoriales a la percepción del movimiento. Neuropsicologia, 41 (13), 1847—1862. doi: 10.1016/S0028-3932 (03) 00185-4

- Spence, C., Senkowski, D., & Roder, B. (2009). Procesamiento crossmodal. [Editorial Introductorio]. Investigación Cerebral Exerimental, 198 (2-3), 107—111. doi: 10.1007/s00221-009-1973—4

- Stein, B. E., & Meredith, M. A. (1993). La fusión de los sentidos. Cambridge, MA: La prensa del MIT.

- Stein, B. E., & Stanford, T. R. (2008). Integración multisensorial: Cuestiones actuales desde la perspectiva de la neurona única. [10.1038/nrn2331]. Nature Reseñas Neurociencia, 9 (4), 255—266.

- Sumby, W. H., & Pollack, I. (1954). Contribución visual de la inteligibilidad del habla en el ruido. Revista de la Sociedad Acústica de América, 26, 212—215.

- Vasconcelos, N., Pantoja, J., Belchior, H., Caixeta, F. V., Faber, J., Freire, M. A. M.,. Ribeiro, S. (2011). Las respuestas intermodales en la corteza visual primaria codifican objetos complejos y se correlacionan con la discriminación táctil. Actas de la Academia Nacional de Ciencias, 108 (37), 15408—15413. doi: 10.1073/pnas.1102780108

- Vroomen, J., & De Gelder, B. (2004). Efectos perceptuales de la estimulación intermodal: Ventriloquia y el fenómeno de congelación. En G. A. Calvert, C. Spence, & B. E. Stein (Eds.), Manual de procesos multisensoriales. Cambridge, MA: Prensa MIT.