7.1: Confiabilidad

- Última actualización

- Guardar como PDF

- Page ID

- 144370

La confiabilidad es el grado en que la medida de un constructo es consistente o confiable. En otras palabras, si usamos esta escala para medir el mismo constructo varias veces, ¿obtenemos prácticamente el mismo resultado cada vez, asumiendo que el fenómeno subyacente no está cambiando? Un ejemplo de una medición poco confiable es que la gente adivine tu peso. Muy probablemente, la gente adivine de manera diferente, las diferentes medidas serán inconsistentes, y por lo tanto, la técnica de “adivinación” de medición no es confiable. Una medición más confiable puede ser usar una báscula de peso, donde es probable que obtenga el mismo valor cada vez que pisa la báscula, a menos que su peso haya cambiado realmente entre las mediciones.

Tenga en cuenta que la confiabilidad implica consistencia pero no precisión. En el ejemplo anterior de la báscula de peso, si la báscula está calibrada incorrectamente (digamos, para afeitarte diez libras de tu peso verdadero, ¡solo para hacerte sentir mejor!) , no medirá tu verdadero peso y por lo tanto no es una medida válida. Sin embargo, la báscula de peso mal calibrada aún le dará el mismo peso cada vez (que es diez libras menos que su peso real), y por lo tanto la báscula es confiable.

¿Cuáles son las fuentes de observaciones poco fiables en las mediciones de ciencias sociales? Una de las fuentes primarias es la subjetividad del observador (o investigador). Si la moral de los empleados en una empresa se mide observando si los empleados se sonríen unos a otros, si hacen bromas, etc., entonces diferentes observadores pueden inferir diferentes medidas de moral si están viendo a los empleados en un día muy ocupado (cuando no tienen tiempo para bromear o charlar) o un día ligero (cuando son más joviales o habladores). Dos observadores también pueden inferir diferentes niveles de moral en el mismo día, dependiendo de lo que vean como una broma y lo que no lo es. La “observación” es una técnica de medición cualitativa. En ocasiones, la confiabilidad puede mejorarse mediante el uso de medidas cuantitativas, por ejemplo, contando el número de agravios presentados a lo largo de un mes como una medida de (la inversa de) la moral. Por supuesto, los agravios pueden o no ser una medida válida de la moral, pero están menos sujetos a la subjetividad humana, y por lo tanto más confiables. Una segunda fuente de observación poco confiable es hacer preguntas imprecisas o ambiguas. Por ejemplo, si le preguntas a la gente cuál es su salario, diferentes encuestados pueden interpretar esta pregunta de manera diferente como salario mensual, salario anual o salario por hora, y por lo tanto, las observaciones resultantes probablemente serán altamente divergentes y poco confiables. Una tercera fuente de falta de confiabilidad es hacer preguntas sobre temas que los encuestados no conocen o no les importan, como preguntarle a un graduado universitario estadounidense si está satisfecho con la relación de Canadá con Eslovenia, o pedirle a un Director Ejecutivo que califique la efectividad de su estrategia tecnológica de la compañía, algo que probablemente haya delegado a un ejecutivo de tecnología.

Entonces, ¿cómo se pueden crear medidas confiables? Si tu medición implica solicitar información de otros, como es el caso de gran parte de la investigación en ciencias sociales, entonces puedes comenzar reemplazando las técnicas de recolección de datos que dependen más de la subjetividad del investigador (como las observaciones) por aquellas que son menos dependientes de la subjetividad (como cuestionario), haciendo solo aquellas preguntas que los encuestados puedan conocer la respuesta o cuestiones que les importan, evitando elementos ambiguos en tus medidas (por ejemplo, indicando claramente si buscas salario anual), y simplificando la redacción en tus indicadores para que no malinterpretados por algunos encuestados (por ejemplo, evitando palabras difíciles cuyos significados tal vez no conozcan). Estas estrategias pueden mejorar la confiabilidad de nuestras medidas, aunque no necesariamente harán que las mediciones sean completamente confiables. Los instrumentos de medición aún deben probarse para determinar su confiabilidad. Existen muchas formas de estimar la confiabilidad, las cuales se discuten a continuación.

Confiabilidad entre evaluadores. La confiabilidad entre evaluadores, también llamada confiabilidad inter-observador, es una medida de consistencia entre dos o más evaluadores independientes (observadores) del mismo constructo. Por lo general, esto se evalúa en un estudio piloto, y se puede hacer de dos maneras, dependiendo del nivel de medición del constructo. Si la medida es categórica, se define un conjunto de todas las categorías, los evaluadores marcan en qué categoría cae cada observación, y el porcentaje de acuerdo entre los evaluadores es una estimación de la confiabilidad entre evaluadores. Por ejemplo, si hay dos evaluadores que califican 100 observaciones en una de las tres categorías posibles, y sus calificaciones coinciden con el 75% de las observaciones, entonces la confiabilidad entre evaluadores es de 0.75. Si la medida está escalada por intervalo o relación (por ejemplo, la actividad en el aula se mide una vez cada 5 minutos por dos evaluadores en una escala de respuesta de 1 a 7), entonces una correlación simple entre las medidas de los dos evaluadores también puede servir como una estimación de la confiabilidad entre evaluadores.

Fiabilidad prueba-retest. La confiabilidad test-retest es una medida de consistencia entre dos mediciones (pruebas) del mismo constructo administradas a la misma muestra en dos momentos diferentes en el tiempo. Si las observaciones no han cambiado sustancialmente entre las dos pruebas, entonces la medida es confiable. La correlación en las observaciones entre las dos pruebas es una estimación de la confiabilidad test-retest. Observe aquí que el intervalo de tiempo entre las dos pruebas es crítico. Generalmente, cuanto más largo es el intervalo de tiempo, mayor es la probabilidad de que las dos observaciones puedan cambiar durante este tiempo (debido a un error aleatorio), y menor será la confiabilidad test-retest.

Confiabilidad de mitad dividida. La confiabilidad de la mitad dividida es una medida de consistencia entre dos mitades de una medida de constructo. Por ejemplo, si tiene una medida de diez elementos de una construcción determinada, divida aleatoriamente esos diez elementos en dos conjuntos de cinco (se permiten mitades desiguales si el número total de ítems es impar) y administrar el instrumento completo a una muestra de encuestados. Luego, calcule la puntuación total para cada mitad para cada encuestado, y la correlación entre las puntuaciones totales en cada mitad es una medida de la confiabilidad de la mitad dividida. Cuanto más largo sea el instrumento, más probable es que las dos mitades de la medida sean similares (ya que los errores aleatorios se minimizan a medida que se agregan más ítems), y por lo tanto, esta técnica tiende a sobreestimar sistemáticamente la confiabilidad de los instrumentos más largos.

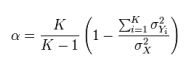

Confiabilidad de consistencia interna. La confiabilidad de consistencia interna es una medida de consistencia entre diferentes ítems del mismo constructo. Si se administra una medida de constructo de ítems múltiples a los encuestados, la medida en que los encuestados califican esos ítems de manera similar es un reflejo de la consistencia interna. Esta confiabilidad se puede estimar en términos de correlación promedio entre ítems, correlación promedio ítem a total, o más comúnmente, alfa de Cronbach. Como ejemplo, si tienes una báscula con seis ítems, tendrás quince emparejamientos de artículos diferentes, y quince correlaciones entre estos seis ítems. La correlación promedio entre ítems es el promedio de estas quince correlaciones. Para calcular la correlación promedio ítem a total, primero hay que crear un ítem “total” sumando los valores de los seis ítems, computar las correlaciones entre este ítem total y cada uno de los seis ítems individuales, y finalmente, promediar las seis correlaciones. Ninguna de las dos medidas anteriores toma en cuenta el número de ítems en la medida (seis ítems en este ejemplo). El alfa de Cronbach, una medida de confiabilidad diseñada por Lee Cronbach en 1951, tiene en cuenta el tamaño de la escala en la estimación de confiabilidad, calculada mediante la siguiente fórmula:

donde K es el número de ítems en la medida, es la varianza (cuadrado de desviación estándar) de las puntuaciones totales observadas, y

es la varianza (cuadrado de desviación estándar) de las puntuaciones totales observadas, y es la varianza observada para el ítem i. El alfa de Cronbach estandarizado puede calcularse usando una fórmula más simple:

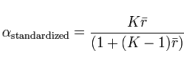

es la varianza observada para el ítem i. El alfa de Cronbach estandarizado puede calcularse usando una fórmula más simple:

donde K es el número de ítems, es la correlación promedio entre ítems, es decir, la media de K (K1) /2 coeficientes en la matriz de correlación triangular superior (o triangular inferior).

es la correlación promedio entre ítems, es decir, la media de K (K1) /2 coeficientes en la matriz de correlación triangular superior (o triangular inferior).