6.1: Variables aleatorias y Probabilidades

( \newcommand{\kernel}{\mathrm{null}\,}\)

Probabilidad asocia con un evento un número que indica la probabilidad de que ocurra ese evento en cualquier juicio. Un evento se modela como el conjunto de aquellos posibles resultados de un experimento que satisfacen una propiedad o proposición que caracteriza al evento.

A menudo, cada resultado se caracteriza por un número. Se realiza el experimento. Si el resultado se observa como una cantidad física, el tamaño de esa cantidad (en unidades prescritas) es la entidad realmente observada. En muchos casos no numéricos, es conveniente asignar un número a cada resultado. Por ejemplo, en un experimento de volteo de monedas, una “cabeza” puede estar representada por un 1 y una “cola” por un 0. En un juicio de Bernoulli, un éxito puede estar representado por un 1 y un fracaso por un 0. En una secuencia de ensayos, podemos estar interesados en el número de éxitos en una secuencia de ensayosn componentes. Se podría asignar un número distinto a cada carta en una baraja de naipes. Las observaciones del resultado de seleccionar una tarjeta podrían registrarse en términos de números individuales. En cada caso, el número asociado pasa a ser propiedad del resultado.

Variables aleatorias como funciones

Consideramos en este capítulo variables aleatorias reales (es decir, variables aleatorias de valor real). En el capítulo sobre Vectores Aleatorios y Distribuciones Conjuntas, extendemos la noción a cuantidades aleatorias valoradas por vector. La idea fundamental de una variable aleatoria real es la asignación de un número real a cada resultado elementalω en el espacio básicoΩ. Tal asignación equivale a determinar una funciónX, cuyo dominio esΩ y cuyo rango es un subconjunto de la línea real R. Recordemos que una función de valor real en un dominio (digamos un intervaloI en la línea real) se caracteriza por la asignación de un número realy a cada elementox (argumento) en el dominio. Para una función de valor real de una variable real, a menudo es posible escribir una fórmula o establecer de otra manera una regla que describa la asignación del valor a cada argumento. Excepto en casos especiales, no podemos escribir una fórmula para una variable aleatoriaX. Sin embargo, las variables aleatorias comparten algunas propiedades generales importantes de las funciones que desempeñan un papel esencial en la determinación de su utilidad.

Mapeos y mapeos inversos

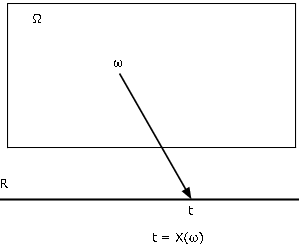

Existen diversas formas de caracterizar una función. Probablemente lo más útil para nuestros propósitos es como mapeo del dominioΩ al codominio R. Encontramos el diagrama cartográfico de la Figura 1 extremadamente útil para visualizar los patrones esenciales. Variable aleatoriaX, como mapeo desde el espacio básicoΩ a la línea real R, asigna a cada elementoω un valort=X(ω). El punto objetoω es mapeado, o transportado, en el punto de imagent. Cada unoω se mapea en exactamente unot, aunque variosω pueden tener el mismo punto de imagen.

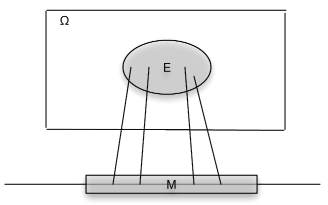

Asociados a una funciónX como mapeo están el mapeo inversoX−1 y las imágenes inversas que produce. MDéjese ser un conjunto de números en la línea real. Por la imagen inversa deM debajo del mapeoX, nos referimos al conjunto de todos aquellos en losω∈Ω que se mapeanM porX (ver Figura 2). SiX no toma un valor enM, la imagen inversa es el conjunto vacío (evento imposible). SiM incluye el rango deX, (el conjunto de todos los valores posibles deX), la imagen inversa es todo el espacio básicoΩ. Formalmente escribimos

X−1(M)={ω:X(ω)∈M}

Ahora asumimos que el conjuntoX−1(M), un subconjunto deΩ, es un evento para cada unoM. Un examen detallado de esa afirmación es un tema en la teoría de medidas. Afortunadamente, los resultados de la teoría de medidas aseguran que podemos hacer la suposición para cualquierX subconjuntoM de la línea real que probablemente se encuentre en la práctica. El conjuntoX−1(M) es el evento queX toma un valor enM. Como evento, se le puede asignar una probabilidad.

Ejemplo6.1.1 Some illustrative examples

- IEdondeE es un evento con probabilidadp. AhoraX toma sólo dos valores, 0 y 1. El evento queX toma el valor 1 es el conjunto

{ω:X(ω)=1}=X−1({1})=E

así que esoP({ω:X(ω)=1})=p. Esta notación bastante torpe se acorta aP(X=1)=p. De igual manera,. Considera cualquier conjuntoM. Si ni 1 ni 0 está enM, entoncesX−1(M)=∅ Si 0 está enM, pero 1 no lo está, entoncesX−1(M)=Ec Si 1 está enM, pero 0 no es, entoncesX−1(M)=E Si ambos 1 y 0 están enM, entoncesX−1(M)=Ω En este caso la clase de todos los eventosX−1(M) consiste en eventoE, su complementoEc, el evento imposible∅, y el evento seguroΩ. - Consideremos una secuencia de ensayos den Bernoulli, con probabilidadp de éxito. DejarSn ser la variable aleatoria cuyo valor es el número de éxitos en la secuencia de ensayos den componentes. Entonces, según el análisis en la sección "Ensayos de Bernoulli y la Distribución Binomial"

P(Sn=k)=C(n,k)pk(1−p)n−k0≤k≤n

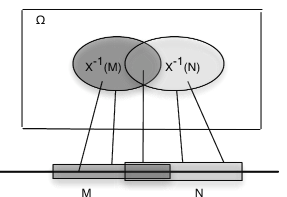

Antes de considerar más ejemplos, observamos una propiedad general de las imágenes inversas. Lo declaramos en términos de una variable aleatoria, que se mapeaΩ a la línea real (ver Figura 3).

Preservación de operaciones de conjunto

DejarX ser un mapeo deΩ a la línea real R. SiM,Mi,i∈J son conjuntos de números reales, con respectivas imágenes inversasE,Ei, entonces

X−1(Mc)=Ec,X−1(⋃i∈JMi)=⋃i∈JEi yX−1(⋂i∈JMi)=⋂i∈JEi

El examen de ejemplos gráficos simples muestra la plausibilidad de estos patrones. Las pruebas formales equivalen a una lectura cuidadosa de la notación. En el centro de la estructura están los hechos de que cada elemento ω se mapea en un solo punto de imagen t y que la imagen inversa deM es el conjunto de todos aquellosω que se mapean en puntos de imagen enM.

Una consecuencia fácil, pero importante, de los patrones generales es que las imágenes inversas de disjuntas tambiénM,N son disjuntas. Esto implica que la inversa de una unión disjunta deMi es una unión disjunta de las imágenes inversas separadas.

Ejemplo6.1.2 Events determined by a random variable

Consideremos, nuevamente, la variable aleatoriaSn que cuenta el número de éxitos en una secuencia de ensayos den Bernoulli. Dejarn=10 yp=0.33. Supongamos que queremos determinar la probabilidadP(2<S10≤8). VamosAk={ω:S10(ω)=k}, a lo que solemos acortarAk={S10=k}. Ahora laAk forma una partición, ya que no podemos tenerω∈Ak yω∈Akj≠k (es decir, para cualquieraω, no podemos tener dos valores paraSn(ω)). Ahora,

{2<S10≤8}=A3⋁A4⋁A5⋁A6⋁A7⋁A8

ya queS10 toma un valor mayor que 2 pero no mayor que 8 iff toma uno de los valores enteros de 3 a 8. Por la aditividad de la probabilidad,

Transferencia de masa y distribución de probabilidad inducida

Debido a la naturaleza abstracta del espacio básico y la clase de eventos, estamos limitados en los tipos de cálculos que se pueden realizar de manera significativa con las probabilidades en el espacio básico. Representamos la probabilidad como masa distribuida en el espacio básico y la visualizamos con la ayuda de diagramas generales de Venn y mapas minterm. Ahora pensamos en el mapeo deΩ a R como una producción de una transferencia punto por punto de la masa de probabilidad a la línea real. Esto se puede hacer de la siguiente manera:

A cualquier conjuntoM en la línea real asignar masa de probabilidadPX(M)=P(X−1(M))

Es evidente quePX(M)≥0 yPX (R)=P(Ω)=1. Y debido a la preservación de las operaciones de conjunto por el mapeo inverso

PX(⋁∞i=1Mi)=P(X−1(⋁∞i=1Mi))=P(⋁∞i=1X−1(Mi))=∑∞i=1P(X−1(Mi))=∑∞i=1PX(Mi)

Esto significa quePX tiene las propiedades de una medida de probabilidad definidas en los subconjuntos de la línea real. Algunos resultados de la teoría de medidas muestran que esta probabilidad se define de manera única en una clase de subconjuntos de R que incluye cualquier conjunto normalmente encontrado en las aplicaciones. Hemos logrado una transferencia punto por punto del aparato de probabilidad a la línea real de tal manera que podemos hacer cálculos sobre la variable aleatoriaX. Llamamos aPX la medida de probabilidad inducida por X. Su importancia radica en el hecho de queP(X∈M)=PX(M). Así, para determinar la probabilidad de que la cantidad aleatoria X tome un valor en el conjunto M, determinamos cuánta masa de probabilidad inducida hay en el conjunto M. Esta transferencia produce lo que se denomina distribución de probabilidad para X. En el capítulo "Funciones de distribución y densidad “, consideramos formas útiles de describir la distribución de probabilidad inducida por una variable aleatoria. Pasamos primero a una clase especial de variables aleatorias.

Variables aleatorias simples

Consideramos, con cierto detalle, variables aleatorias que solo tienen un conjunto finito de valores posibles. Estas se llaman variables aleatorias simples. Así, el término “simple” se emplea en un sentido especial, técnico. La importancia de las variables aleatorias simples se basa en dos hechos. Por un lado, en la práctica podemos distinguir sólo un conjunto finito de valores posibles para cualquier variable aleatoria. Además, cualquier variable aleatoria puede aproximarse lo más cerca posible por una simple variable aleatoria. Cuando se ha examinado la estructura y propiedades de variables aleatorias simples, pasamos a casos más generales. Muchas propiedades de las variables aleatorias simples se extienden al caso general a través del procedimiento de aproximación.

Representación con la ayuda de funciones indicadoras

Para tratar las variables aleatorias simples de manera clara y precisa, debemos encontrar formas adecuadas de expresarlas analíticamente. Esto lo hacemos con la ayuda de funciones indicadoras. Se encuentran tres formas básicas de representación. Estos no son representantes mutuamente excluyentes.

Forma estándar o canónica, que muestra los valores posibles y los eventos correspondientes. Si X toma valores distintos

{t1,t2,⋅⋅⋅,tn}con probabilidades respectivas{p1,p2,⋅⋅⋅,pn}

y siAi={X=ti}, para1≤i≤n, entonces{A1,A2,⋅⋅⋅,An} es una partición (es decir, en cualquier juicio, ocurre exactamente uno de estos eventos). A esto lo llamamos la partición determinada por (o, generada por) X. Podemos escribir

SiX(ω)=ti, entoncesω∈Ai, para queIAi(ω)=1 y todas las demás funciones del indicador tengan valor cero. La expresión de suma selecciona así el valor correctoti. Esto es cierto para cualquierati, por lo que la expresión representaX(ω) para todosω. El conjunto distinto{A,B,C} de los valores y las probabilidades correspondientes{p1,p2,⋅⋅⋅,pn} constituyen la distribución para X. Los cálculos de probabilidad para X se realizan en términos de su distribución. Una de las ventajas de la forma canónica es que muestra el rango (conjunto de valores), y si{A,B,C,D} se conocen las probabilidades, se determina la distribución. Obsérvese que en forma canónica, si uno de losti tiene valor cero, incluimos ese término. Para algunas distribuciones de probabilidad puede ser queP(Ai)=0 para una o más de lasti. En ese caso, llamamos a estos valores valores nulos, pues solo pueden ocurrir con probabilidad cero, y por lo tanto son prácticamente imposibles. En la formulación general, incluimos posibles valores nulos, ya que no afectan ningún cálculo de probabilidad.

Ejemplo6.1.3 Successes in Bernoulli trials

Como muestra el análisis de los ensayos de Bernoulli y la distribución binomial (ver Sección 4.8), la forma canónica debe ser

Sn=∑nk=0kIAkconP(Ak)=C(n,k)pk(1−p)n−k,0≤k≤n

Para muchos propósitos, tanto teórica como práctica, la forma canónica es deseable. Por un lado, muestra directamente el rango (es decir, conjunto de valores) de la variable aleatoria. La distribución consiste en el conjunto de valores{tk:1≤k≤n} emparejados con el conjunto correspondiente de probabilidades{pk:1≤k≤n}, dondepk=P(Ak)=P(X=tk).

La variable aleatoria simple X puede ser representada por una forma primitiva

Observaciones

- Si{Cj:1≤j≤m} es una clase disjunta, pero⋃mj=1Cj≠Ω, podemos anexar el eventoCm+1=[⋃mj=1Cj]c y asignarle valor cero.

- Decimos una forma primitiva, ya que la representación no es única. Cualquiera de los Ci puede ser particionado, con el mismo valorci asociado a cada subconjunto formado.

- La forma canónica es una forma primitiva especial. La forma canónica es única, y en muchos sentidos normativa.

Ejemplo6.1.4 Simple random variables in primitive form

- Se hace girar una rueda dando, sobre una base igualmente probable, los números enteros del 1 al 10. CiSea el evento en el que la rueda se detengai,1≤i≤10. Cada unoP(Ci)=0.1. Si los números 1, 4 o 7 suben, el jugador pierde diez dólares; si los números 2, 5 o 8 aparecen, el jugador no gana nada; si los números 3, 6 o 9 aparecen, el jugador gana diez dólares; si el número 10 aparece, el jugador pierde un dólar. La variable aleatoria que expresa los resultados puede expresarse en forma primitiva como

X=−10IC1+0IC2+10IC3−10IC4+0IC5+10IC6−10IC7+0IC8+10IC9−IC10

-

Una tienda tiene ocho artículos a la venta. Los precios son de $3.50, $5.00, $3.50, $7.50, $5.00, $5.00, $3.50 y $7.50, respectivamente. Entra un cliente. Ella compra uno de los artículos con probabilidades 0.10, 0.15, 0.15, 0.20, 0.10 0.05, 0.10 0.15. Se puede escribir la variable aleatoria que expresa el monto de su compra

X=3.5IC1+5.0IC2+3.5IC3+7.5IC4+5.0IC5+5.0IC6+3.5IC7+7.5IC8

Comúnmente tenemos X representado en forma afín, en la que la variable aleatoria se representa como una combinación afín de funciones indicadoras (es decir, una combinación lineal de las funciones indicadoras más una constante, que puede ser cero).

De esta forma, la clase no{E1,E2,⋅⋅⋅,Em} es necesariamente mutuamente excluyente, y los coeficientes no muestran directamente el conjunto de valores posibles. De hecho, losEi suelen formar una clase independiente. OBSERVACIÓN. Cualquier forma primitiva es una forma afín especial en la quec0=0 y laEi forma una partición.

Ejemplo6.1.5

Consideremos, nuevamente, la variable aleatoriaSn que cuenta el número de éxitos en una secuencia de ensayos den Bernoulli. SiEi es el evento de éxito en eli th juicio, entonces una forma natural de expresar el conteo es

Sn=∑ni=1IEi, conP(Ei)=p1≤i≤n

Esto es forma afín, conc0=0 yci=1 para1≤i≤n. En este caso, losEi no pueden formar una clase mutuamente excluyente, ya que forman una clase independiente.

Eventos generados por una simple variable aleatoria: forma canónica

Podemos caracterizar la clase de todas las imágenes inversas formadas por un simple aleatorioX en términos de la partición que determina. Considera cualquier conjuntoM de números reales. Siti en el rango deX está enM, entonces cada punto seω∈Ai mapea enti, por lo tanto, enM. Si el conjuntoJ es el conjunto de índicesi tal queti∈M, entonces

Sólo esos puntosω enAM=⋁i∈JAi mapa enM.

De ahí que la clase de eventos (es decir, imágenes inversas) determinada porX consiste en el evento imposible∅, el evento seguroΩ, y la unión de cualquier subclase de laAi en la partición determinada porX.

Ejemplo6.1.6 Events determined by a simple random variable

Supongamos que la variable aleatoria simpleX está representada en forma canónica por

X=−2IA−IB+0IC+3ID

Entonces la clase{A,B,C,D} es la partición determinada porX y el rango deX es{−2,−1,0,3}.

- SiM es el intervalo [-2, 1], los valores -2, -1 y 0 están enM yX−1(M)=A⋁B⋁C.

- SiM es el conjunto (-2, -1]∪ [1, 5], entonces los valores -1, 3 están enM yX−1(M)=B⋁D.

- El evento{X≤1}={X∈(−∞,1]}=X−1(M), dondeM=(−∞,1]. Dado que los valores -2, -1, 0 están enM, el evento{X≤1}=A⋁B⋁C.

Determinación de la distribución

Determinar la partición generada por una variable aleatoria simple equivale a determinar la forma canónica. Luego se completa la distribución determinando las probabilidades de cada eventoAk={X=tk}.

De una forma primitiva

Antes de anotar el patrón general, consideramos un ejemplo ilustrativo.

Ejemplo6.1.7 The distribution from a primitive form

Supongamos que se selecciona un elemento al azar de un grupo de diez elementos. Los valores (en dólares) y las probabilidades respectivas son

| cj | 2.00 | 1.50 | 2.00 | 2.50 | 1.50 | 1.50 | 1.00 | 2.50 | 2.00 | 1.50 |

| P(Cj) | 0.08 | 0.11 | 0.07 | 0.15 | 0.10 | 0.09 | 0.14 | 0.08 | 0.08 | 0.10 |

Por inspección, encontramos cuatro valores distintos:t1=1.00,t2=1.50,t3=2.00, yt4=2.50. El valor 1.00 se toma paraω∈C7, de modo queA1=C7 yP(A1)=P(C7)=0.14. Se toma el valor 1.50ω∈C2,C5,C6,C10 para que

A2=C2⋁C5⋁C6⋁C10yP(A2)=P(C2)+P(C5)+P(C6)+P(C10)=0.40

Del mismo modo

P(A3)=P(C1)+P(C3)+P(C9)=0.23yP(A4)=P(C4)+P(C8)=0.25

La distribución para X es así

| k | 1.00 | 1.50 | 2.00 | 2.50 |

| P(X=k) | 0.14 | 0.40 | 0.23 | 0.23 |

El procedimiento general podrá formularse de la siguiente manera:

SiX=∑mj=1cjIcj, identificamos el conjunto de valores distintos en el conjunto{cj:1≤j≤m}. Supongamos que estos sont1<t2<⋅⋅⋅<tn. Para cualquier valor posibleti en el rango, identificar el conjuntoJi de índices de aquellosj tales quecj=ti Luego los términos

∑JicjIcj=ti∑JiIcj=tiIAi, dondeAi=⋁j∈JiCj,

y

P(Ai)=P(X=ti)=∑j∈JP(Cj)

El examen de este procedimiento demuestra que existen dos fases:

- Seleccionar y ordenar los distintos valorest1,t2,⋅⋅⋅,tn

- Agregar todas las probabilidades asociadas a cada valorti para determinarP(X=ti)

Utilizamos la función m-csort que realiza estas dos operaciones (ver Ejemplo 4 de “Mintterms y MATLAB Calculations”).

Ejemplo6.1.8 Use of csort on Example 6.1.7

>> C = [2.00 1.50 2.00 2.50 1.50 1.50 1.00 2.50 2.00 1.50]; % Matrix of c_j

>> pc = [0.08 0.11 0.07 0.15 0.10 0.09 0.14 0.08 0.08 0.10]; % Matrix of P(C_j)

>> [X,PX] = csort(C,pc); % The sorting and consolidating operation

>> disp([X;PX]') % Display of results

1.0000 0.1400

1.5000 0.4000

2.0000 0.2300

2.5000 0.2300

Para un problema así de pequeño, el uso de una herramienta como csort no es realmente necesario. Pero en muchos problemas con grandes conjuntos de datos la función m csort es muy útil.

De forma afín

Supongamos queX está en forma afín,

X=c0+c1IE1+c2IE2+⋅⋅⋅+cmIEm=c0+∑mj=1cjIEj

Determinamos una forma primitiva particular determinando el valor deX en cada minterm generado por la clase{Ej:1≤j≤m}. Esto lo hacemos de manera sistemática utilizando vectores minterm y propiedades de funciones indicadoras.

Xes constante en cada minterm generado por la clase{E1,E2,⋅⋅⋅,Em} ya que, como se observa en el tratamiento de la expansión minterm, cada función indicadoraIEi es constante en cada minterm. Determinamos el valorsi deX en cada mintermMi. Esto describeX en una forma primitiva especial

Aplicamos la operación csort a las matrices de valores y probabilidades minterm para determinar la distribución paraX.

Ilustramos con un ejemplo sencillo. La extensión al caso general debe ser bastante evidente. Primero, hacemos el problema “a mano” en forma tabular. Entonces utilizamos los m-procedimientos para llevar a cabo las operaciones deseadas.

Ejemplo6.1.9 Finding the distribution from affine form

Una casa de pedidos por correo cuenta con tres artículos (límite de uno de cada tipo por cliente). Let

- E1= el evento que el cliente ordena el artículo 1, a un precio de 10 dólares.

- E2= el evento que el cliente ordena el artículo 2, a un precio de 18 dólares.

- E3= el evento que el cliente ordena el artículo 3, a un precio de 10 dólares.

Hay un cargo por correo de 3 dólares por pedido.

Suponemos que{E1,E2,E3} es independiente con probabilidades 0.6, 0.3, 0.5, respectivamente. XSea la cantidad que un cliente que ordena los artículos especiales gasta en ellos más el costo de envío. Entonces, en forma afín,

X=10IE1+18IE2+10IE3+3

Buscamos primero la forma primitiva, usando las probabilidades minterm, que pueden calcularse en este caso usando la función m minprob.

- Para obtener el valor deX en cada minterm

- Multiplicar el vector minterm para cada evento generador por el coeficiente para ese evento

- Suma los valores en cada minterm y suma la constante

Para completar la tabla, enumere las probabilidades minterm correspondientes.

i 10IE1 18IE2 10IE3 c s−i pmi 0 0 0 0 3 3 0.14 1 0 0 10 3 13 0.14 2 0 18 0 3 21 0.06 3 0 18 10 3 31 0.06 4 10 0 0 3 13 0.21 5 10 0 10 3 23 0.21 6 10 18 0 3 31 0.09 7 10 18 10 3 41 0.09 Entonces ordenamos en elsi, los valores en los diversosMi, para exponer más claramente la forma primitiva paraX.

Valores de “forma primitiva” i si pmi 0 3 0.14 1 13 0.14 4 13 0.21 2 21 0.06 5 23 0.21 3 31 0.06 6 31 0.09 7 41 0.09 La forma primitiva deX es así

\ (X = 3I_ {M_0} + 12I_ {M_1} + 13I_ {M_4} + 21I_ {M_2} + 23I_ {M_5} + 31I_ {M_3} + 31I_ {M_6} + 41I_ {M_7}

Observamos que el valor 13 se toma en mintermsM1 yM4. La probabilidadX tiene el valor 13 es asíp(1)+p(4). De igual manera,X tiene valor 31 sobre mintermsM3 yM6.

- Para completar el proceso de determinación de la distribución, enumeramos los valores ordenados y consolidamos sumando las probabilidades de los minterms sobre los que se toma cada valor, de la siguiente manera:

k tk pk 1 3 0.14 2 13 0.14 + 0.21 = 0.35 3 21 0.06 4 23 0.21 5 31 0.06 + 0.09 = 0.15 6 41 0.09 Los resultados se pueden poner en una matrizX de valores posibles y una matriz correspondiente PX de probabilidades queX tome cada uno de estos valores. El examen de la tabla muestra que

X=[3 13 21 23 31 41] yPX= [0.14 0.35 0.06 0.21 0.15 0.09]

MatricesX y PX describen la distribución paraX.

Un procedimiento m para determinar la distribución a partir de la forma afín

Ahora consideramos los pasos adecuados de MATLAB para determinar la distribución a partir de la forma afín, luego incorporarlos en el procedimiento m canónico para llevar a cabo la transformación. Comenzamos con la variable aleatoria en forma afín, y suponemos que tenemos disponibles, o podemos calcular, las probabilidades minterm.

El procedimiento utiliza mintable para establecer los patrones vectoriales básicos minterm, luego usa una matriz de coeficientes, incluyendo el término constante (establecido a cero si está ausente), para obtener los valores en cada minterm. Las probabilidades minterm se incluyen en una matriz de filas.

Habiendo obtenido los valores en cada minterm, el procedimiento realiza la consolidación deseada mediante el uso de la función m csort.

Ejemplo6.1.10 Steps in determining the distribution for X in Example 6.1.9

>> c = [10 18 10 3]; % Constant term is listed last

>> pm = minprob(0.1*[6 3 5]);

>> M = mintable(3) % Minterm vector pattern

M =

0 0 0 0 1 1 1 1

0 0 1 1 0 0 1 1

0 1 0 1 0 1 0 1

% - - - - - - - - - - - - - - % An approach mimicking ``hand'' calculation

>> C = colcopy(c(1:3),8) % Coefficients in position

C =

10 10 10 10 10 10 10 10

18 18 18 18 18 18 18 18

10 10 10 10 10 10 10 10

>> CM = C.*M % Minterm vector values

CM =

0 0 0 0 10 10 10 10

0 0 18 18 0 0 18 18

0 10 0 10 0 10 0 10

>> cM = sum(CM) + c(4) % Values on minterms

cM =

3 13 21 31 13 23 31 41

% - - - - - - - - - - - - - % Practical MATLAB procedure

>> s = c(1:3)*M + c(4)

s =

3 13 21 31 13 23 31 41

>> pm = 0.14 0.14 0.06 0.06 0.21 0.21 0.09 0.09 % Extra zeros deleted

>> const = c(4)*ones(1,8);}

>> disp([CM;const;s;pm]') % Display of primitive form

0 0 0 3 3 0.14 % MATLAB gives four decimals

0 0 10 3 13 0.14

0 18 0 3 21 0.06

0 18 10 3 31 0.06

10 0 0 3 13 0.21

10 0 10 3 23 0.21

10 18 0 3 31 0.09

10 18 10 3 41 0.09

>> [X,PX] = csort(s,pm); % Sorting on s, consolidation of pm

>> disp([X;PX]') % Display of final result

3 0.14

13 0.35

21 0.06

23 0.21

31 0.15

41 0.09

Los dos pasos básicos se combinan en el procedimiento m canónico, que utilizamos para resolver el problema anterior.

Ejemplo6.1.11 Use of canonic on the variables of Example 6.1.10

>> c = [10 18 10 3]; % Note that the constant term 3 must be included last

>> pm = minprob([0.6 0.3 0.5]);

>> canonic

Enter row vector of coefficients c

Enter row vector of minterm probabilities pm

Use row matrices X and PX for calculations

Call for XDBN to view the distribution

>> disp(XDBN)

3.0000 0.1400

13.0000 0.3500

21.0000 0.0600

23.0000 0.2100

31.0000 0.1500

41.0000 0.0900

Con la distribución disponible en las matricesX (conjunto de valores) y PX (conjunto de probabilidades), podemos calcular una amplia variedad de cantidades asociadas a la variable aleatoria.

Utilizamos dos dispositivos clave:

- Utilice operaciones relacionales y lógicas en la matriz de valoresX para determinar una matrizM que tenga unas para aquellos valores que cumplan una condición prescrita. P(X∈M): PM = M*PX'

- DetermineG=g(X)=[g(X1)g(X2)⋅⋅⋅g(Xn)] mediante el uso de operaciones de matriz en matrizX. Tenemos dos alternativas:

- Utilice la matrizG, que tiene valoresg(ti) para cada valor posibleti paraX, o,

- Aplicar csort al par(G,PX) para obtener la distribución paraZ=g(X). Esta distribución (en matrices de valor y probabilidad) puede ser utilizada exactamente de la misma manera que para la variable aleatoria originalX.

Ejemplo6.1.12 Continuation of Example 6.1.11

Supongamos que para la variable aleatoriaX en el Ejemplo 6.11 se desea determinar las probabilidades

P(15≤X≤35),P(|X−20|≤7), y(X−10)(X−25)>0)

>> M = (X>=15)&(X<=35); M = 0 0 1 1 1 0 % Ones for minterms on which 15 <= X <= 35 >> PM = M*PX' % Picks out and sums those minterm probs PM = 0.4200 >> N = abs(X-20)<=7; N = 0 1 1 1 0 0 % Ones for minterms on which |X - 20| <= 7 >> PN = N*PX' % Picks out and sums those minterm probs PN = 0.6200 >> G = (X - 10).*(X - 25) G = 154 -36 -44 -26 126 496 % Value of g(t_i) for each possible value >> P1 = (G>0)*PX' % Total probability for those t_i such that P1 = 0.3800 % g(t_i) > 0 >> [Z,PZ] = csort(G,PX) % Distribution for Z = g(X) Z = -44 -36 -26 126 154 496 PZ = 0.0600 0.3500 0.2100 0.1500 0.1400 0.0900 >> P2 = (Z>0)*PZ' % Calculation using distribution for Z P2 = 0.3800

Ejemplo6.1.13 Alternate formulation of Example 4.3.3 from "Composite Trials"

Diez autos de carreras participan en contrarreloj para determinar las pole positions para una próxima carrera. Para calificar, deben publicar una velocidad promedio de 125 mph o más en una carrera de prueba. QueEi sea el evento el autoi th hace velocidad clasificatoria. Parece razonable suponer que la clase{Ei:1≤i≤10} es independiente. Si las probabilidades de éxito respectivas son 0.90, 0.88, 0.93, 0.77, 0.85, 0.96, 0.72, 0.83, 0.91, 0.84, ¿cuál es la probabilidad de quek o más califiquen (k= 6,7,8,9,10)?

Solución

LetX=∑10i=1IEi

>> c = [ones(1,10) 0];

>> P = [0.90, 0.88, 0.93, 0.77, 0.85, 0.96, 0.72, 0.83, 0.91, 0.84];

>> canonic

Enter row vector of coefficients c

Enter row vector of minterm probabilities minprob(P)

Use row matrices X and PX for calculations

Call for XDBN to view the distribution

>> k = 6:10;

>> for i = 1:length(k)

Pk(i) = (X>=k(i))*PX';

end

>> disp(Pk)

0.9938 0.9628 0.8472 0.5756 0.2114

Esta solución no es tan conveniente de escribir. Sin embargo, con la distribución paraX como se define, se pueden determinar muchas otras probabilidades. Esto es particularmente el caso cuando se desea comparar los resultados de dos carreras independientes o “heats”. Consideramos tales problemas en el estudio de Clases Independientes de Variables Aleatorias.

Una forma de función para canónico

Una desventaja del procedimiento canónico es que siempre nombra la salidaX y PX. Si bien estos pueden renombrarse fácilmente, frecuentemente es deseable usar algún otro nombre para la variable aleatoria desde el principio. Una forma de función, que llamamos canonicf, es útil en este caso.

Ejemplo6.1.14 Alternate solution of Example 6.1.13, using canonicf

>> c = [10 18 10 3];

>> pm = minprob(0.1*[6 3 5]);

>> [Z,PZ] = canonicf(c,pm);

>> disp([Z;PZ]') % Numbers as before, but the distribution

3.0000 0.1400 % matrices are now named Z and PZ

13.0000 0.3500

21.0000 0.0600

23.0000 0.2100

31.0000 0.1500

41.0000 0.0900

Variables aleatorias generales

La distribución para una variable aleatoria simple se visualiza fácilmente como concentraciones de masa puntual en los diversos valores del rango, y la clase de eventos determinada por una variable aleatoria simple se describe en términos de la partición generada porX (es decir, la clase de esos eventos de la forma Ai=[X=ti]para cada unoti en el rango). La situación es conceptualmente la misma para el caso general, pero los detalles son más complicados. Si la variable aleatoria toma un continuo de valores, entonces la distribución de la masa de probabilidad se puede extender suavemente en la línea. O bien, la distribución puede ser una mezcla de concentraciones de masa puntual y distribuciones suaves en algunos intervalos. La clase de eventos determinada porX es el conjunto de todas las imágenes inversasX−1(M) paraM cualquier miembro de una clase general de subconjuntos de subconjuntos de la línea real conocida en la literatura matemática como los conjuntos de Borel. Hay razones técnicas matemáticas para no decir que M es un subconjunto, pero la clase de conjuntos de Borel es lo suficientemente general como para incluir cualquier conjunto que pueda encontrarse en las aplicaciones, ciertamente al nivel de este tratamiento. Los conjuntos de Borel incluyen cualquier intervalo y cualquier conjunto que pueda estar formado por complementos, uniones contables e intersecciones contables de conjuntos de Borel. Este es un tipo de clase conocida como álgebra sigma de eventos. Debido a la preservación de las operaciones de conjunto por la imagen inversa, la clase de eventos determinada por la variable aleatoria tambiénX es un álgebra sigma, y a menudo se designaσ(X). Existen algunas preguntas técnicas sobre la medida de probabilidadPX inducida porX, de ahí la distribución. Estos también se resuelven de tal manera que no hay necesidad de preocupación en este nivel de análisis. Sin embargo, algunas de estas preguntas adquieren importancia para tratar procesos aleatorios y otras nociones avanzadas cada vez más utilizadas en aplicaciones. Dos hechos proporcionan la libertad que necesitamos para proceder con poca preocupación por los detalles técnicos.

X−1(M)es un evento para cada Borel setM iff para cada intervalo semi-infinito(−∞,t] en la línea realX−1((−∞,t]) es un evento.

La distribución de probabilidad inducida se determina únicamente por su asignación a todos los intervalos de la forma(−∞,t].

Estos hechos apuntan a la importancia de la función de distribución introducida en el siguiente capítulo.

Otro hecho, aludido anteriormente y discutido con cierto detalle en el siguiente capítulo, es que cualquier variable aleatoria general puede aproximarse tan estrechamente como complacida por una simple variable aleatoria. Pasamos en el siguiente capítulo a una descripción de ciertas distribuciones de probabilidad comúnmente encontradas y formas de describirlas analíticamente.