5.4: Describir recursos no textuales

- Page ID

- 98115

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

Muchos de los principios y métodos para la descripción de recursos fueron desarrollados para describir recursos de texto en formatos físicos. Esos principios han tenido que evolucionar para lidiar con diferentes tipos de recursos que la gente quiere describir y organizar, desde pinturas y estatuas hasta MP3, JPEG y MPEG.

Algunas descripciones de los recursos no textuales están basadas en texto, y la mayoría de las veces las asignan personas. Otras descripciones están en formatos no textuales se extraen algorítmicamente del contenido del recurso no textual. Estas últimas descripciones de recursos basadas en contenido capturan propiedades técnicas intrínsecas y en algunos dominios son capaces de describir la aproximación con cierta precisión, gracias a los avances en el aprendizaje automático.

Descripción de los recursos museísticos y artísticos

Los problemas asociados con la descripción de los recursos multimedia no son todos nuevos. Los curadores del museo han estado lidiando con ellos desde que comenzaron a recolectar, almacenar y describir artefactos hace cientos de años. Muchos artefactos pueden representar el mismo trabajo (piense en fragmentos de cerámica que alguna vez pudieron haber sido parte del mismo jarrón). Los materiales y formas no transmiten semántica por sí mismos. Sin investigación y descripción adicionales, no sabemos nada del jarrón; no viene con ningún tipo de página de título o etiqueta que lo conecte con un asentamiento maya del siglo IX. Dado que los museos pueden adquirir grandes lotes de artefactos a la vez, tienen que tomar decisiones sobre qué recursos pueden permitirse describir y cuánto pueden describirlos.

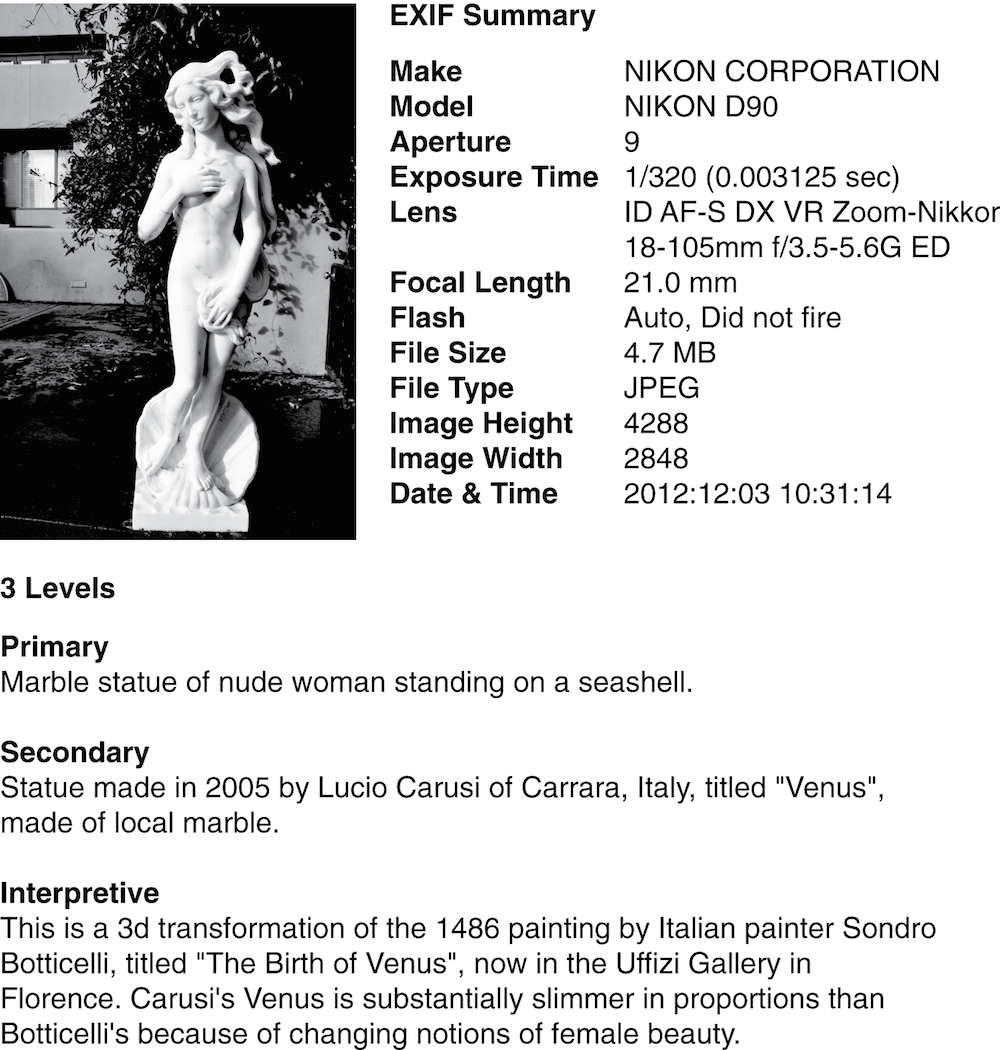

El historiador del arte alemán Erwin Panofsky primero codificó una aproximación a estos problemas de descripción. En su clásico Estudios en Iconología, definió tres niveles de descripción que pueden aplicarse a una obra artística o artefacto museístico. Figura: Descripciones contrastantes para una obra de arte. contrasta estos tres niveles en las descripciones de una estatua de mármol. También muestra las llamativas diferencias entre la descripción EXIF en una foto digital de la estatua y las creadas por las personas. [1]

Los profesionales que crean descripciones de museos y recursos artísticos, arquitectura y otras obras culturales suelen utilizar el Núcleo VRA de la Biblioteca del Congreso, o el Getty Trust Categorías para la Descripción de Obras de Arte (CDWA), un vocabulario masivo controlado con 532 categorías y subcategorías. A [2]

Las descripciones de obras de arte pueden contrastar mucho, especialmente entre las capturadas por un dispositivo como una cámara digital y las creadas por personas. Además, las descripciones creadas por las personas difieren según la experiencia del creador y la cantidad de interpretación subjetiva aplicada en la descripción.

(Foto de R. Glushko. La estatua, titulada “Venus”, fue hecha por Lucio Carusi, de Carrara, Italia, y actualmente forma parte de una colección privada.)

Describiendo imágenes

Las cámaras digitales, incluidas las de los celulares, toman millones de fotos cada día. A diferencia de las imágenes en museos y galerías, la mayoría de estas imágenes reciben pocas descripciones más allá de las creadas por el dispositivo que las hizo. Sin embargo, muchos de ellos terminan con algunas descripciones limitadas en Facebook, Instagram, Flickr, Picasa, DeviantArt, u otros de los numerosos lugares donde la gente comparte imágenes, o en aplicaciones de imagen profesionales como Light Habitación. Todos estos sitios ofrecen algunas facilidades para que los usuarios asignen etiquetas a las imágenes o las organicen en grupos nombrados.

Se han utilizado muchos enfoques computacionales diferentes para describir o clasificar imágenes. Un enfoque utiliza la firma visual de una imagen extraída de características de bajo nivel como el color, la forma, la textura y la luminosidad, que luego se utilizan para distinguir regiones y objetos significativos. La similitud de imagen se calcula para crear categorías de imágenes que contienen los mismos tipos de colores, objetos o configuraciones, lo que facilita la búsqueda de imágenes duplicadas o modificadas. [3]

Para que las computadoras identifiquen objetos específicos o personas en imágenes, es lógicamente necesario entrenarlos con imágenes que ya están identificadas. En 2005 Luis van Ahn ideó una forma inteligente de recopilar grandes cantidades de imágenes etiquetadas con un juego basado en la web llamado ESP que emparejaba aleatoriamente a las personas para sugerir etiquetas o etiquetas para una imagen. Las opciones obvias se eliminaron de la contienda, por lo que una foto de un pájaro contra un cielo azul ya podría golpear a “pájaro” y “cielo” del conjunto de palabras aceptables, dejando a los usuarios sugerir palabras como “volar” y “sin nubes. ” Van Ahn también inventó la técnica reCAPTCHA que presenta imágenes de texto de libros antiguos que se digitalizan, lo que mejora la precisión de la digitalización al tiempo que verifica que el usuario de un sitio web es una persona y no un programa robot. [4]

Sin embargo, si las descripciones de texto cortas o las propiedades de imagen de bajo nivel son las únicas características disponibles para entrenar una imagen, de lo contrario, variaciones irrelevantes en la posición, orientación o iluminación de objetos en las imágenes harán que sea muy difícil distinguir objetos que se vean similares, como un lobo blanco y el perro blanco parecido a un wolfo llamado samoye. Este problema se puede abordar mediante el uso de redes neuronales profundas, que explotan la idea de que las características de imagen de bajo nivel se pueden combinar en muchas capas de otras de nivel superior; los bordes se combinan para formar motivos o patrones, los patrones se combinan para formar partes de objetos familiares y las partes se combinan para formar objetos completos. Esta composición jerárquica permite que las representaciones de más alto nivel se vuelvan insensibles a las variaciones de nivel inferior que plagan los otros enfoques.

En 2012, cuando se aplicaron técnicas de aprendizaje profundo a un conjunto de datos de alrededor de un millón de imágenes que contenían mil categorías de objetos diferentes, redujeron la tasa de error a la mitad. Este espectacular avance, y el hecho de que las técnicas de aprendizaje profundo que derivan capas de entidades a partir de los datos de entrada son completamente generales, rápidamente hicieron que el aprendizaje profundo se aplicara a muchos otros dominios con datos de alta dimensión. Facebook usa el aprendizaje profundo para identificar a las personas en las fotos, Google lo usa para el reconocimiento de voz y la traducción de idiomas, y los subtitulado rápidos para imágenes y videos están en el horizonte. Las computadoras portátiles podrían usarlo para colocar información útil en la visión del mundo de las personas, creando realidad aumentada en tiempo real. [5]

Describiendo la música

Describir la música presenta retos muy diferentes a los involucrados en la descripción de textos o imágenes. Los poemas y las pinturas son cosas tangibles que podemos mirar y contemplar, mientras que la naturaleza auditiva de la música hace que se trate de un fenómeno fugaz que sólo se puede experimentar en el momento performativo. Incluso las partituras y grabaciones musicales, aunque tanto cosas tangibles como pinturas y poemas, son meramente contenedores que tienen el potencial para la experiencia musical y no la música en sí. La mayoría de la música popular contemporánea es en forma de canciones, en las que los textos se fijan a una melodía y se apoyan en armonías instrumentales. Si queremos categorizar o describir dicha música por su contenido lírico, aún podemos confiar en métodos para describir textos. Pero si queremos describir la música en sí, necesitamos adoptar un enfoque algo diferente.

Varias personas y empresas que trabajan en multimedia han explorado diferentes procesos para describir las canciones. En el lado fuertemente tecnológico, aplicaciones de software como Shazam y Midomi pueden crear una huella digital de audio basada en contenido a partir de un fragmento de música. Las huellas digitales de audio representan una descripción digital de una pieza musical, que una computadora puede interpretar y comparar con otras descripciones digitales en una biblioteca. [6]

A primera vista, los servicios de streaming de música contemporánea representan el ápice de la clasificación y descripción de la música. Pandora, por ejemplo, emplea musicólogos capacitados para escuchar la música y luego categorizar los géneros y materiales musicales de acuerdo con un vocabulario musical altamente controlado. El algoritmo resultante, el “Genoma de la Música”, puede esencialmente aprender a definir los gustos musicales de un oyente mediante este etiquetado musical, y luego puede usar esa información para sugerir otra música con características similares. [7]

Pero los músicos han estado pensando en cómo describir la música durante siglos, y aunque el Genoma Musical ciertamente rebosa de complejidad, palidece en comparación con la sofisticación de los métodos mucho más antiguos de “pluma-y-papel” de los que deriva. La etnomusicología (definida vagamente como el estudio de las prácticas musicales globales en sus contextos sociales) ha logrado posiblemente mayores avances hacia descripciones integrales de los recursos musicales que cualquier otro campo de estudio musicológico. Desde finales del siglo XIX, los etnomusicólogos han creado complejos métodos de notación y taxonomías estilísticas para capturar y categorizar la música de culturas occidentales y no occidentales.

El compositor y erudito húngaro Béla Bartók recopiló y transcribió miles de canciones folclóricas de Europa del Este a las que aplicó un complejo sistema de clasificación para agruparlas en “familias” derivadas de arquetipos melódicos. Más recientemente, el proyecto Cantometrics del etnomusicólogo estadounidense Alan Lomax clasificó canciones recopiladas de alrededor de la palabra de acuerdo con 37 factores de estilo en un esfuerzo por crear un vocabulario común controlado que facilitara la comparación intercultural y análisis. [8]

A un nivel más granular, los músicos son infinitamente innovadores en encontrar formas de categorizar, describir y analizar no solo géneros musicales a gran escala, sino las propias notas. En la foto acompañante que muestra la colección discográfica del DJ profesional “Kid Kameleon”, vemos que los discos están arreglados no simplemente por género, sino también por latidos por minuto (BPM). Para Kid Kameleon, estos discos representan los recursos de su proceso creativo musical, y organizarlos por BPM le permite sacar exactamente el material musical correcto que necesita para mantener la música fluyendo durante una actuación. Su sistema de clasificación es, por lo tanto, una taxonomía que pasa de los trazos amplios del género a los granos finos de arreglos específicos de notas y ritmos. Esta foto no es simplemente una imagen de una colección de discos: es una representación visual del proceso creativo de un artista. [9]

Video descriptivo

El video es otro dominio de recursos donde se trabaja para crear descripciones de recursos para que la búsqueda sea más efectiva está en curso. Las técnicas de análisis de video pueden segmentar un video en clips más cortos descritos de acuerdo con su color, dirección de movimiento, tamaño de los objetos y otras características. Identificar eventos anómalos y rostros de personas en video tiene aplicaciones obvias en seguridad y vigilancia. [10] Identificar detalles específicos de contenido sobre un video actualmente requiere una cantidad significativa de intervención humana, aunque es posible que los algoritmos de coincidencia de firmas de imágenes se hagan cargo en el futuro porque permitirían la colocación automatizada de anuncios en videos y televisión. [11]

-

(Panofsky 1972) propone estos tres niveles de descripción:

- Materia primaria

En este nivel, describimos los elementos más básicos de una obra de manera genérica que sería reconocible por cualquier persona independientemente de su experiencia o capacitación. El cuadro La última cena, por ejemplo, podría describirse como “13 personas cenando. ”

- Materia secundaria

Aquí, introducimos un nivel de comprensión cultural básica en una descripción. Alguien familiarizado con una interpretación común de la Biblia, por ejemplo, ahora podría ver La Última Cena como la representación de Jesús rodeado de sus discípulos.

- Significado o interpretación intrínseca

En este nivel entran en juego el contexto y la comprensión más profunda —incluyendo lo que el creador de la descripción sabe sobre la situación en la que se creó la obra. ¿Por qué, por ejemplo, este artista en particular creó esta representación particular de La Última Cena de esta manera? Panofsky planteó que aquí se necesitan historiadores profesionales del arte, porque son ellos los que tienen la educación y los antecedentes necesarios para sacar sentido de una obra.

En otras palabras, Panofsky vio la necesidad de muchos tipos diferentes de descriptores —incluyendo físicos, culturales y contextuales — para trabajar juntos al hacer una descripción completa de un artefacto.

-

Para (Harpring2009) en

http://www.getty.edu/research/publications/electronic_publications/cdwa/.Para (Getty2006) en

http://www.getty.edu/research/publications/electronic_publications/cdwa/cdwalite.pdf.

-

Ver (Datta et al. 2008). La empresa Idée está desarrollando una variedad de algoritmos de búsqueda de imágenes, que utilizan firmas de imagen y medidas de similitud visual para devolver fotos similares a las que un usuario pide ver.

-

(von Ahn y Dabbish 2008).

-

La idea clave que hizo posible el aprendizaje profundo es el uso de la “retropropagación” para ajustar los pesos en las entidades trabajando hacia atrás desde la salida (la clasificación de objetos producida por la red) hasta la entrada. Los lectores matemáticamente sofisticados pueden encontrar una explicación concisa y una historia del aprendizaje profundo en (LeCun, Bengio y Hinton 2015). LeCun y Hinton formaron parte de equipos de investigación que inventaron independientemente la retropropagación a mediados de la década de 1980. Hoy, LeCun encabeza el grupo de investigación de Facebook sobre inteligencia artificial, y Hinton tiene un papel similar en Google.

-

(Cano et al. 2005).

-

(Walker 2009).

-

El método de Bartók para transcribir y categorizar cada melodía en familias fue el siguiente:

-

Todas las melodías terminan en la nota “g” para facilitar la comparación;

-

Las melodías se dividen y categorizan según el número de líneas;

-

Las melodías se clasifican de acuerdo con la colocación de la nota final de varias líneas de afinación con la nota final indicada por figuras;

-

Los subgrupos se clasifican de acuerdo con el número de sílabas a cada línea de afinación;

-

Las melodías se clasifican de acuerdo a su brújula melódica con la nota más baja y más alta de cada melodía etiquetada.

No es difícil ver los paralelismos de este método con el algoritmo Pandora, así como el mayor nivel de detalle descriptivo que brinda el método de Bartók. Véase (Bartók 1981).

Cada colección de canciones folclóricas contiene varios ejemplos de la misma canción interpretada en varias ocasiones por el mismo cantante o por muchos cantantes diferentes. A menudo estas diferentes canciones (o “variantes”) son tan drásticamente diferentes que comenzamos a hacernos la pregunta: “¿En qué momento una variante se convierte en una pieza musical completamente nueva? ” Hasta principios del siglo XX, muchos estudiosos creían que las variantes eran simplemente malas interpretaciones de cantantes folclóricos que intentaban recrear una versión prístina y arquetípica de la canción.

No fue hasta que el coleccionista australiano Percy Grainger sugirió que las variantes representaban una práctica escénica vital y dinámica entre los cantantes folclóricos que la idea de variantes como arquetipos defectuosos dio paso a una en la que todas las actuaciones eran entidades únicas para ellos mismos que poseen lo que Wittgenstein eventualmente denominaría “semejanzas familiares” entre sí. (Grainger 1908)

Más recientemente, la revista Newsweek compiló una lista de 60 versiones diferentes de “Hallelujah” de Leonard Cohen, muchas de las cuales difieren tan drásticamente del original de Cohen que parecen ser canciones completamente diferentes con solo la familia más rudimentaria semejanzas. ¿Ya existe “Aleluya” como “obra”? ¿O es simplemente una idea, un potencial para la música que solo existe durante cada interpretación variada? (

http://www.newsweek.com/60-versions-leonard-cohens-hallelujah-ranked-303580).

-

-

Este método de organización de recursos musicales de fácil acceso (física y cognitivamente) es uno que tiene a la vez un pasado ilustre y un futuro fascinante. El musicólogo Robert Gjerdingen ha estudiado la forma en que los compositores del Nápoles del siglo XVIII aprendieron su arte estudiando un sistema organizado de esquemas musicales que podrían expandirse, ensartarse y variarse para crear una serie interminable de agradables composiciones en el estilo galant de la época (Gjerdingen 2007). Un acercamiento actual a esta misma idea se puede encontrar en la obra del compositor David Cope, cuyo software Experiments in Musical Intelligence (“Emmy” y la próxima generación “Emily Howell”) puede analizar la música existente, romper su recursos musicales en esquema identificable, y luego recombinar esos esquemas para crear una salida musical al estilo de la entrada musical original (Cope 2001). Emmy puede recombinar estos elementos en millones de formas diferentes para producir obras convincentes, convincentes y algo desconcertantes al estilo de cualquier compositor cuya música le haya sido alimentada. Por diferentes que todos puedan parecer, los napolitanos del siglo XVIII, Kid Kameleon y Emmy representan un proceso creativo que depende de la entrada, descripción, organización, recombinación y salida de los recursos musicales.

-

(Regazzoni et al. 2010) presentan un número especial en IEEE Signal Processing sobre análisis visual.

-

Una organización que ve un futuro en el montaje de mejores descripciones de contenido de video es la Liga Nacional de Fútbol de Estados Unidos ((Buhrmester 2007).