4.5: Pruebas de detención aleatoria

( \newcommand{\kernel}{\mathrm{null}\,}\)

Visualizar realizando un experimento repetidamente, observando salidas de muestra sucesivas independientes de una variable aleatoria dada (es decir, observando un resultado de muestra deX1,X2,… dondeXi están IID). El experimento se detiene cuando se han acumulado suficientes datos para los fines en cuestión.

Este tipo de situación ocurre con frecuencia en las aplicaciones. Por ejemplo, podríamos estar obligados a elegir entre varias hipótesis, y podríamos repetir un experimento hasta que las hipótesis sean suficientemente discriminadas. Si se permite que el número de ensayos dependa del resultado, el número medio de ensayos requeridos para lograr una probabilidad de error dada suele ser una pequeña fracción del número de ensayos requeridos cuando el número se elige de antemano. Otro ejemplo ocurre en las búsquedas de árboles donde se explora un camino hasta que otras extensiones del camino parecen no ser rentables.

El primer estudio cuidadoso de situaciones experimentales donde el número de ensayos depende de los datos fue realizado por el estadístico Abraham Wald y condujo al campo del análisis secuencial (ver [21]). Estudiamos estas situaciones ahora ya que uno de los principales resultados, la igualdad de Wald, será útil para estudiarE[N(t)] en la siguiente sección. La detención de ensayos suele ser útil en el estudio de procesos aleatorios, y en particular se utilizará en la Sección 4.7 para el análisis de colas, y nuevamente en el Capítulo 7 como temas centrales en el estudio de Caminatas aleatorias y martingales.

Una parte importante de los experimentos que se detienen después de un número aleatorio de ensayos es la regla para detenerse. Dicha regla debe especificar, para cada ruta de muestreo, el ensayo en el que se detiene el experimento, es decir, el juicio final después del cual no se realizan más ensayos. Por lo tanto, la regla para detener debe especificar una variable aleatoria positiva, de valor enteroJ, llamada tiempo de detención, o detención de prueba, mapeando rutas de muestra a este ensayo final en el que se detiene el experimento.

Consideramos que el espacio muestral incluye el conjunto de secuencias de valores de muestra para la secuencia interminable de variables aleatoriasX1,X2,…. Es decir, aunque el experimento se detenga al final del segundo ensayo, aún se visualizan las variables aleatorias 3º, 4º,. como que tienen valores de muestra como parte de la función de muestra. Es decir, visualizamos que el experimento continúa para siempre, pero que el observador deja de mirar al final del punto de parada. Desde el punto de vista de las aplicaciones, el experimento podría o no continuar después de que el observador deje de mirar. Desde un punto de vista matemático, sin embargo, es muy preferible ver el experimento como continuo. Esto evita confusión y ambigüedad sobre el significado de IID rv cuando la existencia misma de variables posteriores depende de valores de muestra anteriores.

La noción intuitiva de detener un experimento secuencial debe implicar detenerse en función de los datos (es decir, los valores de la muestra) recopilados hasta e incluyendo el punto de parada. Por ejemplo, siX1,X2,…, representan los cambios sucesivos en nuestra fortuna al apostar, es posible que queramos detenernos cuando nuestra ganancia acumulada supere algún valor fijo. El ensayo de detenciónn entonces depende de los valores de muestra deX1,X2,…,Xn. Al mismo tiempo, queremos excluir de detener los ensayos aquellas reglas que permitan al experimentador echar un vistazo a los valores posteriores antes de tomar la decisión de detenerse o no. 8 Esto lleva a la siguiente definición.

Un ensayo de detención (o tiempo de detención 9) J para una secuencia de rvX1,X2,…, es un rv de valor entero positivo tal que para cada unon≥1, el indicador rvI{J=n} es una función de{X1,X2,…,Xn}.

La última cláusula de la definición significa que cualquier valor de muestra dadox1,…,xn para determina deX1,…,Xn manera única si el valor de muestra correspondiente deJ se define como un rv de valor entero positivo, los eventos{J=n} y{J=m} param<n son eventos disjuntos, por lo que se detiene en el juicio mhace imposible detenerse también enn para una ruta de muestra dada. También la unión de los eventos{J=n} sobren≥1 tiene probabilidad 1. Aparte de esta restricción final, la definición no depende de la medida de probabilidad y depende únicamente del conjunto de eventos{J=n} para cada unon. En muchas situaciones, es útil relajar aún más la definiciónJ para permitir que sea un rv posiblemente defectuoso. En este caso la cuestión de si la detención ocurre con probabilidad 1 puede posponerse hasta después de especificar los eventos disjuntos{J=n} terminadosn≥1.

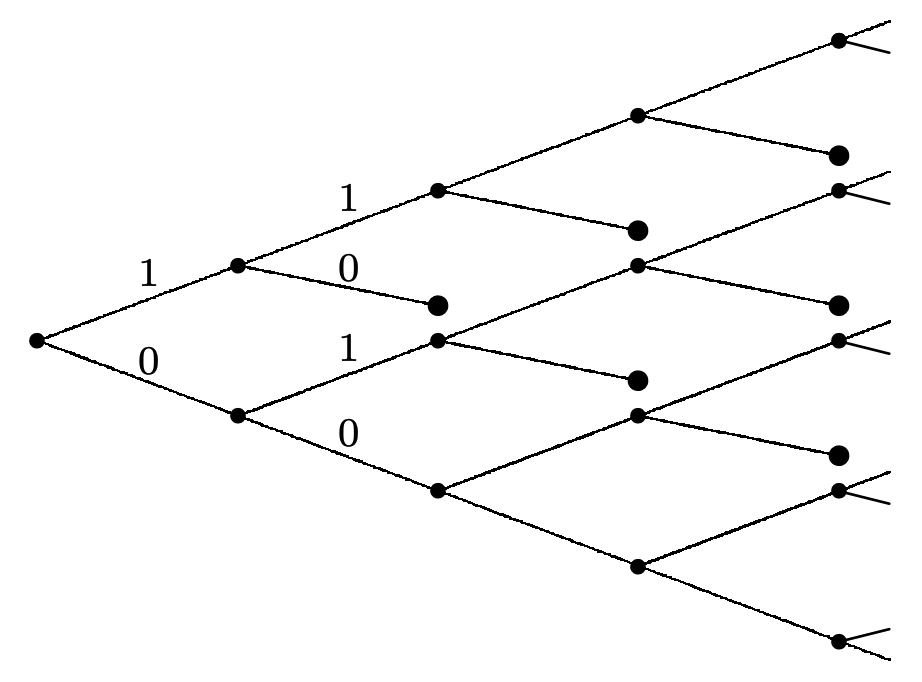

Considera un proceso de Bernoulli{Xn;n≥1}. Una prueba de detención muy simple para este proceso es detenerse en la primera aparición de la cadena (1, 0). La Figura 4.11 ilustra este ensayo de detención viéndolo como un truncamiento del árbol de posibles secuencias binarias.

El evento{J=2}, es decir, el evento que se detiene ocurre en el juicio 2, es el evento{X1=1,X2=0}. De igual manera, el evento{J=3} es{X1=1,X2=1,X3=0}⋃{X1=0,X2=1,X3=0}. La desarticulación de{J=n} y{J=m} paran≠m se representa en la figura terminando el árbol en cada nodo de parada. Se puede ver que el árbol nunca muere por completo, y de hecho, para cada prueban, el número de nodos de detención esn−1. Sin embargo, la probabilidad de que la detención no haya ocurrido por ensayon va a cero exponencialmente conn, lo que asegura queJ es una variable aleatoria.

La representación de una regla de detención por un árbol podado se puede utilizar para cualquier secuencia aleatoria discreta, aunque el árbol se vuelve bastante difícil de manejar en todos los casos menos triviales. Visualizar una regla de detención en términos de un árbol podado es útil conceptualmente, pero las reglas de detención generalmente se establecen en otros términos. Por ejemplo, en breve consideramos un juicio de detención para los intervalos entre llegadas de un proceso de renovación como el primeron para el cual la época de llegadaSn satisfaceSn>t para algunos dadost>0.

La igualdad de Wald

Una cuestión importante que surge con la detención de los ensayos es evaluar la sumaSJ de las variables aleatorias hasta el ensayo de detención, es decir,SJ=∑Jn=1Xn. Muchas estrategias de juego y estrategias de inversión implican algún tipo de regla sobre cuándo parar, y es importante entender el rvSJ (que puede modelar la ganancia o pérdida general hasta ese juicio). La igualdad de Wald es muy útil para ayudar a encontrarE[SJ].

Dejar{Xn;n≥1} ser una secuencia de IID rv, cada uno de mediaˉX. SiJ es un juicio de detención para{Xn;n≥1} y siE[J]<∞, entonces la sumaSJ=X1+X2+⋯+XJ en el juicio de detenciónJ satisface

E[SJ]=ˉXE[J]

- Prueba

-

Tenga en cuenta queXn se incluye enSJ=∑Jn=1Xn cuandon≤J, es decir, siempre que la función indicadora n=1I{J≥n}=1. Así

SJ=∞∑n=1XnI{J≥n}

Esto incluyeXn como parte de la suma si la detención no ha ocurrido antes del juicion. El evento{J≥n} es el complemento de{J<n}={J=1}⋃⋯⋃{J=n−1}. Todos estos últimos eventos están determinados porX1,…,Xn−1 y, por lo tanto, son independientes deXn. De ello se deduce queXn y{J<n} son independientes y por lo tantoXn y también{J≥n} son independientes. 10 Así

E[XnI{J≥n}]=ˉXE[I{J≥n}]

Entonces tenemos

\ [\ begin {alineado}

\ mathrm {E}\ izquierda [S_ {J}\ derecha] &=\ mathrm {E}\ izquierda [\ sum_ {n=1} ^ {\ infty} X_ {n}\ mathbb {I} _ _ {\ {J\ geq n\}}\ derecha]\\

&=\ sum_ {n=1} ^ {\ infty}\ mathrm {E}\ izquierda [X_ {n}\ mathbb {I} _ {\ {J\ geq n\}}\ derecha]\ quad (4.32)\\

&=\ sum_ {n=1} ^ {\ infty}\ bar { X}\ mathrm {E}\ izquierda [\ mathbb {I} _ {\ {J\ geq n\}}\ derecha]\\

&=\ bar {X}\ mathrm {E} [J]. \ quad\ quad\ quad\ quad\ quad (4.33)

\ end {alineado}\ nonumber\]El intercambio de expectativa y suma infinita en\ ref {4.32} es obviamente válido para una suma finita, y se muestra en el Ejercicio 4.18 como válido para una suma infinita siE[J]<∞. El siguiente ejemplo muestra que la igualdad de Wald puede ser inválida cuandoE[J]=∞. El último paso anterior viene de la observación de queE[I{J≥n}]=Pr{J≥n}. Dado queJ es un número entero positivo rv,E[J]=∑∞n=1Pr{J≥n}. También se puede obtener el último paso utilizandoJ=∑∞n=1I{J≥n} (ver Ejercicio 4.13).

Lo que este resultado esencialmente dice en términos de juego es que las estrategias para cuándo dejar de apostar no son realmente efectivas en lo que a la media se refiere. Esto a veces parece obvio y a veces parece muy sorprendente, dependiendo de la aplicación.

Podemos modelar un juego de lanzamiento de monedas (sesgado) como una secuencia de IID rvX1,X2,… donde cada unoX es 1 con probabilidadp y −1 con probabilidad1−p. Considere el juicio de detención posiblemente defectuosoJ dondeJ está el primeron para el cualSn=X1+⋯+Xn=1, es decir, el primer juicio en el que el jugador está por delante.

Primero queremos ver siJ es un rv, es decir, si la probabilidad de una eventual parada, digamosθ=Pr{J<∞}, es 1. Esto lo resolvemos con un truco frecuentemente útil, pero usaremos otros enfoques más sistemáticos en los Capítulos 5 y 7 cuando veamos este mismo ejemplo como una cadena de Markov de nacimiento-muerte y luego como una simple caminata aleatoria. Obsérvese quePr{J=1}=p, es decir,S1=1 con probabilidadp y parada ocurre en el ensayo 1. Con probabilidad1−p,S1=−1. A continuaciónS1=−1, la única manera de llegar a ser uno adelante es volver primero aSn=0 para algunosn>1, y, después del primer regreso de ese tipo, pasar aSm=1 en algún juicio posteriorm. La probabilidad de pasar eventualmente de -1 a 0 es la misma que la de ir de 0 a 1, es decir,θ. También, dado un primer retorno a 0 de -1, la probabilidad de llegar a 1 de 0 esθ. Por lo tanto,

θ=p+(1−p)θ2.

Esta es una ecuación cuadráticaθ con dos soluciones,θ=1 yθ=p/(1−p). Porquep>1/2, la segunda solución es imposible ya queθ es una probabilidad. Así concluimos queJ es un rv. Parap=1/2 (y este es el caso más interesante), ambas soluciones son las mismas,θ=1, y de nuevoJ es un rv. Parap<1/2, la solución correcta 11 esθ=p/(1−p). θ<1AsíJ es un rv defectuoso.

Para los casos dondep≥1/2, es decir, dondeJ es un rv, podemos usar el mismo truco para evaluarE[J],

E[J]=p+(1−p)(1+2E[J])

La solución a esto es

E[J]=12(1−p)=12p−1

Vemos queE[J] es finito parap>1/2 e infinito parap=1/2.

Puesp>1/2, podemos comprobar que estos resultados concuerdan con la igualdad de Wald. En particular, ya queSJ es 1 con probabilidad 1, también tenemosE[SJ]=1. DesdeˉX=2p−1 yE[J]=1/(2p−1), la igualdad de Wald está satisfecha (que por supuesto tiene que ser).

Parap=1/2, todavía tenemosSJ=1 con probabilidad 1 y asíE[SJ]=1. Sin embargoˉX=0 así noˉXE[J] tiene sentido y la igualdad de Wald se rompe. Así vemos que efectivamente se necesita la restricciónE[J]<∞ en la igualdad de Wald. Estos resultados se tabulan a continuación.

\ (\ begin {array} {|r||ccc|}

& p>\ frac {1} {2} & p=\ frac {1} {2} & p<\ frac {1} {2}\

\ hline\ nombreoperador {Pr}\ {J<\ infty\} &\ frac {p} {1-p} & 1\\

\ mathrm {E} [J] &\ infty &\ infty &\ frac {1} {2 p-1}\\

\ hline

\ end {array}\)

Es sorprendente que conp=1/2, el jugador eventualmente pueda convertirse en uno por delante con probabilidad 1. Esto tiene poco valor práctico, primero porque el número esperado requerido de ensayos es infinito, y segundo (como se verá más adelante) porque el jugador debe arriesgar un capital potencialmente infinito.

Aplicando la igualdad de Wald a m (t) =E [N (t)]

{Sn;n≥1}Dejen ser las épocas de llegada y{Xn;n≥1} los intervalos entre llegadas para un proceso de renovación. Para cualquier dadot>0, dejeJ ser el juicion por el queSn primero rebaset. Tenga en cuenta quen se especifica por los valores de muestra de{X1,…,Xn} y por lo tantoJ es un ensayo de detención posiblemente defectuoso para{Xn;n≥1}.

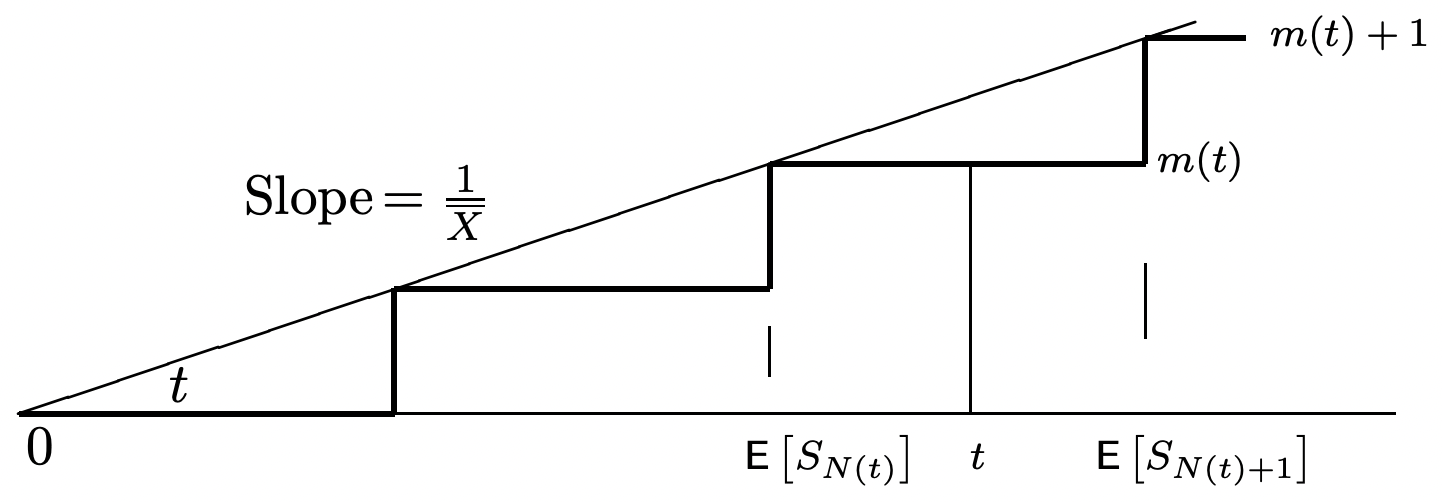

Ya quen es el primer juicio para el cualSn>t, vemos queSn−1≤t ySn>t. AsíN(t) esn−1 yn es el valor muestral deN(t)+1. Dado que esto es cierto para todas las secuencias de muestra,J=N(t)+1. Ya queN(t) es un rv no defectuoso, tambiénJ es, también loJ es una prueba de detención para{Xn;n≥1}.

Entonces podemos emplear la igualdad de Wald para obtener

E[SN(t)+1]=ˉXE[N(t)+1]=ˉX[m(t)+1]

m(t)=E[SN(t)+1]ˉX−1

Como suele ocurrir con la igualdad de Wald, esto proporciona una relación entre dos cantidades,m(t) yE[SN(t)+1], que son ambas desconocidas. Esto se utilizará para probar el teorema de renovación elemental por delimitación superior e inferiorE[SN(t)+1]. El límite inferior es fácil, ya queE[SN(t)+1]≥t, y asím(t)≥t/ˉX−1. De ello se deduce que

m(t)t≥1ˉX−1t

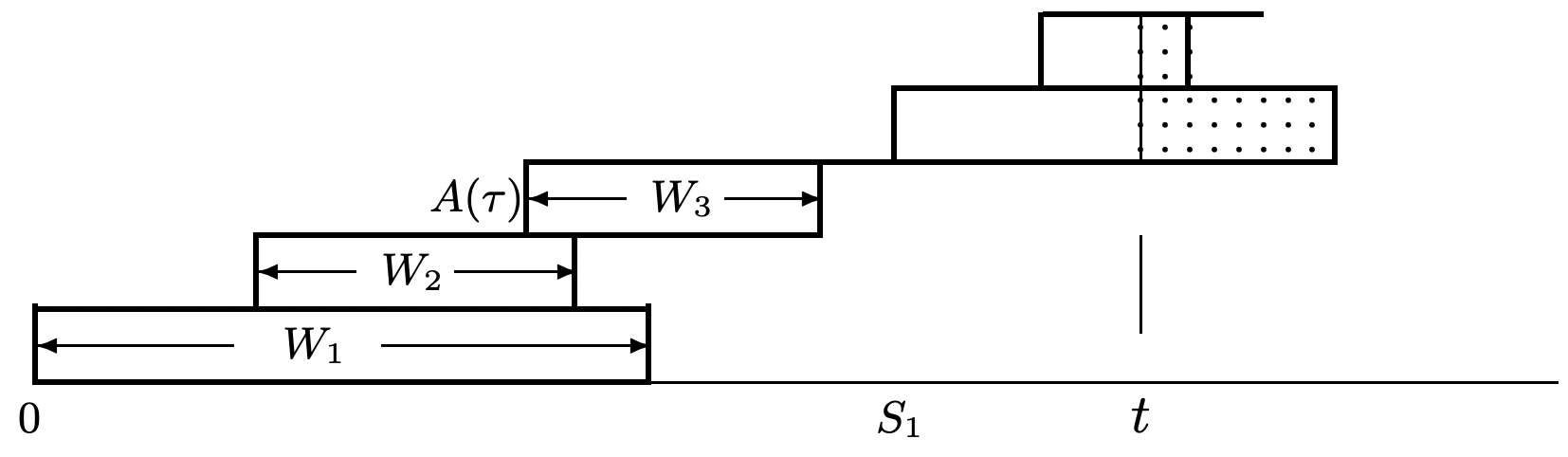

Derivamos un límite superiorE[SN(t)+1] en la siguiente sección. Primero, sin embargo, como un santity check, considere la Figura 4.12 que ilustra\ ref {4.35} para el caso donde cada unoXn es un rv determinista dondeXn=ˉX con probabilidad 1.

Podría ser desconcertante por qué usamosN(t)+1 más queN(t) como un juicio de detención para las épocas{Si;i≥1} en esta aplicación de la igualdad de Wald. Para entender esto, supongamos por ejemplo esoN(t)=n. Cuando un observador ve los valores de muestra deS1,…,Sn, conSn<t, el observador normalmente no puede decir (sobre la base deS1,…,Sn solo) si ocurrirá alguna otra llegada en el intervalo(Sn,t]. En otras palabras,N(t)=n implica esoSn≤t, peroSn<t no implica esoN(t)=n. Por otro lado, aun asumiendoN(t)=n, un observador que veS1,…,Sn+1 lo sabeN(t)=n.

Cualquier ensayo de detención (para una secuencia arbitraria de rv{Sn;n≥1}) puede verse como un experimento donde un observador ve valores de muestras1,s2,…, a su vez hasta que se cumpla la regla de detención. La regla de detención no permite ni mirar hacia adelante ni retroceder para cambiar una decisión anterior. Así la regla: detener enN(t)+1 (para las épocas de renovación{Sn;n≥1}) significa detener en el primer valor de muestraSi que excedet. Nosn≤t es necesariamente posible detenerse en el valor final de la muestra sin mirar hacia el siguiente valor de muestra.

Detener pruebas, renovaciones integradas y colas G/G/1

La definición anterior de un juicio de detención es bastante restrictiva ya que se refiere sólo a una sola secuencia de rv. En muchas situaciones de cola, por ejemplo, hay tanto una secuencia de tiempos{Xi;i≥1} de interllegada como una secuencia de tiempos de servicio{Vi;i≥0}. AquíXi está el intervalo entre llegada entre clientei−1 yi, donde se supone que un cliente inicial 0 llega a la hora 0, yX1 es la hora de llegada para el cliente 1. El tiempo de servicio del cliente 0 es entoncesV0 y cada unoVi,i>0 es el tiempo de servicio del cliente ordinario correspondiente. El número de cliente 0 no es ordinario en el sentido de que llega a la hora fija 0 y no se cuenta en el proceso de conteo de llegadas{N(t);t>0}.

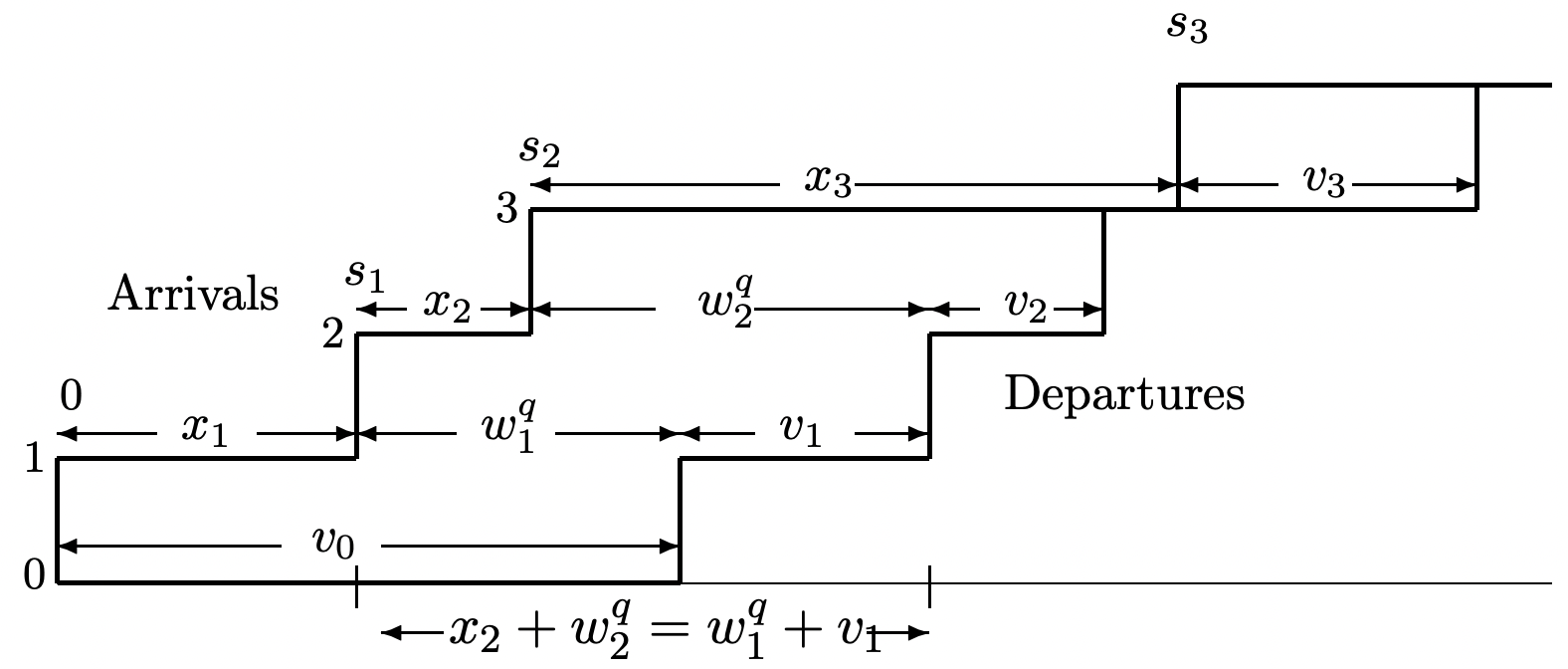

Considere una cola G/G/1 (el caso de servidor único de la cola G/G/m descrito en el Ejemplo 4.1.2). Asumimos que los clientes son atendidos en orden First-Come-First-Servid (FCFS). 12 Se supone que tanto los intervalos entre{Xi;i≥1} llegadas como{Vi;i≥0} los tiempos de servicio son IID y se supone que los tiempos de servicio son independientes de los intervalos entre llegadas. La Figura 4.13 ilustra una ruta de muestreo para estas llegadas y salidas.

La figura ilustra una ruta de muestra para la cualX1<V0, por lo que el número de llegada 1 espera en colaWq1=V0−X1. SiX1≥V0, por otro lado, entonces el cliente uno ingresa al servicio de inmediato, es decir, el cliente uno 've un sistema vacío'. En general, entonces W_1^q=\ max\ left (V_ {0} -X_ {1}, 0\ right). De la misma manera, como se ilustra en la figura, siWq1>0, entonces el cliente 2 esperaWq1+V1−X2 si es positivo y 0 en caso contrario. Esta misma fórmula funciona siWq1=0, asíWq2=max(Wq1+V1−X2,0). En general, se puede ver que

Wqi=max(Wqi−1+Vi−1−Xi,0)

Esta ecuación se analizará más a fondo en la Sección 7.2 donde nos interesa el retraso en la cola y el retardo del sistema. Aquí nuestros objetivos son más simples, ya que solo queremos mostrar que la subsecuencia de llegadas de clientesi para las que{Wqi=0} se satisface el evento forman las épocas de renovación de un proceso de renovación. Para ello, primero observe desde\ ref {4.37} (usando inducción si se desea) queWqi es una función de(X1,…,Xi) y(V0,…,Vi−1). Así, si dejamosJ ser los más pequeñosi>0 para los cualesWqi=0, entoncesIJ=i es una función de(X1,…,Xi) y(V0,…,Vi−1).

Interrumpimos ahora la discusión de las colas G/G/1 con la siguiente generalización de la definición de un juicio de detención.

Un ensayo de parada generalizadaJ para una secuencia de pares de rv(X1,V1),(X2,V2)…, es un rv de valor entero positivo tal que, para cada unon≥1, el indicador rvI{J=n} es una función deX1,V1,X2,V2,…,Xn,Vn.

La igualdad de Wald puede generalizarse trivialmente para estos juicios generalizados de detención.

Dejar{(Xn,Vn);n≥1} ser una secuencia de pares de rv, donde cada par es independiente y distribuido idénticamente (IID) a todos los demás pares. Supongamos que cada unoXi tiene media finitaˉX. SiJ es un juicio de detención para{(Xn,Vn);n≥1} y siE[J]<∞, entonces la sumaSJ=X1+X2+⋯+XJ satisface

E[SJ]=ˉXE[J]

- Prueba

-

Se omitirá la prueba de ello, ya que es la misma que la prueba del Teorema 4.5.1. De hecho, la definición de detener los ensayos podría generalizarse aún más reemplazando los rvVi por rv vectoriales o por un número aleatorio de rv, y la igualdad de Wald aún se mantendría. 13

Para el ejemplo de la cola G/G/1, tomamos la secuencia de pares a ser{(X1,V0),(X2,V1),…,}. Entonces{(Xn,Vn−1;n≥1} satisface las condiciones del Teorema 4.5.2 (suponiendo queE[Xi]<∞. DejarJ ser la regla de detención generalizada especificando el número de la primera llegada para encontrar una cola vacía. Entonces el teorema relataE[SJ], el tiempo esperadot>0 hasta la primera llegada para ver una cola vacía, yE[J], el número esperado de llegadas hasta ver una cola vacía.

Aquí es importante, como en muchas aplicaciones, evitar la confusión creada al verJ como un tiempo de parada. Hemos visto queJ es el número del primer cliente en ver una cola vacía, ySJ es el tiempo hasta que llegue ese cliente.

Existe una posible confusión de tiempo adicional sobre si el tiempo de servicio de un cliente se determina cuando llega el cliente o cuando finaliza el servicio. Esto no hace diferencia, ya que la secuencia ordenada de pares está bien definida y satisface la condición de IID apropiada para usar la igualdad de Wald.

Como suele ocurrir con la igualdad de Wald, no es obvio cómo calcular ninguna cantidad en (4.38), pero es agradable saber que están tan simplemente relacionados. También es interesante ver que, aunque los pares sucesivos(Xi,Vi) se asumen independientes, no es necesarioVi paraXi y ser independientes. Esta falta de independencia no ocurre para la cola G/G/1 (o G/g/M), sino que puede ser útil en situaciones como redes de paquetes donde el tiempo de interllegada entre dos paquetes en un nodo dado puede depender del tiempo de servicio (la longitud) del primer paquete si ambos paquetes provienen del mismo nodo.

Quizás un aspecto más importante de ver la primera renovación para la cola G/G/1 como una prueba de detención es la capacidad de demostrar que las renovaciones sucesivas son de hecho IID. X2,1,X2,2,…Dejen ser los tiempos entre llegadas siguientesJ, la primera llegada para ver una cola vacía. Acondicionamiento encendidoJ=j, tenemosX2,1=Xj+1,X2,2=Xj+2,…,. Así{X2,k;k≥1} es una secuencia IID con la distribución original entre llegadas. Del mismo modo{(X2,k,V2,k);k≥1} es una secuencia de pares IID con la distribución original. Esto es válido para todos los valoresj de muestra del ensayo de detenciónJ. Por lo tanto,{(X2,k,V2,k);k≥1} es estadísticamente independiente deJ y(Xi,Vi);1≤i≤J.

El argumento anterior puede repetirse para las llegadas posteriores a un sistema vacío, por lo que hemos demostrado que las llegadas sucesivas a un sistema vacío en realidad forman un proceso de renovación. 14

Se pueden definir muchas reglas de detención diferentes para las colas, como la primera prueba en la que un número determinado de clientes están en la cola. La igualdad de Wald se puede aplicar a cualquier regla de detención de este tipo, pero se requiere mucho más para que el juicio de detención forme también un punto de renovación. En la primera vez que n clientes están en el sistema, los horarios de salida posteriores dependen en parte de los tiempos de servicio antiguos y en parte de los nuevos tiempos de llegada y servicio, por lo que no existe la independencia requerida para un punto de renovación. Las reglas de detención son útiles para comprender los puntos de renovación incrustados, pero de ninguna manera son equivalentes a los puntos de renovación incrustados.

Por último, nada en el argumento anterior para la cola G/G/1 hizo uso alguno de la disciplina de servicio de la FCFS. Se puede utilizar cualquier disciplina de servicio para la cual la elección de qué cliente servir en un momento dadot se base únicamente en los tiempos de llegada y servicio de los clientes en el sistema por tiempot. De hecho, si el servidor nunca está inactivo cuando los clientes están en el sistema, las épocas de renovación no dependerán de la línea de descripción del servicio. También es posible extender estos argumentos a la cola G/g/m, aunque la disciplina de servicio puede afectar los puntos de renovación en este caso.

Teorema de Little

El teorema de Little es un resultado importante de colas que indica que el número esperado de clientes en un sistema de colas es igual al producto de la tasa de llegada y el tiempo esperado que cada cliente espera en el sistema. Este resultado es cierto bajo condiciones muy generales; utilizamos la cola G/G/1 con el servicio FCFS como ejemplo específico, pero la razón de la mayor generalidad será clara a medida que avancemos. Obsérvese que el teorema no nos dice cómo encontrar ni el número esperado ni la espera esperada; solo dice que si se puede encontrar uno, el otro también se puede encontrar.

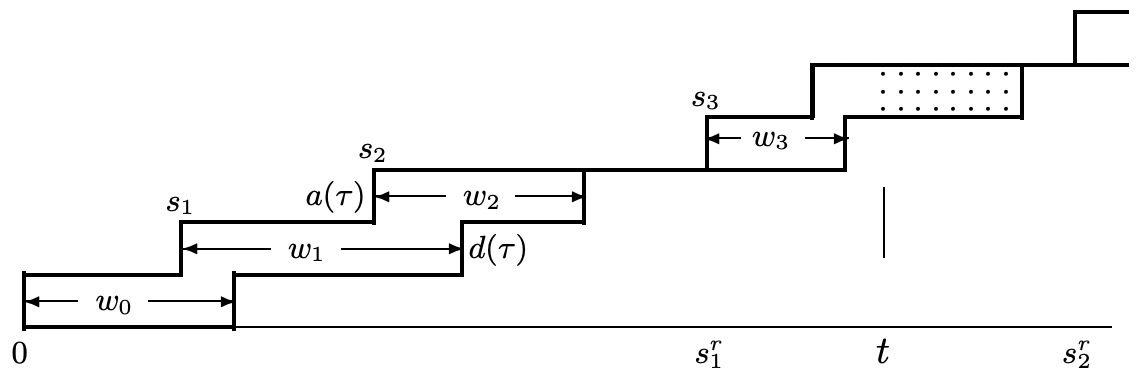

La Figura 4.14 ilustra una ruta de muestra para una cola G/G/1 con servicio FCFS. Ilustra una ruta de muestraa(t) para el proceso de llegadaA(t)=N(t)+1, es decir, el número de llegadas de clientes[0,t], específicamente incluyendo el número de cliente 0 que llega at=0. De igual manera, ilustra el proceso de salidaD(t), que es el número de salidas hasta el tiempot, nuevamente incluyendo al cliente 0. La diferencia,L(t)=A(t)−D(t), es entonces el número en el sistema en el momentot.

Recordemos de la Sección 4.5.3 que la subsecuencia de llegadas de clientes parat>0 que vean un sistema vacío forman un proceso de renovación. En realidad, mostramos un poco más que eso. No solo los intervalos entre renovaciones,Xri=Sri−Sri−1 IID, sino que el número de llegadas de clientes en cada intervalo entre renovaciones son IID, y los intervalos entre llegadas y los tiempos de servicio entre intervalos entre renovaciones son IID. En la figura se muestran los valores muestralessr1 ysr2 de las dos primeras épocas de renovación.

La esencia del teorema de Little se puede ver observando que∫Sr10L(τ)dτ en la figura se encuentra el área entre las funciones de paso superior e inferior, integrada a la primera vez que las dos funciones de paso se vuelven iguales (es decir, el sistema se vuelve vacío). Para el valor de muestra en la figura, esta integral es igual aw0+w1+w2. En cuanto a los rv,

∫Sr10L(τ)dτ=N(Sr1)−1∑i=0Wi

La misma relación existe en cada intervalo entre renovaciones, y en particular podemos definirLn para cada unon≥1 como

Ln=∫SrnSrn−1L(τ)dτ=N(Srn)−1∑i=N(Srn−1)Wi

La interpretación de esto es mucho más sencilla que la notación. La función de paso de llegada y la función de paso de salida en la Figura 4.14 se separan cada vez que hay clientes en el sistema (el sistema está ocupado) y son iguales cuando el sistema está vacío. Las renovaciones ocurren cuando el sistema pasa de vacío a ocupado, por lo que lan renovación es al comienzon del período ocupado. EntoncesLn es el área de la región entre las funciones de dos pasos duranten el período ocupado. Por geometría simple, esta área es también la suma de los tiempos de espera del cliente durante ese período ocupado. Finalmente, dado que los intervalos entre llegadas y los tiempos de servicio en cada periodo ocupado son IID con respecto a aquellos en cada otro periodo ocupadoL1,L2,…, la secuencia, es una secuencia de IID rv.

La funciónL(τ) tiene el mismo comportamiento que una función de recompensa de renovación, pero es un poco más general, siendo una función de más de la edad y duración del proceso de conteo de renovación{Nr(t);t>0} ent=τ. Sin embargo, el hecho de que{Ln;n≥1} sea una secuencia IID nos permite utilizar la misma metodología para tratarL(τ) como se utilizó anteriormente para tratar las funciones de renovación-recompensa. Ahora declaramos y probamos el teorema de Little. La prueba es casi la misma que la del Teorema 4.4.1, por lo que no vamos a detenernos en ella.

Para una cola FCFS G/G/1 en la que el intervalo entre renovaciones esperado es finito, el número medio de tiempo límite de clientes en el sistema es igual, con probabilidad 1, a una constante denotada como¯L. El tiempo de espera promedio de ruta de muestra por cliente también es igual, con probabilidad 1, a una constante denotada como¯W. Finalmente,¯L=λ¯W dóndeλ está la tasa de llegada del cliente, es decir, la recíproca del tiempo interllegada esperado.

- Prueba

-

Tenga en cuenta que para cualquierat>0, se∫t0(L(τ)dτ puede expresar como la suma sobre los períodos ocupados completados antest más un término residual que involucra el período ocupado incluyendot. El término residual puede estar delimitado por la parte superior por la integral durante ese período completo ocupado. Usando esto con (4.40), tenemos

Nr(t)∑n=1Ln≤∫tτ=0L(τ)dτ≤N(t)∑i=0Wi≤Nr(t)+1∑n=1 Ln

Suponiendo que el intervalo entre renovaciones esperadoE[Xr],, es finito, podemos dividir ambos lados de\ ref {4.41} port e ir al límitet→∞. Del mismo argumento que en el Teorema 4.4.1,

limt→∞∑N(t)i=0Wit=limt→∞∫tτ=0L(τ)dτt=E[Ln]E[Xr] with probability 1

La igualdad de la derecha muestra que el promedio de tiempo limitante deL(τ) existe con probabilidad 1 y es igual a¯L=E[Ln]/E[Xr]. La cantidad a la izquierda de\ ref {4.42} ahora se puede dividir como tiempo de espera por cliente multiplicado por el número de clientes por unidad de tiempo, es decir,

limt→∞∑N(t)i=0Wit=limt→∞∑N(t)i=0WiN(t)limt→∞N(t)t

De (4.42), el límite en el lado izquierdo de\ ref {4.43} existe (y es igual a¯L) con probabilidad 1. El segundo límite a la derecha también existe con probabilidad 1 por la ley fuerte para los procesos de renovación, aplicada a{N(t);t>0}. Este límite se denomina tasa de llegadaλ, y es igual al recíproco del intervalo medio entre llegadas para{N(t)}. Dado que estos dos límites existen con probabilidad 1, el primer límite a la derecha, que es el tiempo de espera promedio de ruta de muestra por cliente, denotado¯W, también existe con probabilidad 1.

Al revisar esta prueba y el desarrollo de la cola G/G/1 antes del teorema, vemos que hubo una idea simple, expresada por (4.39), combinada con mucha complejidad notacional debido a que estábamos tratando tanto con un proceso de conteo de llegadas como con un proceso{N(t);t>0} de conteo de renovación incrustado {Nr(t);t>0}. Lo difícil, matemáticamente, fue mostrar que en realidad{Nr(t);t>0} es un proceso de renovación y mostrar que losLn son IID, y aquí era donde necesitábamos entender las reglas de detención.

Recordemos que asumimos antes que los clientes partieron de la cola en el mismo orden en el que llegaron. De la Figura 4.15, sin embargo, es claro que no se requiere orden FCFS para el argumento. Así el teorema se generaliza a sistemas con múltiples servidores y disciplinas de servicio arbitrarias en las que los clientes no siguen el orden FCFS. De hecho, todo lo que el argumento requiere es que el sistema tenga renovaciones (que son IID por definición de renovación) y que el intervalo entre renovaciones sea finito con probabilidad 1.

Figura 4.15: Llegadas y salidas en sistemas no FCFS. El servidor, por ejemplo, podría funcionar simultáneamente (a una tarifa reducida) en todos los clientes del sistema, y así completar el servicio para clientes con pequeñas necesidades de servicio antes de completar llegadas antes con mayores necesidades de servicio. Tenga en cuenta que el borde derecho dentado del diagrama no representa el número de desaparaturas, pero esto no es esencial para el argumento.

Figura 4.15: Llegadas y salidas en sistemas no FCFS. El servidor, por ejemplo, podría funcionar simultáneamente (a una tarifa reducida) en todos los clientes del sistema, y así completar el servicio para clientes con pequeñas necesidades de servicio antes de completar llegadas antes con mayores necesidades de servicio. Tenga en cuenta que el borde derecho dentado del diagrama no representa el número de desaparaturas, pero esto no es esencial para el argumento.Por ejemplo, si se da mayor prioridad a los clientes con tiempos de servicio pequeños, entonces no es difícil ver que se disminuirá el número promedio de clientes en el sistema y el tiempo de espera promedio por cliente. Sin embargo, si el servidor siempre está ocupado cuando hay trabajo por hacer, se puede ver que los tiempos de renovación no se ven afectados. Los discipinos de servicio se discutirán más a fondo en la Sección 5.6.

El mismo argumento que en el teorema de Little se puede utilizar para relacionar el número promedio de clientes en una sola cola de servidor (sin contar el servicio) con la espera promedio en la cola (sin contar el servicio). Las renovaciones aún ocurren en las llegadas a un sistema vacío, y la integral de los clientes en cola durante un período ocupado sigue siendo igual a la suma de los tiempos de espera de la cola. DejarLq(t) ser el número en la cola en el momentot y dejarˉLq=limt→∞(1/t)∫t0Lq(τ)dτ ser la espera de cola promedio de tiempo. Dejando¯Wq ser el tiempo de espera promedio de ruta de muestra en cola,

¯Lq=λ¯Wq

El mismo argumento también se puede aplicar a la instalación de servicio de una sola cola de servidor. El promedio de tiempo del número de clientes en el servidor es solo la fracción de tiempo que el servidor está ocupado. Denotando esta fracción porρ y el tiempo de servicio esperado por¯V, obtenemos

ρ=λ¯V

Tiempo de cola esperado para una cola M/G/1

Para nuestro último ejemplo del uso de procesos de renovación-recompensa, consideramos el tiempo de cola esperado en una cola M/G/1. De nuevo asumimos que una llegada a un sistema vacío ocurre en el tiempo 0 y las renovaciones ocurren en las llegadas posteriores a un sistema vacío. En cualquier momento dadot, dejeLq(t) ser el número de clientes en la cola (sin contar al cliente en servicio, si los hay) y dejar queR(t) sea la vida residual del cliente en servicio. Si ningún cliente está en servicio,R(t)=0, y de lo contrarioR(t) es el tiempo restante hasta que se complete el servicio actual. DejeU(t) ser el tiempo de espera en cola que sería experimentado por un cliente que llega a tiempot. Esto a menudo se llama el trabajo inacabado en la literatura de colas y representa el retraso hasta que todos los clientes actualmente en el sistema completen el servicio. Así el rvU(t) es igual aR(t), la vida residual del cliente en servicio, más los tiempos de servicio de cada uno de losLq(t) clientes que actualmente esperan en la cola.

U(t)=Lq(t)∑i=1VN(t)−i+R(t),

dondeN(t)−i está el número de cliente deli th cliente en la cola en el momentot. Dado queLq(t) es una función solo de los tiempos de interllegada(0,t) y los tiempos de servicio de los clientes que ya han sido atendidos, vemos que para cada valor de muestraLq(t)=ℓ, los rv tienen˜V1,…,˜Vℓ cada uno la distribución del tiempo de servicioFV. Así, tomando los valores esperados,

E[U(t)]=E[Lq(t)]E[V]+E[R(t)].

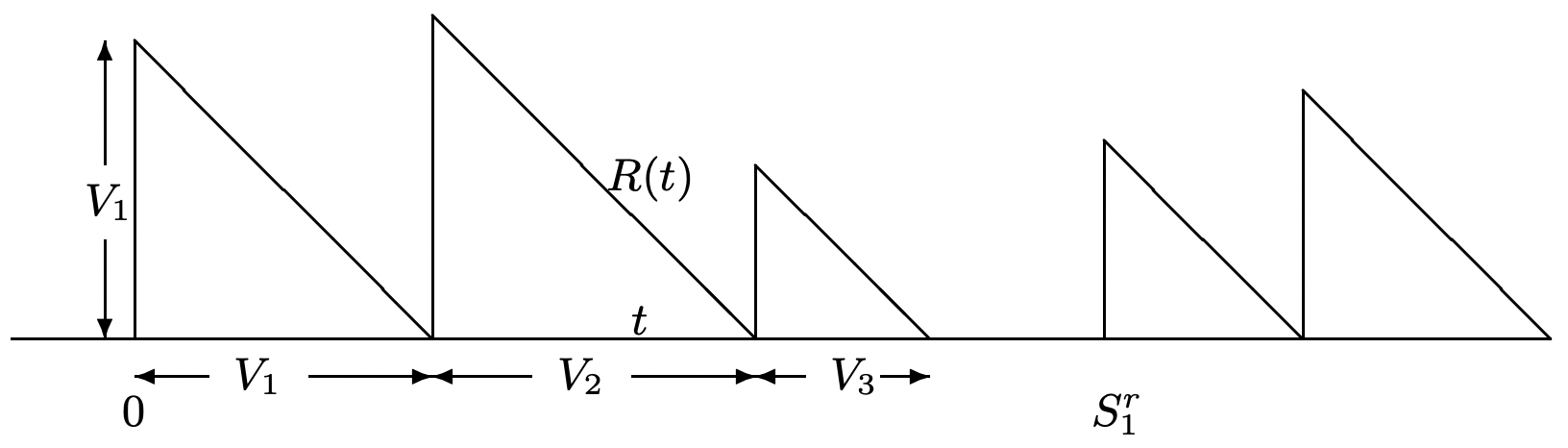

La Figura 4.16 ilustra cómo encontrar el promedio de tiempo deR(t). ViendoR(t) como recompensa

Figura 4.16: Valor muestral de la función de vida residual de los clientes en servicio.

Figura 4.16: Valor muestral de la función de vida residual de los clientes en servicio., podemos encontrar la recompensa acumulada hasta el tiempo t como la suma de áreas triangulares.

Primero, considere∫R(τ)dτ de 0 aSrNr(t), es decir, la recompensa acumulada hasta la época de renovación final en[o,t]t. Tenga en cuenta que no sóloSrNr(t) es una época de renovación para el proceso de renovación, sino también una época de llegada para el proceso de llegada; en particular, es la época deN(SrNr(t)) th llegada, y las llegadasN(SrNr(t))−1 más tempranas son los clientes que han recibido servicio hasta el momentoSrNr(t). Por lo tanto,

∫SrNr(t)0R(τ)dτ=∑N(SrNr(t))−1i=0V2i2≤∑N(t)i=0V2i2.

De manera similar podemos encuadrar superior el término a la derecha arriba por∫SrNr(t)+10R(τ)dτ. También sabemos (de pasar por prácticamente el mismo argumento varias veces) que(1/t)∫tτ=0R(τ)dτ se acercará a un límite 15 con probabilidad 1 ast→∞, y que el límite quedará sin cambios sit se sustituye porSrNr(t) oSrNr(t)+1. Así, tomandoλ como tasa de llegada,

limt→∞∫t0R(τ)dτt=limt→∞∑A(t)i=1V2i2A(t)A(t)t=λE[V2]2WP1

Veremos en la siguiente sección que el promedio de tiempo anterior puede ser reemplazado por un ensemble-promedio limitante, de manera que

limt→∞E[R(t)]=λE[V2]2.

El siguiente apartado también muestra que existe una forma limitante ensemble-promedio de (4.44), lo que demuestra quelimt→∞E[Lq(t)]=λ¯Wq. Sustituyendo este plus\ ref {4.48} en (4.47), obtenemos

limt→∞E[U(t)]=λE[V]¯Wq+λE[V2]2.

AsíE[U(t)] es asintóticamente independiente det. Ahora es importante distinguir entreE[U(t)] y¯Wq. El primero es el trabajo inacabado esperado en el momentot, que es el retraso en la cola en el que incurriría un cliente al llegart; el segundo es el retraso de cola esperado promedio de ruta de muestra. Para las llegadas a Poisson, la probabilidad de una llegada(t,t+δ] es independiente de todas las llegadas anteriores y los horarios de servicio, por lo que es independiente deU(t) 16. Así, en el límitet→∞, cada llegada enfrenta un retraso esperadolimt→∞E[U(t)], por lo quelimt→∞E[U(t)] debe ser igual a¯Wq. Sustituyendo esto en (4.49), obtenemos la célebre fórmula PollacZekkhinchin,

¯Wq=λE[V2]2(1−λE[V]).

Este retraso de cola tiene algunas de las características peculiares de la vida residual, y en particular, siE[V2]=∞, el retraso de cola esperado limitante es infinito incluso cuando el tiempo de servicio esperado es menor que el intervalo esperado entre llegadas.

Al tratar de visualizar por qué el retraso en la cola es tan grande cuandoE[V2] es grande, tenga en cuenta que mientras se está llevando a cabo un servicio particularmente largo, numerosas llegadas están llegando al sistema, y todas están siendo retrasadas por este único servicio largo. Es decir, el número de nuevos clientes retenidos por un servicio largo es proporcional a la duración del servicio, y la cantidad que cada uno de ellos es retenido también es proporcional a la duración del servicio. Esta visualización es bastante cruda, pero sí sirve para explicar el segundo momento deV in (4.50). A este fenómeno se le llama a veces el “efecto camión lento” debido a la acumulación de autos detrás de un camión lento en una carretera de un solo carril.

Para una cola G/G/1,\ ref {4.49} sigue siendo válida, pero los tiempos de llegada ya no son independientes deU(t), por lo que normalmenteE[U(t)]≠¯Wq. Como ejemplo, supongamos que el tiempo de servicio se distribuye uniformemente entre1−ϵ y1+ϵ y que el intervalo entre llegadas se distribuye uniformemente entre2−ϵ y2+ϵ. Suponiendo queϵ<1/2, el sistema no tiene colas y¯Wq=0. Por otro lado, para pequeñosϵ,limt→∞E[U(t)]∼1/4 (es decir, el servidor está ocupado la mitad del tiempo con trabajos inconclusos que van de 0 a 1).

8 Por ejemplo, los jugadores de poker no toman amablemente a un jugador que intenta retirar su apuesta cuando alguien más gana la mano. De igual manera, un estadístico que recoja datos sobre fallas de productos no debe responder a una falla para luego registrar un ensayo anterior como tiempo de detención, no registrando así el fallo.

9 Los ensayos de detención se denominan con mayor frecuencia tiempos de detención o tiempos de parada opcionales en la literatura. Sin embargo, en nuestra primera aplicación importante de un juicio de detención, el juicio de detención es el primer juicion en el que una época de renovaciónSn excede un tiempo determinadot. Ver este juicio como un tiempo genera considerable confusión.

10 Esto puede resultar bastante confuso inicialmente, ya que (como se ve en el ejemplo de la Figura 4.11) noXn es necesariamente independiente del suceso{J=n}{J=n+1}, ni de, etc. En otras palabras, dado que la detención no ha ocurrido antes del juicion, entoncesXn puede tener mucho que ver con el juicio en el que se produce la detención. No obstante, como se mostró anteriormente, noXn tiene nada que ver con si{J<n} o{J≥n}.

11 Esto se mostrará cuando veamos este ejemplo como una cadena de Markov de nacimiento y muerte en el Capítulo 5.

12 Para las colas de un solo servidor, esto a veces se conoce como servicio First-In-First-Out (FIFO).

13 De hecho, a vecesJ se define como una regla de detención siI{J≥n} es independiente deXn,Xn+1,… para cada unon. Esto hace que sea fácil probar la igualdad de Wald, pero bastante difícil de ver cuándo se mantiene la definiciónI{J=n}, especialmente porque, por ejemplo, suele depender deXn (ver nota 7).

14 Confesión por autor: Desde hace unos 15 años, creí erróneamente que era obvio que las llegadas a un sistema vacío en una cola de G/g/m forman un proceso de renovación. Por lo tanto, no puedo esperar que los lectores se entusiasmen con la prueba anterior. Sin embargo, es un buen ejemplo de cómo usar los tiempos de parada para ver claramente los puntos que de otro modo serían turbios.

15 De hecho, uno podría simplemente tomar el límite sin traer el proceso de renovación, ya que ya está claro que el proceso de renovación justifica el límite con probabilidad 1.

16 A esto se le suele llamar la propiedad PASTA, lo que significa llegadas a Poisson ver promedios de tiempo. Esto se sostiene con gran generalidad, requiriendo sólo que existan medias de tiempo y que los parámetros de interés en un momento dadot sean independientes de las futuras llegadas. Al mismo tiempo, esta propiedad es algo vaga, por lo que debe ser utilizada para ayudar a la intuición más que para probar teoremas.