7.12: Ejercicios

- Page ID

- 86347

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\(\newcommand{\avec}{\mathbf a}\) \(\newcommand{\bvec}{\mathbf b}\) \(\newcommand{\cvec}{\mathbf c}\) \(\newcommand{\dvec}{\mathbf d}\) \(\newcommand{\dtil}{\widetilde{\mathbf d}}\) \(\newcommand{\evec}{\mathbf e}\) \(\newcommand{\fvec}{\mathbf f}\) \(\newcommand{\nvec}{\mathbf n}\) \(\newcommand{\pvec}{\mathbf p}\) \(\newcommand{\qvec}{\mathbf q}\) \(\newcommand{\svec}{\mathbf s}\) \(\newcommand{\tvec}{\mathbf t}\) \(\newcommand{\uvec}{\mathbf u}\) \(\newcommand{\vvec}{\mathbf v}\) \(\newcommand{\wvec}{\mathbf w}\) \(\newcommand{\xvec}{\mathbf x}\) \(\newcommand{\yvec}{\mathbf y}\) \(\newcommand{\zvec}{\mathbf z}\) \(\newcommand{\rvec}{\mathbf r}\) \(\newcommand{\mvec}{\mathbf m}\) \(\newcommand{\zerovec}{\mathbf 0}\) \(\newcommand{\onevec}{\mathbf 1}\) \(\newcommand{\real}{\mathbb R}\) \(\newcommand{\twovec}[2]{\left[\begin{array}{r}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\ctwovec}[2]{\left[\begin{array}{c}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\threevec}[3]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\cthreevec}[3]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\fourvec}[4]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\cfourvec}[4]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\fivevec}[5]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\cfivevec}[5]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\mattwo}[4]{\left[\begin{array}{rr}#1 \amp #2 \\ #3 \amp #4 \\ \end{array}\right]}\) \(\newcommand{\laspan}[1]{\text{Span}\{#1\}}\) \(\newcommand{\bcal}{\cal B}\) \(\newcommand{\ccal}{\cal C}\) \(\newcommand{\scal}{\cal S}\) \(\newcommand{\wcal}{\cal W}\) \(\newcommand{\ecal}{\cal E}\) \(\newcommand{\coords}[2]{\left\{#1\right\}_{#2}}\) \(\newcommand{\gray}[1]{\color{gray}{#1}}\) \(\newcommand{\lgray}[1]{\color{lightgray}{#1}}\) \(\newcommand{\rank}{\operatorname{rank}}\) \(\newcommand{\row}{\text{Row}}\) \(\newcommand{\col}{\text{Col}}\) \(\renewcommand{\row}{\text{Row}}\) \(\newcommand{\nul}{\text{Nul}}\) \(\newcommand{\var}{\text{Var}}\) \(\newcommand{\corr}{\text{corr}}\) \(\newcommand{\len}[1]{\left|#1\right|}\) \(\newcommand{\bbar}{\overline{\bvec}}\) \(\newcommand{\bhat}{\widehat{\bvec}}\) \(\newcommand{\bperp}{\bvec^\perp}\) \(\newcommand{\xhat}{\widehat{\xvec}}\) \(\newcommand{\vhat}{\widehat{\vvec}}\) \(\newcommand{\uhat}{\widehat{\uvec}}\) \(\newcommand{\what}{\widehat{\wvec}}\) \(\newcommand{\Sighat}{\widehat{\Sigma}}\) \(\newcommand{\lt}{<}\) \(\newcommand{\gt}{>}\) \(\newcommand{\amp}{&}\) \(\definecolor{fillinmathshade}{gray}{0.9}\)Ejercicio 7.1. Considere la simple caminata aleatoria {\(S_n; n ≥ 1\)} de la Sección 7.1.1 con\(S_n = X_1 + ··· + X_n\) y\(\text{Pr}\{X_i = 1\} = p; \text{ Pr}\{X_i = −1\} = 1 − p\); asuma eso\(p ≤ 1/2\).

a) Mostrar eso\(\text{Pr}\left\{ \bigcup_{n\geq 1} \{S_n ≥ k\} \right\}=\left[\text{Pr}\left\{ \bigcup_{n≥1} \{ S_n ≥1 \} \right\} \right]^k\) para cualquier entero positivo\(k\). Pista: Dado que la caminata aleatoria alguna vez alcanza el valor 1, considere una nueva caminata aleatoria comenzando en ese momento y explore la probabilidad de que la nueva caminata alcance un valor 1 mayor que su punto de partida.

b) Encontrar una ecuación cuadrática para\(y = \text{Pr}\left\{\bigcup_{n≥1} \{S_n ≥ 1\}\right\}\). Pista: explora cada una de las dos posibilidades inmediatamente después del primer juicio.

c) Para\(p < 1/2\), mostrar que las dos raíces de esta ecuación cuadrática son\(p/(1 − p)\) y 1. Argumentan que\(\text{Pr}\left\{\bigcup_{n≥1} \{S_n ≥ 1\}\right\}\) no puede ser 1 y así debe serlo\(p/(1 − p)\).

d) Para\(p = 1/2\), mostrar que la ecuación cuadrática en la parte c) tiene una doble raíz en 1, y así\(\text{Pr}\left\{ \bigcup_{n≥1} \{S_n ≥ 1\}\right\} = 1\). Nota: este es el caso muy peculiar que se explica en la sección sobre la igualdad de Wald.

e) Para\( p < 1/2\), mostrar que\(p/(1 − p) = \exp(−r^∗)\) dónde\(r^∗\) está la raíz positiva única de\(g(r) = 1\) dónde\(g(r) = \mathsf{E} [e^{rX}]\).

Ejercicio 7.2. Considere una cola G/G/1 con llegadas de IID {\(X_i; i ≥ 1\)}, tiempos de servicio IID FCFS {\(Y_i; i ≥ 0\)} y una llegada inicial a un sistema vacío en el tiempo 0. Definir\(U_i = X_i −Y_{i−1}\) para\(i ≥ 1\). Considere una ruta de muestra donde\((u_1, . . . , u_6) = (1, −2, 2, −1, 3, −2)\).

a) Dejar\(Z_i^6 = U_6 + U_{6−1} + . . . + U_{6−i+1}\). Encuentre el retraso en la cola para el cliente 6 como el máximo de la caminata aleatoria “hacia atrás” con elementos\(0, Z_1^6, Z_2^6, . . . , Z_6^6\); dibuje esta caminata aleatoria.

b) Encontrar el retraso en la cola para los clientes 1 a 5.

c) ¿Qué clientes inician un periodo ocupado (\(i.e.\), llegan cuando la cola y el servidor están

vacíos)? Verifique que si\(Z_i^6\) maximiza la caminata aleatoria en la parte a), entonces un período ocupado comienza

con la llegada\(6 − i\).

d) Consideremos ahora una caminata aleatoria hacia adelante\(V_n = U_1 +... +U_n\). Haga un boceto de esta caminata para la ruta de muestra anterior y demuestre que el retraso en la cola para cada cliente es la diferencia entre dos valores elegidos apropiadamente de esta caminata.

Ejercicio 7.3. Una cola G/G/1 tiene un tiempo de servicio determinista de 2 y tiempos de interllegada que son 3 con probabilidad\(p\) y 1 con probabilidad\(1 − p\).

a) Encontrar la distribución de\(W_1\), la espera en cola de la primera llegada después del inicio de un periodo ocupado.

b) Encontrar la distribución de\(W_{\infty}\), la espera en estado estacionario en cola.

c) Repetir las partes a) y b) suponiendo que los tiempos de servicio y los tiempos de interllegada se distribuyan exponencialmente con tarifas\( μ\) y\(\lambda \) respectivamente.

Ejercicio 7.4. Un ejecutivo de ventas escucha que uno de sus vendedores está enrutando la mitad de sus ventas entrantes a un competidor. En particular, se sabe que las ventas que llegan son Poisson a tasa uno por hora. Según el reporte (que vemos como hipótesis 1), cada segundo arribo se encamina a la competencia; así bajo la hipótesis 1 la densidad entre llegadas para ventas exitosas es\(f (y|\mathsf{H}_1) = ye^{−y}; y ≥ 0\). La hipótesis alternativa (\(\mathsf{H}_0\)) es que el rumor es falso y la densidad entre llegadas para ventas exitosas es\(f (y|\mathsf{H}_0) = e^{−y}; y ≥ 0\). Supongamos que, a priori, las hipótesis son igualmente probables. El ejecutivo, un estudiante reciente de procesos estocásticos, explora diversas alternativas para elegir entre las hipótesis; sin embargo, solo puede observar los tiempos de ventas exitosas.

a) Comenzando con una venta exitosa en el tiempo 0,\(S_i\) sea la hora de llegada de la venta exitosa\(i^{th}\) posterior. El ejecutivo observa\(S_1, S_2, . . . , S_n(n ≥ 1)\) y elige la hipótesis de probabilidad aposteriori máxima dada estos datos. Encuentra la densidad de probabilidad conjunta\(f (S_1, S_2, . . . , S_n|\mathsf{H}_1)\)\(f (S_1, . . . , S_n|\mathsf{H}_0)\) y da la regla de decisión.

b) Esto es lo mismo que la parte a) excepto que el sistema está en estado estacionario en el tiempo 0 (en lugar de comenzar con una venta exitosa). Encuentra la densidad de\( S_1\) (el tiempo de la primera llegada después del tiempo 0) condicional on\(\mathsf{H}_0\) y on\(\mathsf{H}_1\). Cuál es la regla de decisión ahora después de observar\(S_1, . . . , S_n\).

c) Esto es lo mismo que la parte b), salvo que en lugar de observar n ventas exitosas, se\(t\) observan las ventas exitosas hasta algún tiempo dado. Encuentra la probabilidad, bajo cada hipótesis, de que la primera venta exitosa ocurra en\((s_1, s_1 + ∆]\), la segunda en\((s_2, s_2 + ∆], . . . ,\) y la última en\((s_{N (t)}, s_{N (t)} + ∆]\) (suponga\(∆\) muy pequeña). ¿Cuál es ahora la regla de decisión?

Ejercicio 7.5. Para el problema de prueba de hipótesis de la Sección 7.3, supongamos que hay un costo\(C_0\) de elegir\(\mathsf{H}_1\) cuándo\(\mathsf{H}_0\) es correcto, y un costo\(C_1\) de elegir\(\mathsf{H}_0\) cuándo\(\mathsf{H}_1\) es correcto. Mostrar que una prueba de umbral minimiza el costo esperado usando el umbral\(η = (C_1p_1)/(C_0p_0)\).

Ejercicio 7.6. Considere un problema de prueba de hipótesis binaria donde\(H\) es 0 o 1 y una observación\(Y\) unidimensional viene dada por\(Y = H + U\) donde\(U\) se distribuye uniformemente\([-1, 1]\) y es independiente de\(H\).

a) Hallar\(\mathsf{f}_{Y |H} (y | 0), \mathsf{f}_{Y |H} (y | 1)\) y la razón de verosimilitud\(Λ(y)\).

b) Encontrar la prueba umbral en\(η\) para cada uno\(η, 0 < η<\infty\) y evaluar las probabilidades de error condicional,\(q_0(η)\) y\(q_1(η)\).

c) Encontrar la curva de error\( u(α)\) y explicar cuidadosamente cómo\(u(0)\) y\(u(1/2)\) se encuentran (pista:\(u(0) = 1/2\)).

d) Describir una regla de decisión para la cual la probabilidad de error bajo cada hipótesis es 1/4. No es necesario usar una regla aleatoria, pero debe manejar cuidadosamente los casos de no atención bajo la prueba de umbral.

Ejercicio 7.7. a) Por dado\(α\),\(0 < α ≤ 1\), vamos a\(η^∗\) lograr lo supremo\(\sup_{0\leq \eta <\infty} q_1 (η) + η(q_0(η) − α)\). \(η^∗ ≤ 1/α\)Demuéstralo. Pista: Piense en términos de Lemma 7.3.1 aplicado a una prueba muy simple.

b) Mostrar que la magnitud de la pendiente de la curva de error\(u(α)\) a\(α\) es como máximo\(1/α\).

Ejercicio 7.8. Definir\(\gamma (r)\) como\(\ln [\mathsf{g}(r)]\) dónde\(\mathsf{g}(r) = \mathsf{E} [\exp (rX)]\). Supongamos que\(X\) es discreto con posibles resultados {\(a_i; i ≥ 1\)}, vamos a\(p_i\) denotar\(\text{Pr}\{X = a_i\}\), y asumir que\(\mathsf{g}(r)\) existe en algún intervalo abierto (\(r_- , r_+\)) que contiene\(r = 0\). Para cualquier dado\(r\),\( r_- < r < r_+\), definir una variable aleatoria\(X_r\) con el mismo conjunto de posibles resultados {\(a_i; i ≥ 1\)} como\(X\), pero con una función de masa de probabilidad\(q_i = \text{Pr}\{X_r = a_i\} = p_i \exp[a_i r − \gamma (r)]\). \( X_r\)no es una función de\(X\), y ni siquiera debe ser visto como en el mismo espacio de probabilidad que\(X\); es de interés simplemente por el comportamiento de su función de masa de probabilidad definida. Se denomina variable aleatoria inclinada con relación a\(X\), y este ejercicio, junto con el Ejercicio 7.9 justificará nuestro interés en él.

a) Verificar que\(\sum_i q_i = 1\).

b) Verificar que\(\mathsf{E} [X_r] = \sum_i a_iq_i\) sea igual a\(\gamma'(r)\).

c) Verificar que Var\([X_r] = \sum_i a_i^2 q_i − (\mathsf{E} [X_r])^2\) sea igual a\(\gamma''(r)\).

d) Argumentan que\(\gamma''(r) ≥ 0\) para todos los\(r\) tales que\(\mathsf{g}(r)\) existe, y que\(\gamma''(r) > 0\) si\(\gamma''(0) > 0\).

e) Dar una definición similar de\(X_r\) para una variable aleatoria\(X\) con una densidad, y modificar las partes a) a d) en consecuencia.

Ejercicio 7.9. Supongamos que\(X\) es discreto, con posibles valores {\(a_i; i ≥ 1\)) y probabilidades\(\text{Pr}\{X = a_i\} = p_i\). Dejar\(X_r\) ser la variable aleatoria inclinada correspondiente como se define en el Ejercicio 7.8. Dejar\(S_n = X_1 +... + X_n\) ser la suma de\( n\) IID rv con la distribución de\(X\), y dejar\(S_{n,r} = X_{1,r} + ...+ X_{n,r}\) ser la suma de\(n\) IID rv inclinadas con la distribución de\(X_r\). Supongamos que\(\overline{X} < 0\) y eso\( r > 0\) es tal que\(\gamma (r)\) existe.

a) Demostrar eso\(\text{Pr}\{S_{n,r} =s\} = \text{Pr}\{S_n =s\} \exp[sr − n\gamma (r)]\). Pista: primero demuestre que

\[ \text{Pr}\{ X_{1,r}=v_1,...,X_{n,r}=v_n \} = \text{Pr}\{X_1=v_1,...,X_n=v_n\} \exp [sr-n\gamma (r)] \nonumber \]

donde\(s=v_1+...+v_n\).

b) Encontrar la media y varianza de\(S_{n,r}\) en términos de\(\gamma(r)\).

c) Definir\(a= \gamma'(r)\) y\(σ_r^2 = \gamma''(r)\). \(\text{Pr}\left\{| S_{n,r} − na|≤\sqrt{2n}σ_r\right\} > 1/2\)Demuéstralo. Usa esto para demostrar que

\[\text{Pr} \left\{ \left| S_n-na \right| \leq \sqrt{2n}\sigma_r \right\} > (1/2)\exp [-r(an+\sqrt{2n} \sigma_r ) +n\gamma (r)] \nonumber \]

d) Utilice esto para demostrar que para cualquiera\(\epsilon\) y para todos suficientemente grandes\(n\),

\[ \text{Pr}\{ S_n\geq n(\gamma'(r)-\epsilon)\}>\dfrac{1}{2}\exp [-rn(\gamma' (r)+\epsilon )+n\gamma (r)] \nonumber \]

Ejercicio 7.10. Considera una caminata aleatoria con umbrales\( α> 0\),\(β< 0\). Deseamos encontrar\(\text{Pr}\{S_J ≥ α\}\) en ausencia de un umbral inferior. Usa el límite superior en (7.5.9) para la probabilidad de que la caminata aleatoria cruce\(α\) antes\(β\).

a) Dado que la caminata aleatoria cruza\(β\) primero, encuentra un límite superior a la probabilidad que ahora\(α\) se cruza antes de que\(2β\) se cruce un umbral aún más bajo at.

b) Dado que\( 2β\) se cruza antes\(α\), upperbound la probabilidad que\(α\) se cruza antes de un umbral en\(3β\). Extendiendo este argumento a umbrales sucesivamente más bajos, encontrar un límite superior para cada término sucesivo y encontrar un límite superior sobre la probabilidad general que\(α\) se cruza. Al observar que\(β\) es arbitrario, mostrar que (7.5.9) es válido sin umbral inferior.

Ejercicio 7.11. Este ejercicio verifica que el Corolario 7.5.1 se sostiene en la situación donde\(\gamma(r) < 0\) para todos\(r ∈ (r_−, r_+)\) y donde\(r^∗\) se toma para estar\(r_+\) (ver Figura 7.7).

a) Demostrar eso por la situación anterior,\(\exp (rS_J ) ≤ \exp(rS_J − J\gamma (r))\) para todos\(r ∈ (0, r^∗)\).

b) Demostrar eso\(\mathsf{E} [\exp (rS_J )] ≤ 1\) para todos\(r ∈ (0, r^∗)\).

c) Demostrar eso\(\text{Pr}\{S_J ≥ α\}≤ \exp(−rα)\) para todos\(r ∈ (0, r^∗)\). Pista: Siga los pasos de la prueba de Corolario 7.5.1.

d) Demostrar eso\(\text{Pr}\{ S_J ≥ α\} ≤ \exp(−r^∗α)\).

Ejercicio 7.12. a) Usa la igualdad de Wald para demostrar que si\(\overline{X} = 0\), entonces,\(\mathsf{E} [S_J ] = 0\) ¿dónde\(J\) está el tiempo de cruce de umbral con un umbral en\(α> 0\) y otro en\(β< 0\).

b) Obtener una expresión para\(\text{Pr}\{S_J ≥ α\}\). Tu expresión debe involucrar el valor esperado de\(S_J\) condicional al cruzar los umbrales individuales (no es necesario intentar calcular estos valores esperados).

c) Evalúe su expresión para el caso de una simple caminata aleatoria.

d) Evalúe su expresión cuando\(X\) tenga una densidad exponencial,\(\mathsf{f}_X \ref{x} = a_1e^{−\lambda x}\) para\(x ≥ 0\) y\(\mathsf{f}_X \ref{x} = a_2e^{μx}\) para\(x < 0\) y donde\(a_1\) y\(a_2\) sean escogidos para que\(\overline{X} = 0\).

Ejercicio 7.13. Una caminata aleatoria {\(S_n; n ≥ 1\)}, con\(S_n =\sum^n_{i=1} X_i\), tiene la siguiente densidad de probabilidad para\(X_i\)

\[ \mathsf{f}_X(x) = \left\{ \begin{array}{pp} \dfrac{e^{-x}}{e-e^{-1}} \,; \qquad -1\leq x \leq 1 \\ \\ \\ =0 \,; \qquad \text{elsewhere} \end{array} \right. \nonumber \]

a) Encontrar los valores de\( r\) para los cuales\(\mathsf{g}(r) = \mathsf{E} [\exp (rX)] = 1\).

b)\( P_α\) Sea la probabilidad de que la caminata aleatoria alguna vez cruce un umbral en\(α\) para algunos\(α> 0\). Encontrar un límite superior a\(P_α\) de la forma\(P_α ≤ e^{−αA}\) donde\(A\) es una constante que no depende de\(α\); evaluar\(A\).

c) Encontrar un límite inferior a\(P_α\) de la forma\(P_α ≥ Be^{−αA}\) donde\(A\) es el mismo que en la parte b) y\(B\) es una constante de la que no depende\(α\). Pista: mantenlo simple — no se espera que encuentres un encuadernado elaborado. También recordemos que\(\mathsf{E}[e^{r^∗S_J} ]= 1\) donde\(J\) está un juicio de parada para la caminata aleatoria y\(\mathsf{g}(r^∗) = 1\).

Ejercicio 7.14. Sea {\(X_n; n ≥ 1\)} una secuencia de variables aleatorias con valor entero IID con la función de masa de probabilidad\(P_X \ref{k} = Q_k\). Supongamos que\(Q_k > 0\) para\(|k| ≤ 10\) y\(Q_k = 0\) para\(|k| > 10\). Que {\(S_n; n ≥ 1\)} sea un paseo al azar con\(S_n = X_1 + ··· + X_n\). Let\(α> 0\) y\(β< 0\) ser umbrales de valor entero, let\(J\) ser el valor más pequeño de\(n\) para el cual cualquiera\(S_n ≥ α\) o\(S_n ≤ β\). Que {\(S_n^∗; n ≥ 1\)} sea la caminata aleatoria detenida;\(i.e.\),\(S^∗_n= S_n\) para\(n ≤ J\) y\(S_n^∗= S_J\) para\(n > J\). Vamos\(π_i^∗ = \text{Pr}\{S_J = i\}\).

a) Consideremos una cadena de Markov en la que esta caminata aleatoria detenida se corre repetidamente hasta el punto de detenerse. Es decir, las probabilidades de transición en cadena de Markov están dadas por\(P_{ij} = Q_{j−i}\) para\(β< i < α\) y\(P_{i0} = 1\) para\(i ≤ β\) y\(i ≥ α\). Todas las demás probabilidades de transición son 0 y el conjunto de estados es el conjunto de enteros\( [−9 + β, 9 + α]\). Demostrar que esta cadena de Markov es ergódica.

b) Sea {\(π_i\)} el conjunto de probabilidades de estado estacionario para esta cadena de Markov. Encuentra el conjunto de probabilidades {\(π_i^∗\)} para los estados de parada de la caminata aleatoria detenida en términos de {\(π_i\)}.

c) Encontrar\(\mathsf{E} [S_J ]\) y\(\mathsf{E} [J]\) en términos de {\(π_i\)}.

Ejercicio 7.15. a) Condicional\(H_0\) para el problema de prueba de hipótesis, considerar las variables aleatorias\(Z_i = \ln [f (Y_i|\mathsf{H}_1)/f (Y_i|H_0)]\). Demostrar que\(r^∗\), la solución positiva a\(\mathsf{g}(r) = 1\), donde\(g(r) = \mathsf{E} [\exp (rZi)]\), viene dada por\(r^∗ = 1\).

b) Suponiendo que\(Y\) es una variable aleatoria discreta (bajo cada hipótesis), mostrar que la variable aleatoria inclinada\(Z_r\) con\(r = 1\) tiene el PMF\(P_Y (y|\mathsf{H}_1)\).

Ejercicio 7.16. a) Supongamos que {\(Z_n; n ≥ 1\)} es una martingala. Verificar (7.6.13);\(i.e.\),\(\mathsf{E} [Z_n] = \mathsf{E} [Z_1]\) para\(n > 1\).

b) Si {\(Z_n; n ≥ 1\)} es una submartingala, verificar (7.7.5), y si una supermartingala, verificar (7.7.6).

Ejercicio 7.17. Supongamos que {\(Z_n; n ≥ 1\)} es una martingala. Demostrar que

\[ \mathsf{E}[Z_m|Z_{n_i},Z_{n_{i-1}},...,Z_{n_1}] = Z_{n_i} \text{ for all } 0<n_1<n_2<...<n_i <m \nonumber \]

Ejercicio 7.18. a) Supongamos que {\(Z_n; n ≥ 1\)} es una submartingala. Demostrar que

\[\mathsf{E} [Z_m|Z_n,Z_{n-1},...,Z_1] \geq Z_n \text{ for all } n<m \nonumber \]

b) Demostrar que

\[ \mathsf{E}[Z_m|Z_{n_i},Z_{n_{i-1}},...,Z_{n_1}] \geq Z_{n_i} \text{ for all } 0<n_1<n_2<...<n_i<m \nonumber \]

c) Supongamos ahora que {\(Z_n; n ≥ 1\)} es una supermartingala. Demostrar que las partes a) y b) aún se mantienen

con\( ≥\) reemplazadas por\(≤\).

Ejercicio 7.19. Sea {\(Z_n = \exp [rS_n − n\gamma (r)]; n ≥ 1\)} la función generadora martingala de (7.6.7) donde\(S_n = X_1 +... + X_n\) y\(X_1, . . . X_n\) son IID con media\(\overline{X} < 0\). \(J\)Sea el ensayo de detención posiblemente defectuoso para el que el proceso se detiene después de cruzar un umbral en\(α> 0\) (no hay umbral negativo). Mostrar que\(\exp [r^∗α]\) es un límite superior a la probabilidad de cruce de umbral considerando el proceso detenido {\(Z_n^∗; n ≥ 1\)}.

El propósito de este ejercicio es ilustrar que el proceso detenido puede producir límites superiores útiles incluso cuando el ensayo de detención es defectuoso.

Ejercicio 7.20. Este problema utiliza martingales para encontrar el número esperado de ensayos\(\mathsf{E} [J]\) antes de que un patrón fijo,\(a_1, a_2, . . . , a_k\), de dígitos binarios ocurra dentro de una secuencia de variables aleatorias binarias IID\(X_1, X_2, . . .\) (ver Ejercicios 4.32 y 3.28 para enfoques alternos). Para determinar se utilizará un casino mítico y un conjunto de jugadores que sigan una estrategia prescrita\(\mathsf{E} [J]\). El casino tiene un juego donde, en el juicio\(i\) th, los jugadores apuestan dinero en 1 o 0. Después de realizar las apuestas,\(X_i\) arriba se utiliza para seleccionar el resultado 0 o 1. Dejar\(p(1) = \mathsf{p}_X (1)\) y\(p(0) = 1 − p(1) = \mathsf{p}_X (0)\). Si\(s\) se apuesta una cantidad en 1, el casino recibe\(s\) if\( X_i = 0\), y paga\(s/p(1) − s\) (más devolviendo la apuesta\(s\)) if\(X_i = 1\). Si\(s\) se apuesta en 0, el casino recibe\(s\) if\(X_i = 1\), y paga\(s/p(0) − s\) (más la apuesta\(s\)) si\(X_i = 0\).

a) Asumir un patrón arbitrario de apuestas por parte de varios apostadores en diversas pruebas (algunos apostadores podrían apostar cantidades arbitrarias en 0 y algunos en 1 en cualquier juicio dado). \(Y_i\)Sea la ganancia neta del casino en juicio\(i\). Demuestre eso\(\mathsf{E} [Y_i] = 0\) (\(i.e.\), demuestre que el juego es justo). \(Z_n = Y_1 + Y_2 +... + Y_n\)Sea la ganancia agregada del casino sobre las\(n\) pruebas. Demuestre que para el patrón dado de apuestas, {\(Z_n; n ≥ 1\)} es una martingala.

b)\(\mathsf{E} [J]\) Para determinar un patrón dado\(a_1, a_2, . . . , a_k\), programamos a nuestros jugadores para que apuesten de la siguiente manera:

i) El jugador 1 tiene un capital inicial de 1 el cual se apuesta\(a_1\) en el juicio 1. Si gana, su capital crece hasta\(1/p(a_1)\), que se apuesta\(a_2\) en el juicio 2. Si vuelve a ganar, apuesta todo su capital,\(1/[p(a_1)p(a_2)]\),\(a_3\) en el juicio 3. Continúa, en cada juicio\(i\), apostando todo su capital\(a_i\) hasta que pierde en algún juicio (en cuyo caso se va sin dinero) o gana en juicios\(k\) sucesivos (en cuyo caso se va con\(1/[p(a_1) . . . p(a_k)]\).

ii) Gambler\(j, j > 1\), sigue exactamente la misma estrategia pero comienza en el juicio\(j\). Tenga en cuenta que si el patrón\(a_1, . . . , a_k\) aparece por primera vez en\(J = n\), entonces el jugador se\(n − k + 1\) va a la vez\(n\) con el capital\(1/[p(a_1) . . . p(a_k)]\) y\(j < n − k + 1\) todos los apostadores pierden su capital.

Supongamos que la cadena\((a_1, . . . , a_k)\) es\((0, 1)\). Vamos por la estrategia de juego anterior. Dado que\(J = 3\) (\(i.e.\), eso\(X_2 = 0\) y\(X_3 = 1\)), tenga en cuenta que el jugador 1 pierde su dinero en cualquiera de los juicios 1 o 2, el jugador 2 se va al tiempo 3 con\(1/[p(0)p(1)]\) y el jugador 3 pierde su dinero en el tiempo 3. Demostrar eso\(Z_J = 3 − 1/[p(0)p(1)]\) dado\(J = 3\). Encontrar\(Z_J\) dado\(J = n\) por arbitrario\(n ≥ 2\) (tenga en cuenta que la condición especifica de\(J = n\) manera única\(Z_J \)).

c) Encontrar\(\mathsf{E}[Z_J ]\) de la parte a). Utilice esta parte más b) para encontrar\(\mathsf{E} [J]\).

d) Repetir las partes b) y c) usando la cadena\((a_1, . . . , a_k) = (1, 1)\). Ten cuidado con el jugador 3 para\(J = 3\). Demostrar que\(\mathsf{E} [J] = 1/[p(1)p(1)] + 1/p(1)\)

e) Repetir las partes b) y c) para\((a_1, . . . , a_k) = (1, 1, 1, 0, 1, 1)\).

Ejercicio 7.21. a) Este ejercicio muestra por qué\(\mathsf{E} [|Z_J |] < \infty\) se requiere el padecimiento en Lemma 7.8.1. Let\(Z_1 = −2\) y, for\(n ≥ 1\), let\(Z_{n+1} = Z_n[1 + X_n(3n + 1)/(n + 1)]\) donde\(X_1, X_2, . . .\) están IID y tomar los valores\(+1\) y\(−1\) con probabilidad 1/2 cada uno. Demuestre que {\(Z_n; n ≥ 1\)} es una martingala.

b) Considerar el juicio de detención\(J\) tal que\(J\) sea el valor más pequeño de\(n > 1\) para el cual\(Z_n\) y\(Z_{n−1}\) tengan el mismo signo. Demostrar eso\(n < J\), condicional,\(Z_n = (−2)^n/n\) y, condicional\(n = J\),\(Z_J = −(−2)^n(n − 2)/(n^2 − n)\).

c) Demostrar que\(\mathsf{E} [|Z_J |]\) es infinito, para que eso\(\mathsf{E} [Z_J ]\) no exista según la definición de expectativa, y demostrarlo\(\lim_{n→\infty} \mathsf{E} [Z_n|J > n] \text{Pr}\{J > n\} = 0\).

Ejercicio 7.22. Este ejercicio muestra por qué el sup de una martingala puede comportarse de manera marcadamente diferente al máximo de un número arbitrariamente grande de las variables. Más precisamente, demuestra que\(\text{Pr}\left\{ \sup_{n≥1} Z_n ≥ a\right\}\) puede ser desigual a\(\text{Pr}\left\{ \bigcup_{n≥1}\{Z_n ≥ a\}\right\}\).

a) Considerar una martingala donde\(Z_n\) pueda asumir únicamente los valores\(2^{−n−1}\) y\(1 − 2^{−n−1}\), cada uno con probabilidad 1/2. Dado que\(Z_n\), condicional\(Z_{n−1}\), es independiente de\(Z_1, . . . Z_{n−2}\), encontrar\(\text{Pr}\{ Z_n|Z_{n−1}\}\) para cada uno para\(n\) que se cumpla la condición martingala.

b) Demostrar eso\(\text{Pr}\left\{\sup_{n≥1} Z_n ≥ 1\right\} = 1/2\) y demostrar eso\(\text{Pr}\left\{ \bigcup_n \{Z_n ≥ 1\} \right\} = 0\).

c) Demostrar que para cada\(\epsilon > 0\),\(\text{Pr}\left\{ \sup_{n≥1} Z_n ≥ a\right\} ≤ \frac{\overline{Z}_1}{a-\epsilon }\). Pista: Utilice la relación entre\(\text{Pr}\left\{ \sup_{n≥1} Z_n ≥ a\right\}\) y\(\text{Pr}\left\{\bigcup_n\{Z_n ≥ a\}\right\}\) mientras se soluciona el tema en la parte b).

d) Utilizar la parte c) para establecer (7.9.3).

Ejercicio 7.23. Demostrar que el Teorema 7.7.1 también es válido para martingales relativo a un proceso conjunto. Es decir, mostrar que si\(h\) es una función convexa de una variable real y si {\(Z_n; n ≥ 1\)} es una martingala relativa a un proceso conjunto {\(Z_n, X_n; n ≥ 1\)}, entonces {\(h(Z_n); n ≥ 1\)} es una submartingala relativa a {\(h(Z_n), X_n; n ≥ 1\)}.

Ejercicio 7.24. Mostrar que si {\(Z_n; n ≥ 1\)} es una martingala (submartingala o supermartingala) relativa a un proceso conjunto {\(Z_n, X_n; n ≥ 1\)} y si\(J\) es una prueba de detención para {\(Z_n; n ≥ 1\)} relativa a {\(Z_n, X_n; n ≥ 1\)}, entonces el proceso detenido es una martingala (submartingala o supermartingala) respectivamente relativo a la proceso conjunto.

Ejercicio 7.25. Mostrar que si {\(Z_n; n ≥ 1\)} es una martingala (submartingala o supermartingala) relativa a un proceso conjunto {\(Z_n, X_n; n ≥ 1\)} y si\(J\) es una prueba de detención para {\(Z_n; n ≥ 1\)} relativa a {\(Z_n, X_n; n ≥ 1\)}, entonces el proceso detenido satisface (7.8.3), (7.8.4) o (7.8.5) respectivamente.

Ejercicio 7.26. Mostrar que si {\(Z_n; n\geq 1\)} es una martingala relativa a un proceso conjunto {\(Z_n, X_n; n ≥1\)} y si\(J\) es un ensayo de detención para {\(Z_n; n ≥ 1\)} relativo a {\(Z_n, X_n; n ≥ 1\)}, entonces\(\mathsf{E} [Z_J ] = \mathsf{E} [Z_1]\) si y solo f (7.8.9) está satisfecho.

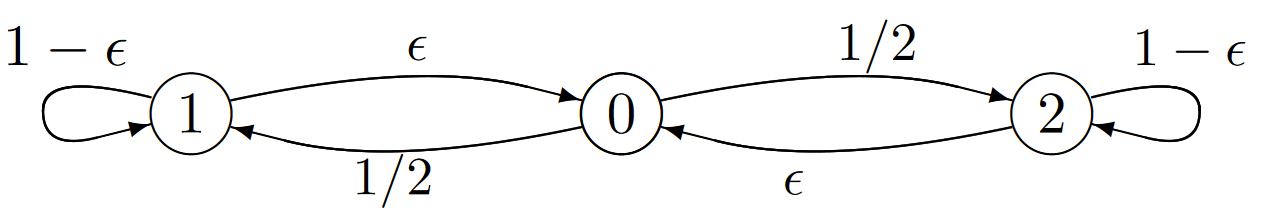

Ejercicio 7.27. Considera la caminata aleatoria modulada de Markov en la siguiente figura. Las variables aleatorias\(Y_n\) en este ejemplo toman solo un único valor para cada transición, siendo ese valor 1 para todas las transiciones del estado 1, 10 para todas las transiciones del estado 2 y 0 de lo contrario. \(\epsilon > 0\)es un número muy pequeño, digamos\(\epsilon < 10^{−6}\).

a) Demostrar que la ganancia en estado estacionario por transición es\(5.5/(1+ \epsilon)\). Mostrar que el vector de ganancia relativa es\(\boldsymbol{w} = (0, (\epsilon − 4.5)/[\epsilon (1 + \epsilon )]\),\((10\epsilon + 4.5)/[\epsilon (1 + \epsilon)])\).

b) Dejar\(S_n = Y_0 +Y_1 +... +Y_{n−1}\) y tomar el estado inicial\(X_0\) para ser 0. Dejar\(J\) ser el valor más pequeño de\(n\) para el cual\(S_n ≥ 100\). Encontrar\(\text{Pr}\{J = 11\}\) y\(\text{Pr}\{ J = 101\}\). Encuentra una estimación de\(\mathsf{E} [J]\) que sea exacta en el límite\(\epsilon \rightarrow 0\).

c) Demostrar eso\(\text{Pr}\{ X_J = 1\} = (1 − 45\epsilon + o(\epsilon ))/2\) y aquello\(\text{Pr}\{ X_J = 2\} = (1 + 45\epsilon + o(\epsilon ))/2\). Verificar, a primer orden en\(\epsilon \) que (7.10.17) esté satisfecho.

Ejercicio 7.28. Mostrar que (7.10.17) resulta de tomar la derivada de (7.10.21) y evaluarla en\(r = 0\).

Ejercicio 7.29. Dejar\(\{ Z_n; n ≥ 1\}\) ser una martingala, y para algún entero\(m\), vamos\(Y_n = Z_{n+m} −Z_m\).

a) Demostrar eso\(\mathsf{E} [Y_n | Z_{n+m−1} = z_{n+m−1}, Z_{n+m−2} = z_{n+m−2}, . . . , Z_m = z_m, . . . , Z_1 = z_1] = z_{n+m−1} − z_m\).

b) Demostrar eso\(\mathsf{E} [Y_n | Y_{n−1} = y_{n−1}, . . . , Y_1 = y_1] = y_{n−1}\).

c) Demostrar eso\(\mathsf{E} [|Y_n|] < \infty\). Tenga en cuenta que b) y c) muestran que {\(Y_n; n ≥ 1\)} es una martingala.

Ejercicio 7.30. a) Demostrar que el Teorema 7.7.1 es válido si {\(Z_n; n ≥ 1\)} es una submartingala en lugar de una martingala. Pista: Simplemente siga la prueba del Teorema 7.7.1 en el texto.

b) Demostrar que la desigualdad martingala Kolmogorov también se mantiene si {\(Z_n; n ≥ 1\)} es una sub-martingala más que una martingala.

Ejercicio 7.31 (Continuación de la ramificación en el tiempo continuo) Este ejercicio ve el proceso de ramificación en el tiempo continuo del Ejercicio 6.15 como una caminata aleatoria detenida. Recordemos que el proceso se especificó ahí como un proceso de Markov tal que para cada estado\(j\),\( j ≥ 0\), la tasa de transición a\(j + 1\) es\(j\lambda \) y a\(j − 1\) es\(jμ\). No hay otras transiciones, y en particular, no hay transiciones fuera del estado 0, de manera que el proceso de Markov es reducible. Recordemos que la cadena incrustada de Markov es la misma que la cadena incrustada de una cola M/M/1 excepto que no hay transición del estado 0 al estado 1.

a) Para modelar la posible extinción de la población, convertir la cadena incrustada de Markov arriba en una caminata aleatoria detenida, {\(S_n; n ≥ 0\)}. La caminata aleatoria detenida comienza en\(S_0 = 0\) y se detiene al alcanzar un umbral en −1. Antes de detenerse, se mueve hacia arriba en uno con probabilidad\(\frac{\lambda}{\lambda+μ}\) y a la baja por 1 con probabilidad\(\frac{μ}{ \lambda+μ}\) en cada paso. Dar la (muy simple) relación entre el estado\(X_n\) de la cadena de Markov y el estado\(S_n\) de la caminata aleatoria detenida para cada uno\(n ≥ 0\).

b) Encontrar la probabilidad de que la población finalmente se extingue en función de\(\lambda\) y\(μ\). Asegúrese de considerar los tres casos\(\lambda > μ\),\(\lambda< μ\), y\(\lambda = μ\).