6.3: Investigación correlacional

- Page ID

- 144642

¿Qué es la investigación correlacional?

La investigación correlacional es un tipo de investigación no experimental en la que el investigador mide dos variables (binarias o continuas) y evalúa la relación estadística (es decir, la correlación) entre ellas con poco o ningún esfuerzo para controlar variables extrañas. Hay muchas razones por las que los investigadores interesados en las relaciones estadísticas entre variables elegirían realizar un estudio correlacional en lugar de un experimento. La primera es que no creen que la relación estadística sea causal o no estén interesados en las relaciones causales. Recordemos que dos objetivos de la ciencia son describir y predecir y la estrategia de investigación correlacional permite a los investigadores lograr ambos objetivos. Específicamente, esta estrategia puede ser utilizada para describir la fuerza y dirección de la relación entre dos variables y si existe una relación entre las variables entonces los investigadores pueden usar puntajes en una variable para predecir puntuaciones en la otra (utilizando una técnica estadística llamada regresión, que se discute más a fondo en la sección sobre Correlación Compleja en este capítulo).

Otra razón por la que los investigadores elegirían utilizar un estudio correlacional en lugar de un experimento es que se piensa que la relación estadística de interés es causal, pero el investigador no puede manipular la variable independiente porque es imposible, poco práctica, o poco ético. Por ejemplo, si bien un investigador podría estar interesado en la relación entre la frecuencia en que las personas usan cannabis y sus habilidades de memoria, no pueden manipular éticamente la frecuencia con la que las personas consumen cannabis. Como tal, deben confiar en la estrategia de investigación correlacional; simplemente deben medir la frecuencia con que las personas consumen cannabis y medir sus habilidades de memoria usando una prueba estandarizada de memoria para luego determinar si la frecuencia que las personas usan cannabis está estadísticamente relacionada con el rendimiento de las pruebas de memoria.

También se utiliza la correlación para establecer la confiabilidad y validez de las mediciones. Por ejemplo, un investigador podría evaluar la validez de una prueba breve de extraversión administrándola a un gran grupo de participantes junto con una prueba de extraversión más larga que ya se ha demostrado que es válida. Este investigador podría entonces verificar si las puntuaciones de los participantes en la prueba breve están fuertemente correlacionadas con sus puntuaciones en la más larga. Tampoco se piensa que el puntaje de la prueba cause al otro, por lo que no hay una variable independiente para manipular. De hecho, los términos variable independiente y variable dependiente no se aplican a este tipo de investigación.

Otra fortaleza de la investigación correlacional es que a menudo es mayor en validez externa que la investigación experimental. Recordemos que normalmente hay una compensación entre la validez interna y la validez externa. A medida que se agregan mayores controles a los experimentos, se incrementa la validez interna pero muchas veces a expensas de la validez externa ya que se introducen condiciones artificiales que no existen en la realidad. Por el contrario, los estudios correlacionales suelen tener baja validez interna porque no se manipula ni controla nada pero a menudo tienen una validez externa alta. Dado que nada es manipulado o controlado por el experimentador, es más probable que los resultados reflejen las relaciones que existen en el mundo real.

Finalmente, extendiendo sobre este equilibrio entre validez interna y externa, la investigación correlacional puede ayudar a proporcionar evidencia convergente para una teoría. Si una teoría es apoyada por un verdadero experimento que es alto en validez interna así como por un estudio correlacional que es alto en validez externa entonces los investigadores pueden tener más confianza en la validez de su teoría. Como ejemplo concreto, estudios correlacionales que establecen que existe una relación entre ver televisión violenta y comportamiento agresivo se han complementado con estudios experimentales que confirman que la relación es causal (Bushman & Huesmann, 2001) [1] .

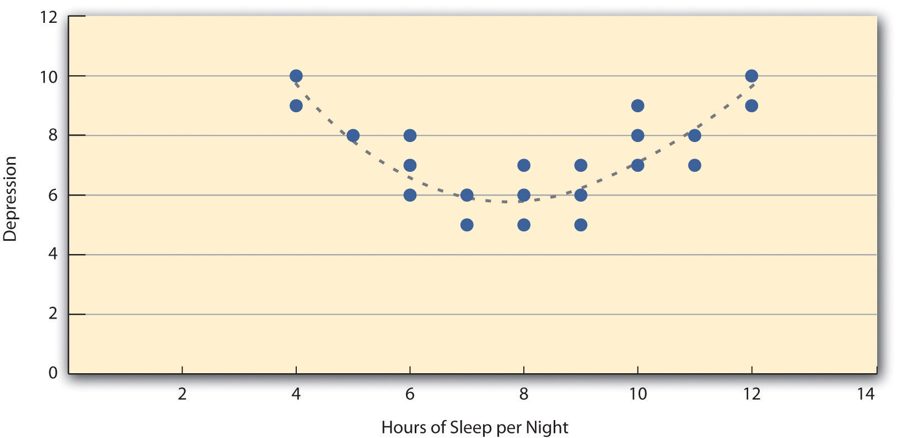

Hay dos situaciones comunes en las que el valor de r de Pearson puede ser engañoso. La r de Pearson es una buena medida solo para las relaciones lineales, en las que los puntos se aproximan mejor por una línea recta. No es una buena medida para las relaciones no lineales, en las que los puntos se aproximan mejor por una línea curva. La figura\(\PageIndex{4}\), por ejemplo, muestra una relación hipotética entre la cantidad de sueño que las personas duermen por noche y su nivel de depresión. En este ejemplo, la línea que mejor se aproxima a los puntos es una curva —una especie de “U” al revés— porque las personas que duermen alrededor de ocho horas tienden a ser las menos deprimidas. Los que duermen muy poco y los que duermen demasiado tienden a estar más deprimidos. A pesar de que la Figura\(\PageIndex{4}\) muestra una relación bastante fuerte entre la depresión y el sueño, la r de Pearson estaría cerca de cero porque los puntos en la gráfica de dispersión no están bien ajustados por una sola línea recta. Esto significa que es importante hacer una gráfica de dispersión y confirmar que una relación es aproximadamente lineal antes de usar r de Pearson. Las relaciones no lineales son bastante comunes en psicología, pero medir su fuerza está más allá del alcance de este libro.

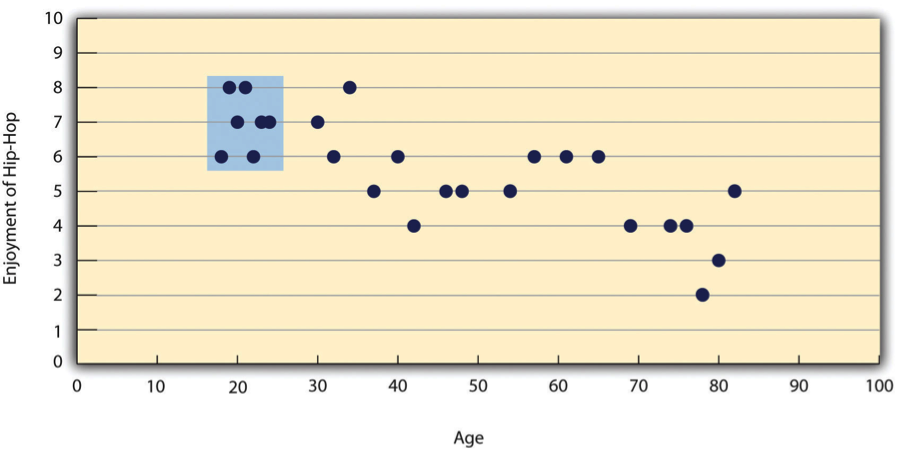

Las otras situaciones comunes en las que el valor de r de Pearson puede ser engañoso es cuando una o ambas variables tienen un rango limitado en la muestra en relación con la población. Este problema se conoce como restricción de rango. Supongamos, por ejemplo, que existe una fuerte correlación negativa entre la edad de las personas y su disfrute de la música hip hop como lo muestra la trama de dispersión de la Figura\(\PageIndex{5}\). La r de Pearson aquí es −.77. Sin embargo, si tuviéramos que recolectar datos solo de 18 a 24 años de edad, representados por el área sombreada de la\(\PageIndex{5}\) Figura, entonces la relación parecería ser bastante débil. De hecho, la r de Pearson para este rango restringido de edades es 0. Es una buena idea, por lo tanto, diseñar estudios para evitar la restricción de rango. Por ejemplo, si la edad es una de tus variables principales, entonces puedes planear recopilar datos de personas de un amplio rango de edades. Debido a que la restricción de rango no siempre se anticipa o se puede evitar fácilmente, sin embargo, es una buena práctica examinar sus datos en busca de una posible restricción de rango e interpretar la r de Pearson a la luz de ella. (También existen métodos estadísticos para corregir la r de Pearson para la restricción de rango, pero están más allá del alcance de este libro).

La correlación no implica causalidad

Probablemente hayas escuchado repetidamente que “La correlación no implica causalidad”. Un ejemplo divertido de esto proviene de un estudio de 2012 que mostró una correlación positiva (r = 0.79 de Pearson) entre el consumo per cápita de chocolate de una nación y el número de premios Nobel otorgados a ciudadanos de esa nación [2]. Parece claro, sin embargo, que esto no significa que comer chocolate haga que la gente gane premios Nobel, y no tendría sentido tratar de aumentar el número de premios Nobel ganados recomendando que los padres alimenten más chocolate a sus hijos.

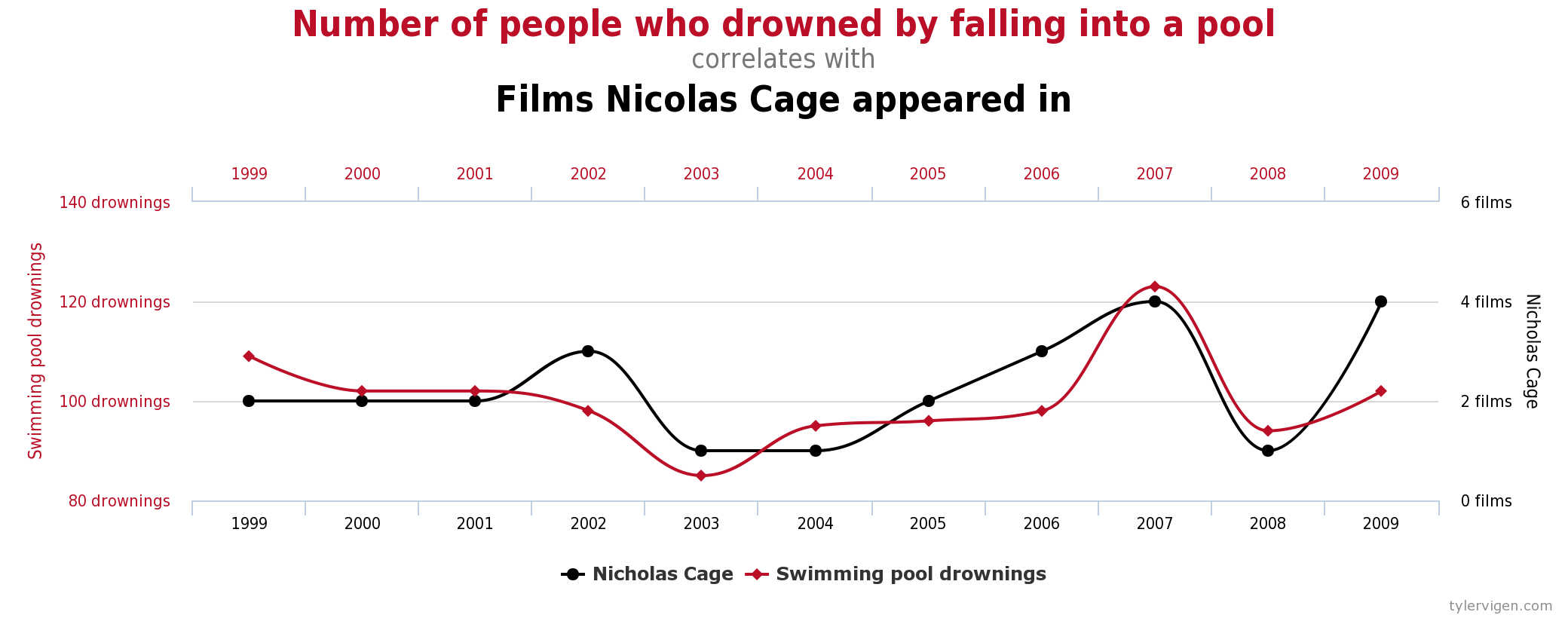

Hay dos razones por las que la correlación no implica causalidad. El primero se llama el problema de la direccionalidad. Dos variables, X e Y, pueden relacionarse estadísticamente porque X causa Y o porque Y causa X. Consideremos, por ejemplo, un estudio que demuestre que si las personas hacen ejercicio o no está estadísticamente relacionado con lo felices que son, de tal manera que las personas que hacen ejercicio son más felices en promedio que las personas que no lo hacen. Esta relación estadística es consistente con la idea de que el ejercicio causa felicidad, pero también es consistente con la idea de que la felicidad causa ejercicio. Quizás ser feliz le da más energía a la gente o la lleve a buscar oportunidades para socializar con los demás al ir al gimnasio. La segunda razón por la que la correlación no implica causalidad se llama el problema de la tercera variable. Dos variables, X e Y, pueden estar estadísticamente relacionadas no porque X causa Y, o porque Y causa X, sino porque alguna tercera variable, Z, causa tanto X como Y. Por ejemplo, el hecho de que las naciones que han ganado más premios Nobel tienden a tener un mayor consumo de chocolate probablemente refleja geografía en que los países europeos tienden a tener tasas más altas de consumo per cápita de chocolate e invierten más en educación y tecnología (una vez más, per cápita) que muchos otros países en el mundo. De igual manera, la relación estadística entre el ejercicio y la felicidad podría significar que alguna tercera variable, como la salud física, cause las dos otras. Estar físicamente sano podría hacer que las personas hagan ejercicio y hacer que sean más felices. Las correlaciones que son el resultado de una tercera variable a menudo se denominan correlaciones espurias.

Algunos ejemplos excelentes y divertidos de correlaciones espurias se pueden encontrar en http://www.tylervigen.com (La figura\(\PageIndex{6}\) proporciona uno de esos ejemplos).

Figura\(\PageIndex{6}\): Ejemplo de una Correlación Espuria. Fuente: http://tylervigen.com/spurious-correlations (CC-BY 4.0)

Figura\(\PageIndex{6}\): Ejemplo de una Correlación Espuria. Fuente: http://tylervigen.com/spurious-correlations (CC-BY 4.0)Referencias

- Bushman, B. J., & Huesmann, L. R. (2001). Efectos de la violencia televisada sobre la agresión. En D. Singer & J. Singer (Eds.), Manual de niños y medios de comunicación (pp. 223—254). Thousand Oaks, CA: Salvia.

- Messerli, F. H. (2012). Consumo de chocolate, función cognitiva y premios Nobel. New England Journal of Medicine, 367, 1562-1564.