15.3: Otros modelos cerebrales del lenguaje hablado y escrito

- Page ID

- 148188

- Contraste el modelo de Mesulam con el modelo Wernicke-Lichtheim-Geschwind del procesamiento cerebral del lenguaje

- Describir y explicar el modelo distribuido de procesamiento del lenguaje por el cerebro

- Explicar por qué en un paciente cerebral dividido los objetos presentados en el campo visual derecho son procesados por el lado izquierdo del cerebro y pueden identificarse verbalmente y por qué los objetos presentados en el campo visual izquierdo no pueden identificarse verbalmente

- Describir las principales evidencias y los hechos básicos de la lateralización cerebral

- Delinear el procesamiento auditivo y visual del lenguaje

- Describir las características y estructuras anatómicas involucradas en tres tipos de afasia

- Describir los tipos de alexia y agrafias y sus causas

- Explique brevemente lo que revela el procesamiento del lenguaje de señas, la música y otros sistemas simbólicos sobre el procesamiento del lenguaje

Visión general

En este módulo consideramos otros modelos de representación y función del lenguaje en el cerebro. El primero sigue el modelo locacionista tradicional que plantea circuitos específicos involucrados en el procesamiento del lenguaje. El segundo plantea la hipótesis de una visión no locacionista que enfatiza las redes distribuidas dedicadas al procesamiento paralelo del lenguaje.

Una alternativa al modelo Wernicke -Lichtheim -Geschwind

En la década de 1980, el neurólogo estadounidense Marsel Mesulam propuso una alternativa al modelo Wernicke-Lichtheim-Geschwind para comprender los circuitos del lenguaje cerebral. El modelo de Mesulam postula una jerarquía de redes en la que la información es procesada por niveles de complejidad.

Por ejemplo, cuando realizas procesos de lenguaje sencillos como recitar los meses del año en orden, las áreas motoras y premotoras para el lenguaje se activan directamente. Pero cuando haces una declaración que requiere de un análisis semántico y fonológico más extenso, entran en juego primero otras áreas.

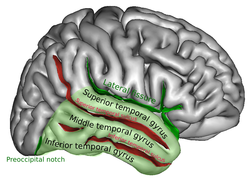

Cuando se escuchan palabras pronunciadas, son percibidas por la corteza auditiva primaria, luego procesadas por áreas asociativas unimodales de la corteza: los lóbulos temporales superior y anterior y la parte opercular de la circunvolución frontal inferior izquierda.

Figura\(\PageIndex{1}\): (Izquierda) Lóbulo temporal derecho. (Derecha) Área de Broca (hemisferio izquierdo) de la circunvolución frontal inferior dividida en pars triangularis (PTri, rojo) y pars opercularis (PoP, azul). PREC: Surco precentral. IFS: Surco frontal inferior. AsCSF Ramus ascendente de la fisura silviana. HzSF Ramus horizontal de fisura silviana (Imágenes y pie de foto para imagen a la derecha de Wikimedia Commons, recuperado 18/10/21).

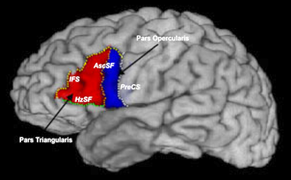

Según el modelo de Mesulam, estas áreas unimodales luego envían su información a dos sitios separados para su integración. Uno de ellos es el polo temporal del sistema paralimbic, que proporciona acceso al sistema de memoria a largo plazo y al sistema emocional. La otra es la porción terminal posterior del surco temporal superior, que proporciona acceso al significado. Las porciones triangulares y orbitales de la circunvolución frontal inferior también juegan un papel en el procesamiento semántico. Una idea importante en el modelo de Mesulam es que la función de un área cerebral dedicada al lenguaje no es fija sino que varía según el “contexto neural”. Es decir, la función de un área en particular depende de la tarea a realizar, ya que estas áreas no siempre activan las mismas conexiones entre ellas. Por ejemplo, la circunvolución frontal inferior izquierda interactúa con diferentes áreas dependiendo de si está procesando el sonido de una palabra o su significado.

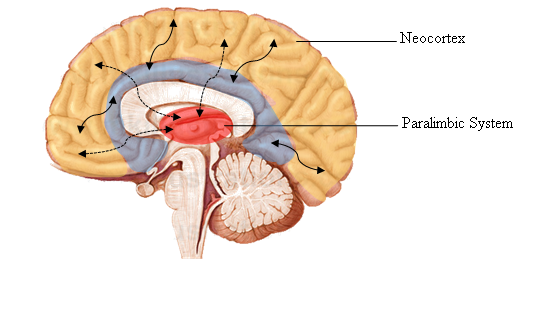

Figura\(\PageIndex{2}\): Sistema paralimbic, área de corteza de tres capas que consiste en la corteza piriforme, corteza entorrinal y corteza parahipocampal en la superficie medial del lóbulo temporal, y la corteza cingulada justo por encima del cuerpo calloso. La corteza paralimbic se encuentra cerca de las estructuras límbicas, y está directamente conectada con ellas. (Imagen, Wikimedia. Leyenda de Kolb & Whishaw: Fundamentos de la Neuropsicología Humana, 2003).

Este tipo de organización en red nos lleva más allá de la ecuación de “un área = una función” y explica muchos de los trastornos del lenguaje a veces altamente específicos. Por ejemplo, algunas personas no pueden decir los nombres de las herramientas o los colores de los objetos. Otras personas pueden explicar la función de un objeto sin poder decir su nombre, y viceversa.

Mesulam, sin embargo, todavía cree que hay dos “epicentros” para el procesamiento semántico, es decir, el área de Broca y el área de Wernicke. Esta nueva concepción de estas dos áreas es consistente con el hecho de que a menudo trabajan sincrónicamente cuando el cerebro está realizando una tarea de procesamiento de textos, lo que respalda la idea de que hay conexiones muy fuertes entre ellas.

El concepto de epicentros de Mesulam se asemeja al de las zonas de convergencia como lo proponen otros autores: zonas donde se puede combinar la información obtenida a través de diversas modalidades sensoriales. Este proceso combinatorio se logra a través de la formación de ensamblajes celulares: grupos de neuronas interconectadas cuyas sinapsis se han fortalecido por su disparo simultáneo, de acuerdo con la ley de Hebb. Este concepto de áreas del lenguaje como zonas de convergencia donde se establecen asambleas neuronales otorga así un lugar destacado a las influencias epigenéticas en el proceso de aprendizaje de una lengua.

Sin duda, una de estas zonas de convergencia es el lóbulo parietal inferior izquierdo, que comprende la circunvolución angular y la circunvolución supramarginal. Además de recibir información del hemisferio derecho, el lóbulo parietal inferior izquierdo también integra asociaciones emocionales de la amígdala y la circunvolución cingulada.

Algunos científicos creen que a lo largo de la evolución, el lenguaje permaneció bajo control límbico hasta que el lóbulo parietal inferior evolucionó y se convirtió en una zona de convergencia que proporciona una gran cantidad de insumos al área de Broca. Algunos científicos también piensan que fue la aparición del lóbulo parietal inferior lo que dio a los humanos la capacidad de descomponer los sonidos que escucharon para darles sentido y, a la inversa, expresar sonidos de manera secuencial para transmitir significado. De esta manera, las vocalizaciones emocionales y sociales primitivas eventualmente habrían llegado a regirse por reglas gramaticales de organización para crear lo que conocemos como lenguaje moderno.

Modelos Distribuidos de Función de Lenguaje

Por último, varios investigadores rechazan ahora los modelos locacionistas clásicos del lenguaje como el de Geschwind y el de Mesulam; en cambio, conceptualizan el lenguaje y las funciones cognitivas en general, como distribuidas en áreas anatómicamente separadas que procesan la información en paralelo (simultáneamente, en lugar de en serie, de un “área lingüística” a otra).

Incluso aquellos investigadores que abrazan esta visión de que la información lingüística se procesa en paralelo siguen aceptando que las funciones primarias del lenguaje, tanto auditivas como articulatorias, están localizadas en cierta medida.

Este concepto de red paralela y distribuida de procesamiento de información lingüística constituye un paradigma epistemológico distintivo que está llevando a la reevaluación de ciertos estudios de imágenes cerebrales funcionales (fMRI).

Los defensores de este paradigma creen que la activación extensiva de diversas áreas del hemisferio izquierdo y la gran cantidad de procesos psicológicos involucrados hacen imposible asociar funciones específicas del lenguaje con áreas anatómicas específicas del cerebro. Por ejemplo, el único acto de recordar palabras implica una red altamente distribuida que se localiza principalmente en el cerebro izquierdo y que incluye el lóbulo temporal inferolateral, el lóbulo parietal posterior inferior, las áreas premotoras del lóbulo frontal, giro cingulado anterior y área motora suplementaria. De acuerdo con este paradigma, con una red de procesamiento paralela tan ampliamente distribuida, no hay manera de atribuir funciones específicas a cada una de estas estructuras que contribuyen al desempeño de esta tarea.

El cerebro sí parece acceder a significados por medio de categorías que almacena en diferentes ubicaciones físicas. Por ejemplo, si se daña el polo temporal (el extremo anterior del lóbulo temporal), se pierde la categoría “gente famosa”; si ocurre una lesión en las partes intermedia e inferior del lóbulo temporal, la categoría “animales” desaparece. También parece que las redes involucradas en la codificación de palabras activan áreas en los sistemas motor y visual. La tarea de nombrar herramientas activa las áreas premotoras frontales, mientras que la de nombrar animales activa las áreas visuales. Pero en ambos casos, el área de Broca y el área de Wernicke ni siquiera están activadas.

Entre aquellos científicos que argumentan que el sistema de procesamiento del lenguaje del cerebro se distribuye a través de diversas estructuras, algunos, como Philip Lieberman, creen que los ganglios basales juegan un papel muy importante en el lenguaje. Estos investigadores creen además que otras estructuras subcorticales tradicionalmente consideradas involucradas en el control motor, como el cerebelo y el tálamo, también contribuyen al procesamiento del lenguaje. Estas opiniones se oponen a las de Chomsky sobre la naturaleza excepcional del lenguaje humano y caen directamente dentro de una perspectiva adaptacionista (enfatizando la selección natural), evolutiva.

Referencias

Mesulam, 2000 En: M.M. Mesulam, Editor, Principles of Behavioral and Cognitive Neurology (2nd ed.), Oxford University Press, Nueva York (2000)

Lateralización, Procesamiento del Lenguaje Auditivo y Visual

Introducción

¿Qué pasa dentro de mi cabeza cuando escucho una frase? ¿Cómo proceso las palabras escritas? Este capítulo analizará más de cerca los procesos cerebrales relacionados con la comprensión del lenguaje. Tratando con la comprensión del lenguaje natural, distinguimos entre el enfoque neurocientífico y el psicolingüístico. A medida que la comprensión del texto se extiende por el amplio campo de la psicología cognitiva, la lingüística y las neurociencias, nuestro enfoque principal se centrará en la intersección de dos últimas, que se conoce como neurolingüística.

Es necesario examinar diferentes áreas del cerebro para averiguar cómo se procesan las palabras y oraciones. Durante mucho tiempo los científicos estuvieron restringidos a sacar conclusiones de ciertas lesiones cerebrales a las funciones de las áreas cerebrales correspondientes. Durante los últimos 40 años se han establecido técnicas de imagen cerebral y medición de ERP que permiten una identificación más precisa de las partes cerebrales involucradas en el procesamiento del lenguaje.

Los estudios científicos sobre estos fenómenos generalmente se dividen en investigaciones sobre comprensión auditiva y visual del lenguaje; discutiremos ambos. No hay que olvidar es que no basta con examinar el inglés: Para entender el procesamiento del lenguaje en general, tenemos que mirar a los sistemas lingüísticos no indoeuropeos y otros como el lenguaje de señas. Pero antes que nada nos ocuparemos de una localización aproximada del lenguaje en el cerebro.

Lateralización del lenguaje

Aunque los estudios y análisis de lateralización funcional encuentran que las diferencias individuales en la personalidad o el estilo cognitivo no favorecen a un hemisferio ni al otro, algunas funciones cerebrales ocurren en uno u otro lado del cerebro. El lenguaje tiende a estar a la izquierda y la atención a la derecha (Nielson, Zielinski, Ferguson, Lainhart & Anderson, 2013). Hay mucha evidencia de que cada hemisferio cerebral tiene sus propias funciones distintas en la comprensión del lenguaje. La mayoría de las veces, el hemisferio derecho se conoce como el hemisferio no dominante y el izquierdo se ve como el hemisferio dominante. Esta distinción se llama lateralización (del vocablo latino lateral, que significa lateral) y la razón de ello se planteó primero mediante experimentos con pacientes de cerebro dividido. Siguiendo un enfoque de arriba hacia abajo discutiremos entonces el hemisferio derecho que podría tener el papel principal en la comprensión de nivel superior, pero no se entiende muy bien. Se han realizado muchas investigaciones en el hemisferio izquierdo y discutiremos por qué podría ser dominante antes de que en las siguientes secciones se discuta el procesamiento fundamental bastante bien entendido del lenguaje en este hemisferio del cerebro.

Asimetría funcional

Diferencias anatómicas entre el hemisferio izquierdo y derecho

Inicialmente consideraremos la parte más aparente de una diferenciación entre hemisferio izquierdo y derecho: Sus diferencias en forma y estructura. Como es visible a simple vista existe una clara asimetría entre las dos mitades del cerebro humano: El hemisferio derecho suele tener una región frontal más grande, más ancha y extendida que el hemisferio izquierdo, mientras que el hemisferio izquierdo es más grande, más ancho y se extiende más lejos en su región occipital (M. T. Banich, "Neuropsicología”, ch.3, pg.92). Significativamente más grande en el lado izquierdo en la mayoría de los cerebros humanos es cierta parte de la superficie del lóbulo temporal, que se llama planum temporale. Se localiza cerca del área de Wernicke y otras áreas de asociación auditiva, por lo que ya podemos especular que el hemisferio izquierdo podría estar más involucrado en procesos de tratamiento del lenguaje y del habla.

De hecho, tal lateralidad izquierda de las funciones del lenguaje es evidente en 97% de la población (D. Purves, “Neurociencia”, ch.26, pg.649). Pero en realidad el porcentaje de cerebros humanos, en el que se puede rastrear un “dominio izquierdo” del planum temporale, es solo del 67% (D. Purves, “Neurociencia”, ch.26, pg.648). Qué otros factores juegan aunresueltos todavía.

Evidencia de asimetría funcional en pacientes con “fractura cerebral”

En los casos duros de epilepsia, un método quirúrgico poco frecuente pero popular para reducir la frecuencia de las crisis epilépticas es la llamada callosotomía del cuerpo. Aquí se realiza un corte radical a través del “puente de comunicación” de conexión entre el hemisferio derecho e izquierdo, el cuerpo calloso; el resultado es un “cerebro dividido”. Para los pacientes cuyo cuerpo calloso se corta, se mitiga el riesgo de lesiones físicas accidentales, pero el efecto secundario es llamativo: Debido a esta transección erradicadora de la mitad izquierda y derecha del cerebro estos dos ya no son capaces de comunicarse adecuadamente. Esta situación brinda la oportunidad de estudiar la diferenciación de la funcionalidad entre los hemisferios. Los primeros experimentos con pacientes de cerebro dividido fueron realizados por Roger Sperry y sus colegas en el Instituto Tecnológico de California en 1960 y 1970 (D. Purves, “Neuroscience”, ch.26, pg.646). Llevan a los investigadores a conclusiones amplias sobre la lateralidad del habla y la organización del cerebro humano en general.

| Una digresión sobre la lateralidad del sistema visual |

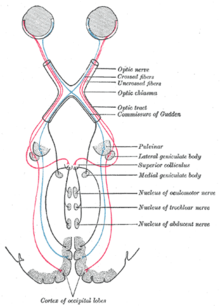

Figura\(\PageIndex{3}\): Sistema visual que muestra el cableado de cada mitad del ojo al cerebro. Un estímulo visual, localizado dentro del campo visual izquierdo, se proyecta sobre la parte nasal (interna) de la retina del ojo izquierdo y sobre la parte temporal (externa) de la retina del ojo derecho. Las imágenes en la región temporal de la retina se procesan en la corteza visual del mismo lado del cerebro (ipsilateral), mientras que la información de la retina nasal se mapea en la mitad opuesta del cerebro (contralateral). El estímulo dentro del campo visual izquierdo llegará completamente a la corteza visual derecha para ser procesado y trabajado. En cerebros “sanos” esta información llega además al hemisferio izquierdo a través del cuerpo calloso y puede integrarse allí. En pacientes con cerebro dividido esta corriente de señales se interrumpe; el estímulo permanece “invisible” para el hemisferio izquierdo. (Imagen de Wikimedia Commons; Archivo:Gray722.png; por Henry Vandyke Carter; Esta obra es de dominio público en Estados Unidos). |

Figura\(\PageIndex{4}\): Experimentos de cerebro dividido. (Imagen de Wikimedia Commons; Archivo:splitbrainexperiments.jpg; https://commons.wikimedia.org/wiki/F...xperiments.jpg; por TilmanaTuos en Wikilibros en inglés; liberada al dominio público por su autor).

El experimento que consideramos ahora se basa en la lateralidad del sistema visual: Lo que se ve en la mitad izquierda del campo visual se procesará en el hemisferio derecho y viceversa. Consciente de este principio un operador de prueba presenta la imagen de un objeto a la mitad del campo visual mientras se instruye al participante para nombrar el objeto visto, y que lo escoja ciegamente de una cantidad de objetos concretos con la mano contralateral.

Se puede demostrar que una imagen, por ejemplo el dibujo de un dado, que sólo se ha presentado al hemisferio izquierdo, puede ser nombrada por el participante (“Vi un dado”), pero no es seleccionable con la mano derecha (ni idea de qué objeto elegir de la tabla). Contrariamente el participante es incapaz de nombrar el dado, si fue reconocido en el hemisferio derecho, pero lo saca fácilmente del montón de objetos sobre la mesa con la ayuda de la mano izquierda.

Estos resultados son una clara evidencia de la asimetría funcional del cerebro humano. El hemisferio izquierdo parece dominar las funciones del procesamiento del habla y el lenguaje, pero es incapaz de manejar tareas espaciales como el reconocimiento de objetos independientes de la visión. El hemisferio derecho parece dominar las funciones espaciales, pero es incapaz de procesar palabras y significados de manera independiente. En un segundo experimento surgieron evidencias de que un paciente con cerebro dividido solo puede seguir una orden escrita (como “¡levántate ya!”) , si se presenta al hemisferio izquierdo. El hemisferio derecho sólo puede “entender” las instrucciones pictóricas.

La siguiente tabla (D. Purves, “Neurociencia”, ch.26, pg.647) da una distinción aproximada de funciones:

| Hemisferio Izquierdo | Hemisferio derecho |

|

|

En primer lugar es importante tener presente que estas distinciones comprenden únicamente dominaciones funcionales, no competencias exclusivas. En los casos de daño cerebral unilateral, muchas veces la mitad del cerebro se hace cargo de tareas del otro. Además, cabe mencionar que este experimento sólo funciona para estímulos presentados por menos de un segundo. Esto se debe a que no sólo el cuerpo calloso, sino también algunas comissures subcorticales sirven para la transferencia interhemisférica. En general ambos pueden contribuir simultáneamente al rendimiento, ya que utilizan roles complementarios en el procesamiento.

| Una digresión sobre la mano |

|

Un tema importante, al explorar la diferente organización cerebral en los dos hemisferios, es la mano, que es la tendencia a utilizar la mano izquierda o la derecha para realizar actividades. A lo largo de la historia, los zurdos, que solo comprenden alrededor del 10% de la población, a menudo han sido considerados como algo anormal. Se decía que eran malvados, tercos, desafiantes y fueron, incluso hasta mediados del siglo XX, obligados a escribir con la mano derecha. Una idea más comúnmente aceptada, en cuanto a cómo la mano afecta a los hemisferios, es la división del trabajo del hemisferio cerebral. Dado que tanto el hablar como el trabajo manual requieren habilidades motoras finas, la presunción aquí es que sería más eficiente que un hemisferio cerebral hiciera ambas cosas, en lugar de dividirlo. Dado que en la mayoría de las personas, el lado izquierdo del cerebro controla el habla, predomina la diestra. La teoría también predice que las personas zurdas tienen una división cerebral inversa del trabajo. En diestros, el procesamiento verbal se realiza principalmente en el hemisferio izquierdo, mientras que el procesamiento visuoespacial se realiza principalmente en el hemisferio opuesto. Por lo tanto, 95% de la salida del habla está controlada por el hemisferio izquierdo del cerebro, mientras que solo el 5% de los individuos controlan la salida del habla en su hemisferio derecho. Los zurdos, por otro lado, tienen una organización cerebral heterogénea. Su hemisferio cerebral está organizado de la misma manera que los diestros, de la manera opuesta, o incluso de tal manera que ambos hemisferios se utilizan para el procesamiento verbal. Pero generalmente, en 70% de los casos, el habla es controlada por el hemisferio izquierdo, 15% por el derecho y 15% por cualquiera de los dos hemisferios. Cuando el promedio se toma a través de todos los tipos de zurdos, parece que los zurdos están menos lateralizados. Después de que, por ejemplo, el daño ocurre en el hemisferio izquierdo, se deduce que existe un déficit visuoespacial, que suele ser más severo en zurdos que en diestros. Las diferencias pueden derivar, en parte, de las diferencias en la morfología cerebral, lo que concluye a partir de asimetrías en el planum temporale. Aún así, se puede suponer que los zurdos tienen menos división del trabajo entre sus dos hemisferios que los diestros y es más probable que carezcan de asimetrías neuroanatómicas. Ha habido muchas teorías en cuanto a averiguar por qué las personas son zurdas y cuáles pueden ser sus consecuencias. Algunas personas dicen que los zurdos tienen una vida más corta o mayores tasas de accidentes o trastornos autoinmunes. Según la teoría de Geschwind y Galaburda, existe una relación con las hormonas sexuales, el sistema inmunológico, y perfiles de habilidades cognitivas que determinan, si una persona es zurda o no. En conclusión, se han propuesto muchos modelos genéticos, sin embargo, las causas y consecuencias siguen siendo un misterio (M.T.Banich, “Neuropsicología”, ch.3, pág. 119). |

El hemisferio derecho

El papel del hemisferio derecho en la comprensión de textos

Los experimentos con pacientes con “cerebro dividido” y la evidencia que se discutirá pronto sugieren que el hemisferio derecho generalmente no es dominante en la comprensión del lenguaje (pero en algunos casos, por ejemplo, el 15% de las personas zurdas). Lo que más a menudo se atribuye al hemisferio derecho es el funcionamiento cognitivo. Cuando se hace daño a esta parte del cerebro o cuando se eliminan regiones temporales del hemisferio derecho, esto puede conducir a problemas de comunicación cognitiva, como deterioro de la memoria, problemas de atención y mal razonamiento (L. Cherney, 2001). Las investigaciones conducen a la conclusión de que el hemisferio derecho procesa la información de manera gestáltica y holística, con especial énfasis en las relaciones espaciales. Aquí, surge una ventaja para diferenciar dos caras distintas porque examina las cosas de manera global y también reacciona a menor frecuencia espacial, y también auditiva. El primer punto puede ser socavado con el hecho de que el hemisferio derecho es capaz de leer palabras más concretas y puede hacer comparaciones gramaticales simples (M. T. Banich, “Neuropsicología “, ch.3, pg.97). Pero para funcionar de tal manera, debe haber algún tipo de comunicación entre las mitades cerebrales.

Prosodia - la envolvente sonora alrededor de las palabras

Considera cuán diferente podría interpretarse la simple afirmación “Ella lo hizo de nuevo” en el siguiente contexto tomado de Banich: LYNN: Alice está muy metida en esta cosa del ciclismo de montaña. Después de romperle el brazo, pensarías que sería un poco más cautelosa. Pero entonces ayer, ella salió y montó el capitán Jack's. Ese sendero es retorcido, estrecho con muchas raíces de árboles y rocas. Y anoche, oí que se dio una mala caída en su camino hacia abajo. SARA: Lo volvió a hacer ¿Dice Sara eso con tono ascendente o enfáticamente y con entonación descendente? En el primer caso preguntaría si Alice se ha vuelto a lesionar. En el otro caso afirma algo que sabe o imagina: Que Alice logró lastimarse por segunda vez. Obviamente el envolvente sonoro alrededor de las palabras -prosodia- sí importa.

La razón para creer que el reconocimiento de patrones prosódicos aparece en el hemisferio derecho surge cuando se toman en cuenta pacientes que tienen daños en una región anterior del hemisferio derecho. Sufren de discurso aprosódico, es decir, sus enunciados están todos al mismo tono. Podrían sonar como un robot de los 80. Hay otro fenómeno que aparece a partir del daño cerebral: el habla disprosódica. En ese caso el paciente habla con entonación desordenada. Esto no se debe a una lesión del hemisferio derecho, sino que surge cuando se sufre daño en el hemisferio izquierdo. La explicación es que el hemisferio izquierdo da señales prosódicas inoportunas al hemisferio derecho, por lo que se ve afectada la entonación adecuada.

Más allá de las palabras: Inferencia desde un punto de vista neurológico

A nivel de palabras, los estudios actuales son en su mayoría consistentes entre sí y con hallazgos de estudios de lesiones cerebrales. Pero cuando se trata de la comprensión más compleja de oraciones enteras, textos e historias, los hallazgos se dividen. Según la revisión de E. C. Ferstl “La neuroanatomía de la comprensión textual. ¿Cuál es la historia hasta ahora?” (2004), hay evidencia a favor y en contra de las regiones del hemisferio derecho que desempeñan un papel clave en la pragmática y la comprensión de textos. Sobre el estado actual del conocimiento, no podemos decir exactamente cómo y dónde funcionan las funciones cognitivas como construir modelos de situación e inferencias, junto con procesos de lenguaje “puro”.

Como este capítulo se refiere a la neurología del lenguaje, cabe remarcar que los pacientes con daño del hemisferio derecho tienen dificultades para inferir. Toma en cuenta la siguiente frase:

Con mosquitos, jejenes y saltamontes volando por todas partes, se encontró con un pequeño insecto negro que estaba siendo utilizado para espiar su conversación.

Tal vez tengas que reinterpretar la frase hasta que te des cuenta de que “pequeño insecto negro” no se refiere a un animal sino a un dispositivo espía. Las personas con daños en el hemisferio derecho tienen problemas para hacerlo. Tienen dificultad para seguir el hilo de una historia y hacer inferencias sobre lo que se ha dicho. Además les cuesta entender aspectos no literales de oraciones como metáforas, por lo que podrían estar realmente horrorizados cuando escuchan que alguien estaba “llorando con los ojos”.

Se remite al lector al siguiente capítulo para una discusión detallada de Modelos de Situación

El hemisferio izquierdo

Evidencia adicional del dominio del hemisferio izquierdo: La técnica de Wada

Antes en cuanto a la funcionalidad concreta del hemisferio izquierdo, se proporciona más evidencia del dominio del hemisferio izquierdo. De relevancia es la llamada técnica Wada, que permite probar qué hemisferio es responsable de la salida del habla y generalmente se usa en pacientes con epilepsia durante la cirugía. No es una técnica de imagen cerebral, sino que simula una lesión cerebral. Uno de los hemisferios es anestesiado inyectando un barbitúrico (amobarbital sódico) en una de las arterias carótidas del paciente. Después se le pide que nombre una serie de artículos en las tarjetas. Cuando no es capaz de hacer eso, a pesar de que podría hacerlo una hora antes, se dice que el hemisferio afectado es el responsable de la salida del discurso. Esta prueba debe hacerse dos veces, ya que existe la posibilidad de que el paciente produzca el habla bilateralmente. La probabilidad para eso no es muy alta, de hecho, según Rasmussen & Milner 1997a (como se menciona en Banich, p. 293) ocurre sólo en 15% de los zurdos y ninguno de los diestros. (Todavía no está claro de dónde provienen estas diferencias en el cerebro de los zurdos).

Eso significa que en la mayoría de las personas, solo un hemisferio “produce” la salida del habla —y en 96% de los diestros y 70% de los zurdos, es el izquierdo. Los hallazgos de los estudios de lesión cerebral sobre asimetría se confirmaron aquí: Normalmente (en diestros sanos), el hemisferio izquierdo controla la salida del habla.

Explicaciones del dominio del hemisferio izquierdo

Todavía se discuten dos teorías por las que el hemisferio izquierdo podría tener capacidades lingüísticas especiales. El primero afirma que la dominación del hemisferio izquierdo se debe a una especialización para el control temporal preciso de los articuladores orales y manuales. Aquí el argumento principal es que los gestos relacionados con una historia se realizan con mayor frecuencia con la mano derecha y por lo tanto con la mano controlada del hemisferio izquierdo mientras que otros movimientos de la mano aparecen igualmente a menudo con ambas manos. La otra teoría dice que el hemisferio izquierdo es dominante porque está especializado para el procesamiento lingüístico y se debe a un solo paciente, un hablante de Lenguaje de Señas Americano con una lesión del hemisferio izquierdo. No podía producir ni comprender ASL, pero aún así podía comunicarse usando gestos en dominios no lingüísticos.

¿Qué tan innata es la estructura organizativa del cerebro?

No solo los casos de zurdos sino también las técnicas de imagen cerebral han mostrado ejemplos de procesamiento bilateral del lenguaje: Según estudios ERP (por Bellugi et al. 1994 y Neville et al. 1993 como se cita en E. Dabrowska, “Language, Mind an Brain” 2004, p. 57), las personas con el síndrome de Williams (WS) tampoco tienen hemisferio dominante para el lenguaje. Los pacientes con WS tienen muchos trastornos físicos y mentales, pero muestran, en comparación con sus otras (malas) habilidades cognitivas, muy buenas habilidades lingüísticas. Y estas habilidades no dependen de un hemisferio dominante, sino que ambas contribuyen por igual. Entonces, mientras que la mayoría de la población tiene un hemisferio izquierdo dominante para el procesamiento del lenguaje, hay una variedad de excepciones a ese dominio. Que existen diferentes “posibilidades de organización” en los cerebros individuales Dabrowska (p. 57) sugiere que la estructura organizativa en el cerebro podría ser menos innata y fija como se piensa comúnmente.

Procesamiento del Lenguaje Auditivo

En esta sección se explicará dónde y cómo se procesa el lenguaje. Para evitar intersecciones con procesos visuales, primero nos concentraremos en el lenguaje hablado. Los científicos han desarrollado tres enfoques para concebir información sobre este tema. Los dos primeros enfoques se basan en lesiones cerebrales, es decir, la afasia, mientras que el enfoque reciente se basa en resultados de técnicas modernas de imagen cerebral.

Perspectiva Neurológica

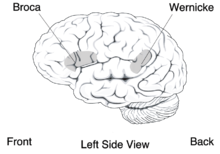

La Perspectiva Neurológica describe qué vías sigue el lenguaje para ser comprendido. Los científicos revelaron que hay áreas concretas dentro del cerebro donde se están llevando a cabo tareas concretas de procesamiento del lenguaje. Las zonas más conocidas son la de Broca y la zona de Wernicke.

Afasia de Broca

Figura\(\PageIndex{5}\): El área de Broca's y Wernicke (Imagen de Wikimedia Commons; Archivo:BrocasareasMall.png; https://commons.wikimedia.org/wiki/F...sAreaSmall.png; dominio público en Estados Unidos por tratarse de una obra elaborada por un funcionario o empleado de la Gobierno de los Estados Unidos como parte de los deberes oficiales de esa persona.

Una de las afasias más conocidas es la afasia de Broca que provoca que los pacientes no puedan hablar con fluidez. Además tienen una gran dificultad para producir palabras. La comprensión, sin embargo, es relativamente intacta en esos pacientes. Debido a que estos síntomas no resultan de problemas motrices de la musculatura vocal, una región del cerebro que es responsable de la salida lingüística debe lesionarse. Broca descubrió que la región cerebral que causa el habla fluida es responsable de la salida lingüística, debe ubicarse ventralmente en el lóbulo frontal, anterior a la tira motora. Investigaciones recientes sugieren que la afasia de BROCA es el resultado también del tejido subcortical y de la materia blanca y no solo del tejido cortical.

| Ejemplo de Discurso espontáneo - Tarea: ¿Qué ves en esta imagen? |

|---|

| “Oh, sí. Det es un niño y una niña... an'... un... auto... casa... luz po' (polo). Perro an' a... bote. ‚N det es un... mm... un... café, un' lectura. Det es un... mm... a... det es un niño... pescando'. “(Adaptado de “Principles of Neuroscience” 4ta edición, 2000, p 1178) |

La afasia de Wernicke

Otra afasia muy famosa, conocida como la afasia de Wernicke, causa síndromes opuestos. Los pacientes que sufren de afasia de Wernicke suelen hablar con mucha fluidez, las palabras se pronuncian correctamente, pero se combinan sin sentido — “ensalada de palabras” es la forma en que se describe con mayor frecuencia. Entender lo que dicen los pacientes de afasia de Wernick es especialmente difícil, porque usan parafasias (sustitución de una palabra en parafasia verbal, de palabra con significado similar en parafasia semántica, y de un fonema en parafasia fonémica) y neologismos. Con la afasia de Wernicke la comprensión de oraciones simples es una tarea muy difícil. Además, su capacidad para procesar la entrada del lenguaje auditivo y también el lenguaje escrito se ve afectada. Con algunos conocimientos sobre la estructura cerebral y sus tareas se puede concluir que el área que causa la afasia de Wernicke, está situada en la articulación de las regiones temporal, parietal y occipital, cerca de la circunvolución de Heschl (área auditiva primaria), porque todas las áreas que reciben e interpretan información sensorial (corteza posterior), y aquellos que conectan la información sensorial con el significado (lóbulo parietal) probablemente estén involucrados.

| Ejemplo de Discurso espontáneo - Tarea: ¿Qué ves en esta imagen? |

|---|

| “Ah, sí, es ah... varias cosas. Es una chica... desenroscar... en un bote. Un perro... 'S es otro perro... uh-oh... long's... en un barco. La señora, es una jovencita. An' un hombre a Estaban comiendo'. ES ser lugar ahí. Esto... ¡un árbol! Un barco. No, esto es un... Es una casa. Por aquí... un pastel. An' es, es mucha agua. Ah, bien. Creo que mencioné sobre ese barco. Noté que había un barco ahí. Sí mencioné eso antes... Varias cosas abajo, cosas diferentes abajo... un murciélago... un pastel... tienes un... “(adaptado de “Principles of Neuroscience” 4ta edición, 2000, p 1178) |

Afasia de conducción

Wernicke supuso que una afasia entre el área de Broca y la zona de Wernicke, a saber, la afasia de conducción, llevaría a graves problemas para repetir frases recién escuchadas en lugar de tener problemas con la comprensión y producción del habla. De hecho, los pacientes que sufren de este tipo de afasia muestran una incapacidad para reproducir oraciones ya que a menudo hacen parafasias fonémicas, pueden sustituir o dejar fuera palabras, o podrían no decir nada. Las investigaciones determinaron que el “cable de conexión”, es decir, el fasciculo arqueado entre el área de Wernicke y Broca, está casi invariablemente dañado en caso de una afasia de conducción. Es por ello que la afasia de conducción también es considerada como un síndrome de desconexión (la disfunción conductual debido a un daño en la conexión de dos regiones cerebrales conectadas).

| Ejemplo de la repetición de la frase “El pastelero estaba eufórico”: |

|---|

| “El panadero era /vaskerin/... uh...” (adaptado de “Principles of Neuroscience” 4ta edición, 2000, p 1178) |

Afasia motora transcortical y afasia global

La afasia motora transcortical, otra lesión cerebral causada por una interrupción de la conexión, es muy similar a la afasia de Broca, con la diferencia de que se mantiene la capacidad de repetición. De hecho, las personas con una afasia motora transcortical suelen sufrir de ecolalia, la necesidad de repetir lo que acaban de escuchar. Por lo general, el cerebro de los pacientes se daña fuera del área de Broca, a veces más anterior y a veces más superior. Los individuos con afasia sensorial transcortical presentan síntomas similares a los que padecen afasia de Wernicke, excepto que muestran signos de ecolalia. Las lesiones en grandes partes del hemisferio izquierdo conducen a una afasia global y, por lo tanto, a una incapacidad tanto para comprender como para producir el lenguaje, ya que no solo se daña el área de Broca o Wenicke. (Barnich, 1997, págs. 276 a 282)

| Tipo de afasia | Habla Espontánea | Parafasia | Comprensión | Repetición | Nombramiento |

|

|

|

|

|

|

Visión general de los efectos de la afasia desde la perspectiva neurológica

(Adaptado de Benson, 1985, p. 32 como se cita en Barnich, 1997, p. 287)

Perspectiva Psicológica

Desde la década de 1960 los psicólogos y psicolingüistas intentaron resolver cómo se organiza y representa el lenguaje dentro del cerebro. Los pacientes con afasias dieron buena evidencia de ubicación y discriminación de las tres partes principales de la comprensión y producción del lenguaje, a saber, fonología, sintaxis y semántica.

Fonología

La fonología se ocupa del procesamiento de partes significativas del discurso resultantes del mero sonido. Más allá existe una diferenciación entre una representación fonémica de un sonido de voz que son las unidades más pequeñas de sonidos que conducen a diferentes significados (por ejemplo, el /b/ y /p/ en bet y pat) y la representación fonética. Esto último significa que un sonido de voz puede producirse de una manera diferente en diferentes situaciones. Por ejemplo el /p/ en píldora suena diferente al /p/ en derrame ya que el primero /p/ es aspirado y el segundo no.

Al examinar qué partes son responsables de la representación fonética, se puede comparar a los pacientes con afasia de Broca o Wernicke. Como la característica del habla para los pacientes con afasia de Broca es no fluida, es decir, tienen problemas para producir la correcta representación fonética y fonémica de un sonido, y las personas con afasia de Wernicke no muestran ningún problema para hablar con fluidez, sino que también tienen problemas para producir el fonema correcto. Esto indica que el área de Broca está involucrada principalmente en la producción fonológica y también, que la representación fonémica y fonética no tienen lugar en la misma parte del cerebro. Los científicos examinaron en un nivel más preciso la producción del habla, a nivel de las características distintivas de los fonemas, para ver en qué rasgos los pacientes con afasia cometieron errores.

Una característica distintiva describe las diferentes maneras y lugares de articulación. /t/ (como en contacto) y /s/ (como en tal) por ejemplo se crean en el mismo lugar pero se producen de manera diferente. /t/ y /d/ se crean en el mismo lugar y de la misma manera pero difieren en la voz.

Los resultados muestran que tanto en los pacientes con afasia fluida como en los no fluentes suelen mezclar solo una característica distintiva, no dos. En general se puede decir que los errores relacionados con el lugar de articulación son más comunes que los vinculados a la sonoridad. Curiosamente, algunos pacientes con afasia son muy conscientes de las diferentes características de dos fonemas, pero son incapaces de producir el sonido correcto. Esto sugiere que aunque los pacientes tienen grandes dificultades para pronunciar correctamente las palabras, su comprensión de las palabras sigue siendo bastante buena. Esto es característico para los pacientes con afasia de Broca, mientras que aquellos con afasia de Wernicke muestran síntomas contrarios: son capaces de pronunciar palabras correctamente, pero no pueden entender lo que significan las palabras. Es por ello que a menudo pronuncian palabras fonológicamente correctas (neologismos) que no son palabras reales con sentido.

Sintaxis

La sintaxis describe las reglas de cómo deben organizarse las palabras para dar lugar a oraciones significativas. Los humanos en general suelen conocer la sintaxis de su lengua materna y así deslizarse la lengua si una palabra pasa a estar fuera de orden en una oración. Las personas con afasia, sin embargo, suelen tener problemas con el análisis de oraciones, no sólo con respecto a la producción del lenguaje sino también con respecto a la comprensión de oraciones. Los pacientes que muestran incapacidad de comprensión y producción de oraciones suelen tener algún tipo de afasia anterior, también llamada afasia agramática. Esto se puede revelar en pruebas con oraciones. Estos pacientes no pueden distinguir fácilmente entre voz activa y pasiva si tanto el agente como el objeto pudieran desempeñar un papel activo. Por ejemplo los pacientes no ven diferencia entre “El niño persiguió a la niña” y “El niño fue perseguido por la niña”, pero sí entienden tanto “El niño vio la manzana” como “La manzana fue vista por el niño”, porque pueden buscar ayuda de semántica y no tienen que depender solo de la sintaxis. Los pacientes con afasia posterior, como por ejemplo la afasia de Wernicke, no muestran estos síntomas, ya que su habla es fluida. La comprensión por simples medios sintácticos también sería posible, pero también se debe considerar el aspecto semántico. Esto se discutirá en la siguiente parte.

Semántica

Semántica trata sobre el significado de las palabras y oraciones. Se ha demostrado que los pacientes que sufren de afasia posterior tienen graves problemas para entender textos simples, aunque su conocimiento de la sintaxis está intacto. La deficiencia semántica a menudo se examina mediante una Prueba Token, prueba en la que los pacientes tienen que señalar objetos referidos en oraciones simples. Como se podría haber adivinado, las personas con afasia anterior no tienen problemas con la semántica, pero es posible que no puedan entender oraciones más largas porque el conocimiento de la sintaxis también está involucrado.

| Afasia anterior (por ejemplo, Broca) | Afasia posterior (por ejemplo, Wernicke) | |

| Fonología | representación fonética y fonémica afectada | representación fonémica afectada |

| Sintaxis | afectados | sin efecto |

| Sintaxis | sin efecto | afectados |

Panorama de los efectos de la afasia desde la perspectiva psicológica

En estudios generales con personas lesionadas han demostrado que se necesitan áreas anteriores para la salida del habla y regiones posteriores para la comprensión del habla. Como se mencionó anteriormente, las regiones anteriores también son más importantes para el procesamiento sintáctico, mientras que las regiones posteriores están involucradas en el procesamiento semántico. Pero una división tan estricta de las partes del cerebro y sus responsabilidades no es posible, porque las regiones posteriores deben ser importantes para algo más que la comprensión de oraciones, ya que los pacientes con lesiones en esta área no pueden comprender ni producir ningún habla. (Barnich, 1997, págs. 283-293)

Evidencia de Métodos Avanzados de Neurociencia

La medición de las funciones tanto de cerebros normales como dañados ha sido posible desde la década de 1970, cuando se desarrollaron las primeras técnicas de imagen cerebral. Con ellos, somos capaces de “ver cómo funciona el cerebro” mientras el sujeto es, por ejemplo, escuchando una broma. Estos métodos (descritos con mayor detalle en el capítulo 4) muestran si los hallazgos anteriores son correctos y precisos.

Generalmente, las imágenes muestran que ciertas regiones cerebrales funcionales son mucho más pequeñas de lo estimado en estudios de lesiones cerebrales, y que sus límites son más distintos (cf. Banich p. 294). La ubicación exacta varía individualmente, por lo tanto, reunir los resultados de muchos estudios de lesiones cerebrales causó regiones funcionales estimadas demasiado grandes antes. Por ejemplo, estimular el tejido cerebral eléctricamente (durante la cirugía de epilepsia) y observar el resultado (por ejemplo, errores en las tareas de nomenclatura) condujo a un conocimiento mucho mejor dónde se encuentran las áreas de procesamiento del lenguaje.

Los estudios de PET (Fiez & Petersen, 1993, como se cita en Banich, p. 295) han demostrado que de hecho tanto las regiones anterior como posterior se activaron en la comprensión y procesamiento del lenguaje, pero con diferentes fortalezas —de acuerdo con los estudios de lesiones. Cuanto más activa se requiere la producción de voz en los experimentos, más frontal es la activación principal: Por ejemplo, cuando las palabras presentadas deben repetirse.

Otro resultado (Raichle et al. 1994, como se menciona en Banich, p. 295) fue que la familiaridad de los estímulos juega un papel importante. Cuando a los sujetos se les presentaron conjuntos de estímulos conocidos en tareas experimentales bien conocidas y tuvieron que repetirlos, se activaron las regiones anteriores. Se sabía que esas regiones causaban afasia de conducción cuando se dañaban. Pero cuando las palabras eran nuevas, y/o los sujetos nunca antes tuvieron que hacer una tarea como esta, la activación se registró más posterior. Eso quiere decir, cuando repites una palabra inesperada, el tejido cerebral más pesado que trabaja está en algún lugar debajo de tu orejera superior izquierda, pero cuando sabías esta palabra que sería la siguiente en repetir antes, está un poco más cerca de tu ojo izquierdo.

Procesamiento de Lenguaje Visual

El procesamiento del lenguaje escrito se realiza cuando estamos leyendo o escribiendo y se piensa que sucede en una unidad de procesamiento neuronal distinta a la del procesamiento del lenguaje auditivo. La lectura y la escritura se basan respectivamente en la visión, mientras que el lenguaje hablado es mediado primero por el sistema auditivo. Los sistemas lingüísticos responsables del procesamiento del lenguaje escrito tienen que interactuar con un sistema sensorial diferente al involucrado en el procesamiento del lenguaje hablado.

El procesamiento del lenguaje visual en general comienza cuando las formas visuales de las letras (“c” o “C” o “c”) se mapean en identidades de letras abstractas. Estos se mapean luego en una forma de palabra y la representación semántica correspondiente (el “significado” de la palabra, es decir, el concepto detrás de ella). Las observaciones de pacientes que perdieron la capacidad del lenguaje debido a un daño cerebral condujeron a diferentes patrones de enfermedad que indicaron una diferencia entre la percepción (lectura) y la producción (escritura) del lenguaje visual al igual que se encuentra en el procesamiento del lenguaje no visual.

Los pacientes aléxicos poseen la capacidad de escribir sin poder leer mientras que los pacientes con agrafias son capaces de leer pero no pueden escribir. Aunque la alexia y la agrafia a menudo ocurren juntas como resultado de un daño en la circunvolución angular, hubo pacientes que tenían alexia sin agrafia (por ejemplo, Greenblatt 1973, como se cita en M. T. Banich, “Neuropsicología “, p. 296) o que tenían agrafia sin alexia (por ejemplo, Hécaen & Kremin, 1976, como se cita en M. T. Banich, “Neuropsicología “, p. 296). Se trata de una doble disociación que sugiere sistemas de control neuronal separados para lectura y escritura.

Dado que las disociaciones dobles también se encuentran en la dislexia fonológica y superficial, los resultados experimentales apoyan la teoría de que la producción del lenguaje y la percepción respectivamente se subdividen en circuitos neuronales separados. El modelo de dos rutas muestra cómo se cree que estos dos circuitos neuronales proporcionan vías de las palabras escritas a los pensamientos y de los pensamientos a las palabras escritas.

Modelo de dos rutas

Figura\(\PageIndex{6}\): Cada ruta deriva el significado de una palabra o la palabra de un significado de una manera diferente, dependiendo de la familiaridad de las palabras. (Imagen de Wikimedia Commons; Archivo:1 1 twoRouteModelInReading.JPG; https://commons.wikimedia.org/wiki/F...lInReading.JPG; por TilmanaTuos en en.wikibooks; licenciado bajo Licencia de Documentación Libre de GNU.).

En esencia, el modelo de dos rutas contiene dos rutas. Cada uno de ellos deriva el significado de una palabra o la palabra de un significado de una manera diferente, dependiendo de lo familiarizados que estemos con la palabra.

Utilizar la ruta fonológica significa tener un paso intermedio entre percibir y comprender el lenguaje escrito. Este paso intermedio tiene lugar cuando estamos haciendo uso de reglas de grafema a fonema. Las reglas de grafema a fonema son una forma de determinar la representación fonológica de un grafema dado. Un grafema es la unidad escrita más pequeña de una palabra (por ejemplo, “sh” en “shore”) que representa un fonema. Un fonema por otro lado es la unidad fonológica más pequeña de una palabra que la distingue de otra palabra que de otra manera suena igual (por ejemplo, “murciélago” y “gato”). Las personas que aprenden a leer o se encuentran con nuevas palabras suelen utilizar la ruta fonológica para llegar a una representación de significado. Construyen fonemas para cada grafema y luego combinan los fonemas individuales a un patrón sonoro que se asocia con cierto significado (ver 1.1).

Se supone que la ruta directa funciona sin una representación fonológica intermedia, por lo que la impresión se asocia directamente con el significado de la palabra. Una situación en la que se tiene que tomar la ruta directa es al leer una palabra irregular como “coronel”. La aplicación de reglas de grafema a fonema conduciría a una representación fonológica incorrecta.

Según Taft (1982, como se menciona en M. T. Banich, “Neuropsicología “, p. 297) y otros se supone que la ruta directa es más rápida que la vía fonológica ya que no hace uso de un “desvío fonológico” y por lo tanto se dice que se utiliza para palabras conocidas (ver 1.1). Sin embargo, esto es solo un punto de vista y otros, como Chastain (1987, como se menciona en M. T. Banich, “Neuropsicología “, p. 297), postulan una dependencia de la ruta fonológica incluso en lectores expertos.

El procesamiento del lenguaje escrito en la lectura

Figura\(\PageIndex{7}\): Los efectos de regularidad son comunes en casos de alexia superficial. (Imagen de Wikimedia Commons; Archivo:1 2 TwoRouteModelIrregularWords.JPG; https://commons.wikimedia.org/wiki/F...gularWords.JPG; por TilmanaTuos en en.wikibooks; licenciado bajo Licencia de Documentación Libre de GNU.).

Se pudieron diferenciar varios tipos de alexia, muchas veces dependiendo de si la vía fonológica o la ruta directa estaba alterada. Los pacientes con lesiones cerebrales participaron en experimentos donde tuvieron que leer palabras y no palabras, así como palabras irregulares. La lectura de no palabras por ejemplo requiere el acceso a la ruta fonológica ya que no puede haber un significado “almacenado” o una representación sonora para esta combinación de letras.

Los pacientes con una lesión en estructuras temporales del hemisferio izquierdo (la ubicación exacta varía) sufren de la llamada alexia superficial. Muestran los siguientes síntomas característicos que sugieren una fuerte dependencia de la ruta fonológica: Muy comunes son los efectos de regularidad, es decir, una mala pronunciación de palabras en las que la ortografía es irregular como “coronel” o “yate” (ver 1.2). Estas palabras se pronuncian de acuerdo con las reglas de grafema a fonema, aunque en algunos casos se pueden conservar palabras de ortografía irregular de alta frecuencia, la pronunciación según la ruta fonológica es simplemente incorrecta.

Además, la posible pronunciación de una palabra se refleja en errores de lectura y comprensión. Cuando se le pidió que describiera el significado de la palabra “oso”, las personas que padecían alexia superficial responderían algo así como “una bebida” porque el patrón sonoro resultante de “oso” era el mismo para estas personas que el de “cerveza”. Esta característica va junto con una tendencia a confundir homófonos (palabras que suenan igual pero que se escriben de manera diferente y tienen diferentes significados asociados). Sin embargo, estas personas siguen siendo capaces de leer no palabras con una ortografía regular ya que pueden aplicarles reglas de grafema a fonema.

Figura\(\PageIndex{8}\): Los pacientes con alexia fonológica tienen que confiar en la ruta directa. (Imagen de Wikimedia Commons; Archivo:1 3 TwoRouteModelNonWords.JPG; https://commons.wikimedia.org/wiki/F...elNonWords.JPG; por TilmanaTuos en en.wikibooks; licenciado bajo Licencia de Documentación Libre de GNU.).

En contraste, la alexia fonológica se caracteriza por una alteración en la ruta fonológica debido a lesiones en estructuras temporales más posteriores del hemisferio izquierdo. Los pacientes pueden leer palabras familiares regulares e irregulares haciendo uso de información almacenada sobre el significado asociado a esa forma visual en particular (por lo que no hay efecto de regularidad como en la alexia superficial). No obstante, son incapaces de procesar palabras desconocidas o no palabras, ya que tienen que depender de la ruta directa (ver 1.3).

También son comunes los efectos de clase de palabras y los errores morfológicos. Los sustantivos, por ejemplo, se leen mejor que las palabras funcionales y a veces incluso mejores que los verbos. Los afijos que no cambian la clase gramatical o el significado de una palabra (afijos infleccionales) a menudo se sustituyen (por ejemplo, “agricultor” en lugar de “agricultura”). Además, las palabras concretas se leen con una tasa de error menor que las abstractas como “libertad” (efecto de concreción).

Deep Alexia comparte muchos rasgos sintomáticos con la alexia fonológica como la incapacidad de leer no palabras. Al igual que en la alexia fonológica, los pacientes cometen errores en las inflexiones de palabras así como en las palabras funcionales y muestran errores basados visualmente en palabras abstractas (“deseo” → “desierto”). Además de eso, las personas con alexia profunda malinterpretan las palabras como palabras diferentes con un significado fuertemente relacionado (“bosque” en lugar de “bosque”), fenómeno al que se hace referencia como paralexia semántica. Coltheart (como se menciona en el “Manual de Neurolingüística”, ch.41-3, p. 563) postula que la lectura en la dislexia profunda está mediada por el hemisferio derecho. Sugiere que cuando lesiones grandes que afectan habilidades del lenguaje distintas a la lectura impiden el acceso al hemisferio izquierdo, se utiliza el almacén de lenguaje hemisférico derecho. Las entradas léxicas almacenadas allí son accedidas y utilizadas como entrada a los sistemas de salida del hemisferio izquierdo.

Figura\(\PageIndex{9}\): Visión general de la alexia. (Imagen de Wikimedia Commons; Archivo:Descripción general alexia.JPG; https://commons.wikimedia.org/wiki/F...iew_alexia.JPG; por TilmanaTuos en en.wikibooks; licenciado bajo Licencia de Documentación Libre de GNU.).

El procesamiento del lenguaje escrito en ortografía

Figura\(\PageIndex{10}\): Se supone que la ruta fonológica hace uso de reglas de fonema a grafema mientras que la ruta directa vincula el pensamiento con la escritura sin una representación fonética intermediaria. (Imagen de Wikimedia Commons; Archivo:1 4 TwoRoutesModelWritig.JPG; https://commons.wikimedia.org/wiki/F...odelWritig.JPG; por TilmanaTuos en en.wikibooks; licenciado bajo Licencia de Documentación Libre de GNU).

Al igual que en la lectura, se piensa que existen dos rutas separadas —una fonológica y otra directa—. Se supone que la ruta fonológica hace uso de reglas fonema a grafema mientras que la ruta directa vincula el pensamiento con la escritura sin una representación fonética intermediaria (ver 1.4).

Cabe señalar aquí que existe una diferencia entre las reglas de fonema a grafema (utilizadas para la ortografía) y las reglas de grafema a fonema en que una no es simplemente la inversa de la otra. En el caso del grafema “k” el fonema más común para ello es /k/. El grafema más común para el fonema /k/, sin embargo, es “c”. La agrafia fonológica es causada por una lesión en la circunvolución supramarginal izquierda, la cual se localiza en el lóbulo parietal por encima de la sección posterior de la fisura silviana (M. T. Banich, “Neuropsicología “, p. 299). La capacidad de escribir palabras regulares e irregulares se conserva mientras que la capacidad de escribir no palabras no lo es. Esto, junto con una mala recuperación de afijos (que no se almacenan léxicamente), indica una incapacidad para asociar palabras habladas con su forma ortográfica a través de reglas de fonema a grafema. Los pacientes confían en la ruta directa, lo que significa que utilizan representaciones ortográficas en forma de palabra que se almacenan en la memoria léxica. Las lesiones en la conjunción del lóbulo parietal posterior y la unión parieto-occipital causan la llamada agrafia léxica que a veces también se conoce como agrafia superficial. Como su nombre ya indica, es paralela a la alexia superficial en que los pacientes tienen dificultad para acceder a representaciones léxico-ortográficas de las palabras. La agrafia léxica se caracteriza por una mala ortografía de palabras irregulares pero buena ortografía para palabras regulares y no palabras. Cuando se les pide que deletreen palabras irregulares, los pacientes suelen cometer errores de regularización, de modo que la palabra se deletrea fonológicamente correcta (por ejemplo, “batidor” se escribiría como “wisque”).

Figura\(\PageIndex{11}\): Visión general de las agrafías. (Imagen de Wikimedia Commons; Archivo:Descripción general agraphia.JPG; https://commons.wikimedia.org/wiki/F...w_agraphia.JPG; por TilmanaTuos en en.wikibooks; licenciado bajo Licencia de Documentación Libre de GNU).

Evidencia de Métodos Avanzados de Neurociencia

¿Cómo podemos encontrar evidencia para la teoría de las dos rutas? Hasta ahora la investigación neurocientífica no es capaz de determinar que existen circuitos neuronales que representan un sistema como el descrito anteriormente. El problema de encontrar evidencia para el procesamiento del lenguaje visual en dos rutas en contraste con una ruta (como lo afirma e.g., de Seidenberg & McClelland como se menciona en M. T. Banich, "Neuropsicología”, p. 308) es que no está claro qué característica activación cerebral indicaría que es o bien ocurriendo en dos o una ruta. Para investigar si hay uno o dos sistemas, los estudios de neuroimagen examinan las correlaciones entre las activaciones de la circunvolución angular, que se cree que es un área cerebral crucial en el procesamiento del lenguaje escrito, y otras regiones cerebrales. Se encontró que durante la lectura de no palabras (lo que afectaría fuertemente a la ruta fonológica) la activación se correlaciona principalmente con regiones cerebrales que están involucradas en el procesamiento fonológico, por ejemplo, regiones temporales superiores (BA 22) y área de Broca. Durante la lectura de palabras normales (que afectarían fuertemente a la ruta directa) la activación más alta se encontró en la corteza occipital y ventral. Eso al menos puede implicar que hay dos rutas distintas. Sin embargo, se trata de conclusiones extraídas de correlaciones más altas que no aseguran esta sugerencia. Lo que los estudios de neuroimagen sí muestran es que el uso de una vía fonológica y una directa se superponen fuertemente, lo que es bastante poco espectacular ya que es tranquilo razonable que los hablantes fluidos mezclen ambas rutas. Otros estudios proporcionan además datos en los que las regiones cerebrales activadas durante la lectura de no palabras y la lectura de palabras normales difieren. Los estudios de ERP sugieren que el hemisferio izquierdo posee algún tipo de mecanismo que responde a combinaciones de letras en una cadena, o a su ortografía y/o a la representación fonológica de la cuerda. Las ondas ERP difieren, durante el análisis temprano de la forma visual de la cadena, si la cadena representa una palabra correcta o simplemente tonterías pronunciables (Posner & McCandliss, 1993 como se refiere en M.T. Banich, “Neuropsychology”, p. 307-308). Eso indica que este mecanismo es sensible a las palabras correctas o incorrectas.

El hemisferio opuesto, el hemisferio derecho, en contraste con el hemisferio izquierdo, no está involucrado en el mapeo abstracto del significado de la palabra, sino que es más bien responsable de codificar formas visuales específicas de palabras. Los estudios ERP y PET proporcionan evidencia de que el hemisferio derecho responde de una manera más fuerte que el hemisferio izquierdo a las cuerdas similares a letras. Además, los estudios de campo visual divididos revelan que el hemisferio derecho puede distinguir mejor entre diferentes formas de la misma letra (por ejemplo, en diferentes escritos a mano) que el hemisferio izquierdo. La contribución del procesamiento del lenguaje visual por ambos hemisferios es que el hemisferio derecho reconoce primero una palabra escrita como secuencias de letras, sin importar cómo se vean exactamente, luego la red lingüística en el hemisferio izquierdo construye un resumen representación de la palabra, que es la comprensión de la palabra.

Otros sistemas simbólicos

La mayor parte de la investigación neurolingüística se refiere a la producción y comprensión del idioma inglés, ya sea escrito o hablado. Sin embargo, observar diferentes sistemas lingüísticos desde una perspectiva neurocientífica puede fundamentar y diferenciar teorías reconocidas del procesamiento del lenguaje. En la siguiente sección se muestra cómo la investigación neurológica de tres sistemas simbólicos, cada uno diferente del inglés en algún aspecto, ha permitido distinguir -al menos en cierta medida- entre regiones cerebrales que se ocupan de la modalidad del lenguaje (y por lo tanto pueden variar de un idioma a otro, dependiendo de si el idioma en cuestión es, por ejemplo, hablado o firmado) desde regiones cerebrales que parecen ser necesarias para el procesamiento del lenguaje en general, independientemente de si estamos tratando con lenguaje firmado, hablado o incluso musical.

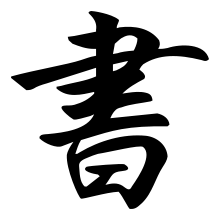

Kana y Kanji

Kana y Kanji son los dos sistemas de escritura utilizados paralelos en el idioma japonés. Dado que en ellas se utilizan diferentes enfoques para representar palabras, estudiar a pacientes japoneses con alexia es una gran posibilidad para probar la hipótesis sobre la existencia de dos rutas diferentes al significado, discutidas en la sección anterior.

El sistema de escritura en inglés es fonológico — cada grafema en inglés escrito representa aproximadamente un sonido de voz — una consonante o una vocal. Existen, sin embargo, otros enfoques posibles para escribir un idioma hablado. En sistemas silábicos como el kana japonés, un grafema representa una sílaba. Si el inglés escrito fuera silábico, podría por ejemplo (por ejemplo) incluir un símbolo para la sílaba “nut”, apareciendo tanto en las palabras “donut” como “peanut”. Los sistemas silábicos están basados en el sonido —dado que los grafemas representan unidades de palabras habladas en lugar de significar directamente, se tiene que crear una representación auditiva de la palabra para llegar al significado. Por lo tanto, la lectura de sistemas silábicas debe requerir una ruta fonológica intacta. Además de kana, los japoneses también utilizan un sistema de escritura logográfica llamado kanji, en el que un grafema representa una palabra completa o un concepto. A diferencia de los sistemas fonológico y silábico, los sistemas logográficos no comprenden relaciones sistemáticas entre las formas visuales y la forma en que se pronuncian; en cambio, la forma visual está directamente asociada con la pronunciación y el significado de la palabra correspondiente. Por lo tanto, la lectura de kanji debe requerir que la ruta directa al significado esté intacta.

La hipótesis sobre la existencia de dos vías diferentes al significado ha sido confirmada por el hecho de que después del daño cerebral, puede haber una doble disociación entre kana y kanji. Algunos pacientes japoneses pueden leer kana pero no kanji (alexia superficial), mientras que otros pueden leer kanji pero no kana (alexia fonológica). Además, existe evidencia de que diferentes regiones cerebrales de hablantes nativos japoneses están activas mientras leen kana y kanji, aunque al igual que en el caso de los hablantes nativos de inglés, estas regiones también se superponen.

Dado que la distinción entre ruta directa y fonológica también tiene sentido en el caso del japonés, puede ser un principio general común a todas las lenguas escritas que su lectura se base en dos sistemas independientes (al menos parcialmente), ambos utilizando estrategias diferentes para captar el significado de una palabra escrita, ya sea asociando la forma visual directamente con el significado (la ruta directa), o utilizando la representación auditiva como intermediario entre la forma visual y el significado de la palabra (la ruta fonológica).

El signo japonés de Kana para la sílaba “mu” |

El letrero kanji japonés para el concepto “Libro”, “escritura” o “caligrafía” |

Lenguaje de señas

Desde una perspectiva lingüística, las lenguas de señas comparten muchas características de las lenguas habladas; hay muchas lenguas de señas regionalmente delimitadas, cada una con una gramática y un léxico distintos. Ya que al mismo tiempo, las lenguas de señas difieren de las lenguas habladas en la forma en que se “pronuncian” las palabras, es decir, en la modalidad, la investigación neurocientífica en ellas puede arrojar valiosas ideas sobre la cuestión de si existen mecanismos neuronales generales que se ocupan del lenguaje, independientemente de su modalidad.

Estructura de SL

Las lenguas de señas son lenguajes fonológicos - cada signo significativo consiste en varios fonemas (los fonemas solían llamarse queremes (griego χερι: mano) hasta que se realizó su equivalencia cognitiva con los fonemas en las lenguas habladas) que no tienen ningún significado como tal, pero sin embargo son importantes para distinguir los significado del signo. Una característica distintiva de los fonemas SL es el lugar de la articulación: la forma de una mano puede tener diferentes significados dependiendo de si se produce a nivel de ojos, nariz o mentón. Otras características que determinan el significado de un signo son la forma de la mano, la orientación de la palma, el movimiento y los marcadores no manuales (por ejemplo, expresiones faciales).

Para expresar las relaciones sintácticas, las Lenguas de Signos explotan las ventajas del medio visuo-espacial en el que se producen los signos; por lo tanto, la estructura sintáctica de las lenguas de señas a menudo difiere de la de las lenguas habladas. Dos características importantes de la mayoría de las gramáticas del lenguaje de señas (incluyendo American Sign Language (ASL), Deutsche Gebärdensprache (DGS) y varias otras lenguas de señas importantes) son la direccionalidad y la codificación simultánea de elementos de información:

- Direccionalidad

La dirección en la que se hace el signo suele determinar el sujeto y el objeto de una oración. Los sustantivos en SL pueden ser 'vinculados' a un punto particular en el espacio, y posteriormente en el discurso pueden ser referidos señalando nuevamente ese mismo lugar (esto está funcionalmente relacionado con los pronombres en inglés). El objeto y el sujeto pueden cambiarse entonces cambiando la dirección en la que se hace el signo de un verbo transitivo.

- Codificación simultánea de elementos de información

El medio visual también permite codificar varias piezas de información simultáneamente. Considera por ejemplo la frase “El vuelo fue largo y no lo disfruté”. En inglés, la información sobre la duración y desagrado del vuelo tiene que codificarse secuencialmente agregando más palabras a la oración. Para enriquecer el enunciado “El vuelo fue largo” con la información sobre lo desagradable del vuelo, hay que agregar otra frase (“No la disfruté”) a la original. Entonces, para transmitir más información, la longitud de la sentencia original debe crecer. En lenguaje de señas, sin embargo, el aumento de información en una enunciación no necesariamente aumenta la duración de la expresión. Para transmitir información sobre el desagrado de un vuelo largo experimentado en el pasado, uno puede simplemente usar el signo único para “vuelo” con el marcador de tiempo pasado, movido de una manera que representa el atributo “largo”, combinado con la expresión facial de desafección. Dado que todas estas características están firmadas simultáneamente, no se necesita tiempo adicional para pronunciar “El vuelo fue largo” en comparación con “El vuelo fue largo y no lo disfruté”.

Neurología de SL

Dado que las oraciones en SL se codifican visualmente, y dado que su gramática a menudo se basa en relaciones visuales más que secuenciales entre diferentes signos, se podría sugerir que el procesamiento de SL depende principalmente del hemisferio derecho, que se ocupa principalmente del desempeño en tareas visuales y espaciales. Sin embargo, hay evidencia que sugiere que el procesamiento de SL y lenguaje hablado puede ser igualmente dependiente del hemisferio izquierdo, es decir, que el mismo mecanismo neural básico puede ser responsable del funcionamiento de todo el lenguaje, independientemente de su modalidad (es decir, si el lenguaje es hablado o firmado).

La importancia del hemisferio izquierdo en el procesamiento de SL indicó, por ejemplo, por el hecho de que los firmantes con un hemisferio derecho dañado pueden no ser afasiacos, mientras que como en el caso de sujetos auditivos, las lesiones en el hemisferio izquierdo de los firmantes pueden resultar en sutiles dificultades lingüísticas (Gordon, 2003). Además, estudios de firmantes nativos afásicos han demostrado que el daño a las porciones anteriores del hemisferio izquierdo (área de Broca) resulta en un síndrome similar a la afasia de Broca: los pacientes pierden fluidez de comunicación, no son capaces de usar correctamente marcadores sintácticos e inflexionar verbos, aunque las palabras que firman son semánticamente apropiadas. En contraste, los pacientes con daños en las porciones posteriores de la circunvolución temporal superior (área de Wernicke) aún pueden inflar correctamente los verbos, configurar y recuperar sustantivos de un locus del discurso, pero las secuencias que firman no tienen significado (Poizner, Klima & Bellugi, 1987). Entonces, como en el caso de las lenguas habladas, las porciones anterior y posterior del hemisferio izquierdo parecen ser responsables de la sintaxis y semántica del lenguaje respectivamente. Por lo tanto, no es esencial para los “mecanismos de procesamiento de sintaxis” del cerebro si la sintaxis se transporta simultáneamente a través de marcadores espaciales o sucesivamente a través del orden de las palabras y morfemas agregados a las palabras, los mismos mecanismos subyacentes podrían ser responsables de la sintaxis en ambos casos.

Otra evidencia de los mismos mecanismos subyacentes para las lenguas habladas y firmadas proviene de estudios en los que la FMRI se ha utilizado para comparar el procesamiento lingüístico de:

- 1. firmantes nativos congénitamente sordos del lenguaje de señas británico,

- 2. escuchar a los firmantes nativos de BSL (generalmente oyen hijos de padres sordos)

- 3. escuchar a los firmantes que han aprendido BSL después de la pubertad

- 4. Sujetos que no firman

Investigar el procesamiento del lenguaje en estos diferentes grupos permite hacer algunas distinciones entre diferentes factores que influyen en la organización del lenguaje en el cerebro, por ejemplo, en qué cantidad influye la sordera en la organización del lenguaje en el cerebro en comparación con solo tener SL como primer idioma (1 vs. 2), o a qué cantidad difiere el aprendizaje de SL como primer idioma del aprendizaje de SL como lengua nativa (1,2 vs.3), o a qué cantidad se organiza la lengua en hablantes en comparación con los firmantes (1,2,3 vs.4).

Estos estudios han demostrado que las áreas típicas del hemisferio izquierdo se activan tanto en hablantes nativos de inglés dados estímulos escritos como en firmantes nativos que dan signos como estímulos. Además, también hay áreas que están igualmente activadas tanto en el caso de sujetos sordos que procesan el lenguaje de señas como los sujetos auditivos que procesan el lenguaje hablado, hallazgo que sugiere que estas áreas constituyen el sistema lingüístico central independientemente de la modalidad de lenguaje (Gordon, 2003).

A diferencia de los hablantes, sin embargo, los firmantes también muestran una fuerte activación del hemisferio derecho. Esto se debe en parte a la necesidad de procesar información visuo-espacial. Sin embargo, algunas de esas áreas (por ejemplo, la circunvolución angular) solo se activan en firmantes nativos y no en sujetos auditivos que aprendieron SL después de la pubertad. Esto sugiere que la forma de aprender las lenguas de señas (y las lenguas en general) cambia con el tiempo: los cerebros de los alumnos tardíos son incapaces de reclutar ciertas regiones cerebrales especializadas para procesar este lenguaje (Newman et al., 1998).]

Hemos visto que la evidencia de afasias así como de la neuroimagen sugiere los mismos mecanismos neuronales subyacentes para ser responsables de los lenguajes de signos y hablados. Es natural preguntarse si estos mecanismos neuronales son aún más generales, es decir, si son capaces de procesar cualquier tipo de sistema simbólico subyacente a alguna sintaxis y semántica. Un ejemplo de este tipo de sistema simbólico más general es la música.

Música

Al igual que el lenguaje, la música es un universal humano que involucra algunos principios combinatorios que rigen la organización de elementos discretos (tonos) en estructuras (frases) que transmiten algún significado; la música es un sistema simbólico con un tipo especial de sintaxis y semántica. Por lo tanto, es interesante preguntarse si la música y el lenguaje natural comparten algunos mecanismos neuronales: si el procesamiento de la música depende del procesamiento del lenguaje o al revés, o si los mecanismos subyacentes que los subyacen están completamente separados. Al investigar los mecanismos neuronales subyacentes a la música podríamos averiguar si los procesos neuronales detrás del lenguaje son exclusivos del dominio del lenguaje natural, es decir, si el lenguaje es modular. Hasta ahora, la investigación en la neurobiología de la música ha arrojado evidencias contradictorias respecto a estas cuestiones.

Por un lado, hay evidencia de que existe una doble disociación de las habilidades lingüísticas y musicales. Las personas que sufren de amusia son incapaces de percibir la armonía, de recordar y de reconocer incluso melodías muy simples; al mismo tiempo no tienen problemas para comprender o producir el habla. Incluso hay un caso de una paciente que desarrolló amusia sin aprosodia, es decir, aunque no pudo reconocer el tono en las secuencias musicales, aún así podría hacer uso de tono, sonoridad, ritmo o ritmo para transmitir significados en el lenguaje hablado (Pearce, 2005). Este problema altamente selectivo en el procesamiento de la música (amusia) puede ocurrir como consecuencia de un daño cerebral, o ser innato; en algunos casos corre sobre familias, sugiriendo un componente genético. El síndrome del complemento de la amusia también existe —tras sufrir un daño cerebral en el hemisferio izquierdo, el compositor ruso Shebalin perdió sus funciones de habla, pero sus habilidades musicales permanecieron intactas (Zatorre, McGill, 2005).

Por otro lado, los datos de neuroimagen sugieren que el lenguaje y la música tienen un mecanismo común para procesar estructuras sintácticas. El P600 ERP`s en el área de Broca, medido como respuesta a oraciones no gramaticales, también se provoca en sujetos que escuchan secuencias de acordes musicales carentes de armonía (Patel, 2003); por lo tanto, la expectativa de secuencias típicas en la música podría estar mediada por los mismos mecanismos neuronales que la expectativa de secuencias gramaticales en lenguaje.

Una posible solución a esta aparente contradicción es el enfoque de sistema dual (Patel, 2003) según el cual la música y el lenguaje comparten algunos mecanismos procedimentales (áreas cerebrales frontales) responsables de procesar los aspectos generales de la sintaxis, pero en ambos casos estos mecanismos operan sobre diferentes representaciones (áreas cerebrales posteriores) — notas en caso de música y palabras en caso de lenguaje.

Resumen

Muchas preguntas aún no han sido respondidas. Todavía no está claro si existe un módulo de lenguaje distinto (que podrías cortar sin afectar nada en otras funciones cerebrales) o no. Como señala Eely C. Ferstl en su revisión, el siguiente paso después de explorar distintas regiones pequeñas responsables de las subtareas del procesamiento del lenguaje será averiguar cómo funcionan juntas y construir la red lingüística.

Referencias y lecturas adicionales

Libros

- Brigitte Stemmer, Harry A. Whitaker. Manual de Neurolingüística. Prensa Académica (1998). ISBN 0126660557

- Marie T. Banich: Neuropsicología. Las bases neuronales de la función mental (1997).

- Ewa Dąbrowska: Lenguaje, Mente y Cerebro. Prensa de la Universidad de Edimburgo Ltd. (2004)

- una revisión: Evelyn C. Ferstl, La neuroanatomía funcional de la comprensión textual. ¿Cuál es la historia hasta ahora?” de: Schmalhofer, F. & Perfetti, C. A. (Eds.), Procesos del Lenguaje de Nivel Superior en el Cerebro:Procesos de Inferencia y Comprensión. Lawrence Erlbaum. (2004)

- Müller, H.M.& Rickert, G. (Hrsg.): Neurokognition der Sprache. Verlag de Stauffenberg (2003)

- Poizner, Klima & Bellugi: Lo que revelan las manos sobre el cerebro. Prensa MIT (1987)

- N. Chomsky: Aspectos de la Teoría de la Sintaxis. Prensa MIT (1965). ISBN 0262530074

- Neville & Bavelier: Variabilidad en los efectos de la experiencia en el desarrollo de especializaciones cerebrales: Insights a partir del estudio de individuos sordos. Washington, D.C.: Imprenta del Gobierno de Estados Unidos (1998)

- Newman et al.: Effects of Age of Acquisition on Cortical Organization for American Sign Language: an fMRI Study. NeuroImage, 7 (4), parte 2 (1998)

Enlaces - inglés

- Robert A. Mason y Marcel Adam Just: Cómo procesa el cerebro las inferencias causales en el texto