18.6: Capítulo 10- Modelos informáticos y aprendizaje en redes neuronales artificiales

- Page ID

- 148309

Objetivos de aprendizaje

- Explicar la regla de Hebb y cómo se aplica en las redes conexionistas

- Describir los pesos de conexión y cómo su modificación por entradas a ellos crea “aprendizaje” en una red conexionista

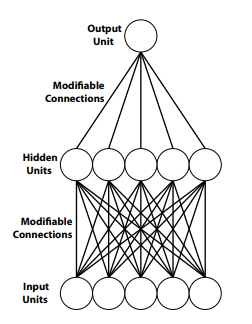

- Describir la estructura de una red simple de tres capas

- Explique lo que se entiende por “codificación gruesa” y dé un ejemplo

- Explicar el concepto de Hebb de “conjuntos de celdas”

- Discutir cómo los potenciales graduados (EPSP e IPSP) en neuronas biológicas experimentan una transformación no lineal durante la comunicación neuronal permitiendo propiedades emergentes

Visión general

Las redes neuronales artificiales, o redes coneccionistas, son modelos generados por computadora que utilizan principios de computación basados libremente en cómo operan las neuronas biológicas y las redes de neuronas biológicas. Las unidades de procesamiento en redes de conexión están dispuestas frecuentemente en capas interconectadas. Las conexiones entre unidades de procesamiento en redes coneccionistas son modificables y, por lo tanto, pueden volverse más fuertes o débiles, similar a la forma en que se presume que las sinapsis en el cerebro se ven modificadas en fuerza por el aprendizaje y la experiencia. Los procesos cognitivos se pueden estudiar utilizando redes neuronales artificiales que proporcionan información sobre cómo los cerebros biológicos pueden codificar y procesar la información.

Sinapsis hebbianas, modificación de pesos de conexión y aprendizaje en redes neuronales artificiales

Hebbian Learning, también conocido como Regla de Hebb o Teoría de Ensamblaje Celular, intenta conectar los fundamentos psicológicos y neurológicos del aprendizaje. Como se discutió en una sección anterior de este capítulo, la base de la teoría de Hebb es cuando nuestros cerebros aprenden algo nuevo, las neuronas se activan y se conectan con otras neuronas, formando una red neuronal o ensamblaje celular (un grupo de neuronas conectadas sinápticamente) que puede representar cognitiva estructuras como percepciones, conceptos, pensamiento o recuerdos. Se desconoce qué tan grandes grupos de neuronas generan tales estructuras y procesos cognitivos. Sin embargo, en los últimos años, investigadores de la neurociencia y la informática han avanzado en nuestra comprensión de cómo las neuronas trabajan juntas mediante el uso de modelos informáticos de la actividad cerebral. El modelado por computadora de los procesos cerebrales no solo ha proporcionado nuevos conocimientos sobre los mecanismos cerebrales en el aprendizaje, la memoria y otras funciones cognitivas, sino que la investigación de inteligencia artificial (IA) también tiene poderosas aplicaciones prácticas en muchas áreas del esfuerzo humano.

La influencia del libro de Hebb, La organización del comportamiento (1949), se ha extendido más allá de la psicología y la neurociencia al campo de la investigación de inteligencia artificial utilizando redes neuronales artificiales. Una red neuronal artificial es una simulación por computadora de un sistema “parecido al cerebro” de unidades de procesamiento interconectadas, similar a las neuronas. Estas unidades de procesamiento, a veces denominadas “neurodas”, imitan muchas de las propiedades de las neuronas biológicas. Por ejemplo, los “neurodos” en las redes neuronales artificiales tienen conexiones entre ellas similares a las sinapsis en cerebros biológicos. Al igual que las fortalezas de conductividad de las sinapsis entre neuronas biológicas pueden modificarse por la experiencia (es decir, el aprendizaje), los “pesos” sinápticos en las conexiones entre “neurodas” también se pueden modificar mediante entradas al sistema, permitiendo que las redes neuronales artificiales aprender. La idea básica es que los cambios en los “pesos de conexión” por entradas a una red artificial son análogos a los cambios en las fortalezas sinápticas entre neuronas en el cerebro durante el aprendizaje. Recordemos de una sección anterior que la experiencia puede fortalecer el vínculo asociativo entre las neuronas cuando la actividad en esas neuronas ocurre juntas (es decir, la Regla de Hebb). En las redes neuronales artificiales, también llamadas redes coneccionistas, cuando los pesos de conexión entre unidades de procesamiento son alterados por entradas, la salida de la red cambia: la red neuronal artificial aprende.

Al igual que las sinapsis biológicas, las conexiones entre unidades de procesamiento en una red neuronal artificial pueden ser tanto inhibitorias como excitadoras. “El peso sináptico en una red neuronal artificial es un número que define la naturaleza y la fuerza de la conexión. Por ejemplo, las conexiones inhibitorias tienen pesos negativos, y las conexiones excitatorias tienen pesos positivos. Las conexiones fuertes tienen pesos fuertes. La señal enviada por un procesador a otro es un número que se transmite a través de la conexión ponderada o “sinapsis”. La conexión “sináptica” y su correspondiente “peso” sirve como canal de comunicación entre unidades de procesamiento (neurodas) que amplifica o disminuye las señales que se envían a través de ella; la conexión “sináptica” amplifica o disminuye la señal porque estas señales se multiplican por el peso ( ya sea positivo o negativo y de magnitud variable) asociados con la conexión “sináptica”. Las conexiones fuertes, ya sean positivas o negativas, tienen pesos grandes (en términos de valor absoluto sin tener en cuenta el signo) y grandes efectos sobre la señal, mientras que las conexiones débiles tienen pesos cercanos a cero” (Libretexto, Mente, Cuerpo, Mundo: Fundamentos de la Ciencia Cognitiva (Dawson), 4.2, Nature vs Nurture). Los cambios en los “pesos” sinápticos cambian la salida de la red neuronal constituyendo aprendizaje por la red. Observe la clara similitud con la concepción del aprendizaje de Hebb en cerebros biológicos.

Figura\(\PageIndex{1}\): Una red neuronal multicapa con una capa de unidades ocultas entre las unidades de entrada y salida. (Imagen del libretexto, mente, cuerpo, mundo: fundamentos de la ciencia cognitiva (Dawson), 4.5, El sándwich coneccionista; https://socialsci.libretexts.org/Boo...onist_Sandwich)

Las capas ocultas adicionales aumentan la complejidad del procesamiento que puede realizar una red. Se ha demostrado que las redes neuronales artificiales con múltiples capas son capaces de representaciones bastante complejas y un aprendizaje sofisticado y resolución de problemas. Este enfoque para modelar el aprendizaje, la memoria y la cognición se conoce como “conexionismo” (ver Materia y conciencia de Paul Churchland, MIT Press, 2013, para una excelente y muy legible introducción al campo) y es la base de gran parte de la investigación en el creciente campo de la inteligencia artificial, incluyendo el reconocimiento de voz y la visión artificial.

Recordemos que Hebb (1949) propuso que si dos neuronas interconectadas están ambas “encendidas” al mismo tiempo, entonces se debería aumentar el peso sináptico entre ellas. Así, el aprendizaje hebbio es una forma de plasticidad sináptica dependiente de la actividad donde la activación correlacionada de las neuronas pre y postsinápticas conduce al fortalecimiento de la conexión entre las dos neuronas. “La regla de aprendizaje hebbiana es una de las reglas de aprendizaje más tempranas y simples para las redes neuronales” “y se basa en gran parte en la dinámica de los sistemas biológicos. Una sinapsis entre dos neuronas se fortalece cuando las neuronas a ambos lados de la sinapsis (pre y possináptica) tienen resultados altamente correlacionados (recordemos las secciones de este capítulo sobre LTP). En esencia, cuando una neurona de entrada dispara, si frecuentemente conduce al disparo de la neurona de salida, se fortalece la sinapsis”. De manera similar, en una red neuronal artificial, el peso o fuerza “sináptica” entre unidades en una red neuronal artificial “se incrementa con una alta correlación entre el disparo de las unidades presinápticas y possinápticas” (adaptadas de Wikilibros, Redes Neuronales Artificiales/Hebbian Learning, https://en.wikibooks.org/wiki/Artifi...bbian_Learning; recuperado 13/8/2021). Las redes neuronales artificiales no están cableadas. En cambio, aprenden de la experiencia a establecer los valores de sus pesos de conexión, tal como podría ocurrir en los cerebros biológicos cuando aprenden. Cambiando pesos de conexión dentro de la red, cambia la salida de la red, su “comportamiento”. Esta es la base física del aprendizaje en una red neuronal artificial (una red coneccionista) y es análoga a los cambios en el cerebro que se cree que son la base física del aprendizaje en animales y humanos.

Se han desarrollado redes neuronales artificiales más complejas de varios tipos diferentes utilizando diferentes reglas o paradigmas de aprendizaje, pero independientemente de la regla de aprendizaje empleada, cada una utiliza la modificación de los pesos sinápticos (fortalezas sinápticas) para modificar los resultados a medida que procede el aprendizaje por la red conexionista—a fundamentalmente idea hebbiana.

En algunos sistemas, llamados redes autoorganizables, la experiencia da forma a la conectividad a través del “aprendizaje no supervisado” (Carpenter & Grossberg, 1992). Cuando el aprendizaje no es supervisado, las redes solo se proporcionan con patrones de entrada. Las redes cuyos pesos de conexión se modifican a través del aprendizaje no supervisado desarrollan sensibilidad a las regularidades estadísticas en las entradas y organizan sus unidades de salida para reflejar estas regularidades. En este caso, la red neuronal artificial coneccionista puede descubrir nuevos patrones en datos no reconocidos previamente por los humanos.

En la ciencia cognitiva, la mayoría de las redes reportadas en la literatura no son autoorganizadas y no están estructuradas mediante aprendizaje no supervisado. En cambio, son redes a las que se les instruye para mediar en una asignación de entrada-salida deseada. Esto se logra a través del aprendizaje supervisado. En el aprendizaje supervisado, se asume que la red cuenta con un “maestro” externo. La red se presenta con un patrón de entrada y produce una respuesta a la misma. El profesor compara la respuesta generada por la red con la respuesta deseada, generalmente calculando la cantidad de error asociada a cada unidad de salida. El “maestro” luego proporciona el error como retroalimentación a la red. Una regla de aprendizaje (como la regla delta) utiliza retroalimentación sobre el error para modificar los pesos de conexión en la red de tal manera que la próxima vez que se presente este patrón a la red, la cantidad de error que produce será menor. Técnicamente, este paradigma de aprendizaje se llama “retropropagación del error” y puede ser análogo al aprendizaje por retroalimentación en animales y humanos que aprenden a alcanzar una meta (piense en el condicionamiento operante, específicamente en la conformación operante).

Representación y procesamiento de información en redes artificiales da pistas sobre representación y procesamiento en cerebros biológicos

Una de las ventajas asumidas de la ciencia cognitiva conexionista (una rama de la psicología, la neurociencia y la informática que intenta utilizar sistemas coneccionistas para modelar procesos psicológicos humanos) es que puede inspirar nociones alternativas de representación de la información en el cerebro. ¿Cómo representan las neuronas, las poblaciones de neuronas y sus operaciones las percepciones, las imágenes mentales, los recuerdos, los conceptos, las categorías, las ideas y otras estructuras cognitivas? La codificación gruesa puede ser una respuesta.

Un código grueso es aquel en el que una unidad de procesamiento individual está sintonizada muy ampliamente, sensible a una amplia gama de características o al menos a una amplia gama de valores para una característica individual (Churchland & Sejnowski, 1992; Hinton, McClelland, & Rumelhart, 1986). En otras palabras, los procesadores individuales son en sí mismos dispositivos muy inexactos para medir o detectar una característica del mundo, como el color. Sin embargo, la representación precisa de una característica puede ser posible al agrupar o combinar las respuestas de muchos de estos detectores inexactos, particularmente si sus perspectivas son ligeramente diferentes (por ejemplo, si son sensibles a diferentes rangos de características, o si detectan características de diferentes entradas ubicaciones). Aquí, es útil pensar en receptores auditivos, por ejemplo, cada uno de los cuales es sensible a un rango de frecuencias de ondas sonoras. La precisión en la discriminación de frecuencia, experimentada como tono, ocurre por patrones de actividad en células receptoras auditivas (“células ciliadas” en la membrana basilar dentro de la cóclea del oído interno) que son sensibles a rangos de frecuencias superpuestos (campos receptivos auditivos). Las tasas de disparo relativas en un grupo de receptores auditivos con rangos de sensibilidad superpuestos dan una codificación neuronal precisa de cada frecuencia particular.

Otro ejemplo familiar de codificación gruesa lo proporciona la teoría tricromática de la percepción del color del siglo XIX (Helmholtz, 1968; Wasserman, 1978). Según esta teoría, la percepción del color está mediada por tres tipos de receptores de cono retiniano. Uno es máximamente sensible a longitudes de onda cortas (azules) de luz, otro es máximamente sensible a longitudes de onda medias (verdes) y el tercero es máximamente sensible a longitudes de onda largas (rojas). Así, ninguno de estos tipos de receptores es capaz de representar, por sí mismos, el rico arco iris de tonalidades perceptibles.

Sin embargo, estos receptores están ampliamente sintonizados y tienen sensibilidades superpuestas. Como resultado, la mayor parte de la luz activará los tres canales simultáneamente, pero en diferentes grados. La luz coloreada real no produce sensaciones de color absolutamente puro; ese camión de bomberos rojo, por ejemplo, incluso cuando está completamente liberado de toda mezcla de luz blanca, todavía no excita esas fibras nerviosas que por sí solas son sensibles a las impresiones de rojo, sino también, en un grado muy leve, las que son sensibles al verde, y quizás en menor medida las que son sensibles a los rayos violetas (Helmholtz, 1968, p. 97).

El estudio de las redes neuronales artificiales ha proporcionado a psicólogos biológicos y neurocientíficos cognitivos nuevos conocimientos sobre cómo el cerebro podría procesar la información de manera que genere percepción, aprendizaje y memoria, y diversas formas de cognición, incluido el reconocimiento visual y la representación neuronal de mapas espaciales en el cerebro (una función del hipocampo de mamíferos). Incluso los críticos del conexionismo admiten que “el estudio de las máquinas conexionistas ha llevado a una serie de hallazgos llamativos e imprevistos; es sorprendente la cantidad de computación que se puede hacer con una red uniforme de elementos simples interconectados” (Fodor y Pylyshyn, 1988, p. 6). Hillis (1988, p. 176) ha señalado que las redes neuronales artificiales permiten “la posibilidad de construir inteligencia sin antes entenderla”. Como dijo un investigador, “La principal lección de la investigación en redes neuronales, creo, ha sido expandir así nuestra visión de las formas en que un sistema físico como el cerebro podría codificar y explotar la información y el conocimiento” (Clark, 1997, p. 58).

La idea clave en el conexionismo es la asociación: diferentes ideas pueden vincularse entre sí, de manera que si una surge, entonces la asociación entre ellas hace que surja también la otra. Observe la similitud con el concepto de Hebb de ensamblajes celulares, formados por asociaciones mediadas por cambios en las sinapsis, y la asociación de ensamblajes celulares entre sí a través del mismo mecanismo. Una vez más, la influencia de Hebb es evidente en las redes neuronales artificiales del conexionismo, incluso el nombre, el conexionismo, refleja las ideas de Hebb sobre cómo las estructuras cognitivas y el aprendizaje y la memoria se forman en el cerebro, por los cambios en las conexiones entre neuronas. Como se discutió anteriormente, la potenciación a largo plazo (LTP) ha sido ampliamente estudiada por psicólogos biológicos y neurocientíficos como un mecanismo biológicamente plausible para las alteraciones sinápticas por la experiencia propuesta en la teoría del aprendizaje y la memoria de Hebb en cerebros biológicos.

Si bien la asociación es una noción fundamental en los modelos coneccionistas, la ciencia cognitiva moderna requiere otras nociones en el esfuerzo por modelar propiedades complejas de la mente. Una de estas ideas adicionales es el procesamiento no lineal. Si un sistema es lineal, entonces todo su comportamiento es exactamente igual a la suma de los comportamientos de sus partes. Las propiedades emergentes, sin embargo, donde las propiedades de un todo (es decir, una idea compleja) son más que la suma de las propiedades de las partes (por ejemplo, un conjunto de ideas más simples asociadas), requieren un procesamiento no lineal. La cognición compleja, la percepción, el aprendizaje y la memoria pueden ser propiedades emergentes derivadas de las actividades de las neuronas y redes del cerebro. Esta observación sugiere que el procesamiento no lineal es una característica clave de cómo se representa y procesa la información en el cerebro. Podemos ver la presencia de procesamiento no lineal a nivel de neuronas individuales.

Las neuronas demuestran un poderoso tipo de procesamiento no lineal que involucra potenciales de acción. Como se discute en el capítulo 5, las entradas a una neurona son señales eléctricas débiles, llamadas potenciales graduadas (EPSP e IPSP; ver capítulo 5 sobre Comunicación dentro del Sistema Nervioso), que estimulan y viajan a través de las dendritas de la neurona receptora. Si suficientes de estos potenciales graduados débiles llegan al soma de la neurona aproximadamente al mismo tiempo, entonces se suman y si su efecto acumulativo alcanza el “umbral desencadenante” de la neurona, se produce una despolarización masiva de la membrana del axón de la neurona, el potencial de acción. El potencial de acción es una señal de intensidad constante que viaja a lo largo del axón para eventualmente estimular alguna otra neurona (ver capítulo 5). Una propiedad crucial del potencial de acción es que se trata de un fenómeno de todo o ninguno, que representa una transformación no lineal de los potenciales graduados sumados. La neurona convierte las entradas continuamente variables (EPSP e IPSP) en una respuesta que está activada (potencial de acción generado) o desactivada (potencial de acción no generado). A esto se le ha llamado la ley de todo o ninguno que establece que una vez que se genera un potencial de acción siempre es de tamaño completo, minimizando la posibilidad de que se pierda información a medida que el potencial de acción se lleva a cabo a lo largo del axón. La salida de todo o ninguno de las neuronas es una transformación no lineal de entrada sumada, continuamente variable, y es la razón por la que el cerebro puede describirse como de naturaleza digital (von Neumann, 1958).

Las redes neuronales artificiales se han utilizado para modelar una vertiginosa variedad de fenómenos que incluyen el aprendizaje animal (Enquist & Ghirlanda, 2005), el desarrollo cognitivo (Elman et al., 1996), los sistemas expertos (Gallant, 1993), el lenguaje (Mammone, 1993), el reconocimiento de patrones y la percepción visual (Ripley, 1996) y la música cognición (Griffith & Todd, 1999). Una red neuronal incluso descubrió una prueba matemática que los matemáticos humanos no habían podido resolver (Churchland, 2013).

Investigadores de la Universidad de California en San Diego, y en otros lugares de laboratorios de todo el mundo, están produciendo “aprendizaje profundo” utilizando redes artificiales con 5 o más capas que pueden realizar tareas como reconocimiento facial, categorización de objetos o reconocimiento de voz (ver https://cseweb.ucsd.edu//groups/guru/). Aunque los psicólogos, los investigadores del PDP y los neurocientíficos tienen un largo camino por recorrer, el modelado del aprendizaje y la memoria, la percepción y la cognición en redes neuronales artificiales (PDP) ha contribuido a nuestra comprensión de cómo las neuronas en las redes cerebrales pueden representar, codificar y procesar la información durante el estados psicológicos que experimentamos diariamente, incluyendo el aprendizaje y la memoria. Por ejemplo, “La simulación del procesamiento cerebral por redes artificiales sugiere que múltiples memorias pueden ser codificadas dentro de una sola red neuronal, por diferentes patrones de conexiones sinápticas. Por el contrario, una sola memoria puede implicar activar simultáneamente varios grupos diferentes de neuronas en diferentes partes del cerebro” (de The Brain from Top to Bottom; https://thebrain.mcgill.ca/flash/a/a...07_cl_tra.html). Como hemos visto anteriormente en este capítulo, la actividad neuronal de diferentes regiones de la corteza cerebral converge hacia el hipocampo donde el procesamiento puede combinar trazas de memoria de diferentes modalidades en memorias multimodales unificadas.

Referencias

Bliss, T. V., & Lømo, T. (1973). Potenciación de larga duración de la transmisión sináptica en el área dentada del conejo anestesiado tras la estimulación de la trayectoria perforante. La Revista de fisiología, 232 (2), 331-356.

Churchland, P. M. (2013). Materia y conciencia. Cambridge, MAMÁ. Prensa MIT.

Churchland, P.S. & Sejnowski, T.J. (1992). El Cerebro Computacional. Cambridge, MAMÁ. Prensa MIT.

Clark, A. (1997). Estar ahí: Uniendo de nuevo el cerebro, el cuerpo y el mundo. Cambridge, MA: Prensa MIT.

Elman, J. L., Bates, E. A., & Johnson, M. H. (1996). Repensar la innatencia: Una perspectiva coneccionista sobre el desarrollo (Vol. 10). Prensa MIT.

Enquist, M., & Ghirlanda, S. (2005). Redes Neuronales y Comportamiento Animal (Vol. 33). Prensa de la Universidad de Princeton.

Fodor, J. A., & Pylyshyn, Z. W. (1988). Conexionismo y arquitectura cognitiva: Un análisis crítico. Cognición, 28 (1-2), 3-71.

Gallant, S. I., & Gallant, S. I. (1993). Aprendizaje de redes neuronales y sistemas expertos. Prensa MIT.

Griffith, N., Todd, P. M., & Todd, P. M. (Eds.). (1999). Redes musicales: Percepción y performance distribuidas en paralelo. Prensa MIT.

Hayashi-Takagi, A., Yagishita, S., Nakamura, M., Shirai, F., Wu, Y.I., Loshbaugh, A.L., Kuhlman, B., Hahn, KM., Kasai, H. (2015). Etiquetado y borrado óptico de trazas de memoria sináptica en la corteza motora. Naturaleza 525, 333—338.

Hebb, D.O. (1949). La Organización de la Conducta. Nueva York. Wiley.

Helmholtz, H. von, (1968). El reciente avance de la teoría de la visión. Helmholtz sobre Percepción: su fisiología y desarrollo, Editado por Richard Warren y Roslyn Warren, John Wiley and Sons, Nueva York, Londres, Sydney, 125.

Henry, F. E., Hockeimer, W., Chen, A., Mysore, S. P., & Sutton, M. A. (2017). La diana mecanicista de la rapamicina es necesaria para cambios en la morfología de la columna dendrítica asociados con la potenciación a largo Cerebro Molecular, 10 (1), 1-17.

Hillis, W. D. (1988). La inteligencia como comportamiento emergente; o, los cantos del edén. Dédalo, 175-189.

Hinton, G. E., McClelland, J. L., & Rumelhart, D. E. (1986). Procesamiento distribuido paralelo.

Kandel, E. (1976). Bases de Comportamiento Celular. San Francisco. W.H. Freeman y Compañía.

Kandel, E. R., & Schwartz, J. H. (1982). Biología molecular del aprendizaje: Modulación de la liberación del transmisor. Ciencia, 218 (4571), 433—443

Kolb, B. & Whishaw, I.Q. (2001). En Introducción al Cerebro y Comportamiento. Nueva York. Worth Publishers.

Kozorovitskiy Y, et al. (2005). La experiencia induce cambios estructurales y bioquímicos en el cerebro de primate adulto. Proc Natl Acad Sci USA. 102:17478. [Artículo gratuito de PMC] [PubMed]

Mammone, R. J. (Ed.). (1993). Redes neuronales artificiales para el habla y la visión (Vol. 4). Editores Académicos Kluwer.

Miller, R. R., & Marlin, N. A. (2014). Amnesia tras choque electroconvulsivo. Trastornos funcionales de la memoria, 143-178. Nueva York. Prensa de Psicología.

Pinel, P.J. & Barnes, S. (2021). Biopsicología (11ª Edición). Boston. Educación Pearson.

Renner MJ, & Rosenzweig MR. Entornos enriquecidos y empobrecidos: efectos sobre el cerebro y el comportamiento. Springer Verlag; Nueva York: 1987.

Ripley, B.D. (1996) Reconocimiento de Patrones y Redes Neuronales. Prensa de la Universidad de Cambridge, Cambridge.

Rosenzweig, M. R. (2007). Modificación de circuitos cerebrales a través de la experiencia. En Plasticidad Neural y Memoria: De los Genes a la Imagen Cerebral. CRC Press/Taylor & Francis, Boca Raton (FL); 2007. PMID: 21204433.

Von Neumann, J. (1958). La computadora y el cerebro. New Haven, Conn.: Prensa de la Universidad de Yale.

Wasserman, G. S. (1978). Visión del color: Una introducción histórica. John Wiley & Hijos.

Atribuciones

1. Sección 10.9: “Modelos informáticos y aprendizaje en redes neuronales artificiales” por Kenneth A. Koenigshofer, PhD, Chaffey College, licenciado CC BY 4.0

2. Partes de la sección “Aprendizaje en Redes Neuronales Artificiales”, es adaptada por Kenneth A. Koenigshofer, PhD, de Libretexto, Mente, Cuerpo, Mundo: Fundamentos de la Ciencia Cognitiva, 4.2, Naturaleza vs Nutrición; 4.3, Asociaciones; 4.4 Transformaciones no lineales; [1]4.5 El Sandwich Connectionist; 4.19 Qué es la Ciencia Cognitiva Coneccionista; por Michael R. W. Dawson, LibreTexts; licenciado bajo CC BY-NC-ND.