2.4: Análisis de hallazgos

- Page ID

- 143197

Objetivos de aprendizaje

- Explicar lo que nos dice un coeficiente de correlación sobre la relación entre variables

- Reconocer que la correlación no indica una relación causa-efecto entre variables

- Discutir nuestra tendencia a buscar relaciones entre variables que realmente no existen

- Explicar el muestreo aleatorio y la asignación de participantes en grupos experimentales y de control

- Discutir cómo el sesgo del experimentador o participante podría afectar los resultados de un experimento

- Identificar variables independientes y dependientes

¿Sabías que a medida que aumentan las ventas en helados, también lo hace la tasa general de delincuencia? ¿Es posible que entregarse a tu sabor favorito de helado pueda enviarte a una juerga de crímenes? O, después de cometer el delito ¿crees que podrías decidir darte un capricho? No cabe duda de que existe una relación entre el helado y el crimen (por ejemplo, Harper, 2013), pero sería bastante tonto decidir que una cosa realmente causó que ocurriera la otra.

Es mucho más probable que tanto la venta de helados como los índices delictivos estén relacionados con la temperatura exterior. Cuando la temperatura es cálida, hay mucha gente fuera de sus casas, interactuando entre sí, molestándose entre sí y, a veces, cometiendo delitos. Además, cuando hace calor afuera, es más probable que busquemos una golosina fresca como el helado. ¿Cómo determinamos si efectivamente existe una relación entre dos cosas? Y cuando hay una relación, ¿cómo podemos discernir si es atribuible a la coincidencia o a la causalidad?

Investigación correlacional

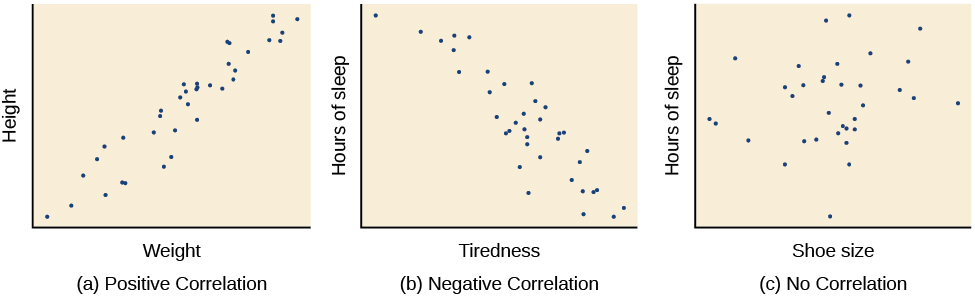

Correlación significa que existe una relación entre dos o más variables (como el consumo de helados y la delincuencia), pero esta relación no implica necesariamente causa y efecto. Cuando se correlacionan dos variables, simplemente significa que a medida que una variable cambia, también lo hace la otra. Podemos medir la correlación calculando un estadístico conocido como coeficiente de correlación. Un coeficiente de correlación es un número desde\(-1\) hasta\(+1\) que indica la fuerza y dirección de la relación entre variables. El coeficiente de correlación suele estar representado por la letra r.

La porción numérica del coeficiente de correlación indica la fuerza de la relación. Cuanto más cerca esté el número\(1\) (sea negativo o positivo), más fuertemente relacionadas estarán las variables y más predecibles serán los cambios en una variable a medida que cambie la otra variable. Cuanto más cerca esté el número de cero, más débil será la relación, y menos predecibles se vuelven las relaciones entre las variables. Por ejemplo, un coeficiente de correlación de\(0.9\) indica una relación mucho más fuerte que un coeficiente de correlación de\(0.3\). Si las variables no están relacionadas entre sí en absoluto, el coeficiente de correlación es\(0\). El ejemplo anterior sobre helado y crimen es un ejemplo de dos variables que podríamos esperar que no tengan relación entre sí.

El signo —positivo o negativo— del coeficiente de correlación indica la dirección de la relación. Una correlación positiva significa que las variables se mueven en la misma dirección. Dicho de otra manera, significa que a medida que una variable aumenta también lo hace la otra, y a la inversa, cuando una variable disminuye también lo hace la otra. Una correlación negativa significa que las variables se mueven en direcciones opuestas. Si dos variables están correlacionadas negativamente, una disminución en una variable se asocia con un aumento en la otra y viceversa.

El ejemplo de las tasas de helado y criminalidad es una correlación positiva porque ambas variables aumentan cuando las temperaturas son más cálidas. Otros ejemplos de correlaciones positivas son la relación entre la estatura y el peso de un individuo o la relación entre la edad de una persona y el número de arrugas. Se podría esperar que exista una correlación negativa entre el cansancio de alguien durante el día y el número de horas que durmió la noche anterior: la cantidad de sueño disminuye a medida que aumentan los sentimientos de cansancio. En un ejemplo del mundo real de correlación negativa, estudiantes investigadores de la Universidad de Minnesota encontraron una correlación negativa débil (\(r = -0.29\)) entre el número promedio de días por semana que los estudiantes obtuvieron menos de\(5\) horas de sueño y su GPA (Lowry, Dean, & Manders, 2010). Tenga en cuenta que una correlación negativa no es lo mismo que ninguna correlación. Por ejemplo, probablemente no encontraríamos correlación entre las horas de sueño y el tamaño del zapato.

Como se mencionó anteriormente, las correlaciones tienen valor predictivo. Imagina que estás en el comité de admisiones de una universidad mayor. Se enfrenta a una gran cantidad de solicitudes, pero solo puede acomodar un pequeño porcentaje del grupo de solicitantes. ¿Cómo podría decidir quién debe ser admitido? Podrías intentar correlacionar el GPA universitario de tus estudiantes actuales con sus puntajes en exámenes estandarizados como el SAT o ACT. Al observar qué correlaciones fueron más fuertes para tus alumnos actuales, podrías usar esta información para predecir el éxito relativo de aquellos estudiantes que han solicitado ingreso a la universidad.

La correlación no indica causalidad

La investigación correlacional es útil porque nos permite descubrir la fuerza y dirección de las relaciones que existen entre dos variables. Sin embargo, la correlación es limitada porque establecer la existencia de una relación nos dice poco de causa y efecto. Si bien las variables a veces se correlacionan porque una causa la otra, también podría ser que algún otro factor, una variable confusa, en realidad esté causando el movimiento sistemático en nuestras variables de interés. En el ejemplo de índice de helado/delincuencia mencionado anteriormente, la temperatura es una variable confusa que podría dar cuenta de la relación entre las dos variables.

Incluso cuando no podemos apuntar a borrar variables de confusión, no debemos asumir que una correlación entre dos variables implica que una variable causa cambios en otra. Esto puede resultar frustrante cuando una relación de causa y efecto parece clara e intuitiva. Piense en nuestra discusión sobre la investigación realizada por la American Cancer Society y cómo sus proyectos de investigación fueron algunas de las primeras demostraciones del vínculo entre el tabaquismo y el cáncer. Parece razonable suponer que fumar causa cáncer, pero si nos limitáramos a la investigación correlacional, estaríamos sobrepasando nuestros límites al hacer esta suposición.

Desafortunadamente, la gente hace afirmaciones erróneas de causalidad en función de correlaciones todo el tiempo. Tales afirmaciones son especialmente comunes en anuncios y noticias. Por ejemplo, investigaciones recientes encontraron que las personas que comen cereales de manera regular logran pesos más saludables que aquellos que rara vez comen cereales (Frantzen, Treviño, Echon, Garcia-Dominic, & DiMarco, 2013; Barton et al., 2005). Adivina cómo reportan las empresas de cereales este hallazgo. ¿Comer cereales realmente hace que un individuo mantenga un peso saludable, o hay otras explicaciones posibles, como, alguien con un peso saludable tiene más probabilidades de comer regularmente un desayuno saludable que alguien que es obeso o alguien que evita las comidas en un intento de dieta? Si bien la investigación correlacional es invaluable para identificar las relaciones entre variables, una limitación importante es la incapacidad de establecer causalidad. Los psicólogos quieren hacer declaraciones sobre causa y efecto, pero la única manera de hacerlo es realizar un experimento para responder a una pregunta de investigación. En la siguiente sección se describe cómo los experimentos científicos incorporan métodos que eliminan, o controlan, explicaciones alternativas, que permiten a los investigadores explorar cómo los cambios en una variable causan cambios en otra variable.

Correlaciones ilusorias

La tentación de hacer afirmaciones erróneas de causa y efecto basadas en investigaciones correlacionales no es la única manera en que tendemos a malinterpretar los datos. También tendemos a cometer el error de correlaciones ilusorias, especialmente con observaciones no sistemáticas. Correlaciones ilusorias, o correlaciones falsas, ocurren cuando la gente cree que las relaciones existen entre dos cosas cuando no existe tal relación. Una correlación ilusoria bien conocida es el supuesto efecto que las fases de la luna tienen sobre el comportamiento humano. Mucha gente afirma apasionadamente que el comportamiento humano se ve afectado por la fase de la luna, y específicamente, que las personas actúan de manera extraña cuando la luna está llena.

No se puede negar que la luna ejerce una poderosa influencia en nuestro planeta. El flujo y reflujo de las mareas oceánicas están fuertemente ligados a las fuerzas gravitacionales de la luna. Mucha gente cree, por lo tanto, que es lógico que también nos afecte la luna. Después de todo, nuestros cuerpos están formados en gran parte por agua. Un metaanálisis de casi\(40\) estudios demostró consistentemente, sin embargo, que la relación entre la luna y nuestro comportamiento no existe (Rotton & Kelly, 1985). Si bien podemos prestar más atención al comportamiento extraño durante la fase completa de la luna, las tasas de comportamiento impar permanecen constantes a lo largo del ciclo lunar.

¿Por qué estamos tan propensos a creer en correlaciones ilusorias como esta? A menudo leemos u oímos hablar de ellos y simplemente aceptamos la información como válida. O bien, tenemos una corazonada sobre cómo funciona algo y luego buscamos pruebas que respalden esa corazonada, ignorando las pruebas que nos dirían que nuestra corazonada es falsa; esto se conoce como sesgo de confirmación. Otras veces, encontramos correlaciones ilusorias basadas en la información que más se nos viene a la mente, aunque esa información esté severamente limitada. Y si bien podemos sentirnos seguros de que podemos usar estas relaciones para comprender y predecir mejor el mundo que nos rodea, las correlaciones ilusorias pueden tener inconvenientes importantes. Por ejemplo, la investigación sugiere que las correlaciones ilusorias, en las que ciertos comportamientos se atribuyen de manera inexacta a ciertos grupos, están involucradas en la formación de actitudes perjudiciales que en última instancia pueden conducir a comportamientos discriminatorios (Fiedler, 2004).

Causalidad: Realización de experimentos y uso de los datos

Como ya has aprendido, la única manera de establecer que existe una relación de causa y efecto entre dos variables es realizar un experimento científico. El experimento tiene un significado diferente en el contexto científico que en la vida cotidiana. En la conversación cotidiana, a menudo la usamos para describir probar algo por primera vez, como experimentar con un nuevo peinado o una nueva comida. Sin embargo, en el contexto científico, un experimento tiene requisitos precisos para el diseño y la implementación.

La hipótesis experimental

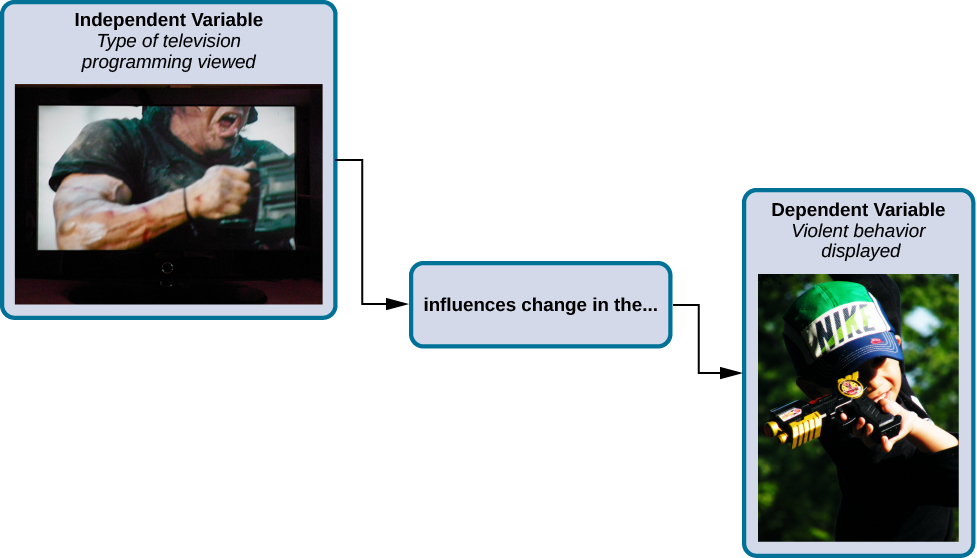

Para llevar a cabo un experimento, un investigador debe tener una hipótesis específica para ser probado. Como ya has aprendido, las hipótesis pueden formularse ya sea a través de la observación directa del mundo real o después de una cuidadosa revisión de investigaciones previas. Por ejemplo, si piensas que no se debe permitir que los niños vean programas violentos en la televisión porque hacerlo haría que se comportaran más violentamente, entonces básicamente has formulado una hipótesis, es decir, que ver programas violentos de televisión hace que los niños se comporten de manera más violenta. ¿Cómo pudo haber llegado a esta hipótesis en particular? Es posible que tengas familiares más jóvenes que ven caricaturas con personajes que usan artes marciales para salvar al mundo de los malhechores, con una impresionante variedad de puñetazos, patadas y posturas defensivas. Te das cuenta que después de ver estos programas por un tiempo, tus familiares jóvenes imitan el comportamiento combativo de los personajes retratados en la caricatura.

Este tipo de observaciones personales son las que a menudo nos llevan a formular una hipótesis específica, pero no podemos utilizar observaciones personales limitadas y evidencias anecdóticas para poner a prueba rigurosamente nuestra hipótesis. En cambio, para averiguar si los datos del mundo real apoyan nuestra hipótesis, tenemos que realizar un experimento.

Diseñar un experimento

El diseño experimental más básico involucra dos grupos: el grupo experimental y el grupo control. Los dos grupos están diseñados para ser iguales excepto por una diferencia: la manipulación experimental. El grupo experimental obtiene la manipulación experimental, es decir, el tratamiento o la variable que se está probando (en este caso, imágenes violentas de televisión) y el grupo control no. Dado que la manipulación experimental es la única diferencia entre los grupos experimental y control, podemos estar seguros de que cualquier diferencia entre los dos se debe a la manipulación experimental más que al azar.

En nuestro ejemplo de cómo la programación televisiva violenta podría afectar el comportamiento violento en niños, tenemos el grupo experimental que ve la programación televisiva violenta durante un tiempo específico y luego mide su comportamiento violento. Medimos el comportamiento violento en nuestro grupo de control después de que vean programas de televisión no violentos por la misma cantidad de tiempo. Es importante que el grupo control sea tratado de manera similar al grupo experimental, con la excepción de que el grupo control no recibe la manipulación experimental. Por lo tanto, tenemos al grupo de control viendo programas de televisión no violentos durante la misma cantidad de tiempo que el grupo experimental.

También necesitamos definir con precisión, u operacionalizar, lo que se considera violento y no violento. Una definición operativa es una descripción de cómo mediremos nuestras variables, y es importante para permitir que otros entiendan exactamente cómo y qué mide un investigador en un experimento en particular. Al operacionalizar el comportamiento violento, podríamos optar por contar solo los actos físicos como patear o golpear como instancias de este comportamiento, o también podemos optar por incluir intercambios verbales enojados. Independientemente de lo que determinemos, es importante que operacionalicemos el comportamiento violento de tal manera que cualquiera que por primera vez escuche sobre nuestro estudio sepa exactamente a qué nos referimos con violencia. Esto ayuda a la capacidad de las personas para interpretar nuestros datos, así como su capacidad para repetir nuestro experimento si así lo deciden.

Una vez que hayamos operacionalizado lo que se considera programación televisiva violenta y lo que se considera comportamiento violento por parte de los participantes de nuestro experimento, necesitamos establecer cómo vamos a ejecutar nuestro experimento. En este caso, podríamos hacer que los participantes vean un programa de televisión de un\(30\) minuto (ya sea violento o no violento, dependiendo de su pertenencia al grupo) antes de enviarlos a un patio de recreo durante una hora donde se observe su comportamiento y se registre el número y tipo de actos violentos.

Idealmente, las personas que observan y registran el comportamiento de los niños desconocen quién fue asignado al grupo experimental o control, con el fin de controlar por sesgo experimentador. El sesgo del experimentador se refiere a la posibilidad de que las expectativas de un investigador puedan sesgar los resultados del estudio. Recuerde, realizar un experimento requiere mucha planeación, y las personas involucradas en el proyecto de investigación tienen un interés personal en apoyar sus hipótesis. Si los observadores supieran qué niño estaba en qué grupo, podría influir en la atención que prestaban al comportamiento de cada niño así como en cómo interpretaban ese comportamiento. Al ser ciegos a qué niño está en qué grupo, protegemos contra esos sesgos. Esta situación es un estudio monociego, lo que significa que uno de los grupos (participantes) desconoce en qué grupo se encuentran (grupo experimental o control) mientras que el investigador que desarrolló el experimento sabe qué participantes están en cada grupo.

En un estudio doble ciego, tanto los investigadores como los participantes son ciegos a las tareas grupales. ¿Por qué un investigador querría realizar un estudio donde nadie sabe quién está en qué grupo? Porque al hacerlo, podemos controlar tanto las expectativas del experimentador como de los participantes. Si estás familiarizado con la frase efecto placebo, ya tienes alguna idea de por qué esta es una consideración importante. El efecto placebo ocurre cuando las expectativas o creencias de las personas influyen o determinan su experiencia en una situación determinada. En otras palabras, simplemente esperar que algo suceda en realidad puede hacer que suceda.

El efecto placebo se describe comúnmente en términos de probar la efectividad de un nuevo medicamento. Imagina que trabajas en una compañía farmacéutica, y crees que tienes un nuevo medicamento que es efectivo en el tratamiento de la depresión. Para demostrar que tu medicamento es efectivo, haces un experimento con dos grupos: El grupo experimental recibe el medicamento, y el grupo control no. Pero no quieres que los participantes sepan si recibieron el medicamento o no.

¿Por qué es eso? Imagina que eres participante en este estudio, y acabas de tomar una pastilla que crees que mejorará tu estado de ánimo. Debido a que esperas que la píldora tenga un efecto, es posible que te sientas mejor simplemente porque tomaste la píldora y no por ningún medicamento realmente contenido en la píldora, este es el efecto placebo.

Para asegurarse de que cualquier efecto sobre el estado de ánimo se deba al medicamento y no a las expectativas, el grupo de control recibe un placebo (en este caso una píldora de azúcar). Ahora todos reciben una pastilla, y una vez más ni el investigador ni los participantes experimentales saben quién consiguió el medicamento y quién consiguió la píldora de azúcar. Cualquier diferencia en el estado de ánimo entre los grupos experimental y control ahora se puede atribuir a la droga en sí más que al sesgo del experimentador o a las expectativas de los participantes.

Variables independientes y dependientes

En un experimento de investigación, nos esforzamos por estudiar si los cambios en una cosa causan cambios en otra. Para lograrlo, debemos prestar atención a dos variables importantes, o cosas que se pueden cambiar, en cualquier estudio experimental: la variable independiente y la variable dependiente. Una variable independiente es manipulada o controlada por el experimentador. En un estudio experimental bien diseñado, la variable independiente es la única diferencia importante entre los grupos experimental y control. En nuestro ejemplo de cómo los programas de televisión violentos afectan la demostración de comportamiento violento por parte de los niños, la variable independiente es el tipo de programa —violento o no violento-que ven los participantes en el estudio. Una variable dependiente es lo que mide el investigador para ver cuánto efecto tuvo la variable independiente. En nuestro ejemplo, la variable dependiente es el número de actos violentos que muestran los participantes experimentales.

Esperamos que la variable dependiente cambie en función de la variable independiente. En otras palabras, la variable dependiente depende de la variable independiente. Una buena manera de pensar sobre la relación entre las variables independientes y dependientes es con esta pregunta: ¿Qué efecto tiene la variable independiente en la variable dependiente? Volviendo a nuestro ejemplo, ¿qué efecto tiene ver media hora de programación televisiva violenta o no violenta en el número de incidentes de agresión física exhibidos en el patio de recreo?

Selección y Asignación de Participantes Experimentales

Ahora que nuestro estudio está diseñado, necesitamos obtener una muestra de individuos para incluir en nuestro experimento. Nuestro estudio involucra a participantes humanos por lo que necesitamos determinar a quién incluir. Los participantes son sujetos de investigación psicológica, y como su nombre lo indica, los individuos involucrados en la investigación psicológica participan activamente en el proceso. A menudo, los proyectos de investigación psicológica dependen de estudiantes universitarios para que sirvan como participantes. De hecho, la gran mayoría de la investigación en subcampos de psicología ha involucrado históricamente a los estudiantes como participantes de la investigación (Sears, 1986; Arnett, 2008). Pero, ¿los universitarios son verdaderamente representativos de la población en general? Los estudiantes universitarios tienden a ser más jóvenes, más educados, más liberales y menos diversos que la población general. Aunque usar a los estudiantes como sujetos de prueba es una práctica aceptada, confiar en un grupo tan limitado de participantes de la investigación puede ser problemático porque es difícil generalizar los hallazgos a la población más grande.

Nuestro experimento hipotético involucra a niños, y primero debemos generar una muestra de niños participantes. Las muestras se utilizan porque las poblaciones suelen ser demasiado grandes para involucrar razonablemente a cada miembro en nuestro experimento particular. Si es posible, deberíamos usar una muestra aleatoria (hay otros tipos de muestras, pero para los fines de este capítulo, nos centraremos en muestras aleatorias). Una muestra aleatoria es un subconjunto de una población mayor en la que cada miembro de la población tiene las mismas posibilidades de ser seleccionado. Se prefieren muestras aleatorias porque si la muestra es lo suficientemente grande podemos estar razonablemente seguros de que los individuos participantes son representativos de la población más grande. Esto significa que los porcentajes de características en la muestra —sexo, etnia, nivel socioeconómico y cualquier otra característica que pueda afectar los resultados— son cercanos a esos porcentajes en la población mayor.

En nuestro ejemplo, digamos que decidimos que nuestra población de interés es de cuarto grado. Pero todos los estudiantes de cuarto grado son una población muy grande, por lo que necesitamos ser más específicos; en cambio podríamos decir que nuestra población de interés es la totalidad de estudiantes de cuarto grado en una ciudad en particular. Deberíamos incluir estudiantes de diversos grupos de ingresos, situaciones familiares, razas, etnias, religiones y áreas geográficas de la ciudad. Con esta población más manejable, podemos trabajar con las escuelas locales en la selección de una muestra aleatoria de alrededor de estudiantes de\(200\) cuarto grado que queremos participar en nuestro experimento.

En resumen, debido a que no podemos probar a todos los alumnos de cuarto grado en una ciudad, queremos encontrar un grupo de aproximadamente\(200\) que refleje la composición de esa ciudad. Con un grupo representativo, podemos generalizar nuestros hallazgos a la población más grande sin temor a que nuestra muestra sea sesgada de alguna manera.

Ahora que tenemos una muestra, el siguiente paso del proceso experimental es dividir a los participantes en grupos experimentales y de control mediante asignación aleatoria. Con asignación aleatoria, todos los participantes tienen las mismas posibilidades de ser asignados a cualquiera de los dos grupos. Existe un software estadístico que asignará aleatoriamente a cada uno de los alumnos de cuarto grado de la muestra ya sea al grupo experimental o al grupo control.

La asignación aleatoria es crítica para el diseño experimental de sonido. Con muestras suficientemente grandes, la asignación aleatoria hace poco probable que existan diferencias sistemáticas entre los grupos. Entonces, por ejemplo, sería muy poco probable que consigamos un grupo compuesto enteramente por varones, una determinada identidad étnica, o una ideología religiosa dada. Esto es importante porque si los grupos fueran sistemáticamente diferentes antes de comenzar el experimento, no sabríamos el origen de las diferencias que encontramos entre los grupos: ¿Las diferencias eran preexistentes, o fueron causadas por la manipulación de la variable independiente? La asignación aleatoria permite suponer que cualquier diferencia observada entre los grupos experimental y control resulta de la manipulación de la variable independiente.

Cuestiones a considerar

Si bien los experimentos permiten a los científicos hacer afirmaciones de causa y efecto, no están exentos de problemas. Los verdaderos experimentos requieren que el experimentador manipule una variable independiente, y eso puede complicar muchas preguntas que los psicólogos podrían querer abordar. Por ejemplo, imagina que quieres saber qué efecto tiene el sexo (la variable independiente) sobre la memoria espacial (la variable dependiente). Aunque ciertamente puedes buscar diferencias entre hombres y mujeres en una tarea que aprovecha la memoria espacial, no puedes controlar directamente el sexo de una persona. Clasificamos este tipo de enfoque de investigación como cuasiexperimental y reconocemos que no podemos hacer afirmaciones de causa y efecto en estas circunstancias.

Los experimentadores también están limitados por restricciones éticas. Por ejemplo, no podrías realizar un experimento diseñado para determinar si experimentar abuso cuando eras niño lleva a menores niveles de autoestima entre los adultos. Para llevar a cabo tal experimento, necesitarías asignar aleatoriamente algunos participantes experimentales a un grupo que recibe abuso, y ese experimento no sería ético.

Interpretación de Hallazgos Experimentales

Una vez recolectados los datos tanto del grupo experimental como del grupo testigo, se realiza un análisis estadístico para averiguar si existen diferencias significativas entre los dos grupos. Un análisis estadístico determina la probabilidad de que cualquier diferencia encontrada se deba a la casualidad (y por lo tanto no significativa). En psicología, las diferencias de grupo se consideran significativas, o significativas, si las probabilidades de que estas diferencias ocurran solo por casualidad son\(5\) por ciento o menos. Dicho de otra manera, si repetimos este experimento\(100\) veces, esperaríamos encontrar los mismos resultados al menos\(95\) veces fuera de\(100\).

La mayor fortaleza de los experimentos es la capacidad de afirmar que cualquier diferencia significativa en los hallazgos es causada por la variable independiente. Esto ocurre porque la selección aleatoria, la asignación aleatoria y un diseño que limite los efectos tanto del sesgo del experimentador como de la expectativa de los participantes deben crear grupos que sean similares en composición y tratamiento. Por lo tanto, cualquier diferencia entre los grupos es atribuible a la variable independiente, y ahora finalmente podemos hacer una declaración causal. Si encontramos que ver un programa de televisión violento da como resultado un comportamiento más violento que ver un programa no violento, podemos decir con seguridad que ver programas de televisión violentos provoca un aumento en la visualización de comportamientos violentos.

Investigación de informes

Cuando los psicólogos completan un proyecto de investigación, generalmente quieren compartir sus hallazgos con otros científicos. La American Psychological Association (APA) publica un manual que detalla cómo escribir un artículo para su presentación a revistas científicas. A diferencia de un artículo que podría publicarse en una revista como Psychology Today, que se dirige a un público general con interés en la psicología, las revistas científicas generalmente publican artículos de revistas revisadas por pares dirigidos a una audiencia de profesionales y académicos que son activamente involucrados en la investigación ellos mismos.

Un artículo de revista revisado por pares es leído por varios otros científicos (generalmente de forma anónima) con experiencia en el tema. Estos revisores pares proporcionan retroalimentación, tanto al autor como al editor de la revista, sobre la calidad del borrador. Los revisores pares buscan una sólida justificación para la investigación que se describe, una descripción clara de cómo se realizó la investigación y evidencia de que la investigación se realizó de manera ética. También buscan fallas en el diseño, los métodos y los análisis estadísticos del estudio. Comprueban que las conclusiones extraídas por los autores parecen razonables dadas las observaciones realizadas durante la investigación. Los revisores pares también comentan lo valiosa que es la investigación para avanzar en el conocimiento de la disciplina. Esto ayuda a evitar duplicaciones innecesarias de hallazgos de investigación en la literatura científica y, en cierta medida, asegura que cada artículo de investigación proporcione nueva información. En última instancia, el editor de la revista recopilará todos los comentarios de los revisores pares y determinará si el artículo se publicará en su estado actual (una ocurrencia rara), se publicará con revisiones o no se aceptará para su publicación.

La revisión por pares proporciona cierto grado de control de calidad para la investigación psicológica. Los estudios mal concebidos o ejecutados pueden ser eliminados, e incluso investigaciones bien diseñadas pueden ser mejoradas por las revisiones sugeridas. La revisión por pares también asegura que la investigación se describa con la suficiente claridad como para permitir que otros científicos la repliquen, lo que significa que pueden repetir el experimento usando diferentes muestras para determinar la confiabilidad. En ocasiones, las réplicas implican medidas adicionales que amplían el hallazgo original. En cualquier caso, cada réplica sirve para proporcionar más evidencia que respalde los hallazgos originales de la investigación. Las réplicas exitosas de investigaciones publicadas hacen que los científicos sean más propensos a adoptar esos hallazgos, mientras que los repetidos fracasos tienden a poner en duda la legitimidad del artículo original y llevan a los científicos a buscar en otra parte. Por ejemplo, sería un avance importante en el campo médico si un estudio publicado indicara que tomar un nuevo medicamento ayudaba a los individuos a alcanzar un peso saludable sin cambiar su dieta. Pero si otros científicos no pudieran replicar los resultados, se cuestionarían las afirmaciones del estudio original.

Profundice: El mito vacuna-autismo y la retracción de los estudios publicados

Algunos científicos han afirmado que las vacunas infantiles de rutina hacen que algunos niños desarrollen autismo y, de hecho, varias publicaciones revisadas por pares publicaron investigaciones que hacen estas afirmaciones. Desde los reportes iniciales, la investigación epidemiológica a gran escala ha sugerido que las vacunas no son responsables de causar autismo y que es mucho más seguro vacunar a tu hijo que no. Además, varios de los estudios originales que hacen esta afirmación se han retractado desde entonces.

Un trabajo publicado puede ser rescindido cuando los datos son cuestionados por falsificación, fabricación o serios problemas de diseño de investigación. Una vez rescindida, se informa a la comunidad científica que existen serios problemas con la publicación original. Las retracciones pueden ser iniciadas por el investigador que dirigió el estudio, por los colaboradores de la investigación, por la institución que empleó al investigador, o por el consejo editorial de la revista en la que se publicó originalmente el artículo. En el caso vacuna-autismo, la retracción se realizó por un importante conflicto de intereses en el que el investigador líder tuvo un interés económico en establecer un vínculo entre las vacunas infantiles y el autismo (Offit, 2008). Desafortunadamente, los estudios iniciales recibieron tanta atención mediática que muchos padres de todo el mundo dudaron en vacunar a sus hijos (Figura). Para obtener más información sobre cómo se desarrolló la historia vacuna/autismo, así como las repercusiones de esta historia, eche un vistazo al libro de Paul Offit, Los falsos profetas del autismo: mala ciencia, medicina riesgosa y la búsqueda de una cura.

Confiabilidad y Validez

La confiabilidad y validez son dos consideraciones importantes que deben hacerse con cualquier tipo de recolección de datos. La confiabilidad se refiere a la capacidad de producir consistentemente un resultado dado. En el contexto de la investigación psicológica, esto significaría que cualquier instrumento o herramienta utilizada para recolectar datos lo haga de manera consistente y reproducible.

Desafortunadamente, ser consistente en la medición no significa necesariamente que hayas medido algo correctamente. Para ilustrar este concepto, considera una báscula de cocina que se utilizaría para medir el peso del cereal que comes por la mañana. Si la báscula no está correctamente calibrada, puede subestimar o sobreestimar de manera consistente la cantidad de cereal que se está midiendo. Si bien la báscula es altamente confiable para producir resultados consistentes (por ejemplo, la misma cantidad de cereal vertida en la báscula produce la misma lectura cada vez), esos resultados son incorrectos. Aquí es donde entra en juego la validez. La validez se refiere a la medida en que un determinado instrumento o herramienta mide con precisión lo que se supone que debe medir. Si bien cualquier medida válida es por necesidad confiable, lo contrario no es necesariamente cierto. Los investigadores se esfuerzan por utilizar instrumentos que sean altamente confiables y válidos.

CONEXIÓN DIARIO: ¿Qué tan válido es el SAT?

Se supone que las pruebas estandarizadas como el SAT miden la aptitud de un individuo para una educación universitaria, pero ¿qué tan confiables y válidas son tales pruebas? La investigación realizada por el College Board sugiere que los puntajes en el SAT tienen una alta validez predictiva para el GPA de los estudiantes universitarios de primer año (Kobrin, Patterson, Shaw, Mattern, & Barbuti, 2008). En este contexto, la validez predictiva se refiere a la capacidad de la prueba para predecir efectivamente el GPA de estudiantes universitarios de primer año. Dado que muchas instituciones de educación superior requieren del SAT para su ingreso, este alto grado de validez predictiva podría ser reconfortante.

No obstante, el énfasis puesto en los puntajes del SAT en las admisiones universitarias ha generado cierta polémica en varios frentes. Por un lado, algunos investigadores afirman que el SAT es una prueba sesgada que coloca a los estudiantes de minorías en desventaja y reduce injustamente la probabilidad de ser admitidos en una universidad (Santelices & Wilson, 2010). Adicionalmente, algunas investigaciones han sugerido que la validez predictiva del SAT es muy exagerada en lo bien que es capaz de predecir el GPA de los estudiantes universitarios de primer año. De hecho, se ha sugerido que la validez predictiva del SAT puede ser sobreestimada tanto como\(150\%\) (Rothstein, 2004). Muchas instituciones de educación superior están empezando a considerar desenfatizar la importancia de los puntajes del SAT en la toma de decisiones de admisión (Rimer, 2008).

En 2014, el presidente de College Board, David Coleman, expresó su conciencia de estos problemas, reconociendo que el éxito universitario se predice con mayor precisión por los grados de secundaria que por los puntajes del SAT Para atender estas preocupaciones, ha pedido cambios significativos en el examen SAT (Lewin, 2014).

Resumen

Se describe una correlación con un coeficiente de correlación,\(r\), que va de\(-1\) a\(+1\). El coeficiente de correlación nos habla de la naturaleza (positiva o negativa) y la fuerza de la relación entre dos o más variables. Las correlaciones no nos dicen nada sobre la causación—independientemente de cuán fuerte sea la relación entre las variables. De hecho, la única manera de demostrar la causalidad es realizando un experimento. La gente suele cometer el error de afirmar que las correlaciones existen cuando realmente no lo hacen.

Los investigadores pueden probar hipótesis de causa y efecto realizando experimentos. Idealmente, los participantes experimentales son seleccionados aleatoriamente de la población de interés. Después, los participantes son asignados aleatoriamente a sus respectivos grupos. En ocasiones, el investigador y los participantes son ciegos a la pertenencia al grupo para evitar que sus expectativas influyan en los resultados.

En el diseño experimental ideal, la única diferencia entre los grupos experimental y control es si los participantes están expuestos a la manipulación experimental. Cada grupo pasa por todas las fases del experimento, pero cada grupo experimentará un nivel diferente de la variable independiente: el grupo experimental está expuesto a la manipulación experimental, y el grupo control no está expuesto a la manipulación experimental. Luego, el investigador mide los cambios que se producen en la variable dependiente en cada grupo. Una vez recolectados los datos de ambos grupos, se analizan estadísticamente para determinar si existen diferencias significativas entre los grupos.

Los psicólogos reportan sus hallazgos de investigación en artículos de revistas revisadas por pares. La investigación publicada en este formato es verificada por varios otros psicólogos que sirven como filtro separando ideas que están sustentadas en evidencias de ideas que no lo son. La replicación tiene un papel importante para garantizar la legitimidad de la investigación publicada. A la larga, solo aquellos hallazgos que sean capaces de ser replicados consistentemente lograrán consensos en la comunidad científica.

Glosario

- relación causa-efecto

- los cambios en una variable causan los cambios en la otra variable; solo se pueden determinar a través de un diseño de investigación experimental

- sesgo de confirmación

- tendencia a ignorar evidencias que desmienten ideas o creencias

- variable de confusión

- factor externo imprevisto que afecta a ambas variables de interés, dando a menudo la falsa impresión de que los cambios en una variable provocan cambios en la otra variable, cuando, en la actualidad, el factor externo provoca cambios en ambas variables

- grupo de control

- sirve como base para la comparación y controla los factores de azar que podrían influir en los resultados del estudio, al mantener dichos factores constantes entre grupos para que la manipulación experimental sea la única diferencia entre los grupos

- correlación

- relación entre dos o más variables; cuando dos variables están correlacionadas, una variable cambia como lo hace la otra

- coeficiente de correlación

- número de -1 a +1, indicando la fuerza y dirección de la relación entre variables, y generalmente representado por r

- variable dependiente

- variable que mide el investigador para ver cuánto efecto tuvo la variable independiente

- estudio doble ciego

- experimento en el que tanto los investigadores como los participantes son ciegos a las asignaciones grupales

- grupo experimental

- grupo diseñado para responder a la pregunta de investigación; la manipulación experimental es la única diferencia entre los grupos experimental y control, por lo que cualquier diferencia entre los dos se debe a la manipulación experimental más que al azar

- sesgo del experimentador

- expectativas del investigador sesgan los resultados del estudio

- correlación ilusoria

- ver las relaciones entre dos cosas cuando en realidad no existe tal relación

- variable independiente

- variable que es influenciada o controlada por el experimentador; en un estudio experimental sonoro, la variable independiente es la única diferencia importante entre el grupo experimental y el grupo control

- correlación negativa

- dos variables cambian en diferentes direcciones, con una cada vez más grande a medida que la otra se vuelve más pequeña; una correlación negativa no es lo mismo que ninguna correlación

- definición operativa

- descripción de qué acciones y operaciones se utilizarán para medir las variables dependientes y manipular las variables independientes

- participantes

- temas de investigación psicológica

- artículo de revista revisado por pares

- artículo leído por varios otros científicos (generalmente de forma anónima) con experiencia en el tema, quienes brindan retroalimentación sobre la calidad del manuscrito antes de que sea aceptado para su publicación

- efecto placebo

- las expectativas o creencias de las personas que influyen o determinan su experiencia en una situación determinada

- correlación positiva

- dos variables cambian en la misma dirección, siendo ambas más grandes o más pequeñas

- asignación aleatoria

- método de asignación de grupo experimental en el que todos los participantes tienen la misma oportunidad de ser asignados a cualquiera de los grupos

- muestra aleatoria

- subconjunto de una población mayor en la que cada miembro de la población tiene las mismas posibilidades de ser seleccionado

- fiabilidad

- consistencia y reproducibilidad de un resultado dado

- replicar

- repetir un experimento usando diferentes muestras para determinar la confiabilidad de la investigación

- estudio simple ciego

- experimento en el que el investigador conoce qué participantes están en el grupo experimental y cuáles están en el grupo control

- análisis estadístico

- determina la probabilidad de que cualquier diferencia entre los grupos experimentales se deba a la casualidad

- validez

- precisión de un resultado dado en la medición de lo que está diseñado para medir