2.6: Características cualitativas de la entropía

- Page ID

- 128850

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

El concepto de entropía es notoriamente difícil de entender. Incluso el consumado matemático y físico Johnny von Neumann afirmó que “nadie sabe realmente qué es la entropía de todos modos”. Si bien tenemos una fórmula exacta y notablemente simple para la entropía de un macroestado en términos del número de microestados correspondientes, esta simplicidad se limita a ocultar la sutil caracterización necesaria para una comprensión real del concepto de entropía. Para obtener esa comprensión, debemos examinar las sorpresas verdaderamente maravillosas (en el significado original de esa palabra sobreutilizada) que presenta esta sencilla fórmula cuando se aplica a sistemas físicos reales.

Sorpresas

El gas ideal monatómico

Examinemos cualitativamente la fórmula de Sackur-Tetrode (2.32) para ver si concuerda con nuestra comprensión de la entropía como proporcional al número de microestados correspondientes a un macroestado dado. Si\(V\) se incrementa el volumen, entonces la fórmula establece que la entropía\(S\) aumenta, lo que ciertamente parece razonable: Si el volumen sube, entonces cada partícula tiene más lugares donde puede estar, por lo que la entropía debería aumentar. Si\(E\) se incrementa la energía, entonces\(S\) aumenta, lo que de nuevo parece razonable: Si hay más energía alrededor, entonces habrá más formas diferentes de dividirla y compartirla entre las partículas, así que esperamos que la entropía aumente. (Así como hay muchas más formas de distribuir un botín grande entre cierto número de piratas que hay de distribuir un botín pequeño). Pero, ¿y si la masa m de cada partícula aumenta? (Experimentalmente, se podría comparar la entropía de, digamos, argón y criptón en idénticas condiciones. Ver problema 2.27.) Nuestra fórmula muestra que la entropía aumenta con la masa, pero ¿hay alguna manera de entenderlo cualitativamente?

De hecho, puedo producir no sólo uno sino dos argumentos cualitativos relativos a la\(S\) dependencia de\(m\). ¡Desafortunadamente los dos argumentos dan resultados opuestos! El primero se basa en el hecho de que

\[E=\frac{1}{2 m} \sum_{i} p_{i}^{2},\]

así que para una energía dada\(E\), cualquier partícula individual puede tener un impulso que va de 0 a\( \sqrt{2mE}\). Una masa mayor implica un rango más amplio de posibles momentos, lo que sugiere más microestados y una mayor entropía. El segundo argumento se basa en el hecho de que

\[E=\frac{m}{2} \sum_{i} v_{i}^{2},\]

así que para una energía dada\(E\), cualquier partícula individual puede tener una velocidad que va de 0 a\( \sqrt{E/m}\). Una masa mayor implica un rango reducido de velocidades posibles, lo que sugiere menos microestados y una entropía más pequeña. La moral es simple: ¡Los argumentos cualitativos pueden ser contraproducentes!

Esa es la moraleja de la paradoja. La resolución de la paradoja es a la vez más profunda y sutil: depende de que el hogar propio de la mecánica estadística es el espacio de fases, no el espacio de configuración, porque el teorema de Liouville implica la conservación del volumen en el espacio de fase, no en el espacio de configuración. Este tema preocupó profundamente a los fundadores de la mecánica estadística. Véase Ludwig Boltzmann, Vorlesungen über Gastheorie (J.A. Barth, Leipzig, 1896—98), parte II, capítulos III y VII [traducido al inglés por Stephen G. Brush: Conferencias sobre teoría del gas (University of California Press, Berkeley, 1964)]; J. Willard Gibbs, Elementary Principles in Mecánica estadística (C. Scribner's Sons, Nueva York, 1902), página 3; y Richard C. Tolman, Los principios de la mecánica estadística (Oxford University Press, Oxford, Reino Unido, 1938), páginas 45, 51—52.

Congelación de agua

Es común escuchar entropía asociada con “trastorno”, “suavidad” u “homogeneidad”. ¿Cómo soportan estas asociaciones la simple situación de un recipiente con agua líquida colocado en un congelador? Inicialmente el agua es lisa y homogénea. A medida que baja su temperatura, la muestra permanece homogénea hasta alcanzar el punto de congelación. A la temperatura de congelación la muestra es una mezcla no homogénea de hielo y agua líquida hasta que todo el líquido se congela. Entonces la muestra vuelve a ser homogénea ya que la temperatura sigue bajando. Así, la muestra ha pasado de homogénea a no homogénea a homogénea, sin embargo, a la vez su entropía ha disminuido. (Veremos más adelante que la entropía de una muestra siempre disminuye a medida que baja su temperatura).

Supongamos que luego el hielo se agrieta de su tazón para hacer astillas, las cuales se vuelven a colocar en el recipiente y se dejan reposar a temperatura ambiente hasta que se derriten. El revoltijo de astillas de hielo irregulares ciertamente parece desordenado en relación con el cuenco homogéneo de agua de deshielo, sin embargo son las astillas de hielo las que tienen la entropía más baja. La moraleja aquí es que la enorme cantidad de grados microscópicos de libertad en el agua de deshielo eclipsan por completo el número mínimo de grados macroscópicos de libertad en las astillas de hielo desmenuzadas. Pero las analogías de la entropía con el “desorden” o la “suavidad” nos invitan a ignorar esta moral y concentrarnos en la apariencia burda del sistema y en los rasgos macroscópicos casi irrelevantes.

Fases de reentrada

Cuando la temperatura baja a presión constante, la mayoría de los materiales puros pasan de gas a líquido a sólido. Pero los materiales inusuales llamados “cristales líquidos”, que consisten en moléculas similares a barras, muestran un mayor número de fases. Para los cristales líquidos típicos, la fase líquida de alta temperatura es isotrópica, lo que significa que las posiciones y las orientaciones de las moléculas están dispersas casi al azar. A temperaturas más bajas, la sustancia experimenta una transición a la llamada fase “nemática”, en la que las moléculas tienden a orientarse

Figura\(\PageIndex{1}\): Diagrama de fases de una mezcla de cristal líquido. La variable “composición” se refiere a la relación de peso molecular de 6OCB a 8OCB.

en la misma dirección pero en la que las posiciones siguen dispersas. A temperaturas aún más bajas pasa a la fase “esméctica”, en la que las moléculas se orientan en la misma dirección y sus posiciones tienden a caer en planos. Finalmente, a temperaturas aún más bajas, las moléculas se congelan en un sólido convencional. La historia contada hasta ahora refuerza la imagen de “la entropía como trastorno”, con fases de temperatura más baja (de ahí menor entropía) mostrando cada vez más orden cualitativo.

Pero no todos los cristales líquidos se comportan exactamente de esta manera. Un material llamado “hexiloxi-cianobifenilo” o “6OCB” pasa de líquido isotrópico a nemático a esméctico y luego de nuevo a nemático a medida que baja la temperatura. La primera transición sugiere que la fase nemática es “menos ordenada” que la fase esméctica, ¡mientras que la segunda transición sugiere lo contrario!

Se podría argumentar que la fase nemática de baja temperatura, la llamada “nemática reentrante”, es de alguna manera cualitativamente diferente en carácter de la nemática de mayor temperatura, pero los experimentos resumidos en la figura\(\PageIndex{1}\) demuestran que este no es el caso. Estos experimentos involucran un material similar de cristal líquido llamado “octiloxi-cianobifenilo” o “8OCB” que no tiene ninguna fase esméctica en absoluto. Agregar un poco\(\text{8OCB}\) a una muestra de\(\text{6OCB}\) reduce el rango de temperatura sobre el cual existe la fase esméctica. Agregar un poco más reduce ese rango aún más. Finalmente, la adición de suficiente\(\text{8OCB}\) hace que la fase esméctica desaparezca por completo. La implicación de la figura\(\PageIndex{1}\) es clara: no hay diferencia cualitativa entre las fases nemáticas habituales y las nemáticas reentrantes; se puede mover continuamente de una a otra en el diagrama de fases de temperatura-composición.

Figura\(\PageIndex{2}\): Diagrama de fases para una mezcla de agua y nicotina.

La implicación de las fases reentrantes para la entropía es profunda: Bajo algunas condiciones la fase nemática tiene más entropía que la fase esméctica y bajo otras condiciones menos, mientras que en todos los casos la nemática está cualitativamente menos ordenada. Otro ejemplo de comportamiento reentrante aparece en el diagrama de fases de la mezcla de agua y nicotina (ver figura\(\PageIndex{2}\)). Para un amplio rango de proporciones de mezcla, esta mezcla es una solución homogénea a altas temperaturas, se segrega en fases ricas en agua y ricas en nicotina a temperaturas moderadas, pero se vuelve homogénea nuevamente a bajas temperaturas. A proporciones de mezcla más cercanas al agua pura o nicotina pura, la mezcla es homogénea a todas las temperaturas. Así, las fases homogéneas de alta temperatura y reentrada son de hecho la misma fase. (Las fases reentrantes también se encuentran en los superconductores tipo II).

Rust

Según un concepto erróneo común, “La ley de entropía describe la tendencia de todos los objetos a oxidarse, romperse, desmoronarse, desgastarse y, de otra manera, pasar a un estado menos ordenado”. 6 O “La entropía tiende a hacer que nuestros ojos se debiliten a medida que envejecemos.. la entropía hace que el hierro y otros metales se oxiden”. 7 O “La entropía se impone en forma de limitación y en la tendencia natural hacia la confusión y el caos, hacia la decadencia y la destrucción. La entropía es por lo que el helado se derrite y la gente muere. Es por eso que los autos se oxidan y los bosques arden Preponderantemente, la segunda ley describe efectos que no queremos ver”. 8

Al menos un error se mantiene en común por estas tres comillas. ¿La oxidación conduce a un aumento de la entropía?

La reacción de óxido es

\[\text{4 Fe } + \text{ 3 O}_2 \to \text{ 2 Fe}_2\text{O}_3.\]

De acuerdo con las tablas estándar 9 la entropía (a temperatura ambiente\(\text{298.15 K}\) y a presión\(\text{105 Pa}\)) de un mol de\(\text{Fe}\) es\(\text{27.280 J/K}\), de un mol de\(\text{O}_2\) es\(\text{205.147 J/K}\), y de un mol de\(\text{Fe}_2\text{O}_3\) es\(\text{87.404 J/K}\). La entropía de los reactivos es\(\text{724.561 J/K}\), la entropía de los productos es\(\text{174.808 J/K}\), por lo que la reacción da como resultado una disminución de entropía de\(\text{549.753 J/K}\).

Es fácil entender por qué esto debería ser así: los gases suelen tener entropías mucho mayores que los sólidos. Y por supuesto esto no quiere decir que durante la oxidación, la entropía del universo disminuya: aunque la entropía del hierro más oxígeno disminuya, la entropía del entorno aumenta aún más. Sin embargo, es claro que la oxidación en sí misma implica una disminución de la entropía, no un aumento.

La entropía y el gas reticular

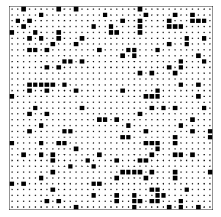

Los cuatro ejemplos anteriores deberían advertirnos sobre apoyarnos en argumentos cualitativos relativos a la entropía. Aquí hay otra situación 10 para desafiar tu intuición: La página siguiente muestra dos configuraciones de\(132 = 169\) cuadrados arrojados hacia abajo sobre un área que tiene espacios\(35 \times 35 = 1225\) vacíos, cada uno de los cuales podría contener un cuadrado. (Este sistema se llama el “modelo de gas de celosía”). Las dos configuraciones fueron producidas por dos programas de computadora diferentes (Toss1 y Tosc2) que utilizaron reglas diferentes para posicionar los cuadrados. (Las reglas se presentarán en su momento; por el momento revelaré únicamente que ambas reglas emplean números aleatorios). ¿Qué configuración crees que tiene la mayor entropía? Asegúrese de mirar las configuraciones, reflexionar y hacer una conjetura (no importa cuán mal informado) antes de seguir leyendo.

Figura\(\PageIndex{3}\): Una configuración de gas reticular generada por el programa Toss1.

Figura\(\PageIndex{4}\): Una configuración de gas reticular generada por el programa Tosc2.

Antes de analizar estas imágenes, primero debo confesar que mi pregunta fue muy engañosa. Pregunté “¿Qué configuración tiene la mayor entropía?” , pero la entropía no se define en términos de una sola configuración (un solo microestado). En cambio, la entropía se define para un macroestado, y se relaciona con el número de microestados que el sistema puede tomar y aún clasificarse en ese mismo macroestado. En lugar de hacer la pregunta que hice, debería haber señalado que tenía dos clases, dos albercas, de microestados, y que usé mis dos programas de computadora para seleccionar un miembro de cada una de esas dos piscinas. La selección se realizó al azar, por lo que la configuración seleccionada debe considerarse típica. Por lo tanto, mi pregunta debería haber sido “¿Qué configuración se extrajo de la piscina más grande?” , o “¿Qué configuración es típica de la clase más grande?”. Ante esta pregunta corregida, es posible que desee volver atrás y mirar las configuraciones nuevamente.

He hecho estas preguntas a varias personas (tanto estudiantes como profesionales) y la mayoría de ellas adivinan que la configuración inferior (la salida del programa Tosc2), es típica de la clase con mayor entropía. La configuración inferior es más suave, menos grumoso. Miran la configuración superior y ven patrones, lo que sugiere algún proceso ordenado para producir esa configuración, mientras que la suavidad de la configuración inferior sugiere un proceso de construcción aleatorio y desordenado. Déjame terminar con el suspenso y decirte cómo mis programas de computadora produjeron las dos configuraciones. La configuración superior se produjo arrojando\(169 = (13)^2\) cuadrados al azar sobre un área con\(35 \times 35 = 1225\) ubicaciones, sujeto solo a la regla de que dos cuadrados no podían caer en la misma ubicación. La configuración del fondo se produjo exactamente de la misma manera excepto que había una regla adicional, a saber, que dos cuadrados tampoco podían caer en ubicaciones adyacentes. Así, la configuración superior se dibujó del charco de todos los patrones con 169 cuadrados, mientras que la configuración inferior se dibujó del charco mucho más pequeño de patrones con 169 cuadrados y sin dos cuadrados adyacentes. La configuración superior es típica de la clase con más configuraciones y por lo tanto mayor entropía.

Vuelva a mirar la configuración inferior. Notarás que no hay plazas inmediatamente adyacentes a ninguna plaza dada. Esta regla de “exclusión de vecino más cercano” actúa para extender los cuadrados, dando lugar a la apariencia suave que engaña a tantos para que adivinen que la configuración inferior es típica de una clase con alta entropía.

Ahora mira de nuevo a la configuración superior. Notarás agujeros y grumos de cuadrados, las inhomogeneidades que llevan a muchos a adivinar que es típico de una clase pequeña. Pero, de hecho, uno debería esperar que una configuración aleatoria tenga agujeros; solo una configuración muy excepcional es perfectamente lisa. 11 Esto implica la distinción entre una configuración típica y una configuración promedio. Las configuraciones típicas tienen agujeros: algunos tienen agujeros en la parte superior derecha, algunos en el centro izquierdo, algunos en el centro. Debido a que los agujeros caen en varias ubicaciones, la configuración promedio, la que se produce al agregar todas las configuraciones y dividir por el número de configuraciones, es suave. La configuración promedio es en realidad atípica. (Analogía: Una persona típica no es de estatura media. Una persona típica es algo más alta o algo más baja que la media, y muy pocas personas son exactamente de estatura promedio. Cualquier fabricante de ropa que produjera solo camisas de talla media iría rápidamente a la quiebra.) La presencia de agujeros o grumos, por lo tanto, no necesita ser una indicación de un patrón o de un diseño. Sin embargo, los humanos tendemos a encontrar patrones dondequiera que miremos, incluso cuando no hay diseño presente. 12 De esta manera los antiguos griegos miraban hacia el cielo nocturno, con estrellas salpicadas al azar, y vieron a los animales, dioses y héroes que se convirtieron en nuestras constelaciones.

Entropía y poker

Una excelente ilustración de la naturaleza de la entropía es dada por el juego de cartas poker. Hay muchas manos posibles en el póquer, algunas valiosas y lo más menos. Por ejemplo, la mano

\[A♥, K♥, Q♥, J♥, 10♥\]

es un ejemplo de una rubor real, la mano más poderosa del póker. Solo hay cuatro rubores reales (la rubor real de corazones, de diamantes, de espadas y de palos) y cualquier jugador de póquer que alguna vez haya recibido una descarga real lo recordará por el resto de su vida.

Por el contrario, nadie puede recordar si le han repartido la mano

\[4♦, 3♦, J♥, 2♠, 7♦\]

porque esta mano es miembro de una enorme clase de manos de póquer no especialmente valiosas. Pero la probabilidad de que se le reparte esta mano es exactamente la misma que la probabilidad de que se le reparte el rubor real de corazones. El motivo de que una mano sea memorable y la otra no lo es no tiene nada que ver con la rareza de esa mano en particular, tiene todo que ver con el tamaño de la clase de la que la mano es miembro.

Esta ilustración de la importancia de la clase más que de la configuración individual es tan poderosa y tan gráfica que llamaré a esa distinción “la paradoja del poker”.

Conclusión

A menudo se dice que la entropía es una medida del trastorno de un sistema. Este concepto cualitativo tiene al menos tres fallas: Primero, es vago. No existe una definición precisa de trastorno. Algunos encuentran desordenados los cuadros abstractos de Jackson Pollock; otros los encuentran preñados de estructura. Segundo, usa una palabra cargada de emoción. La mayoría de nosotros tenemos sentimientos sobre el desorden (ya sea a favor o en contra de él), y la analogía nos anima a transferir ese gusto o aversión del desorden, donde nuestros sentimientos son apropiados, a la entropía, donde no lo son. El fallo más importante, sin embargo, es que la analogía entre entropía y desorden nos invita a pensar en una sola configuración más que en una clase de configuraciones. En el modelo de gas de celosía hay muchas configuraciones “ordenadas” (como el patrón de tablero de ajedrez de la figura 2.6) que son miembros de ambas clases. Hay muchas otras configuraciones “ordenadas” (como el patrón de bloque sólido de la figura\(\PageIndex{6}\)) que son miembros solo de las más grandes (¡entropía más alta!) clase. 13 La mano de poker

\[2♣, 4♦, 6♥, 8♠, 10♣\]

es muy ordenado, pero miembro de una clase muy grande de manos de póquer casi inútiles.

Figura\(\PageIndex{5}\): Una configuración ordenada de gas de celosía que es un miembro tanto de la clase grande como de la clase pequeña de configuraciones.

Figura\(\PageIndex{6}\): Una configuración ordenada de gas de celosía que es miembro solo de la gran (¡alta entropía!) clase de configuraciones.

Dada la clara necesidad de una intuición sobre la entropía, y el carácter atractivo pero insatisfactorio del símil “entropía como desorden”, ¿qué hay que hacer? Sugiero un símil adicional, a saber, “la entropía como libertad”, que debería usarse no por sí misma sino en conjunción con “la entropía como desorden”.

“Libertad” significa una gama de acciones posibles, mientras que “entropía” significa una gama de posibles microestados. Si sólo un microestado corresponde a un cierto macroestado, entonces el sistema no tiene libertad para elegir su microestado —y tiene entropía cero. Si eres libre de administrar tu propia habitación, entonces puedes mantenerla ordenada o desordenada, así como los macroestados de alta entropía abarcan microestados ordenados y desordenados. La entropía da el número de formas en que los constituyentes de un sistema pueden ser arreglados y seguir siendo miembros del club (o clase). Si la entropía de clase es alta, entonces hay varias formas diferentes de satisfacer los criterios de membresía de clase. Si la entropía de clase es baja, entonces esa clase es muy exigente —muy restrictiva— sobre qué microestados admitirá como miembros. En definitiva, la ventaja de la analogía de “entropía como libertad” es que centra la atención en la variedad de microestados correspondientes a un macroestado mientras que la analogía de “entropía como trastorno” invita a enfocarse en un solo microestado.

Si bien la “entropía como libertad” tiene estos beneficios, también tiene dos de los inconvenientes de la “entropía como trastorno”. Primero, el término “libertad” está cargado de aún más bagaje emocional que el término “desorden”. Segundo, es aún más vago: los movimientos políticos desde la extrema derecha pasando por el centro hasta la extrema izquierda se caracterizan todos como “luchadores por la libertad”. ¿Hay alguna manera de cosechar los beneficios de esta analogía sin hundirse en el fango de los inconvenientes?

Para obtener la máxima ventaja, sugiero usar ambas analogías. Las emociones y vaguedades apegadas a la “libertad” son muy distintas de las apegadas al “desorden”, por lo que utilizarlas juntas tiende a anular la emoción. Una frase simple como “Para los macroestados de alta entropía, el sistema tiene la libertad de elegir uno de un gran número de microestados, y la mayor parte de tales microestados están microscópicamente desordenados” dirige la atención lejos del bagaje emocional glib y hacia la perspectiva de “más entropía significa más microestados. ”

Pero tal vez sea incluso mejor evitar las analogías todas juntas. Basta pensar en la entropía como describir el número de microestados consistentes con el macroestado prescrito. Y entonces recordarás siempre que la entropía se aplica a un macroestado, es decir, a una clase de microestados, más que a un microestado individual.

Problemas

2.17 Entropía del gas ideal monatómico clásico: límites

a. Cada macroestado tiene al menos un microestado correspondiente. Usa esto para demostrarlo en todos los casos\(S \geq 0\).

b. Utilizar la fórmula Sackur-Tetrode (2.31) para encontrar la entropía del gas ideal monatómico clásico en el límite de alta densidad (es decir, el volumen por partícula se aproxima a cero). [Este resultado absurdo indica una ruptura en la aproximación de partículas “ideales” que no interactúan. A altas densidades, a medida que las partículas se amontonan, ya no es posible ignorar las interacciones repulsivas que son responsables del “tamaño” de cada átomo.]

c. ¿Cuál es la entropía del gas ideal monatómico clásico cuando la energía es igual a la energía del estado fundamental (i.e.\(E \to 0\))? [Este resultado absurdo indica un desglose en la aproximación “clásica”. Como veremos en el capítulo 6, la mecánica cuántica se convierte en un efecto significativo a bajas energías. Históricamente, este absurdo fue uno de los primeros indicios de que la mecánica clásica no podía ser universalmente cierta.]

2.18 (Q, E) El lanzamiento de la moneda

Si lanzas una moneda diez veces, esperas en promedio obtener cinco cabezas y cinco colas.

a. El patrón HHHHHHHHHH viola dramáticamente esta expectativa. ¿Cuál es la probabilidad de obtener este patrón?

b. El patrón HTHTHTHTHT coincide exactamente con esta expectativa. ¿Cuál es la probabilidad de obtener este patrón?

c. ¿Cuál es la probabilidad de obtener el patrón HTTTHHTTHT?

d. ¿Cuál es la probabilidad de obtener un patrón con una cola y nueve cabezas?

2.19 (Q) Caminatas aleatorias

Se te presentan dos imágenes que supuestamente bosquejan el progreso de un andador aleatorio a medida que se mueve por el espacio. Uno fue dibujado por una computadora usando un generador de números aleatorios, el otro por un ser humano. Una imagen es más o menos uniforme, la otra tiene algunos espacios oscuros con líneas y otros espacios apenas tocados. ¿Qué imagen se dibujó de qué manera?

2.20 Póker

En el juego de póquer, una mano consta de cinco cartas extraídas de una baraja de 52 cartas. Las cartas se dividen equitativamente en cuatro palos (corazones, diamantes, palos, espadas).

a. ¿Cuántas manos hay en el póquer? Explica tu razonamiento.

b. ¿Cuántas manos hay rubores? (Es decir, las cinco cartas del mismo palo.)

c. Harry juega al póquer todas las noches, y cada noche se le reparten 100 manos. ¿Cuánto tiempo debe jugar Harry, en promedio, antes de que le repartan la mano?

\[4♦, 3♦, J♥, 2♠, 7♦\]

6 Cutler J. Cleveland y Robert Kaufmann “Principios fundamentales de la energía”, en Enciclopedia de la Tierra, última actualización el 29 de agosto de 2008, http://www.eoearth.org/article/Fundamental-principles-of-energy.

7 Louis M. Savary, Teilhard de Chardin: Explicación del medio divino (Paulist Press, Mahwah, NJ, 2007) página 163.

8 Gilbert L. Wedekind, Entropía Espiritual (Xulon Press, Fairfax, VA, 2003) página 68.

9 Ihsan Barin, Datos termoquímicos de sustancias puras (VCH Publishers, Weinheim, Alemania, 1995) páginas 675, 1239 y 702.

10 El argumento de esta sección fue inventado por Edward M. Purcell y se resume en Stephen Jay Gould, Bully for Brontosaurus (W.W. Norton, Nueva York, 1991), páginas 265—268, 260—261. Los programas de computadora mencionados, que funcionan bajo MS-DOS, están disponibles para su descarga gratuita a través de http://www.oberlin.edu/physics/dstyer/.

11 En su libro The Second Law (Scientific American Books, New York, 1984), P.W. Atkins promueve la idea de que la entropía es una medida de homogeneidad. (Esto a pesar de la observación cotidiana de la coexistencia en dos fases.) Para apoyar este argumento, el libro presenta seis ilustraciones (en las páginas 54, 72, 74, 75 y 77) de “configuraciones de gas de celosía de equilibrio”. Cada configuración tiene 100 sitios ocupados en una\(40 \times 40\) cuadrícula. Si los sitios ocupados hubieran sido seleccionados al azar, entonces la probabilidad de que algún sitio estuviera ocupado sería\(100/1600\), y la probabilidad de que cualquier par dado de sitios ambos estuvieran ocupados sería\(1/(16)^2\). La matriz contiene pares de sitios\(2 \times 39 \times 39\) adyacentes, por lo que el número esperado de pares adyacentes ocupados sería\(2(39/16)^ = 11.88\). Los números reales de pares de vecinos más cercanos ocupados en las seis ilustraciones son\(0, 7, 3, 7, 4\), y\(3\). Un cálculo similar muestra que el número esperado de filas o columnas vacías en una matriz ocupada aleatoriamente es\((15/16)10 \times 2 \times 40 = 41.96\). Los números reales para las seis ilustraciones son\(28, 5, 5, 4, 4\), y\(0\). Confío en que los sitios en estas ilustraciones no fueron ocupados al azar, sino más bien para dar la impresión de uniformidad.

12 Mirad de nuevo a la figura\(\PageIndex{3}\). ¿Ves al perro atrapando una pelota en la mitad izquierda? ¿Ves la nave Enterprise en la parte inferior derecha?

13 Alguien podría plantear la objeción: “Sí, pero ¿cuántas configuraciones tendría que sacar de la piscina, en promedio, antes de obtener exactamente la configuración especial de figura\(\PageIndex{6}\)?” La respuesta es: “Precisamente el mismo número que necesitarías dibujar, en promedio, antes de obtener exactamente la configuración especial de figura”\(\PageIndex{3}\). Estas dos configuraciones son igualmente especiales e igualmente raras.