1.5: Progreso científico

- Page ID

- 99149

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

Intro

En capítulos anteriores hemos establecido que las teorías dentro de los mosaicos cambian a través del tiempo. También hemos argumentado que estos cambios ocurren de manera regular, similar a la ley. Reconocer que las teorías de un mosaico cambian a través del tiempo, y comprender cómo cambian, es importante. Pero, ¿qué nos hace pensar que nuestras teorías empíricas logran describir el mundo? Sí, podemos afirmar que cambian de manera regida por la ley, es decir, que las teorías sólo llegan a ser aceptadas cuando cumplen con las expectativas de la comunidad respectiva. Pero, ¿significa eso que nuestras teorías aceptadas físicas, químicas, biológicas, psicológicas, sociológicas o económicas logran decirnos algo sobre los procesos, entidades y relaciones que intentan describir? En otras palabras, sabemos que el proceso de cambio científico exhibe ciertos patrones generales de cambio, pero ¿significa eso necesariamente que este proceso de cambios gobernado por la ley en teorías y métodos realmente nos acerca a la verdadera descripción del mundo tal como realmente es?

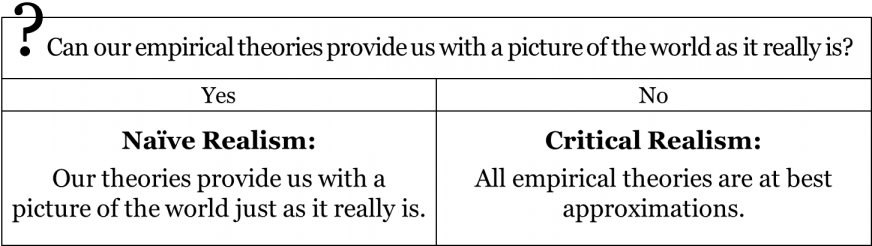

La posición del falibilismo que hemos establecido en el capítulo 2 sugiere que todas las teorías empíricas son —en el mejor de los casos — aproximaciones. Sin embargo, no necesariamente se desprende de esto que nuestras teorías empíricas realmente logran aproximarse al mundo que intentan describir. Para iniciar este capítulo, abordaremos la siguiente pregunta:

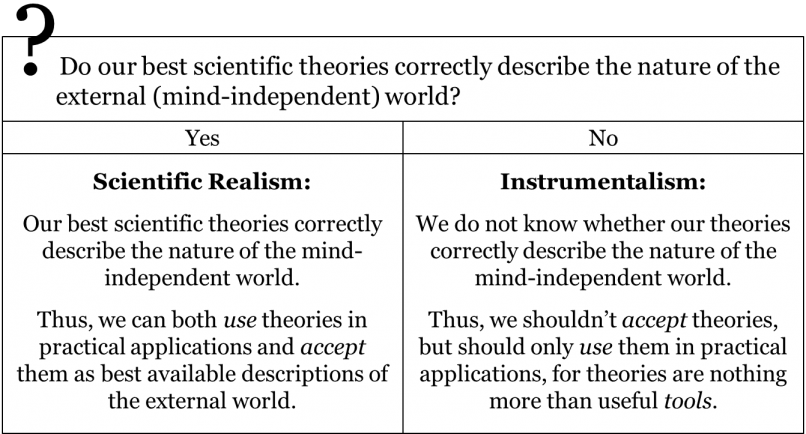

¿Nuestras mejores teorías describen correctamente el mundo externo independiente de la mente?

Antes de ir más lejos, es importante tener presente que estamos comprometidos con el punto de vista filosófico del falibilismo. Como tal, cada vez que hablamos de la corrección, el éxito o la verdad de una teoría empírica, esas teorías siempre están sujetas a los problemas de sensaciones, inducción, y teoría-ladenness, y por lo tanto no son absolutamente ciertas, no absolutamente ciertas. Entonces, la pregunta no es si nuestras teorías empíricas proporcionan descripciones absolutamente correctas del mundo; hoy en día se acepta que no lo hacen. La cuestión es si podemos afirmar que nuestras mejores teorías obtienen al menos algo correcto, es decir, si tienen éxito como descripciones aproximadas del mundo como realmente es.

Realismo Científico vs Instrumentalismo

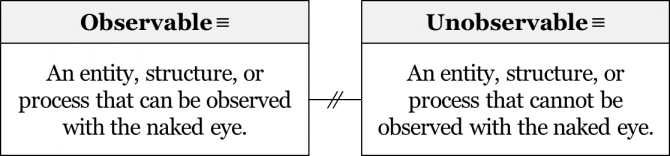

Muchas teorías de la ciencia empírica intentan explicar hechos fácilmente observables, eventos, procesos, relaciones, etc. Tomemos como ejemplo la caída libre de una taza de café. Podemos observar fácilmente una caída de taza de café de una mesa al suelo, es decir, la caída en sí es un proceso observable. Por ejemplo, podemos medir el tiempo que tardó la taza de café en golpear el suelo y formular una proposición que describa los resultados de nuestra observación: “la taza tarda 0.5 segundos en golpear el suelo”. Pero, ¿qué hay de explicar por qué la taza de café cae de la mesa al suelo? Para describir el mecanismo subyacente que produce la caída, hoy en día citamos la teoría de la relatividad general. La explicación que brinda la relatividad general va en esta línea: la taza de café cae al suelo porque la masa de la Tierra dobla el espacio-tiempo a su alrededor de tal manera que el movimiento inercial de la taza se dirige hacia el suelo. Si bien una copa que cae por el aire es fácilmente observable, el espacio-tiempo doblado que invoca la relatividad general no lo es. Del mismo modo, muchas teorías científicas postulan la existencia de entidades, estructuras o procesos que son demasiado pequeños (como quarks, átomos o microbios), demasiado grandes (como cúmulos de galaxias), demasiado rápidos (como el movimiento de los fotones), o demasiado lentos (como el proceso de evolución biológica por selección natural) para ser detectado directamente con los sentidos humanos. Además, algunas de las entidades, estructuras o procesos invocados por nuestras teorías científicas son tales que no se pueden observar directamente ni siquiera en principio (como el espacio-tiempo mismo). Cualquier proceso, estructura o entidad que pueda percibirse sin ninguna ayuda tecnológica (“a simple vista”) se denomina típicamente observable. Por el contrario, cualquier proceso, estructura o entidad que no se pueda observar a simple vista se denomina inobservable.

Dado que muchas —si no la mayoría— las teorías científicas empíricas invocan inobservables para ayudar a explicar sus objetos, esto hace que nuestra pregunta inicial sea un poco más interesante. Cuando preguntamos si nuestras teorías describen correctamente el mundo externo, en realidad estamos haciendo la pregunta más específica:

¿Nuestras teorías científicas describen correctamente tanto observables como no observables?

En términos generales, los científicos y filósofos de la ciencia hoy aceptan que nuestras teorías logran describir correctamente los observables, incluso como falibilistas. Cuando hayamos dejado caer esa taza de café por hora 400 y aún así cronometrar su tiempo de emisión a 0.5 segundos, consideraremos la afirmación de “toma 0.5 segundos para que la taza golpee el suelo” confirmada y correcta. Pero, ¿cómo debemos entender las afirmaciones relativas a los no observables, como invocar la noción de espacio-tiempo doblado para explicar la caída de la taza de café? ¿Podemos legítimamente hacer alguna afirmación sobre procesos, entidades o relaciones no observables? Así, la cuestión de interés aquí es la relativa a los no observables:

¿Nuestras teorías científicas describen correctamente los no observables?

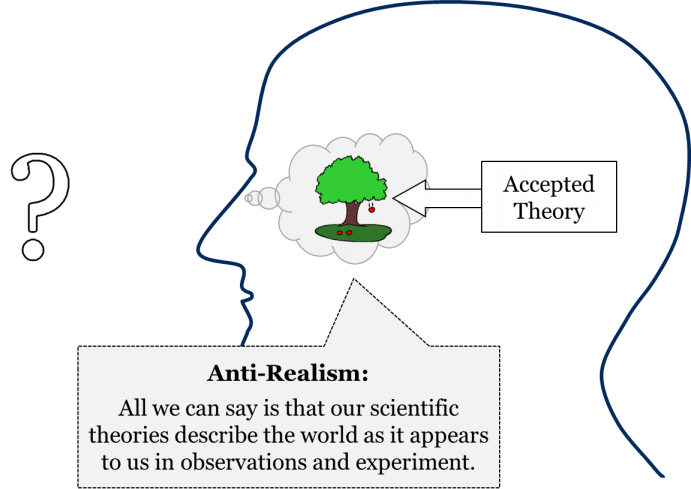

Hay muchos filósofos que son relativamente pesimistas cuando se trata de nuestra capacidad de hacer afirmaciones legítimas sobre las entidades, estructuras o procesos inobservables que postulan nuestras teorías científicas. Quienes ostenten esta posición responderían “no” a la pregunta de si las teorías científicas describen correctamente los inobservables. Esta es la posición del antirealismo. Si bien los antirrealistas no niegan que nuestras teorías suelen describir correctamente los observables, sí niegan que podamos hacer afirmaciones legítimas sobre la realidad de entidades, procesos o relaciones no observables invocadas por nuestras teorías científicas. Por ejemplo, según un antirealista, no estamos en condiciones de decir que existe tal cosa como el espacio-tiempo doblado:

La posición del antirrealismo también suele llamarse instrumentalismo porque trata las teorías científicas en general —y las partes de esas teorías que hacen afirmaciones sobre los no observables específicamente— simplemente como herramientas o instrumentos para calcular, predecir o intervenir en el mundo de observables. Así, según los instrumentistas, la noción de espacio-tiempo doblado es meramente una herramienta matemática útil que nos permite calcular y predecir cómo cambian las ubicaciones de los objetos observables a través del tiempo; no podemos hacer afirmaciones legítimas sobre la realidad de ese espacio-tiempo doblado. En otras palabras, si bien el instrumentalismo sostiene que las teorías que invocan a los no observables a menudo arrojan resultados prácticos, esas mismas teorías podrían no estar logrando describir rasgos genuinos del mundo.

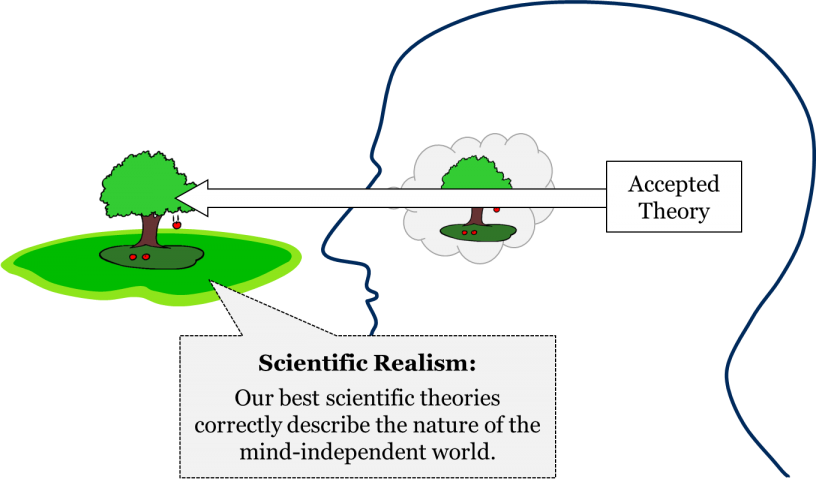

Pero también hay quienes son optimistas cuando se trata de nuestra capacidad de conocer o describir inobservables postulados por nuestras teorías científicas. Esta posición se llama realismo científico. Quienes ostenten esta posición responderían “sí” a la pregunta de si las teorías científicas describen correctamente los inobservables. Para ellos, los no observables como los quarks, los bosones, la selección natural y el espacio-tiempo no son simplemente instrumentos útiles para hacer predicciones de fenómenos observables, sino que denotan entidades, procesos y relaciones que probablemente existan en el mundo.

Es importante señalar que la cuestión que separa a los realistas científicos de los instrumentistas no se refiere a la existencia del mundo externo independiente de la mente. La cuestión de si nuestro mundo de fenómenos observables es todo lo que hay o si hay un mundo externo más allá de lo inmediatamente observable es una cuestión importante. Se encuentra dentro del dominio de la metafísica, rama de la filosofía preocupada por los rasgos más generales del mundo. Sin embargo, esa cuestión metafísica no nos preocupa aquí. Nuestra pregunta no es sobre la existencia del mundo externo independiente de la mente, sino sobre la capacidad o incapacidad de nuestras mejores teorías científicas para decirnos algo sobre las características de ese mundo externo independiente de la mente. Así, un instrumentista no niega necesariamente la existencia de una realidad más allá del mundo de fenómenos observables. Su afirmación es diferente: que incluso nuestras mejores teorías científicas no logran revelar nada sobre el mundo tal como realmente es.

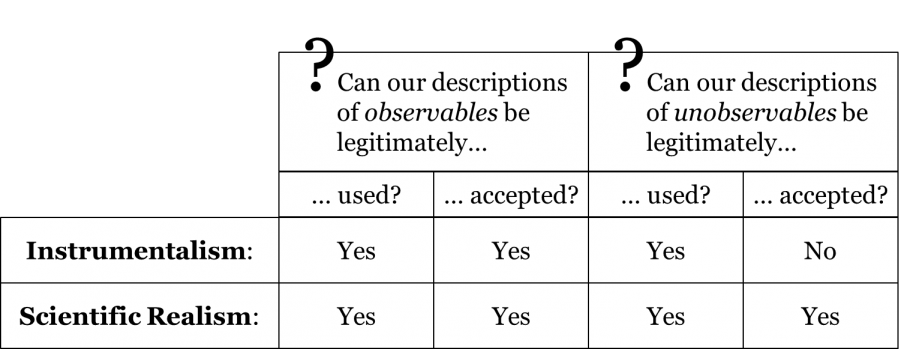

Para ayudar a diferenciar más claramente el realismo científico del instrumentalismo, usemos la distinción entre aceptación y uso que presentamos en el capítulo 3. Recordemos que una cosa es aceptar una teoría como la mejor descripción disponible de su respectivo dominio, y otra cosa es usarla en aplicaciones prácticas. Si bien una comunidad puede usar cualquier número de teorías competidoras en la práctica (como diferentes herramientas en una caja de herramientas), normalmente acepta solo una de las teorías competidoras como la mejor descripción disponible de su objeto.

Ahora bien, los instrumentistas y científicos realistas no niegan que las comunidades, de hecho, a menudo aceptan teorías y las utilizan en la práctica; la existencia de estas posturas epistémicas en la práctica real de la ciencia está fuera de toda duda. Lo que separa a instrumentistas y científicos realistas es la cuestión de la legitimidad de esas posturas. La cuestión no es si los científicos han aceptado o utilizado históricamente sus teorías —está claro que sí— sino si es justificable hacerlo. Dado que estamos tratando con dos posturas diferentes (aceptación y uso) en relación con dos tipos diferentes de afirmaciones (sobre observables e inobservables), hay cuatro preguntas distintas en juego aquí:

¿Podemos usar legítimamente una teoría sobre los observables?

¿Podemos aceptar legítimamente una teoría como describiendo observables?

¿Podemos usar legítimamente una teoría sobre los no observables?

¿Podemos aceptar legítimamente una teoría como describiendo inobservables?

En lo que se refiere al uso práctico de las teorías, no hay desacuerdo entre instrumentistas y realistas: ambas partes coinciden en que cualquier tipo de teoría puede llegar a ser legítimamente útil. Esto va tanto para teorías sobre fenómenos observables como para teorías sobre no observables. Los instrumentistas y realistas también coinciden en que podemos aceptar legítimamente teorías sobre observables. Donde los dos partidos difieren, sin embargo, es en su actitud respecto a la legitimidad de aceptar teorías sobre los no observables. La cuestión que separa a ambos partidos es si podemos aceptar legítimamente alguna teoría sobre los no observables. Es decir, de las cuatro preguntas anteriores, los realistas y los instrumentistas sólo difieren en su respuesta a una de ellas. Esto se puede resumir en la siguiente tabla:

Para un instrumentista, las teorías relativas a los no observables a veces pueden ser legítimamente utilizadas en la práctica (por ejemplo, construcción de puentes, construcción de telescopios, formulación de políticas) pero nunca legítimamente aceptadas. Para un realista, las teorías relativas a los no observables a veces pueden ser legítimamente utilizadas, a veces legítimamente aceptadas, y a veces tanto legítimamente utilizadas como aceptadas. La siguiente tabla resume la diferencia entre las dos concepciones:

Ahora que hemos establecido la diferencia filosófica básica entre instrumentalismo y realismo, consideremos algunos ejemplos históricos para ayudar a ilustrar estas distinciones contemporáneas.

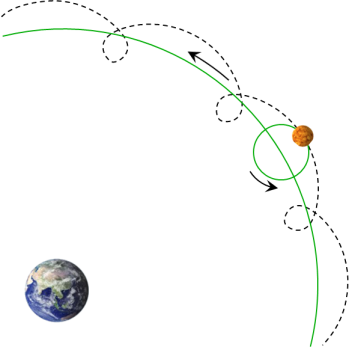

Durante siglos, los astrónomos aceptaron el modelo de Tolomeo de un universo geocéntrico, incluida la teoría ptolemaica del movimiento planetario. Primero, recordemos que para Ptolomeo los caminos observables de los planetas, incluyendo su movimiento retrógrado, fueron producidos por una combinación de epiciclos y deferentes. Aquí está el diagrama que consideramos en el capítulo 3:

Además de ser aceptada, esta teoría epiciclo-sobre-deferente y sus correspondientes matemáticas se utilizaron durante siglos para predecir la posición de los planetas con notable precisión. Las tablas de posiciones planetarias compuestas por medio de esa teoría (las llamadas efemérides) serían utilizadas entonces en astrología, medicina, navegación, agricultura, etc. (Ver capítulo 7 para mayor detalle.)

Ahora vamos a descomponer un poco este ejemplo. Por un lado, los planetas y su movimiento retrógrado son observables: no necesitamos telescopios para observar la mayoría de los planetas como puntos de luz, y con el tiempo podemos rastrear fácilmente sus caminos a través del cielo nocturno a simple vista. Por otro lado, desde la perspectiva de un observador en la Tierra, los deferentes y los epiciclos son inobservables, ya que no se pueden observar a simple vista. En cambio, son el supuesto mecanismo del movimiento planetario, la verdadera forma de los orbes que subyacen al deambular de los planetas a través del cielo nocturno.

Entonces, ¿cómo entenderíamos la teoría epiciclo-sobre-deferente de Ptolomeo del movimiento planetario desde las perspectivas del instrumentalismo y el realismo? Tanto para instrumentistas como para realistas, sería aceptable el relato ptolemaico de los serpenteantes caminos de los planetas a través del cielo nocturno ya que estos caminos son observables. Es decir, ambas concepciones coinciden en que, en su momento, las predicciones y proyecciones ptolemaicas para las ubicaciones de los planetas en el cielo nocturno podrían considerarse legítimamente como la mejor descripción de esos fenómenos. Pero el instrumentalismo y el realismo no están de acuerdo sobre si era legítimo que los astrónomos medievales aceptaran también aquellas partes de la teoría de Ptolomeo que se referían a deferentes y epiciclos no observables. Según el realismo, en su momento, la teoría de Tolomeo sobre los epiciclos y los deferentes podría aceptarse legítimamente como la mejor descripción disponible del mecanismo real del movimiento planetario. En contraste, el instrumentista insistiría en que los astrónomos tenían que abstenerse de comprometerse con la realidad de los epicíclos y los deferentes, y en cambio tenían que enfocarse en si las nociones de epicycle y deferente eran útiles para calcular las posiciones planetarias.

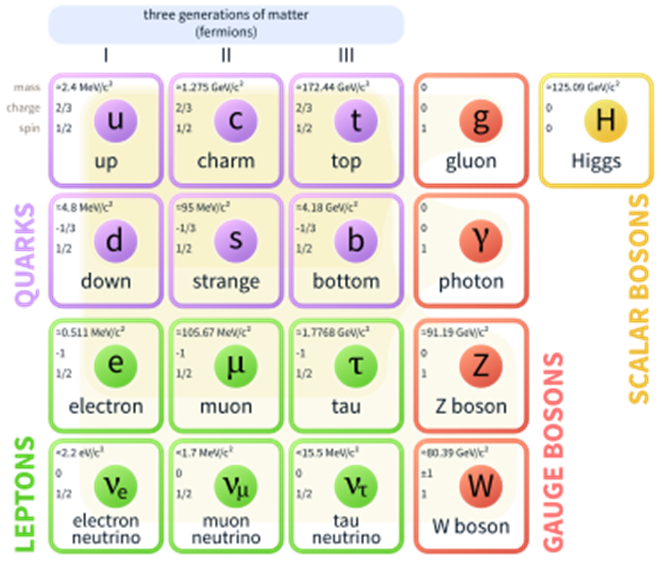

Consideremos un ejemplo histórico un poco más reciente: el modelo estándar de la física cuántica. Según el modelo estándar, hay seis quarks, seis leptones, cuatro bosones de calibre y un bosón escalar, el bosón de Higgs recientemente descubierto. Aquí hay una representación estándar del modelo estándar:

Para nuestros propósitos, podemos omitir los roles específicos que cada tipo de partícula elemental juega en este modelo. Para los efectos de nuestra discusión es importante señalar que todas estas partículas elementales son inobservables; debido a su tamaño minucioso, no se pueden observar a simple vista. En todo caso, es un hecho histórico que este modelo estándar es aceptado actualmente por los físicos como la mejor descripción disponible de su dominio.

La cuestión filosófica que separa a instrumentistas y científicos realistas es si es legítimo creer que estas partículas son más que una simple herramienta de cálculo útil. Tanto los científicos realistas como los instrumentistas sostienen que podemos utilizar legítimamente el modelo estándar para predecir lo que se observará en un determinado entorno experimental dadas tales y tales condiciones iniciales. No obstante, según los instrumentistas, los científicos no deben aceptar la realidad de estas partículas, sino que deben considerarlas únicamente como instrumentos útiles que les permitan calcular y predecir los resultados de observaciones y experimentos. En contraste, los realistas científicos afirmarían que podemos aceptar legítimamente el modelo estándar como la mejor descripción disponible del mundo de las partículas elementales, es decir, que el modelo estándar no es una mera herramienta de predicción.

Especies de Realismo Científico

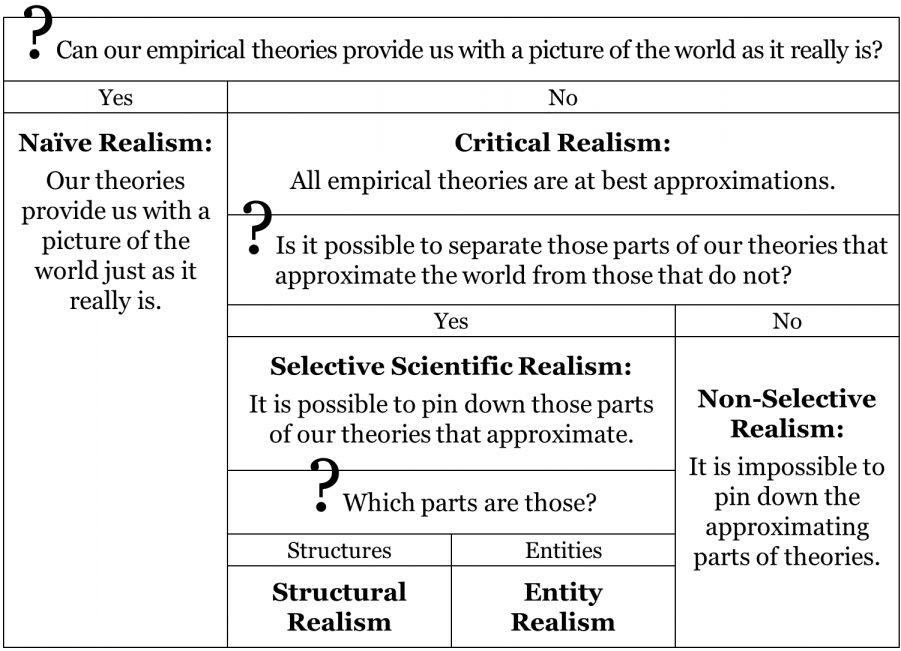

Aquí está en orden una nota histórica. En los viejos tiempos del infalibilismo, la mayoría de los filósofos creían que, de una forma u otra, logramos obtener un conocimiento absoluto sobre el mundo externo independiente de la mente. Naturalmente, la lista de teorías que se consideraron estrictamente verdaderas cambió a través del tiempo. Por ejemplo, en la segunda mitad del siglo XVIII, los filósofos citarían la física newtoniana como un ejemplo de conocimiento infalible, mientras que las teorías del mosaico aristotelio-medieval serían consideradas estrictamente ciertas en el siglo XV. Pero independientemente de qué teorías científicas se consideraran absolutamente ciertas, en general se aceptó que tal conocimiento absoluto sí existe. En otras palabras, la mayoría de los filósofos aceptaron que nuestras mejores teorías científicas nos proporcionan una imagen del mundo tal como realmente es. Esta especie de realismo científico se conoce como realismo ingenuo.

No obstante, como hemos visto en el capítulo 2, los filósofos poco a poco han llegado a apreciar que todas las teorías empíricas son, en principio, falibles. Una vez completada la transición del infalibilismo al falibilismo, la posición del realismo ingenuo ya no podía considerarse viable, es decir, ya no era posible argumentar que nuestras mejores teorías nos proporcionan la imagen exacta del mundo tal como realmente es. En cambio, la pregunta se convirtió en:

¿Nuestras teorías científicas se aproximan al mundo externo independiente de la mente (es decir, el mundo de los no observables)?

Así, la pregunta que hacen los falibilistas no es si nuestras teorías logran proporcionar una imagen exacta del mundo externo —lo cual, como sabemos, es imposible—, sino si nuestras teorías al menos logran aproximarse al mundo externo. Es esta pregunta la que hoy en día separa a los realistas científicos de los instrumentistas. Así, la versión del realismo científico que está al alcance de los falibilistas no es el realismo ingenuo, sino el realismo crítico, que sostiene que las teorías empíricas pueden tener éxito en aproximarse al mundo. Si bien los realistas críticos creen que al menos algunas de nuestras mejores teorías logran proporcionarnos algún conocimiento, aunque falible, del mundo de los no observables, hoy en día hay poco acuerdo entre los realistas críticos en cuanto a cómo debe entenderse esta aproximación.

Una vez aceptada la falibilidad de nuestras teorías empíricas, muchos realistas críticos adoptaron el llamado enfoque selectivo. Los realistas científicos selectivos intentan identificar aquellos aspectos de nuestras teorías falibles que pueden ser legítimamente aceptados como aproximadamente verdaderos. En este enfoque selectivo, si bien cualquier teoría empírica tomada en su conjunto es estrictamente falsa, sin embargo puede tener algunas partes que los científicos pueden aceptar legítimamente como aproximadamente verdaderas. Así, la tarea de un realista científico selectivo es identificar aquellos aspectos de nuestras teorías que justifican tal postura epistémica. Si bien el realismo científico selectivo tiene muchas subespecies, aquí nos centraremos en dos de las variedades más comunes: el realismo de entidades y el realismo estructural. Estas dos variedades de realismo selectivo difieren en sus respuestas a la pregunta qué aspectos de nuestras teorías los científicos pueden considerar legítimamente aproximándose a la realidad.

Según el realismo de la entidad, los científicos pueden justificarse al aceptar la realidad de entidades no observables como las partículas subatómicas o los genes, siempre que sean capaces de manipular a estas entidades no observables de tal manera que produzcan con precisión fenómenos observables. Por ejemplo, dado que los científicos pueden predecir con precisión qué se observará exactamente cuando se manipulen las características putativas de un electrón, entonces tienen buenas razones para aceptar la realidad de ese electrón. Los realistas de entidades sostienen que es la capacidad de los científicos para manipular causalmente entidades no observables y producir resultados observables muy precisos lo que justifica su creencia de que estas entidades no observables son reales. La razón clave por la que algunos filósofos encuentran atractiva la posición del realismo de la entidad es que permite continuar aceptando legítimamente la realidad de una entidad a pesar de cualquier cambio en nuestro conocimiento sobre el comportamiento de esa entidad. Por ejemplo, según los realistas de la entidad, podemos seguir aceptando la realidad de un electrón independientemente de cualquier conocimiento adicional sobre características específicas del electrón y su comportamiento que podamos adquirir en el futuro. Es importante destacar que el realismo de la entidad adopta un enfoque selectivo en cuanto a qué partes de nuestras teorías pueden ser legítimamente aceptadas y qué partes solo pueden considerarse útiles.

Una versión diferente del enfoque selectivo es ofrecida por el realismo estructural. Si bien los realistas estructurales coinciden con los realistas de entidades en que los científicos pueden aceptar legítimamente solo ciertas partes de las mejores teorías científicas, difieren drásticamente en su opinión sobre qué partes los científicos están justificados en aceptar. Según los realistas estructurales, los científicos pueden aceptar justificadamente no las descripciones de entidades inobservables proporcionadas por nuestras mejores teorías, sino solo las afirmaciones que estas teorías hacen sobre estructuras no observables, es decir, sobre ciertas relaciones que existen en el mundo. Una motivación clave para esta visión es una observación histórica de que a menudo nuestro conocimiento de ciertas relaciones estructurales se está preservando a pesar de los cambios fundamentales en nuestras opiniones sobre los tipos de entidades que pueblan el mundo. Consideremos, por ejemplo, la ley de la refracción desde la óptica:

La relación de los senos de los ángulos de incidencia θ 1 y ángulo de refracción θ 2 es equivalente a la relación de velocidades de fase (v 1/v 2) en los dos medios:

Dejando de lado la cuestión de a quién se le debe acreditar legítimamente el descubrimiento de esta ley —René Descartes, o el astrónomo holandés Willebrord Snellius, o incluso el científico persa Ibn Sahl— podemos decir con seguridad que todas las teorías de la luz aceptadas desde el siglo XVII contenían una versión de esta ley. Esto va para la óptica mecanicista de Descartes, la óptica de Newton, la teoría de ondas de Fresnel de la luz, la electrodinámica de Maxwell, así como la óptica cuántica contemporánea. Estas diferentes teorías ópticas tenían puntos de vista drásticamente opuestos sobre la naturaleza de la luz: algunas de estas teorías entendían la luz como una cadena de corpúsculos (partículas), mientras que otras trataban a la luz como una entidad ondulada, mientras que otras consideraban a la luz como corpuscular y ondulante. Pero a pesar de estos cambios drásticos en nuestra comprensión de la naturaleza de la luz, la ley de la refracción ha mantenido su estado en nuestro mosaico. Así, según los realistas estructurales, los científicos están justificados al aceptar aquellas afirmaciones de nuestras teorías que revelan ciertas estructuras subyacentes (relaciones), mientras que las afirmaciones sobre entidades no observables deben tomarse escépticamente. En esta visión, los científicos aún pueden encontrar útiles las afirmaciones relativas a entidades no observables, pero no están justificadas para aceptar esas afirmaciones. Todo lo que pueden hacer legítimamente es creer que sus teorías proporcionan aproximaciones aceptables de las estructuras subyacentes que producen fenómenos observables. Este es otro ejemplo de realismo científico selectivo.

Sin embargo, tras un escrutinio más detenido, tanto el realismo de la entidad como el realismo estructural no logran coincidir con la historia de la ciencia. Empecemos por el realismo de la entidad, según el cual, estamos justificados en aceptar la existencia de aquellas entidades inobservables que logramos manipular. Esta opinión supone que existen afirmaciones sobre ciertas entidades no observables que mantienen sus posiciones en el mosaico a pesar de todos los cambios en las pretensiones relativas a su comportamiento y relaciones con otras entidades. Desafortunadamente, un rápido vistazo a la historia de la ciencia revela muchas entidades inobservables que alguna vez fueron aceptadas y que ya no son aceptadas. Consideremos, por ejemplo, la teoría del flogiston aceptada por los químicos hasta finales del siglo XVIII. Según esta teoría, lo que hace que algo sea combustible es la presencia de una determinada sustancia, llamada flogistona. Así, la leña se quema porque contiene flogiston. Al quemar, así dice la historia, la leña está siendo desflogisticada mientras el aire a su alrededor se vuelve flogisticado. Es decir, según esta teoría, el flogiston se mueve de la sustancia ardiente al aire. Lo importante para nuestra discusión es que la existencia del flogistón, entidad inobservable, fue aceptada por la comunidad de la época. No hace falta decir que ya no aceptamos la existencia del flogistón. De hecho, la descripción de la combustión que aceptamos hoy en día es drásticamente diferente. Actualmente, los químicos aceptan que, en la combustión, una sustancia compuesta principalmente por carbono, hidrógeno y oxígeno (la leña) se combina con el oxígeno en el aire, produciendo dióxido de carbono y vapor de agua. En definitiva, las entidades químicas que aceptamos hoy en día son muy distintas a las que solíamos aceptar en el siglo XVIII. Cuando estudiamos la historia de la ciencia, encontramos fácilmente muchos casos en los que ya no se acepta una entidad alguna vez aceptada. Consideremos, por ejemplo, los cuatro elementos aristotélicos, los fluidos eléctricos del siglo XVIII, o el éter lumífero del siglo XIX. ¿Cómo pueden entonces los realistas de entidades argumentar que los científicos están justificados al aceptar la existencia de entidades no observables si nuestro conocimiento de estas entidades es tan cambiante como nuestro conocimiento de las estructuras?

Por supuesto, una entidad realista puede responder diciendo que aquellas entidades que ya no aceptamos fueron aceptadas por error, es decir, que los científicos realmente no lograron manipularlas causalmente. Pero tal respuesta es históricamente insensible, pues supone que sólo nuestra ciencia contemporánea logra manipular adecuadamente a las entidades no observables, mientras que los científicos del pasado se equivocaron en sus creencias de que lograron manipular a sus entidades inobservables. En realidad, sin embargo, tales “errores” sólo se hacen evidentes cuando una teoría es rechazada y reemplazada por una nueva teoría que postula nuevas entidades no observables. Lo más probable es que algún día nuestras actuales entidades no observables también sean reemplazadas por algunas nuevas inobservables, como ha sucedido repetidamente a lo largo de la historia. ¿Estarían preparados los realistas de entidades para admitir que nuestros científicos contemporáneos no estaban realmente justificados al aceptar a nuestras actuales entidades no observables, como los quarks, los leptones o los bosones, una vez que estas entidades sean reemplazadas por otras entidades no observables? Claramente, eso derrotaría todo el propósito del realismo de la entidad, que era seleccionar aquellas partes de nuestras teorías que acercaran con éxito al mundo.

El realismo estructural se enfrenta a una objeción similar. Sí, es cierto que a veces nuestras afirmaciones relativas a las relaciones estructurales resisten grandes transiciones de un conjunto de entidades no observables a otro. Sin embargo, esto no es de ninguna manera una característica universal de la ciencia. Podemos pensar en muchos casos de la historia de la ciencia donde una propuesta largamente aceptada que describe una cierta relación finalmente se rechaza. Consideremos la ley aristotélica del movimiento violento que fue aceptada a lo largo de los períodos medieval y moderno temprano:

Si la fuerza (F) es mayor que la resistencia (R) entonces el objeto se moverá con una velocidad (V) proporcional a F/R. De lo contrario, el objeto no se moverá.

Entre otras cosas, la ley fue aceptada como la explicación correcta del movimiento de proyectiles, como la de una flecha disparada por un arquero. Se creía que la velocidad de la flecha móvil dependía de dos factores: la fuerza aplicada por el arquero y la resistencia del medio, es decir, el aire. Cuanto mayor es la fuerza aplicada, mayor es la velocidad; cuanto mayor es la resistencia del medio, menor es la velocidad. Se aceptó que la fuerza inicial se debía al motor, es decir, al arquero. Pero, ¿qué tipo de fuerza mantiene el objeto, es decir, la flecha, moviéndose después de haber perdido el contacto con el motor inicial? Generaciones de eruditos medievales y modernos tempranos han intentado responder a esta pregunta. Sin embargo, se aceptó que cualquier movimiento —incluido el movimiento continuo— requiere necesariamente una cierta fuerza, ya sea una fuerza externa o una fuerza interna derivada del propio objeto en movimiento.

Ahora compara esto con la segunda ley de la física newtoniana:

La aceleración (a) de un cuerpo es proporcional a la fuerza neta (F) que actúa sobre el cuerpo y es inversamente proporcional a la masa (m) del cuerpo:

¿Cómo analizaríamos el mismo caso arquero flecha por medio de esta ley? Primero, notamos que la masa de la flecha de repente se vuelve importante. También notamos que la fuerza ahora se entiende como la fuerza neta y es proporcional no a la velocidad sino a la aceleración, es decir, al cambio de velocidad por unidad de tiempo. Según la ley, cuanto mayor es la fuerza neta, mayor es la aceleración, y cuanto mayor es la masa, menor es la aceleración. En definitiva, la segunda ley expresa relaciones que son bastante distintas a las que expresa la ley aristotélica del movimiento violento. Entonces, ¿cómo puede un realista estructural afirmar que nuestro conocimiento de las relaciones normalmente se está preservando de una forma u otra?

Ha habido otros casos históricos en los que aceptamos la existencia de nuevas relaciones y rechazamos la existencia de relaciones previamente aceptadas. Consideremos, por ejemplo, la transición de la ley de la gravedad de Newton a las ecuaciones de campo de Einstein que tuvo lugar como resultado de la aceptación de la relatividad general ca. 1920. Aquí hay una formulación típica de la ley de la gravedad:

Y aquí hay una formulación típica de la ecuación de campo de Einstein:

Las dos ecuaciones no sólo son muy diferentes visualmente, sino que además capturan relaciones muy diferentes. La ley newtoniana de la gravedad postula una cierta relación entre las masas de dos objetos, la distancia entre ellos, y la fuerza de gravedad con la que se atraen entre sí. En contraste, la ecuación de campo de Einstein postula una relación entre la curvatura espacio-tiempo expresada por el tensor de Einstein (G μν) y una distribución específica de materia y energía expresada por el tensor de tensión-energía (T μν ). Si bien la ley de Newton nos dice cuál es la fuerza de la gravedad se le dará a los objetos con ciertas masas a cierta distancia, la ecuación de Einstein nos dice cómo se curvará una determinada región del espacio-tiempo dada una cierta disposición de masa y energía en esa región. Decir que las dos ecuaciones captan de alguna manera la misma relación sería un tramo inaceptable.

En definitiva, existen fuertes razones históricas contra tanto el realismo de la entidad como el realismo estructural. Ambas versiones del realismo científico selectivo no logran cuadrar con la historia de la ciencia, lo que demuestra claramente que tanto nuestro conocimiento de las entidades como nuestro conocimiento de las estructuras han cambiado repetidamente a través del tiempo. Esto no es sorprendente, ya que como falibilistas sabemos que ninguna proposición sintética es inmune al cambio. Claramente, no hay razón por la que algunas de estas proposiciones sintéticas —ya sea las que describen entidades o las que describen las relaciones— deban ser diferentes.

Además, existe una fuerte razón teórica contra el realismo científico selectivo. Es seguro decir que tanto el realismo de la entidad como el realismo estructural fracasan en sus intentos debido a una falla fatal implícita en cualquier enfoque selectivo. El objetivo de cualquier enfoque selectivo es proporcionar algunos criterios —es decir, algún método — que nos ayuden a separar aquellas partes de nuestras teorías que se aproximan al mundo de aquellas partes que en el mejor de los casos son meros instrumentos útiles. Hemos visto cómo tanto el realismo de las entidades como el realismo estructural intentaron proporcionar sus distintos métodos para distinguir partes aceptables de teorías de aquellas que son meramente útiles. El método realista de la entidad para seleccionar partes aceptables iría en esta línea: “la existencia de una entidad no observable es aceptable si esa entidad ha sido manipulada con éxito”. Por el contrario, el método realista estructural puede formularse como “la afirmación sobre inobservables es aceptable si se refiere a una relación (estructura)”. Es importante destacar que estos métodos estaban destinados a ser universales y transhistóricos, es decir, aplicables a todos los campos de la ciencia en todos los períodos históricos. Después de nuestras discusiones en los capítulos 3 y 4, debería quedar claro por qué cualquier intento de identificar métodos transhistóricos y universales está condenado. Sabemos que los métodos de la ciencia son cambiantes: lo que es aceptable para una comunidad en un período histórico no necesariamente tiene que ser aceptable para otra comunidad en otro período histórico. Incluso la misma comunidad puede, con el tiempo, cambiar su actitud hacia una determinada relación o entidad.

Tomemos, por ejemplo, la idea del enredo cuántico. Según la mecánica cuántica, a veces varias partículas interactúan de tal manera que el estado de una partícula individual depende del estado de las otras partículas. En tales casos, se dice que las partículas están enredadas: el estado actual de una partícula enredada no se puede caracterizar independientemente de las otras partículas enredadas. En cambio, el estado de todo el sistema enredado debe caracterizarse colectivamente. Si, por ejemplo, tenemos un par de electrones enredados, entonces la medición del estado cuántico de un electrón (por ejemplo, espín, polarización, impulso, posición) tiene un impacto en el estado cuántico del otro electrón. Es importante destacar que según la mecánica cuántica, el enredo puede ser no local: las partículas pueden enredarse incluso cuando están separadas por grandes distancias.

No hace falta decir que la existencia del enredo no local no se aceptó de inmediato, pues aparentemente violó uno de los principios clave de la teoría de la relatividad de Einstein, según la cual nada puede moverse y ninguna información puede transmitirse más rápido que la velocidad de la luz. Específicamente, no estaba claro cómo una manipulación en una de las partículas enredadas posiblemente puede afectar el estado de la otra partícula lejana sin transmitir esta información más rápido que la velocidad de la luz. Esta fue una de las razones por las que personas como Albert Einstein y Erwin Schrödinger estaban en contra de aceptar la noción de enredo no local. Así, durante mucho tiempo, la idea de enredo se consideró una herramienta de cálculo útil. Pero la realidad del enredo fue cuestionada, es decir, no fue aceptada como un fenómeno físico real. No fue hasta los experimentos de Alain Aspect de 1982 que se aceptó la existencia de enredos no locales. Hoy en día, la comunidad física acepta que las partículas subatómicas pueden enredarse a grandes distancias.

Lo que este ejemplo muestra es que la postura hacia una determinada entidad o relación puede cambiar incluso dentro de una sola comunidad. Una comunidad puede al principio ser instrumentista hacia una entidad o una estructura, como el enredo cuántico, y luego puede volverse realista sobre la misma entidad o estructura. Por la segunda ley del cambio científico, la aceptación o no aceptación de un reclamo sobre una entidad o una relación por parte de una determinada comunidad depende del método respectivo empleado por esa comunidad. Así, asumir que nosotros como filósofos estamos en condiciones de proporcionar criterios transhistóricos y universales para evaluar lo que es aceptable y lo que es meramente útil sería no sólo anacrónico y presuntuoso sino que iría en contra de las leyes del cambio científico. Por lo tanto, tenemos que abstenernos de trazar tales líneas transhistóricas y universales entre lo que es aceptable y lo que es meramente útil. Es decir, el enfoque del realismo científico selectivo es insostenible.

Esto nos lleva a la posición que se puede llamar realismo científico no selectivo. Según esta visión, nuestras mejores teorías científicas de alguna manera se aproximan al mundo y estamos justificados aceptarlas como las mejores descripciones disponibles de sus respectivos dominios, pero nunca podemos decir qué partes específicas de nuestras teorías son aproximaciones aceptables y qué partes no lo son. El realismo científico no selectivo sostiene que cualquier intento de diferenciar partes aceptables de nuestras teorías de partes meramente útiles está condenado, ya que todas las proposiciones sintéticas —tanto las que describen entidades como las que describen relaciones/estructuras— son inevitablemente falibles y pueden ser reemplazadas en el futuro.

La siguiente tabla resume las principales variedades de realismo científico:

Del realismo al progreso

Una vez que apreciamos que el enfoque selectivo no es viable, también entendemos que ya no podemos intentar trazar líneas transhistóricas y universales entre aproximaciones legítimas y meros instrumentos útiles. Esto se decide por el método empleado de una comunidad individual que puede cambiar a través del tiempo. Así, la cuestión que un realista quiere abordar no es si nuestras teorías se aproximan al mundo —de alguna manera lo hacen— sino si las nuevas teorías aceptadas proporcionan mejores aproximaciones que las teorías previamente aceptadas. Así, la pregunta es la del progreso:

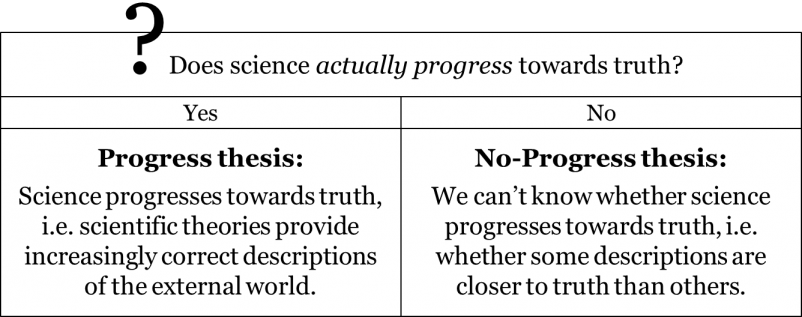

¿La ciencia realmente progresa hacia la verdad?

Obsérvese que, si bien ha habido muchas nociones diferentes de progreso, aquí nos interesa exclusivamente avanzar hacia la descripción correcta del mundo externo independiente de la mente. En efecto, nadie cuestiona realmente la existencia de avances tecnológicos, es decir instrumentales. Es un hecho histórico que nuestra capacidad para manipular diferentes fenómenos ha aumentado constantemente. Después de todo, ahora podemos producir autos autónomos, teléfonos inteligentes y fidget spinners, algo que no pudimos hacer hace poco. Es decir, la existencia del progreso tecnológico (instrumental, empírico) está fuera de toda duda. Lo que está en juego aquí es si también avanzamos en nuestras descripciones del mundo tal como realmente es. Esto vale la pena explicarlo.

La cuestión de si las teorías científicas avanzan hacia la verdad es importante en muchos aspectos. La ciencia, después de todo, parece ser uno de los pocos campos del esfuerzo humano donde legítimamente podemos hablar de progreso. La razón misma por la que tenemos agencias de subvenciones que financian la investigación científica es que asumimos que nuestras nuevas teorías pueden mejorar nuestra comprensión del mundo. La creencia de que las teorías científicas contemporáneas son aproximaciones mucho mejores del mundo que las teorías del pasado parece estar implícita en toda la empresa científica. En definitiva, la creencia de que las teorías actualmente aceptadas son mejores que las del pasado es parte integral de nuestra cultura. Esto es más de lo que se puede decir de muchos otros campos de la actividad humana. Por ejemplo, ¿alguien puede realmente demostrar que la música rock contemporánea es mejor que la de los años setenta y ochenta? ¿Cómo podríamos siquiera comenzar a comparar los dos? ¿Son los autores contemporáneos mejores que Jane Austen, Leo Tolstoy o Marcel Proust? ¿El arte visual contemporáneo es mejor que el de Da Vinci o Rembrandt? Hoy en día se acepta que el arte logra producir diferentes formas, es decir, diferentes formas de abordar el tema, pero la noción misma de que una de estas formas puede ser mejor que otras se considera problemática. Sin embargo, cuando se trata de ciencia, nuestra actitud común en estos días es que avanza de manera constante hacia una aproximación cada vez mejor del mundo. Nuestra pregunta aquí es determinar si ese es realmente el caso. Lo que queremos establecer es si es el caso de que la ciencia se aproxime gradualmente a la verdadera descripción del mundo, o si debemos admitir que la ciencia puede, en el mejor de los casos, darnos diferentes formas de ver el mundo, ninguna de las cuales es mejor o peor.

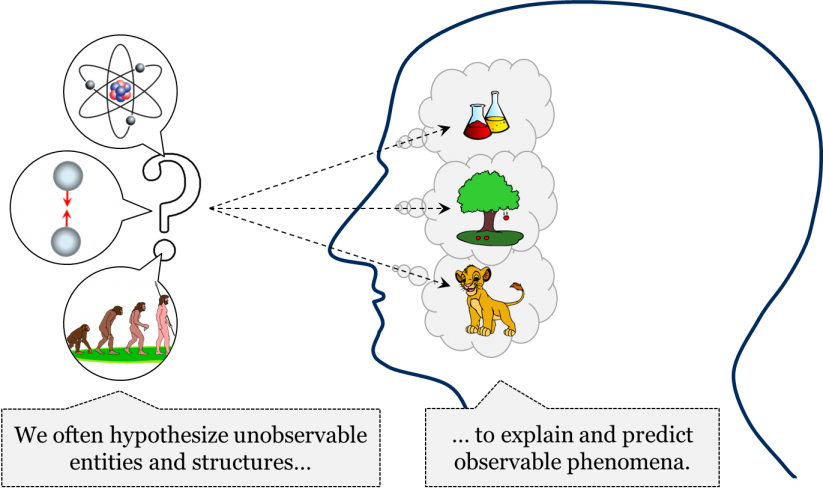

En la ciencia, muchas veces postulamos diferentes hipótesis sobre entidades o relaciones/estructuras no observables para poder explicar fenómenos observables. Por ejemplo, planteamos la hipótesis de la existencia de cierta fuerza atractiva que pretendía explicar por qué se caen las manzanas y por qué los planetas giran en elipses. Del mismo modo, planteamos la hipótesis de la existencia de una cierta estructura atómica que nos permitió explicar muchos fenómenos químicos observables. Se planteó la hipótesis de la existencia de la evolución a través de la mutación y selección natural para explicar las características observables de las especies biológicas. En definitiva, habitualmente planteamos hipótesis y aceptamos diferentes entidades y estructuras no observables para explicar el mundo de los fenómenos, es decir, para explicar el mundo tal como nos aparece en experimentos y observaciones.

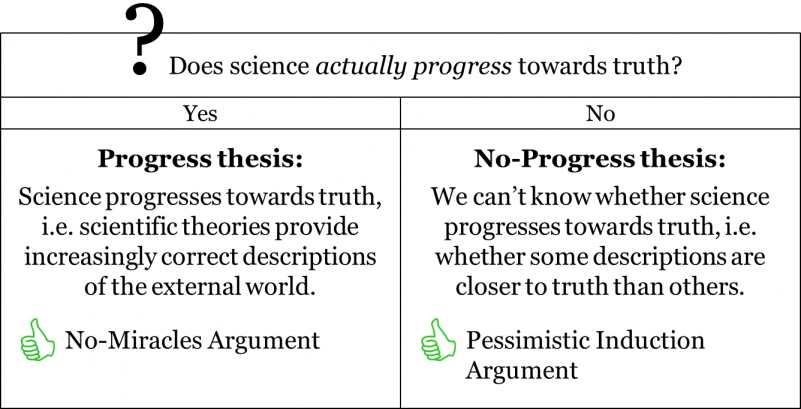

Además, como ya hemos visto, a veces los científicos cambian sus puntos de vista sobre qué tipos de entidades y estructuras pueblan el mundo: las entidades y relaciones que se aceptaron hace cien años pueden o no ser aceptadas todavía hoy en día. Pero si nuestras opiniones sobre entidades y estructuras no observables que supuestamente pueblan el mundo cambian a través del tiempo, ¿realmente podemos decir que estamos mejorando en nuestro conocimiento del mundo tal como realmente es? Hay dos puntos de vista opuestos sobre esta cuestión: la tesis de progreso y la tesis de no progreso. Si bien los campeones de la tesis de progreso creen que la ciencia avanza poco a poco en sus aproximaciones al mundo, los proponentes de la tesis sin progreso sostienen que no estamos en condiciones de saber si nuestras teorías científicas avanzan hacia la verdad.

¿Cómo podemos averiguar cuál de estos partidos opuestos tiene razón? Naturalmente, podríamos estar inclinados a referirnos a las leyes del cambio científico y ver qué tienen que decirnos sobre el tema. Sin embargo, un análisis rápido revela que las leyes del cambio científico tal como están actualmente en realidad no arrojan luz sobre el tema del progreso científico. En efecto, consideremos la segunda ley, según la cual las teorías normalmente llegan a ser aceptadas por una comunidad cuando de alguna manera cumplen con los criterios de aceptación del método empleado por la comunidad. Ahora recordemos la definición de aceptación: aceptar una teoría significa considerarla la mejor descripción disponible de lo que sea que la teoría intente describir. Así, si le preguntamos a alguna comunidad, dirán que sus teorías actuales son mejor aproximación de sus objetos que las teorías que aceptaron en el pasado. Después de todo, no aceptaríamos la relatividad general si no pensáramos que es mejor que la teoría newtoniana. Cualquier comunidad siempre creerá que han ido mejorando en su conocimiento del mundo. Si bien algunas comunidades también pueden creer que ya han logrado la descripción absolutamente verdadera de cierto objeto, incluso estas comunidades aceptarán que sus teorías actuales son mejores que las teorías del pasado. Es decir, cuando miramos el proceso de cambio científico desde la perspectiva de cualquier comunidad, la secuencia histórica de sus teorías aceptadas siempre les aparecerá progresiva.

Claramente, este enfoque no nos lleva demasiado lejos, ya que la cuestión no era si el proceso de cambio científico parece progresivo desde la perspectiva de la comunidad científica, sino si el proceso es realmente progresivo. Las leyes del cambio científico nos dicen que si fuéramos a preguntar a alguna comunidad científica, se suscribirían a la noción de progreso. Sin embargo, para saber si, de hecho, avanzamos hacia la verdad, necesitamos un enfoque diferente. En lo que resta de este capítulo, consideraremos los dos argumentos más famosos a favor y en contra de la tesis de progreso: el argumento de no milagros y el argumento pesimista de metainducción.

Como ya lo hemos establecido, nadie niega que la ciencia se vuelva cada vez más exitosa en su capacidad de manipular y predecir fenómenos observables. Es este éxito empírico de nuestras teorías lo que nos permite predecir eventos futuros, construir todo tipo de instrumentos útiles y cambiar drásticamente el mundo que nos rodea. En su capacidad para predecir y manipular con precisión fenómenos observables, nuestra ciencia del siglo XXI está innegablemente por encima de la ciencia del pasado. Pero, ¿este creciente éxito empírico de nuestras teorías significa que también nos estamos acercando a la verdadera imagen del mundo tal como realmente es? Aquí es donde la tesis de progreso y la tesis de no progreso difieren drásticamente.

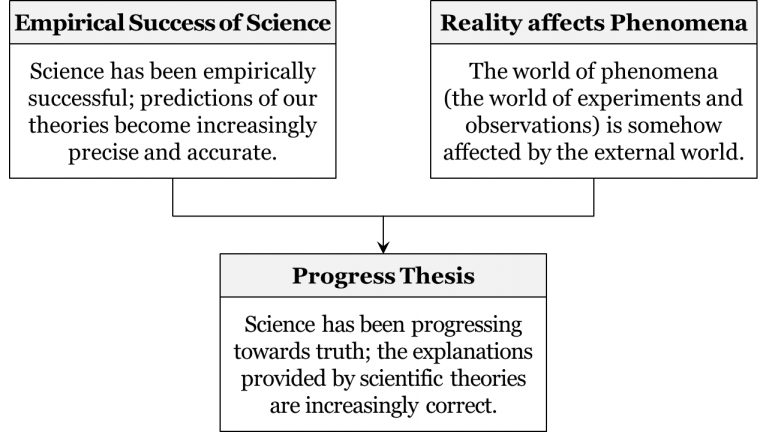

Según los campeones de la tesis de progreso, el éxito empírico de nuestras teorías es el resultado de nuestra comprensión cada vez mejor del mundo tal como realmente es. Esto se debe a que el mundo de los fenómenos no puede estar completamente divorciado del mundo externo. Después de todo, así dice el argumento, el mundo de los fenómenos es un efecto del mundo externo sobre nuestros sentidos: lo que vemos, escuchamos, olemos, saboreamos y tocamos debería estar conectado de alguna manera con cómo es realmente el mundo. Por supuesto, nadie va a afirmar que el mundo tal como es en la realidad es exactamente la forma en que lo percibimos —es decir, nadie defenderá la visión del realismo ingenuo en estos días— pero ¿no es razonable sugerir que lo que percibimos depende de la naturaleza del mundo externo al menos hasta cierto punto? Así, los resultados de experimentos y observaciones se ven afectados al menos parcialmente por las cosas como realmente son. Pero esto significa que al mejorar nuestra capacidad de lidiar con el mundo de los fenómenos observables, también estamos mejorando gradualmente nuestro conocimiento del mundo de los no observables. En otras palabras, a medida que aumenta el poder predictivo general de nuestras teorías, esto es, en términos generales, un buen indicio de que nuestra comprensión del mundo mismo también mejora. Aquí está el argumento:

La idea subyacente es bastante simple: si nuestras teorías no lograran acertar al menos algo sobre el mundo tal como realmente es, entonces el éxito empírico de nuestra ciencia sería simplemente un milagro. En efecto, ¿de qué otra manera podríamos explicar el éxito empírico sin precedentes de nuestra ciencia si no por el hecho de que se vuelve cada vez mejor en sus aproximaciones al mundo externo? Seguramente, si pudiéramos lograr tener tanto éxito empírico sin tener nunca nada correcto sobre el mundo externo, eso sería un milagro. La única explicación razonable, dicen los campeones de la tesis de progreso, es que nuestras aproximaciones del mundo también mejoran, es decir, que poco a poco avanzamos hacia la verdad. Esta es la esencia del famoso argumento de no milagros para el progreso científico.

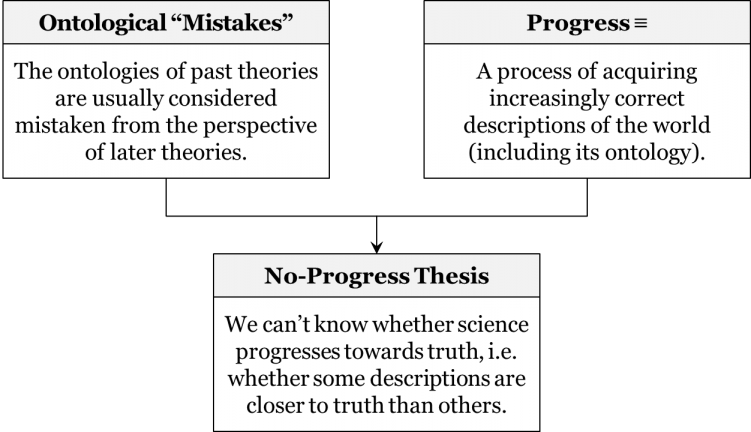

¿Cómo respondería a esto un campeón de la tesis sin progreso? Una respuesta común es el llamado argumento pesimista de metainducción. Apreciemos primero, dice un campeón de la tesis de no progreso, un simple hecho histórico: a menudo nos hemos equivocado en nuestras hipótesis relativas a entidades o estructuras no observables. Cuando tratamos de plantear la hipótesis de qué entidades o estructuras no observables pueblan el mundo, es decir, cuando tratamos de adivinar la ontología del mundo, a menudo terminamos aceptando entidades y estructuras que finalmente llegamos a rechazar como equivocadas. La historia de la ciencia, así va el argumento, proporciona varios grandes ejemplos de ello. Considere la idea de los cuatro elementos terrestres de tierra, agua, aire y fuego que fueron parte integral de cualquier mosaico aristotelio-medieval hasta el siglo XVII. De igual manera, recordemos la idea de flogiston aceptada en el siglo XVIII. Recordemos también la idea de que la fuerza de gravedad actúa a una distancia entre dos objetos cualesquiera del universo, la cual fue aceptada hasta ca. 1920. Es un hecho histórico, dicen los proponentes de la tesis de no progreso, que nuestro conocimiento sobre las entidades y estructuras que pueblan el mundo ha cambiado a través del tiempo. A menudo nos equivocamos en nuestras hipótesis sobre la ontología del mundo. Como resultado, muchas veces rechazamos viejas ontologías y aceptamos otras nuevas. Pero si las ontologías de nuestras teorías pasadas normalmente se consideran equivocadas desde perspectivas posteriores, ¿cómo podemos afirmar que nuestras teorías mejoran gradualmente al aproximarse al mundo? ¿No deberíamos preferir ser más modestos y decir que todo lo que sabemos es que a menudo nos equivocamos en nuestras hipótesis sobre las entidades y estructuras no observables, que muchas veces llegamos a rechazar ontologías largamente aceptadas, y que las ontologías de nuestras teorías actuales podrían encontrarse, algún día, igualmente equivocadas? Es decir, debemos aceptar que no hay garantía de que nuestras teorías mejoren como aproximaciones del mundo tal como realmente es; no estamos en condiciones de afirmar que la ciencia proporciona descripciones cada vez más correctas del mundo. ¡Pero eso es precisamente de lo que se trata la idea de progreso! Así, no hay progreso en la ciencia. Aquí está la esencia del argumento:

Si la ontología largamente aceptada de cuatro elementos terrestres se consideró finalmente equivocada, entonces ¿por qué nuestra ontología de quarks, leptones y bosones debería ser diferente? Las entidades y estructuras inobservables que postulan nuestras teorías van y vienen, lo que significa que en el futuro las ontologías de nuestras teorías actuales probablemente se considerarán equivocadas desde la perspectiva de las teorías que vendrán a reemplazarlas. Esta es la sustancia de lo que se conoce como el argumento pesimista de metainducción.

Ahora bien, ¿por qué una etiqueta tan extraña — “metainducción pesimista”? En la literatura, el argumento suele ser retratado como inductivo: debido a que las ontologías de nuestras teorías pasadas han sido repetidamente rechazadas, generalizamos y pronosticamos que las ontologías de las teorías actualmente aceptadas también algún día serán rechazadas. Este es un paso meta- inductivo, ya que no se refiere a nuestras descripciones del mundo, sino a nuestras descripciones sobre nuestras descripciones, es decir, nuestras metateorías (por ejemplo, la afirmación de que “las ontologías de teorías pasadas han sido rechazadas”). Como todo el argumento cuestiona la capacidad de nuestras ontologías actuales para soportar retos futuros, también es claramente pesimista. Es importante señalar que si bien la forma inductiva del argumento es muy popular en la literatura filosófica, también puede formularse como argumento deductivo, como lo hemos hecho anteriormente. La razón principal por la que hoy en día creemos que nuestras afirmaciones sobre entidades y estructuras no observables pueden ser rechazadas en el futuro es nuestro falibilismo, por lo que tenemos varias razones teóricas, como el problema de las sensaciones, el problema de la inducción y el problema de la teoría-ladenness. Ya que aceptamos que todas nuestras teorías empíricas son falibles, no hacemos ninguna excepción para nuestras afirmaciones sobre la ontología del mundo —y ¿por qué deberíamos hacerlo? Entonces, aunque el argumento es tradicionalmente etiquetado como “metainducción pesimista”, puede formularse de tal manera que se evite cualquier uso directo de la inducción. Ni siquiera tenemos que mencionar el fracaso de nuestras ontologías pasadas; nuestro falibilismo por sí solo es suficiente para afirmar que nuestras ontologías actuales también están probablemente condenadas al fracaso.

Independientemente de cómo se formule el argumento, su mensaje principal sigue siendo el mismo: no estamos en condiciones de decir que hay avances reales hacia la verdad. Dado que las ontologías de las teorías pasadas suelen considerarse erróneas desde la perspectiva de las teorías futuras, el proceso de cambio científico produce una ontología defectuosa de entidades y estructuras inobservables tras otra. Lo que terminamos es esencialmente un cementerio de ontologías rechazadas —una serie de transiciones donde una falsa ontología reemplaza a otra falsa ontología y así sucesivamente. Todo lo que nos da la ciencia son diferentes perspectivas, diferentes formas de acercarse al mundo, que pueden ser más o menos empíricamente exitosas, sin embargo, ninguna de estas se puede decir que se aproxima al mundo mejor que otras. Así, todo lo que podemos reivindicar legítimamente, según la tesis de no progreso, es que la ciencia aumenta su poder predictivo general pero no nos acerca más a la verdad.

¿Este argumento tiene agua? A diferencia del argumento de no milagros, el argumento pesimista de metainducción divorcia el éxito empírico de una teoría de su capacidad de aproximarse con éxito al mundo. En efecto, el hecho de que una teoría sea predictivamente precisa y pueda ser utilizada en aplicaciones prácticas no necesariamente hace que su ontología sea más veraz. Consideremos, por ejemplo, la astronomía geocéntrica ptolemaica que tuvo un gran éxito en sus predicciones de posiciones planetarias, pero postuló una ontología de excéntricos, ecuantes, epiciclos y deferentes, que se consideró dudosa incluso en la Edad Media. Además, la historia de la ciencia proporciona muchos ejemplos en los que varias teorías, con ontologías completamente diferentes, tuvieron igualmente éxito en sus predicciones de fenómenos observables. Así, a principios del siglo XVII, la teoría heliocéntrica copernicana y la teoría geo-heliocéntrica tychónica postulaban ontologías distintas pero eran casi indistinguibles en sus predicciones de posiciones planetarias observables. Hoy en día, tenemos una serie de teorías cuánticas diferentes —las llamadas “interpretaciones” de la mecánica cuántica— que hacen exactamente las mismas predicciones pero postulan ontologías muy diferentes. Si teorías con ontologías completamente diferentes logran ser igualmente exitosas en sus predicciones, entonces ¿cómo podemos incluso elegir cuál de estas ontologías distintas aceptar, y mucho menos argumentar que una de ellas es una mejor aproximación del mundo? Los campeones de la tesis sin progreso hacen un gran trabajo destacando esta discrepancia entre los éxitos empíricos y la aproximación al mundo. Es decir, señalan que, del mero hecho de que el mundo de los fenómenos se ve afectado por la realidad, no se deduce que al mejorar nuestro conocimiento de los fenómenos, simultáneamente mejoramos nuestro conocimiento del mundo tal como realmente es. Así, cuestionan la validez del argumento de no milagros.

Sin embargo, el argumento pesimista de metainducción tiene un defecto fatal, pues se basa en la premisa de que nuestras ontologías pasadas se consideran equivocadas desde la perspectiva de teorías futuras. Si realmente somos falibilistas, entonces debemos tener mucho cuidado al considerar las ontologías del pasado como falsas en el sentido absoluto. En cambio, debemos aceptar que no son absolutamente falsas, sino que contienen al menos algunos granos de verdad, es decir, que de alguna manera se aproximan al mundo, aunque imperfectamente. Por ejemplo, finalmente llegamos a rechazar la ontología de cuatro elementos, pero no creemos que fuera absolutamente falsa. En cambio, pensamos que contenía algunos granos de verdad, ya que claramente se asemeja a la idea contemporánea de los cuatro estados de la materia: sólido, líquido, gas y plasma. Del mismo modo, ya no aceptamos la teoría del flogiston, pero decir que su ontología estaba absolutamente equivocada sería un estiramiento; era una aproximación —una bastante mala para estar seguros, pero una aproximación sin embargo. La posición falibilista no es que las antiguas ontologías sean estrictamente falsas, sino que la ontología de la relatividad general y la física cuántica es ligeramente mejor que la ontología de la física clásica, así como la ontología de la física clásica fue ligeramente mejor que la ontología de la filosofía natural de Descartes, que a su vez era ligeramente mejor que la de Aristóteles. Así, no podemos decir que cometemos errores ontológicos en el sentido absoluto. Las viejas ontologías son rechazadas no porque se consideren absolutamente falsas, sino porque pensamos que tenemos algo mejor. Una manera útil de pensarlo es como una serie de fotografías de la misma persona —desde las más borrosas hasta las más nítidas. En comparación con las fotografías nítidas, las fotografías borrosas serían peores aproximaciones de la apariencia de la persona; sin embargo, lo que es más importante, todas son aproximaciones. En definitiva, la premisa de los “errores” ontológicos no retiene agua, y así todo el argumento no es sólido.

Resumen

Comenzamos este capítulo planteando la cuestión del realismo científico: ¿nuestras mejores teorías describen correctamente el mundo externo independiente de la mente? Hemos aprendido que el punto central de contienda entre realistas e instrumentistas no se refiere a nuestra capacidad de describir lo que es inmediatamente observable, sino a nuestra capacidad de proporcionar descripciones confiables de entidades y estructuras no observables. Si bien ambas partes coinciden en que las teorías pueden ser legítimamente utilizadas en aplicaciones prácticas, los realistas científicos también creen que podemos aceptar legítimamente las afirmaciones de nuestras teorías sobre los no observables. Hemos discutido una serie de subespecies de realismo científico. También hemos visto cómo fracasan los enfoques selectivos en sus intentos de diferenciar partes aceptables de nuestras teorías de aquellas que son meramente útiles. Nuestro conocimiento tanto de las entidades no observables como de las estructuras no observables cambia a través del tiempo y no existe un método transhistórico y universal que indique qué partes de nuestras teorías deben aceptarse y cuáles solo se utilizan. Sólo los métodos reales empleados por una comunidad determinada en un momento dado pueden responder a esa pregunta.

Entonces sugerimos que hay una cuestión más interesante que discutir, la del progreso científico. Si bien en general se concuerda en que nuestras teorías científicas han tenido un enorme éxito en el tratamiento de fenómenos observables, existe un acalorado debate sobre si las teorías científicas progresan gradualmente hacia aproximaciones del mundo cada vez mejores. Hemos visto que el argumento principal para la tesis de no progreso —el argumento pesimista de la meta-inducción— tiene un grave defecto. El debate puede resumirse en la siguiente tabla:

Si bien podemos decir tentativamente que la tesis de progreso parece un poco mejor apoyada, hay que ser cautelosos para no saltar a la conclusión de que el debate ha terminado. Lejos de ello: la cuestión del progreso es central en la filosofía contemporánea de la ciencia y es objeto de continuas discusiones.