1.10: Cosmovisión contemporánea

- Page ID

- 99143

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

Intro

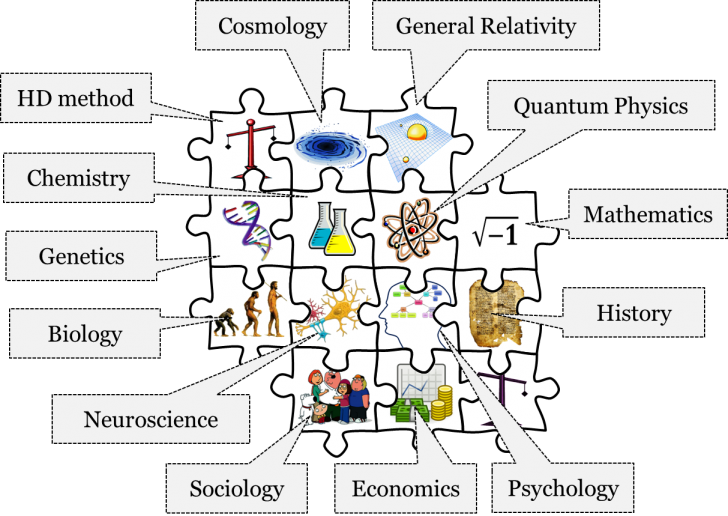

El mosaico contemporáneo probablemente nos parecerá más familiar que sus predecesores. Incluye, después de todo, las teorías y métodos que se enseñan en las mismas universidades a las que asistes. Llevamos el mosaico contemporáneo desde alrededor de la década de 1920. Incluye teorías aceptadas como la neurociencia, la mecánica cuántica, la relatividad especial y general, y la cosmología, que consideraremos con más profundidad a continuación, además de las teorías de biología evolutiva, genética, química, psicología, sociología, economía e historia.

Es importante recordar que, como con todos los mosaicos anteriores, el mosaico Contemporáneo se encuentra en un continuo estado de flujo. En otras palabras, el mosaico de 1920 no es idéntico al mosaico de hoy. Además, como subrayamos en el capítulo 2, nuestro conjunto actual de teorías aceptadas y métodos empleados no son en modo alguno absolutamente cierto. Creemos que son las mejores descripciones disponibles de sus respectivos objetos, pero también estamos preparados para reemplazar nuestras mejores descripciones por otras aún mejores. Consideremos, por ejemplo, la aceptación del bosón de Higgs, el mapeo del genoma humano o el descubrimiento de nuevas pirámides en Egipto. Entonces, aunque a veces tratamos nuestra cosmovisión contemporánea como inmutable y algo ya cristalizado, es muy modificable a medida que aprendemos más sobre el mundo.

Comencemos nuestra discusión enfocada de la cosmovisión contemporánea con el campo de la neurociencia cognitiva y los principios metafísicos implícitos en esta disciplina.

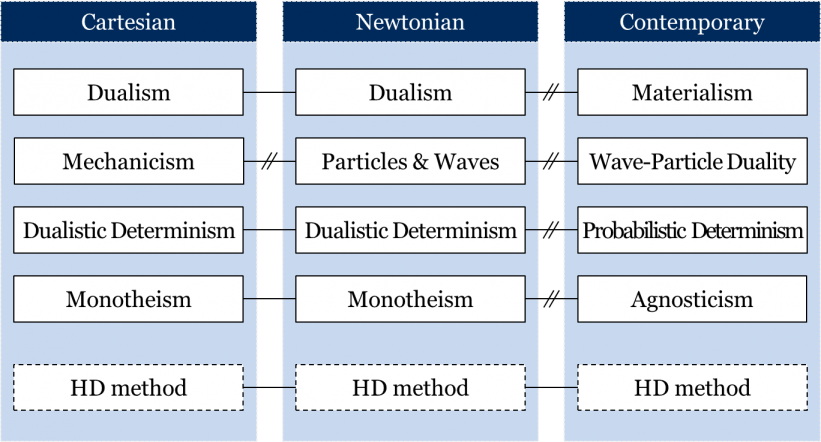

Neurociencia Cognitiva

La neurociencia es el estudio del sistema nervioso y tiene como objetivo comprender mejor las funciones del cerebro. La ciencia cognitiva es el estudio de la mente y sus procesos. La neurociencia cognitiva fusiona estos dos campos y busca comprender los procesos de la mente como funciones del cerebro. La cuestión metafísica central aquí es si la mente puede existir independientemente del cerebro o cualquier cosa material, o si la mente requiere la existencia de un sustrato material para producirla. En los capítulos históricos anteriores, hemos visto que cartesianos y newtonianos por igual aceptaron la concepción metafísica del dualismo, que sostiene que la mente y la materia son sustancias independientes. Recordemos, por ejemplo, cómo los fisiólogos mecanicistas cartesianos no pudieron encontrar una manera aceptable para que la mente interactuara con la materia. Este problema se agudizó en el siglo XIX, cuando se aceptó la ley de conservación de la energía. La ley implica que el mundo físico está causalmente cerrado, y que por lo tanto es imposible que una mente no física influya en un cerebro físico. Dada esta restricción, y las teorías neurocientíficas aceptadas dentro del mosaico contemporáneo, el dualismo de sustancias ya no se considera como la mejor descripción disponible de la relación entre mente y materia.

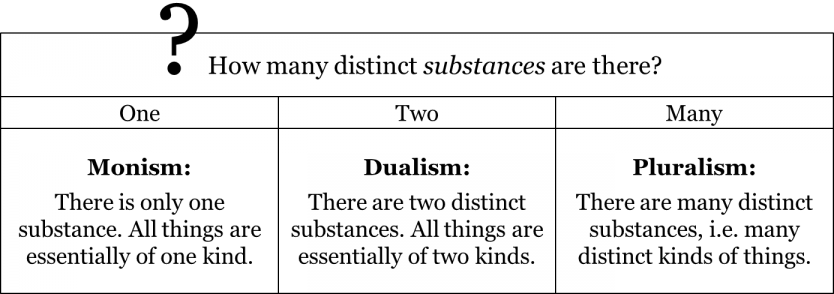

El dualismo es una respuesta a una pregunta sobre el número de distintas sustancias independientes que realmente existen. Responde que hay dos sustancias independientes. El pluralismo —principio metafísico implícito en la cosmovisión aristotélico-medieval — responde que hay muchas sustancias independientes. Otra posible respuesta es la del monismo: que sólo hay una sola sustancia independiente.

Las diferentes variedades de monismo tienen una comprensión diferente de la naturaleza de esta única sustancia independiente. Consideremos los diversos tipos de monismo.

Un tipo de monismo se llama idealismo. El idealismo nos dice que sólo hay una sustancia independiente, la mente. En otras palabras, todas las cosas materiales del mundo son simplemente los productos o manifestaciones de la mente. El idealismo tiene dos subtipos principales: el idealismo subjetivo y el objetivo. El idealismo subjetivo sugiere que la existencia de objetos materiales depende de la percepción de esos objetos por una mente individual, es decir, ser es ser percibido.

Esencialmente, los idealistas subjetivos afirman que se puede decir que los objetos existen solo como percepciones dentro de una mente individual. Para reforzar esta afirmación, preguntan cómo se imagina un objeto material no percibido. Es decir, preguntan cómo se ve algo independiente de la mente (es decir, algo no percibido). Responder a esta pregunta, sin embargo, es imposible, porque en cuanto intentas imaginar algo, estás confiando en una mente. De ahí que, según el idealismo subjetivo, los objetos materiales no puedan existir independientemente de la mente. El idealismo subjetivo suele estar ligado al filósofo irlandés George Berkeley.

El idealismo subjetivo es problemático porque no está muy claro por qué diferentes mentes individuales perciben las mismas cosas. Por ejemplo, si dos personas están mirando el mismo objeto, por lo general tendrán percepciones similares de ese objeto. Por lo tanto, debe existir algún tipo de mecanismo que garantice la coherencia de las percepciones entre las diferentes mentes individuales.

Para resolver este problema, algunos filósofos postularon la existencia de una mente universal, como la de Dios, que garantiza que las percepciones de diferentes mentes individuales coherán. Este paso, sin embargo, nos lleva al idealismo objetivo, que sostiene que todo depende y existe dentro de la mente de un solo perceptor objetivo.

Es importante destacar que el idealismo objetivo no niega que los objetos materiales existan fuera de las mentes individuales. Pero sí niega que el mundo material pueda existir fuera de esta mente única y universal. Este subtipo de idealismo está asociado con el filósofo alemán George Wilhelm Friedrich Hegel. A menudo, los idealistas objetivos entienden el mundo material como una manifestación de esta mente objetiva, universal. En nuestra comprensión moderna, esto es similar a una simulación por computadora. Dentro de esta simulación, suceden un par de cosas. Primero, la percepción de cualquier persona del mundo material (simulado) sería similar a la de todos los demás.Dos, la experiencia de cualquiera de este mundo material depende del programa que ejecuta la simulación, y no de las mentes individuales dentro de la simulación.

Para ser claros, el idealismo no implica que el mundo material no exista. En cambio, el idealismo afirma que el mundo material no puede existir sin la mente —ni subjetiva ni objetiva—. En otras palabras, la mente es la única sustancia independiente.

En contraste con el idealismo, existe otra posición monista conocida como materialismo. El materialismo también nos dice que solo hay una sustancia independiente, pero que esta sustancia es materia, no mente. Para los materialistas, todos los estados mentales, pensamientos, emociones, recuerdos y percepciones son productos de algún proceso material. Antes de los tiempos modernos, era muy difícil entender cómo esto podría ser posible.

Una tercera variedad de monismo se llama monismo neutral. Según el monismo neutral, sólo hay una sustancia independiente, que no es ni puramente material ni puramente ideal, sino una sustancia neutra que es tanto material como ideal al mismo tiempo. Según los monistas neutrales, todo en el universo es a la vez materia y mente: no hay nada puramente material o puramente ideal. En otras palabras, se dice que todo lo material tiene algunas capacidades mentales, aunque muy mínimas. De igual manera, se dice que todo lo ideal presupone un proceso material u otro. En esta visión, la materia y la mente son simplemente dos caras de una misma moneda; la naturaleza misma es, en cierto sentido, neutra. Una variedad tradicional de monismo neutral es la idea de que la naturaleza (materia) y Dios (mente) son esencialmente uno y lo mismo: la mente divina no existe fuera de la naturaleza, y la naturaleza no existe independientemente de la mente divina. Uno de los campeones más notables de esta versión del monismo neutral es el filósofo Baruch Spinoza. Una visión similar fue avalada por el físico Albert Einstein. Una versión aún más contemporánea del monismo neutral sugiere que cada pedacito de materia contiene en sí misma información sobre su estado actual, así como sus estados pasados y, probablemente, sus posibles estados futuros. Pero la información, en esta opinión, es algo ideal —son los datos “almacenados” en la naturaleza y “procesados” por naturaleza. Toda la naturaleza, en esta visión, se convierte en una enorme computadora que procesa grandes cantidades de información cada segundo para decidir qué sucede con cada pedacito de la materia.

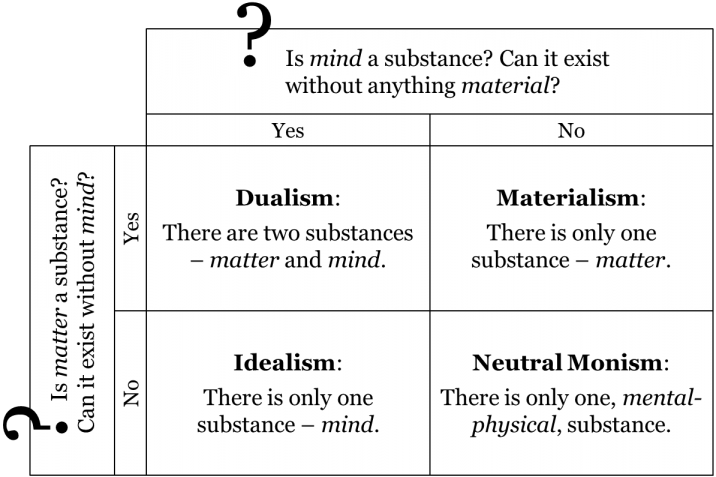

Entonces, el dualismo, el idealismo, el materialismo y el monismo neutral son nuestras opciones respecto a la relación entre mente y materia. Las cuatro concepciones se resumen en la siguiente tabla:

Tanto cartesianos como newtonianos descansaban dentro del campo del dualismo. Esto no se debió simplemente a su aceptación de las creencias teológicas cristianas sobre la inmortalidad del alma. Tanto para los cartesianos como para los newtonianos, los sistemas materiales eran en cierto sentido parecidos a máquinas, pero parecía inconcebible que nuestra mente pudiera ser una máquina. Descartes señaló que la razón humana era un 'instrumento universal' que podía ser utilizado de manera flexible en todo tipo de situaciones, mientras que todas las máquinas que conocía estaban rígidamente dispuestas a realizar una función en particular.

¿Qué visión de la relación entre mente y materia forma parte de la cosmovisión contemporánea? ¿Qué hemos aprendido de la mente en el siglo pasado que podría arrojar luz sobre este tema?

La neurociencia comenzó en el siglo XIX cuando importantes mejoras en los microscopios permitieron comprender la estructura a microescala de los seres vivos. El neuroanatomista español Santiago Ramón y Cajal demostró que el sistema nervioso, al igual que otros sistemas corporales, estaba compuesto por distintas células vivas, a las que llamó neuronas. Ramón y Cajal supuso que las neuronas, con sus complejas ramas arbóreas, se señalaban entre sí y formaban las unidades de trabajo del cerebro. Según una estimación actual, el cerebro humano contiene 86 mil millones de neuronas. La sustancia del cerebro poseía claramente la complejidad organizada que uno podría suponer que una máquina pensante necesitaría. Pero, ¿cómo podría pensar una máquina?

A principios del siglo XX muchos neurocientíficos trabajaron para comprender los mecanismos de señalización eléctrica y química de las neuronas. Pero este trabajo, por sí mismo, proporcionó poca idea de cómo o si el cerebro podría ser la base física de la mente. La perspicacia necesaria vino de otro campo. En 1936, el matemático Alan Turing demostró que teóricamente era posible que una máquina simple, ahora llamada máquina de Turing, realizara cualquier cálculo matemático, siempre y cuando pudiera especificarse claramente. El hallazgo de Turing, en efecto, refutó la afirmación de Descartes de que una máquina carecía de la flexibilidad para ser un instrumento universal. Aunque el trabajo de Turing originalmente estaba destinado a abordar un problema en los fundamentos filosóficos de las matemáticas, él y otros pronto se dieron cuenta de que también tenía un significado práctico. Condujo directamente al desarrollo de la computadora electrónica digital. A principios del siglo XXI, esta máquina, y una forma rudimentaria de 'pensamiento' de la máquina, se han convertido en una característica siempre presente de la vida cotidiana.

La capacidad de realizar, en segundos, cálculos matemáticos que tardarían años o siglos para un ser humano sin ayuda tuvo un profundo impacto en muchas áreas de la ciencia, incluyendo, especialmente, el intento de entender la mente. Los primeros científicos cognitivos supusieron que la mente funcionaba literalmente como computadoras actuales y funcionaba manipulando símbolos de acuerdo con reglas lógicas. Este enfoque tuvo algunos éxitos, ya que las computadoras podrían programarse para realizar tareas que requerirían mucho esfuerzo intelectual si fueran realizadas por seres humanos, como vencer a grandes maestros en el ajedrez o probar teoremas matemáticos. Pero los investigadores pronto se dieron cuenta de que el estilo de computación del cerebro era muy diferente al de las computadoras actuales y que entender la mente requeriría comprender cómo las neuronas del cerebro interactuaban entre sí para crearla. A finales del siglo XX, la ciencia cognitiva y la neurociencia se habían fusionado como neurociencia cognitiva. Al ser instrumentos universales, las computadoras digitales podrían programarse para simular redes idealizadas de neuronas que interactúan. Estas redes neuronales artificiales tienen la capacidad de aprender y demostraron ser capaces de aprender de manera flexible para realizar tareas como reconocer y clasificar patrones, tareas que se consideran críticas para sus contrapartes biológicas. En lugar de simplemente reaccionar a sus entradas, se ha encontrado que el cerebro se encuentra en un estado de actividad constante, impulsada internamente, formando un sistema dinámico que constantemente anticipa y predice sus entradas.

Más evidencia de que el cerebro es el sustrato físico de la mente proviene de nuevas tecnologías, como la resonancia magnética funcional (fMRI) para obtener imágenes directas de procesos funcionales en cerebros humanos vivos. En esencia, la fMRI mide el flujo sanguíneo dentro del cerebro. Un aumento del flujo sanguíneo a cierta área del cerebro indica actividad neuronal y uso cognitivo de esa área del cerebro. FMRI permite a los neurocientíficos obtener imágenes de diferentes partes del cerebro activadas en respuesta a diversos estímulos. Durante un experimento conductual, un neurocientífico podría pedirle a un sujeto de prueba que realice una tarea simple o recuerde un recuerdo que provoque ciertas emociones. Al haber mapeado diferentes procesos cerebrales en diferentes áreas del cerebro, los neurocientíficos son capaces de predecir y medir con éxito qué partes del cerebro del sujeto se activarán en respuesta a sus instrucciones. Así, razonan que las tareas mentales, como sentir una emoción o revivir una memoria son el resultado de la actividad neuronal en el cerebro.

Los neurocientíficos cognitivos aceptan que el cerebro es el sustrato físico de la mente y persiguen un relato teórico que busca explicar procesos cognitivos como la percepción, la razón, la emoción y la toma de decisiones sobre esa base. La afirmación de que los estados mentales son producidos por procesos físicos es incompatible con el dualismo de sustancia. De hecho, si los estados mentales son producidos por un proceso físico, esto es un fuerte indicio de que la mente no existe sin procesos materiales subyacentes. En otras palabras, esto sugiere la visión materialismo, que afirma que la materia es la única sustancia independiente.

Mecánica Cuántica

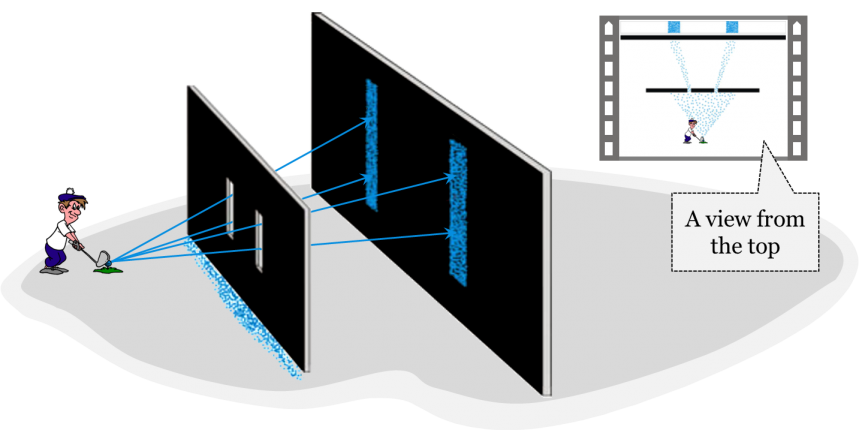

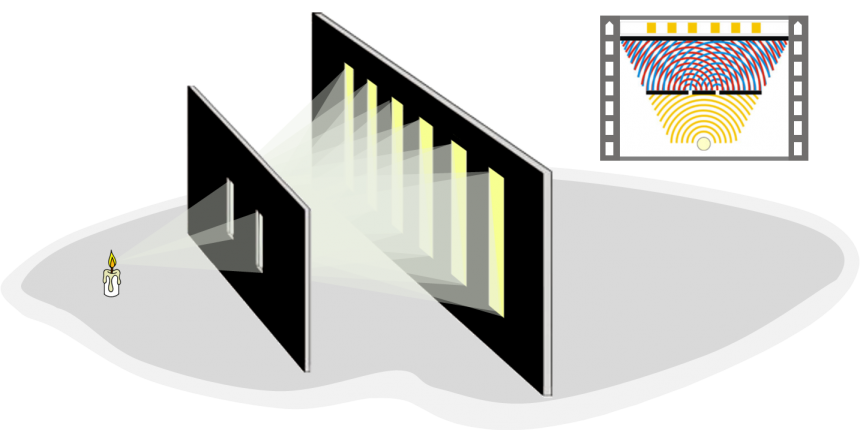

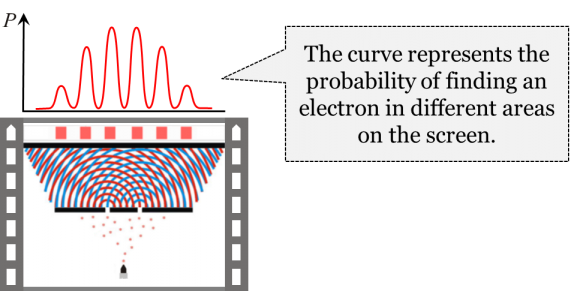

Apreciar que la materia es la única sustancia es una cosa, tener una comprensión clara de qué es la materia y qué propiedades tiene es algo diferente. Es seguro decir que la noción misma de materia cambió a través del tiempo. Para ilustrar estos cambios, consideraremos diferentes versiones del famoso experimento de doble hendidura. Imagina una pared con una hendidura frente a otra pared sólida. Ahora, considere a un golfista golpeando bolas cubiertas de pintura en dirección a las dos paredes. Si bien algunas de las bolas probablemente golpearán la primera pared, otras pasarán por la hendidura y dejarán marcas en la pared posterior. Poco a poco, una forma lineal emergerá en la pared posterior. Ahora, agreguemos otra hendidura a la pared frontal. ¿Qué tipo de patrón esperaríamos en esta puesta a punto? Esperaríamos dos líneas pintadas en la pared posterior, así:

Esta imagen está muy en sintonía con las predicciones de la mecánica newtoniana, donde, según la primera ley de Newton, se supone que las pelotas viajarán por líneas rectas si no se ven afectadas por ninguna otra fuerza.

Recordemos, sin embargo, el cambio en la concepción newtoniana de la materia discutida al final del capítulo 9. Después de la aceptación de la teoría de ondas de la luz en 1819, la noción de materia se amplió para incluir no sólo los corpúsculos, sino también las ondas en un medio fluido llamado éter luminífero. Imagina que reemplazamos al golfista con una fuente de luz. Si la luz consistiera en corpúsculos, entonces, en cuanto a las pelotas de golf, uno esperaría una imagen de dos líneas rectas en la pantalla posterior. Sin embargo, si las hendiduras son lo suficientemente estrechas, y lo suficientemente cercanas entre sí, la imagen causada por la luz que brilla a través de las dos hendiduras y representada en la pantalla posterior no sería de dos líneas. En su lugar habría múltiples líneas:

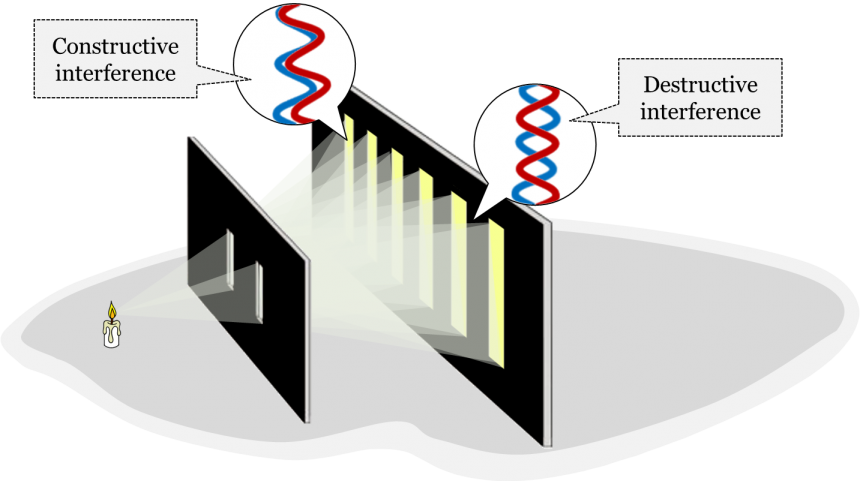

Este extraño fenómeno fue muy bien explicado por la teoría de ondas de la luz. Según esta teoría, las ondas de luz se someten a un proceso llamado difracción. La difracción es la flexión de una onda alrededor de un objeto o después de pasar a través de un agujero que es estrecho en relación con la longitud de onda de la onda de luz. Entonces, en lugar de continuar en línea recta después de pasar por una sola hendidura, la ola comienza a extenderse. En el experimento, sin embargo, tenemos dos rendijas. A medida que las ondas de luz pasan por ambas hendiduras y comienzan a difractar al otro lado de la primera pantalla, empiezan a interferir entre sí. Es similar a dejar caer dos piedras en un charco de aguas tranquilas al mismo tiempo. Las ondas eventualmente se golpearán entre sí y crearán olas cada vez más grandes. A este fenómeno se le conoce como interferencia, que también ocurre con las ondas de luz.

Hay dos tipos de interferencia. En la interferencia destructiva, las crestas y depresiones de las dos ondas están desincronizadas y se cancelan entre sí formando regiones más oscuras en la pantalla detrás de las ranuras. La interferencia constructiva ocurre cuando las crestas y depresiones de las dos ondas están sincronizadas, y las ondas se refuerzan entre sí formando múltiples regiones brillantes en la pantalla.

La teoría de las olas de la luz fue aceptada en la cosmovisión newtoniana hasta alrededor de la década de 1880. Después de eso, los newtonianos aceptaron la electrodinámica clásica, que era una teoría que daba una cuenta unificada de fenómenos tanto eléctricos como magnéticos. En esta teoría, la luz sigue siendo tratada como una onda, pero esta vez como radiación electromagnética, es decir, una onda en un campo electromagnético que se propaga por el espacio vacío sin la necesidad de un medio como el éter luminífero.

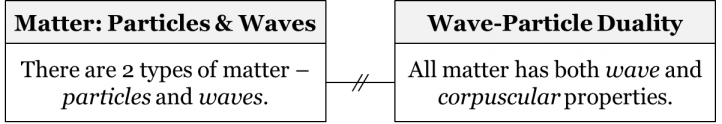

En la década de 1920, sin embargo, la idea newtoniana de que las entidades físicas fundamentales eran partículas u ondas llegó a ser reemplazada por otra idea, la idea de la dualidad onda-partícula. Para entender mejor esta transición, necesitamos profundizar en un elemento del mosaico contemporáneo: la mecánica cuántica.

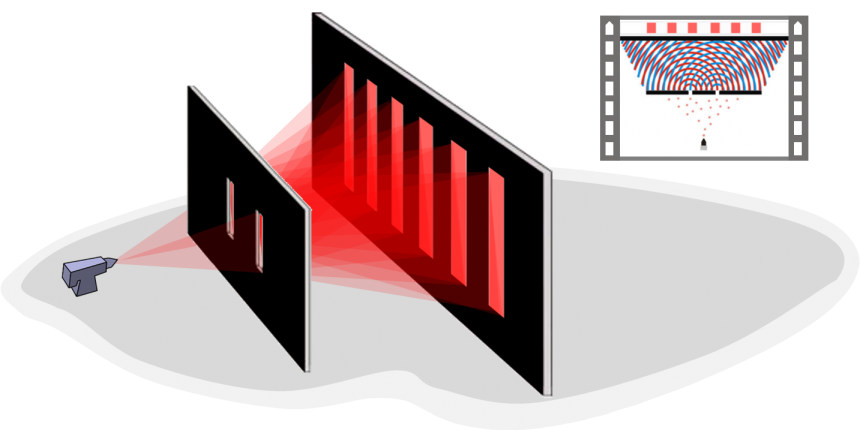

La mecánica cuántica es el estudio físico del mundo cuántico, la física de cosas muy pequeñas. Se trata de explicar cómo se comporta la materia e interactúa con la energía a escala de átomos y partículas subatómicas. El experimento de doble rendija se realizó nuevamente en la década de 1920 para obtener una nueva visión de la naturaleza de los fenómenos cuánticos. La tarea era averiguar si las partículas elementales como los electrones son corpúsculos u ondas. El experimento de doble rendija, en este contexto, fue ligeramente modificado. En lugar de una fuente de luz, se utilizó una pistola de partículas para disparar partículas elementales como electrones. Si los electrones fueran de naturaleza corpuscular, entonces uno esperaría dos líneas rectas en la pantalla posterior. Si, por otro lado, los electrones fueran ondas, uno esperaría patrones de difracción en la pantalla posterior. Un patrón de difracción surgió en la pantalla posterior, sugiriendo que los electrones son ondas.

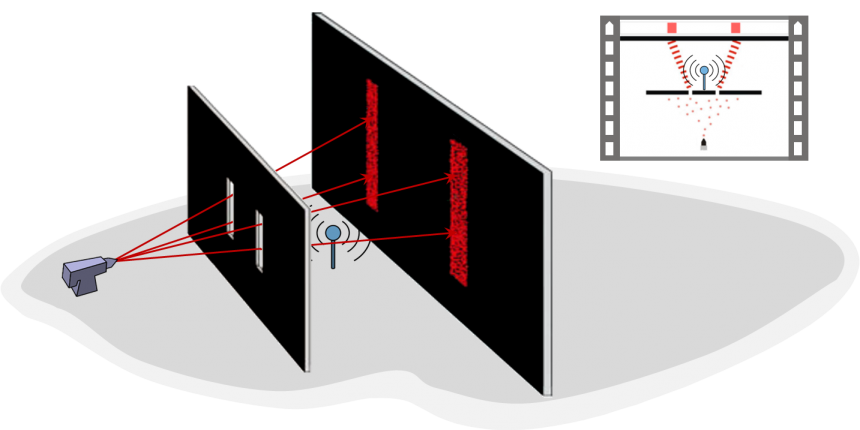

Incluso si los electrones se dispararan en la pantalla uno a la vez, el patrón seguiría apareciendo. Esto significaba que cada electrón tenía que pasar de alguna manera a través de ambas rendijas, luego difractar e interferir consigo mismo para producir el patrón de difracción en la pantalla. Para confirmar que cada electrón pasaba por ambas hendiduras, los experimentadores agregaron un detector junto a las hendiduras que nos indicaría por cuál de las dos hendiduras pasó un electrón: el detector indicaría a los experimentadores si un electrón pasó por la hendidura izquierda, la rendija derecha, ambas hendiduras, o ninguna hendidura. Debido a los patrones de difracción que observaron, los físicos esperaban que el detector indicara que un electrón pasaba por ambas rendijas a la vez. Sin embargo, en el momento en que se agregó el detector a la configuración, los patrones de difracción desaparecieron misteriosamente; ¡ahora eran dos líneas rectas!

Se detectó que cada electrón individual pasaba solo por una de las dos hendiduras, pero nunca a través de ambas. Este fue un resultado sorprendente, ya que se esperaba que los electrones pasaran por ambas rendijas. ¡Era un comportamiento esperado de los corpúsculos, no de las olas! Lo que los experimentadores se dieron cuenta, sin embargo, fue que los electrones que se emitieron se comportaron de manera diferente dependiendo de la presencia o ausencia del detector. Siempre que el detector estaba presente, los electrones encendidos se comportaban como partículas: solo un detector se apagaba para indicar que algo había pasado por su hendidura y no emergería ningún patrón de difracción. En contraste, cada vez que el detector estaba ausente, los electrones encendidos se comportaban como ondas y surgirían patrones de difracción.

Los físicos concluyeron de este experimento que toda la materia tiene propiedades onduladas y corpusculares (es decir, similares a partículas). Todas las partículas en el Modelo Estándar de física de partículas —la teoría actualmente aceptada de qué bloques básicos de la materia existen y cómo interactúan— exhiben este comportamiento dual. Esto incluye electrones, fotones (“partículas ligeras”) e incluso el bosón de Higgs (relativamente) recientemente descubierto. Consideramos este comportamiento dual de toda la materia como un principio metafísico de la cosmovisión contemporánea, y lo llamamos dualidad onda-partícula. El principio metafísico de la dualidad onda-partícula vino a reemplazar la idea de ondas y partículas existentes por separado implícitas en la cosmovisión newtoniana a principios del siglo XX:

Como otro ejemplo de dualidad onda-partícula, considere un experimento relativo al llamado efecto fotoeléctrico. El efecto fotoeléctrico es un fenómeno por el cual los electrones son expulsados de una superficie metálica después de que la luz se ilumina sobre esa superficie. La pregunta que Einstein buscó responder fue si las ondas o partículas de luz eran las responsables de la expulsión de los electrones. Para probar esto, se mediría tanto la frecuencia como la intensidad de la luz. Einstein planteó la hipótesis de que la capacidad de la luz para expulsar electrones con cierta energía dependía únicamente de su frecuencia: no importa cuán alta sea la intensidad de la luz, si su frecuencia no pasaba un cierto umbral, entonces nunca expulsaría electrones de la superficie metálica. Este hecho no se tuvo en cuenta en la teoría de ondas de la luz, que predijo que aumentar la intensidad de la luz también expulsaría electrones. Si bien los newtonianos habían demostrado que la luz se comportaba como ondas, Einstein concluyó que las partículas de luz habían desplazado electrones sobre la superficie metálica. Las teorías de Einstein sobre el efecto fotoeléctrico no eliminaron la evidencia anterior que respaldaba la teoría de ondas de la luz. La luz aún exhibía las propiedades de una ola. Sólo ahora, también exhibió las propiedades de una partícula.

Se acepta en la física cuántica contemporánea que la luz se comporta a veces como una partícula y a veces como una onda. De hecho, en 2015, Nature Communications publicó la primera fotografía de la dualidad onda-partícula de la luz, que se ve a continuación.

La dualidad de la materia también se expresa en el principio de incertidumbre de Heisenberg, uno de los principios fundamentales de la física cuántica. Si se formula para la posición y el impulso de una partícula, el principio de incertidumbre establece:

Cuanto más precisa sea la posición (σ x), más incierto será el impulso (σ p), y viceversa:

El principio establece que cuando tratamos de medir la posición de una partícula elemental, la incertidumbre en el impulso de la partícula aumenta, y a la inversa, cuando tratamos de medir el impulso de la partícula, la incertidumbre en su posición aumenta. Las dos incertidumbres están inversamente relacionadas. Es importante destacar que el principio no se trata de nuestra incapacidad para medir las cosas precisamente por meras limitaciones tecnológicas. Tiene que ver con el hecho de que las partículas elementales realmente son entidades difusas que solo se vuelven parecidas a partículas cuando interactúan con un sistema externo. Esta fuzziness fundamental es una consecuencia de la naturaleza de partículas de onda dual de la materia.

En la mecánica cuántica, la evolución de un sistema cuántico es descrita por la ecuación de onda de Schrödinger. De acuerdo con la ecuación de onda de Schrödinger, las partículas elementales son entidades borrosas, similares a ondas que, sin embargo, exhiben un estado definido similar a una partícula cuando se observan. Pero, incluso en circunstancias idénticas, este estado no siempre es el mismo estado. Las nuevas teorías aceptadas como parte de la mecánica cuántica significaron que los científicos de la cosmovisión contemporánea adoptaron una nueva perspectiva sobre las relaciones de causa y efecto, modificando su creencia anterior en el determinismo. Entonces, consideremos de qué se trata el determinismo y resaltemos brevemente lo que los científicos de cosmovisiones anteriores tuvieron que decir sobre el concepto, antes de profundizar más en lo que es la visión Contemporánea sobre este tema.

La mecánica cuántica afectó más que solo nuestras opiniones sobre la naturaleza de la materia, sino también nuestra comprensión de la causalidad. La cuestión de si el futuro está completamente determinado por el pasado, o si es, en cierto sentido, abierto, ha sido una de las cuestiones centrales de la metafísica desde los días de Aristóteles. Diferentes posturas sobre este tema afectan muchos aspectos de la cosmovisión de uno, incluida la creencia en el libre albedrío, el destino y la predeterminación. La cuestión también tiene graves repercusiones morales. Por ejemplo, si todo en el universo resulta estar estrictamente determinado por el curso de los acontecimientos pasados, entonces ¿cómo podemos culpar a un delincuente por sus crímenes? Si sus acciones de hecho estuvieran completamente determinadas por todo el pasado del universo, entonces, por algunos relatos filosóficos, es el universo al que hay que culpar, ¡no al criminal! Al igual que con otras preguntas metafísicas, la cuestión de la causalidad ha tenido varias respuestas diferentes. Los dos puntos de vista básicos sobre la causalidad son el determinismo y el indeterminismo.

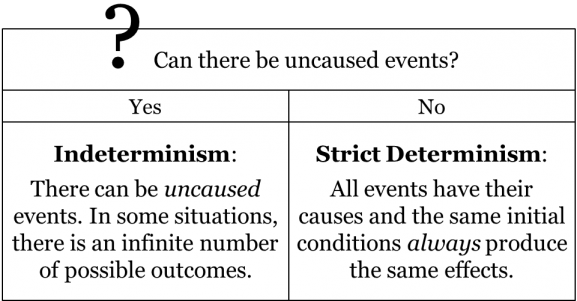

El determinismo (también conocido como determinismo causal, o determinismo estricto) es esencialmente la idea de que cada evento está determinado por eventos anteriores. Más crudamente, significa que para cada efecto, siempre hay una causa que lo produce. Así, si pudiéramos conocer el estado presente del universo (por ejemplo, las posiciones, masas y velocidades de todas las partículas materiales del universo), podríamos, en principio, calcular los estados futuros del universo. Por supuesto, como no somos omniscientes y como no tenemos capacidades ilimitadas de medición y cálculo, tal vez nunca estemos realmente en condiciones de hacer tales predicciones y conocer el futuro con absoluta precisión. Pero esto está fuera de lugar; lo importante aquí es que, según deterministas estrictos, la naturaleza misma “sepa” a dónde va: su futuro está determinado por su pasado.

Lo contrario del determinismo es el indeterminismo, que sugiere que puede haber eventos no causados, es decir, eventos que son completamente aleatorios y que no siguen del curso anterior de los acontecimientos. Tenga en cuenta que los indeterministas no necesariamente afirman que todos los eventos no son causados. Basta con aceptar la existencia de algunos hechos no causados para calificar como indeterminista.

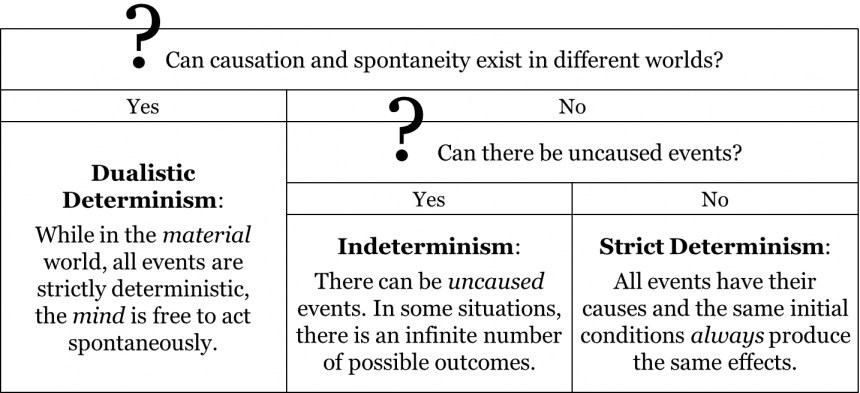

El determinismo y el indeterminismo no agotan el espectro de puntos de vista sobre el tema. Una concepción históricamente popular es la del determinismo dualista, que sostiene que mientras los acontecimientos en el mundo material están estrictamente determinados, la mente humana tiene libre albedrío y es capaz de actuar espontáneamente. Fue esta visión la que estaba implícita en varias cosmovisiones.

En la cosmovisión aristotélico-medieval, casi todos los eventos se consideraron estrictamente determinados, salvo aquellos eventos afectados por el libre albedrío humano o actos divinos. La comunidad aristotelio-medieval creía que todos los fenómenos celestes son estrictamente deterministas, ya que sabían que las posiciones futuras de las estrellas y los planetas eran predecibles. También extendieron esta visión determinista a los fenómenos terrestres, porque el reino celeste ejerció influencia sobre los procesos naturales del reino terrestre. Es decir, los estudiosos medievales sostenían que los procesos terrestres no afectados por el libre albedrío humano también eran deterministas. Sin embargo, también creían que un Dios benevolente había otorgado a los humanos el libre albedrío —una capacidad de actuar espontáneamente y tomar decisiones que no siempre se derivan de los cursos anteriores de los acontecimientos. Aceptaron que muchas acciones y decisiones humanas no eran causadas. Es decir, la concepción del determinismo dualista estaba implícita en la cosmovisión aristotélico-medieval: en el mundo material todos los acontecimientos son deterministas, pero la mente es libre de actuar espontáneamente. Filosóficamente, la concepción del determinismo dualista difiere tanto del determinismo estricto como del indeterminismo en que asume que la causalidad y la espontaneidad pueden existir en diferentes mundos:

Si bien no estaban de acuerdo con los estudiosos aristotélico-medievales en muchos temas metafísicos, tanto cartesianos como newtonianos mantuvieron una perspectiva muy similar sobre los temas de la causalidad: ambas comunidades aceptaron el determinismo dualista, aunque por razones propias. Sus posturas deterministas respecto al mundo material en realidad se derivaron de la universalidad de sus leyes de la física. Por ejemplo, en la física de Newton, si se conoce la disposición actual de los planetas en el sistema solar, uno puede al menos en principio predecir las posiciones de los planetas para cualquier momento dado en el futuro. Lo mismo ocurre con cualquier sistema de materiales, sin importar cuán complejo sea. Si bien puede ser prácticamente imposible para los humanos hacer los cálculos reales y hacer estas predicciones, de acuerdo con las leyes de la física newtoniana el futuro de cualquier sistema material se desprende estrictamente de su pasado. Lo mismo vale para la física cartesiana: las mismas condiciones iniciales siempre producen los mismos efectos. Dicho esto, cartesianos y newtonianos también aceptaron que la mente tiene libre albedrío para tomar decisiones sin causa y, así, perturbar el curso de los acontecimientos, por lo demás determinista. En consecuencia, tanto cartesianos como newtonianos creyeron que el futuro del mundo no era estrictamente determinista siempre y cuando fuera afectado por criaturas con libre albedrío. Así, el determinismo dualista estaba implícito no sólo en la cosmovisión aristotélico-medieval, sino también en las cosmovisiones cartesianas y newtonianas.

Ahora podemos considerar cómo las teorías de la mecánica cuántica y el principio metafísico de la dualidad onda-partícula en la cosmovisión contemporánea afectan las opiniones de los científicos actuales sobre el determinismo. Una pista rápida: no son deterministas dualistas.

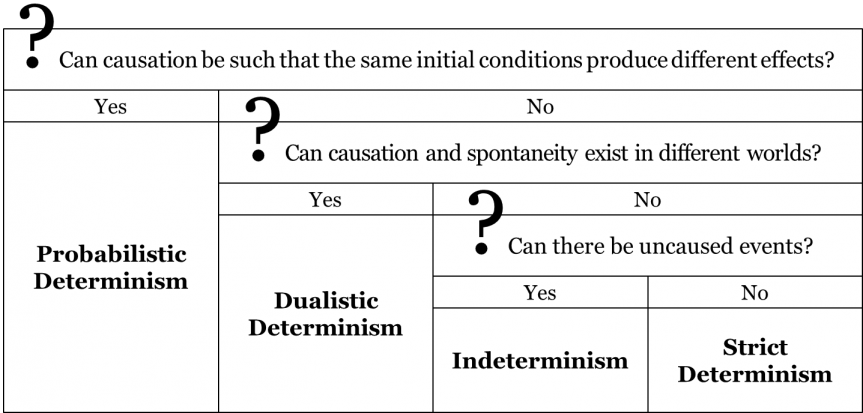

Para comprender mejor la postura de la cosmovisión contemporánea sobre la cuestión de la causalidad, consideremos el proceso de desintegración radiactiva. Hoy en día, los físicos aceptan que existe un 50% de probabilidad de que un átomo de radio se descomponga en radón y helio después de 1600 años. Este periodo de tiempo se conoce como la vida media del radio. Digamos que podríamos aislar mil átomos de radio, colocarlos en un recipiente sellado y volver a abrir el contenedor después de 1600 años. Estadísticamente hablando, es más probable que encontremos alrededor de 500 átomos de radio restantes, mientras que los otros 500 átomos habrán decaído en radón y helio. Lo que observamos aquí es que todos los átomos de radio se colocaron en el mismo contenedor, sin embargo, solo la mitad de ellos se desintegraron mientras que el resto permanecía intacto. El hecho de que las mismas condiciones iniciales puedan conducir a dos resultados distintos sugiere que los procesos fundamentales del mundo probablemente no sean estrictamente deterministas. En cambio, la física cuántica parece sugerir que los procesos fundamentales se determinan probabilísticamente. Esta es la visión del determinismo probabilístico, que está implícito en la cosmovisión contemporánea.

Según el determinismo probabilístico, todos los eventos tienen sus causas, pero las mismas condiciones iniciales pueden producir efectos diferentes.

Todos estos efectos están determinados probabilísticamente, en el sentido de que existe cierta probabilidad de que ocurra un cierto curso de eventos, pero este curso de eventos no está estrictamente determinado por el curso pasado de los acontecimientos. En nuestro ejemplo anterior, existe una probabilidad estadística de descomposición, es decir, hay un 50% de probabilidad de que el radio se descomponga después de 1600 años. Sin embargo, la teoría no indica cuál de los átomos se desintegrará o no en 1600 años. El determinismo probabilístico interpreta esto como una sugerencia de que los eventos futuros están determinados por eventos pasados pero no estrictamente: la naturaleza está limitada a un número limitado de opciones.

Consideremos otro ejemplo, el experimento de doble rendija en física cuántica. Esencialmente, la teoría nos permite predecir la probabilidad con la que un electrón golpeará una determinada región en la pared. Esa probabilidad será mayor en regiones más claras del patrón de difracción, y menor en regiones más oscuras.

Es imposible decir con certeza dónde en la pantalla posterior golpeará un electrón dado después de pasar por las rendijas. Pero hay una alta probabilidad de que golpee en una de las bandas brillantes. Según el determinismo probabilístico, este es otro indicio de que los procesos naturales son causados probabilísticamente más que estrictamente.

Debemos tener cuidado de no confundir el determinismo probabilístico con el determinismo en el determinismo. Si bien ambos conceptos admiten una multiplicidad de resultados siguiendo las mismas condiciones iniciales, existe un claro límite a ese número de resultados bajo determinismo probabilístico. Un indeterminista estaría, técnicamente hablando, abierto a la posibilidad de que después de 1600 años el radio pueda transformarse en una barra de oro, o en una pila de tierra, o Slimer, el fantasma verde viscoso de los Cazafantasmas. Sin embargo, un determinista probabilístico limita el número de efectos potenciales que podrían seguir la misma causa y sugiere que no todo puede suceder: la naturaleza 'elige' de un conjunto limitado de opciones. En otras palabras, según el determinismo probabilístico, no hay un número infinito de posibles resultados dado un cierto conjunto de condiciones iniciales.

Ahora bien, ¿cómo reaccionaría ante esto un determinista estricto? Una reacción natural es sospechar que hay algo deficiente en nuestro conocimiento de las condiciones iniciales. En efecto, cuando se creó la mecánica cuántica en la década de 1920, esta fue precisamente la reacción de algunos físicos famosos, entre ellos Albert Einstein. Si bien Einstein apreció que la mecánica cuántica proporcionaba una gran mejora en nuestra comprensión del mundo de las partículas elementales, también argumentó que la teoría es deficiente ya que no proporciona predicciones precisas de los fenómenos cuánticos. Según Einstein y otros deterministas estrictos, si la mitad de los átomos de radio terminan en descomposición mientras que la otra mitad no, entonces quizás esto se deba a que no partieron de las mismas condiciones iniciales; quizás hubo alguna causa desconocida que lleva a que solo algunos de los átomos del radio se descompongan. Esta es la interpretación del estricto determinista, quien cree que todos los eventos son estrictamente causados por hechos pasados y la naturaleza probabilística de nuestras predicciones es resultado de la falta de conocimiento de nuestra parte. Según deterministas estrictos, debe haber una causa oculta que explique por qué esos 500 átomos particulares terminaron en descomposición. Nuestras teorías pueden ser incapaces de decirnos cuál es esa causa oculta, pero ese es exclusivamente nuestro problema; la naturaleza misma “sabe” a dónde va. En esta visión, futuras investigaciones pueden revelar esa causa oculta y restaurar la imagen estrictamente determinista del mundo. Los deterministas estrictos compararían el caso de la desintegración radiactiva con el de un lanzamiento de monedas. Si tiráramos una moneda mil veces, probablemente la observaríamos aterrizando sobre cabezas aproximadamente la mitad del tiempo. Coloquialmente, podríamos decir que existe una probabilidad 50/50 de que una moneda volteada aterrice sobre la cabeza o la cola. Sin embargo, esto es claramente resultado de nuestro desconocimiento de las condiciones iniciales. Si tuviéramos que medir la posición inicial de la moneda antes de cada lanzamiento así como la fuerza aplicada a la moneda, entonces podríamos predecir con precisión si aterrizará cabeza o cola. Si quisiéramos, podríamos incluso construir un artilugio que pudiera arrojar una moneda de tal manera que aterrizara consistentemente sobre cabezas. Según deterministas estrictos, la situación con la desintegración radiactiva es similar, salvo que no estamos en condiciones de medir las condiciones iniciales con la suficiente precisión para poder predecir el desenlace. No obstante, la naturaleza “conoce” el resultado del proceso de descomposición, así como “sabe” si una moneda caerá en la cabeza o en la cola. En definitiva, deterministas estrictos negarían la idea de que algo se cause probabilísticamente; en su opinión, todo tiene una causa y se desprende de esa causa de manera estricta.

¿Cómo respondería a esto un determinista probabilístico? Los deterministas probabilísticos estarían de acuerdo en que nuestras teorías no son descripciones perfectas del mundo; después de todo, todos somos falibilistas y entendemos que ninguna teoría empírica es perfecta. Pero, ¿es esta razón suficiente para ignorar lo que nos dicen nuestras teorías actuales y en su lugar especular cómo serán nuestras teorías futuras? A falta de una descripción absolutamente correcta del mundo, nuestra mejor apuesta es estudiar detenidamente lo que nuestras teorías actualmente aceptadas nos dicen sobre el mundo. ¿Es concebible que nuestras futuras teorías cuánticas sean estrictamente deterministas y proporcionen predicciones precisas de todos los fenómenos cuánticos? Si somos falibilistas, nuestra respuesta es “sí”: tal escenario es concebible. Pero es igualmente concebible que nuestras teorías futuras sean probabilísticas —no tenemos forma de pronosticar esto. Nuestra mejor opción es dejar de adivinar lo que nuestras teorías futuras pueden o no traernos y enfocarnos en cambio en lo que nuestras teorías actualmente aceptadas tienen que decir sobre el asunto. Así, según deterministas probabilísticos, las implicaciones de nuestra teoría cuántica actual deben tomarse en serio, y el determinismo probabilístico es una de estas implicaciones. En este punto de vista, las predicciones probabilísticas de la teoría cuántica no tienen nada que ver con nuestra falta de conocimiento o nuestro fracaso para predecir el resultado: el proceso es en sí mismo probabilístico. Ya que la teoría nos dice que la desintegración radiactiva no es un proceso estrictamente determinista, entonces así es como deberíamos verlo. Todo lo demás es una especulación sobre lo que el futuro puede tener en la tienda.

Relatividad General y Cosmología

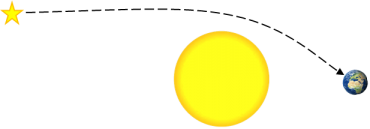

Entonces, entendemos un poco sobre cómo funciona la física a escala cuántica y sus implicaciones para la cosmovisión contemporánea, pero ¿qué pasa con la física a gran escala cosmológica? Para ello, debemos referirnos a la teoría general de la relatividad propuesta por Einstein en 1915. Como aprendimos en el capítulo 1, la teoría de la relatividad general de Einstein postula que los objetos con masa curvan el espacio que los rodea. Esto se aplica a todos los objetos con masa pero se hace especialmente evidente en el caso de objetos más masivos, como la Tierra, el Sol y la Vía Láctea, o los objetos extremadamente comprimidos como los agujeros negros. La curvatura del espacio alrededor de un objeto depende de su masa y su densidad. Es por ello que la curvatura del espacio alrededor de un objeto masivo comprimido a densidad extrema, como la singularidad de un agujero negro, es tal que ni siquiera los rayos de luz pueden escapar. En consecuencia, según la relatividad general, no hay fuerza de gravedad y, por lo tanto, los objetos no se atraen realmente entre sí, sino que simplemente parecen estar atrayéndose unos a otros como resultado de moverse inercialmente en un espacio curvo.

De manera similar, la relatividad general predice que los objetos materiales afectan el tiempo, al hacerlo correr más lento en relación con un reloj en una región menos curvada del espacio-tiempo. Supongamos que tenemos dos relojes sincronizados; mantenemos uno en la superficie de la Tierra, y llevamos al otro a la Estación Espacial Internacional, donde el espacio-tiempo está menos fuertemente curvado que en la superficie de la Tierra. Según la relatividad general, el reloj en la Estación Espacial correrá un poco más rápido que el de la Tierra. Esto se debe a que el tiempo en la Tierra corre un poco más lento debido a la curvatura espacio-temporal del campo gravitacional de la Tierra. En consecuencia, cuando el reloj de la Estación Espacial sea devuelto a la Tierra, mostrará una hora que está ligeramente por delante de la que muestra el de la Tierra. Esta diferencia entre los tiempos transcurridos se conoce como dilatación temporal. En general, cuanto más fuerte es el campo gravitacional del objeto, mayor es la dilatación del tiempo. Por ejemplo, si la Tierra se comprimiera a una mayor densidad o aumentara en masa, el espacio-tiempo estaría más fuertemente curvado en su superficie. Por lo tanto, la diferencia entre los dos relojes sería mayor.

Tanto los efectos del espacio curvo como el efecto de la dilatación temporal han sido confirmados experimentalmente. De la relatividad general de Einstein se deduce que incluso la luz misma se doblará notablemente alrededor de objetos muy masivos. Considera un rayo de luz proveniente de una estrella distante. Según la teoría, debería doblarse ligeramente al pasar por las inmediaciones de objetos masivos. De ello se deduce, por lo tanto, que la misma estrella debería aparecer en un lugar diferente en el espacio cuando la luz que viene de esa estrella pase cerca del Sol.

Para observar este efecto, primero tomamos una foto de esa región específica del espacio por la noche y luego tomamos otra foto de ese mismo fragmento del espacio cuando el Sol está en las inmediaciones. Para tomar esta última foto tendremos que esperar un eclipse solar para asegurarnos de que los rayos de luz del Sol no obstruyan los rayos de luz que vienen de la estrella distante. Según la relatividad general, las estrellas en las inmediaciones del Sol aparecerán ligeramente dispersas del Sol debido a que los rayos de luz provenientes de estas estrellas se doblarán en las inmediaciones del Sol.

El fenómeno de flexión de la luz fue una de las predicciones novedosas de la relatividad general. Así, cuando la cantidad de flexión de luz predicha por la teoría de Einstein fue observada por primera vez por Arthur Eddington en 1919, se consideró una confirmación de la relatividad general. Dado que el método de la época era el método hipotético-deductivo, esto condujo a la aceptación de la relatividad general ca. 1920 y al rechazo de la teoría newtoniana de la gravedad. Desde entonces se han confirmado otras predicciones novedosas de relatividad general. Por ejemplo, el fenómeno de la dilatación del tiempo ha sido confirmado por ligeras diferencias en los tiempos mostrados por un par de relojes precisos en la Tierra y la Estación Espacial. El fenómeno también fue confirmado por el hecho de que los relojes de los satélites GPS funcionan un poco más rápido que los de la Tierra.

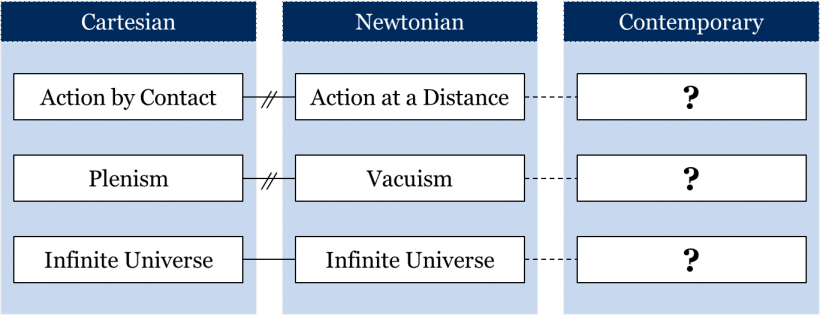

Al igual que con cualquier teoría fundamental, la relatividad general tiene un efecto sobre los principios metafísicos aceptados. Entonces, ¿cómo da forma la relatividad general a nuestros principios metafísicos contemporáneos? Explicar los principios metafísicos implícitos en la cosmovisión contemporánea no siempre es una tarea fácil, ya que nuestras teorías actualmente aceptadas a veces parecen sugerir principios metafísicos contradictorios. El punto aquí no es que los científicos contemporáneos no estén en sintonía con sus propias teorías. Es en cambio que es difícil saber qué principios extraer de nuestras teorías actualmente aceptadas. En lo que sigue vamos a esbozar una serie de preguntas metafísicas a las que no vamos a dar las respuestas contemporáneas. En cambio, mostraremos por qué la extracción de las respuestas a estas preguntas no es una tarea sencilla.

Empecemos por la cuestión del espacio vacío: según la cosmovisión contemporánea, ¿puede haber espacio vacío? Los físicos a veces hablan del 'vacío del espacio exterior' para enfatizar el vacío general del universo. Sin embargo, cuando se presionan, podrían admitir que existen algunos átomos de hidrógeno por cada metro cúbico del espacio exterior, lo que podría interpretarse en sintonía con la concepción del plenismo. Sin embargo, entre los átomos de hidrógeno estaría la nada, lo que significa que parece posible una aproximación muy cercana de un vacío. Por otro lado, las observaciones de la radiación cósmica de fondo de microondas también sugieren que los fotones sobrantes del Big Bang impregnan todo el aparente espacio vacío del universo. Esto parece sugerir que un vacío perfecto en la naturaleza es imposible después de todo. Por otra parte, la relatividad general nos dice que el espacio y el tiempo carecen de una existencia independiente y en cambio constituyen un espacio-tiempo unificado de cuatro dimensiones, que se ve afectado tanto por la materia como por la energía en el universo. La dependencia del espacio-tiempo de la materia y la energía parece sugerir que no puede haber espacio vacío. La mecánica cuántica también implica que no hay espacio vacío. Además de la relación de incertidumbre de posición e impulso mencionada anteriormente, el principio de incertidumbre de Heisenberg implica una relación de incertidumbre de tiempo y energía, lo que significa que cuanto más corto es el intervalo de tiempo que se considera, mayor es la incertidumbre con respecto a la cantidad de energía en una región del espacio . En efecto, en cualquier región del espacio, las llamadas partículas virtuales están constantemente apareciendo y desapareciendo de la existencia. Este fenómeno se conoce como espuma cuántica. Este sorprendente efecto es un fenómeno bien probado, respaldado por muchos experimentos. Quizás, entonces, el plenismo está implícito en la cosmovisión contemporánea. Así, la pregunta es: ¿qué visión metafísica —el vacuismo o el plenismo— está implícita en nuestra cosmovisión contemporánea?

¿Qué pasa con el movimiento en el universo: los objetos se mueven exclusivamente como resultado de la acción por contacto, o la acción a distancia es posible en la cosmovisión contemporánea? Por un lado, aceptamos hoy en día que la velocidad de la luz es la máxima velocidad en el universo. Viajar más rápido que la velocidad de la luz violaría nuestras leyes actuales de la física. Por lo tanto, la física descarta casos especiales de acción a una distancia más rápida que la velocidad de la luz, lo más claramente casos de acción instantánea a distancia. Según la relatividad general incluso los cambios en la curvatura del espacio-tiempo se propagan a la velocidad de la luz. Para apreciar esto, considera que el Sol curva el espacio-tiempo a su alrededor. Los rayos de luz del Sol tardan aproximadamente 8 minutos en llegar a la Tierra. Si, por algún milagro, el Sol desapareciera, tardarían aproximadamente 8 minutos para que los cambios en la curvatura del espacio-tiempo se propagaran y llegaran a la Tierra y cambiaran el movimiento orbital de la Tierra. La Tierra no comenzaría a precipitarse hacia el espacio de inmediato. Si la acción instantánea a distancia es teóricamente imposible, entonces quizás toda la materia se mueve e interactúa a través del contacto real limitado por la velocidad de la luz.

Por otro lado, los físicos que trabajan en la mecánica cuántica nos hablan del enredo cuántico, que —al menos a su valor nominal— parece permitir una acción instantánea a distancia. El enredo cuántico es un fenómeno por el cual un par de partículas a una distancia arbitraria se enreda de tal manera que medir y manipular las propiedades de una partícula en el par provoca que la otra, a cualquier distancia, cambie instantáneamente como resultado. Este fenómeno fue confirmado experimentalmente por primera vez en 1982 por Alain Aspect. Desde entonces, se realizaron numerosos experimentos con diferentes tipos de partículas, con diferentes propiedades de las partículas (por ejemplo, momento, espín, ubicación), así como con distancias variadas entre las partículas enredadas. Cada vez, manipular una partícula cambia instantáneamente a la otra. Estos experimentos con enredo cuántico parecen sugerir que la acción instantánea a distancia es posible, a pesar de las limitaciones impuestas por la velocidad de la luz. Esto está claramente en conflicto con la idea de acción por contacto que se deriva de la relatividad general. Ahora la pregunta es: ¿aceptan los físicos contemporáneos la posibilidad de actuar a distancia, o logran conciliar la aparente acción a distancia de partículas enredadas con la idea de acción por contacto?

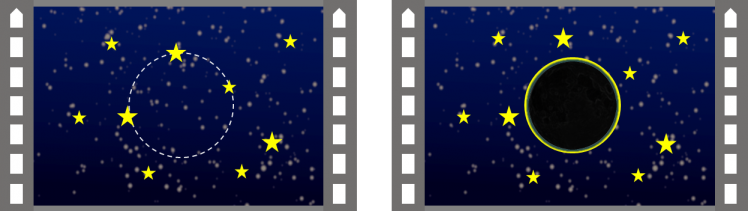

Nuestra pregunta final de esta sección es si el universo es finito o infinito. En lo que respecta a la cuestión relacionada de los límites físicos del universo, la ciencia contemporánea acepta que el universo no tiene límites, es decir, no hay límites físicos para el universo. Pero un universo sin límites todavía puede ser finito si el universo vuelve a girar hacia sí mismo, como el equivalente de cuatro dimensiones de una esfera. Este tipo de universo será ilimitado pero finito. Alternativamente, el universo podría ser ilimitado y extendiéndose infinitamente hacia afuera. Entonces, ¿aceptamos en la cosmovisión contemporánea que el universo es finito o infinito? Responder a esta pregunta en realidad depende de la curvatura real del espacio del universo. Alexander Friedmann sugirió tres modelos del universo, cada uno con su curvatura distinta:

Universo abierto: Un universo abierto tiene una curvatura negativa, es decir, que el espacio-tiempo se curva en dos direcciones diferentes desde un solo punto. Si bien la curvatura de un espacio tridimensional se puede describir matemáticamente con precisión, es difícil (si no imposible) de imaginar. Se vuelve más fácil si pensamos en términos de un análogo bidimensional, en cuyo caso un espacio tridimensional se convierte en una superficie bidimensional. En el caso de un universo abierto esta superficie se curva en una forma como una silla de montar, o un chip Pringle. Dado que el espacio-tiempo nunca volvería a curvarse sobre sí mismo en este tipo de universo, el universo abierto también será un universo infinito.

Universo cerrado: Un universo cerrado tiene una curvatura positiva, lo que significa que el espacio-tiempo se curva en la misma dirección desde cualquier punto del universo. Nuevamente, usando nuestra analogía bidimensional, podemos pensar en un universo cerrado como una superficie con forma de esfera, curvándose en la misma dirección desde cualquier punto. También sería un universo finito, ya que la curva continua eventualmente daría vueltas alrededor de sí misma. Si viajáramos lo suficientemente lejos al espacio en una nave espacial, ¡eventualmente llegaríamos a la Tierra!

Universo plano: Un universo plano tiene, en general, una curvatura cero, lo que significa que el espacio-tiempo se extiende en líneas rectas en todas las direcciones alejadas de cualquier punto único. Podemos pensar en un universo plano con la forma de un trozo de papel plano, o una sábana plana. Tal universo todavía tendría curvas ocasionales aquí y allá alrededor de objetos masivos; sin embargo, sería plano en general. Un universo plano sería un universo infinito, ya que el espacio-tiempo nunca vuelve a curvarse sobre sí mismo.

Los tres modelos del universo son compatibles con la relatividad general. Sin embargo, estos tres modelos del universo proponen distintas geometrías del universo. Ahora bien, ¿cuál de estos modelos describe mejor el espacio de nuestro universo? La respuesta a esta pregunta depende de cuánta masa haya en el universo. Si la masa del universo es mayor que un cierto umbral, entonces el universo se curva sobre sí mismo y es finito; de lo contrario es abierto e infinito.

Una conclusión aquí es que no siempre es fácil extraer los principios metafísicos implícitos en una cosmovisión. A menudo requiere de un análisis meticuloso de las teorías aceptadas en ese mosaico y de las consecuencias que se derivan de estas teorías. Así, la postura de una comunidad hacia una cuestión metafísica puede o no ser fácil de desenterrar. La cuestión del espacio vacío, la cuestión de la acción a distancia y la cuestión del universo finito/infinito son algunas de las cuestiones metafísicas más desafiantes en el contexto de la cosmovisión contemporánea.

La teoría del Big Bang

¿Y el tema de la religión en la cosmovisión contemporánea? Es un tema extraño de sacar a colación mientras se habla de la física de la relatividad especial y general. Pero en cierto sentido, los físicos atravesaron el territorio de los teólogos en el siglo XX cuando intentaron mirar los orígenes del universo. La teoría actualmente aceptada sobre los orígenes del universo se llama la teoría del Big Bang.

A finales del siglo XIX y principios del siglo XX, los astrónomos comenzaron a utilizar un nuevo instrumento para observar objetos celestes llamado espectroscopio. Los espectroscopios miden esencialmente la distribución de las longitudes de onda de la luz que se emite desde un objeto astronómico, lo que permite a los astrónomos determinar ciertas características de una estrella, galaxia u otro cuerpo celeste. Debido a que cada elemento químico tiene su propia “huella” espectral característica, el espectroscopio puede ser utilizado para determinar la composición química de un objeto astronómico. El espectroscopio también puede ser utilizado para determinar si un objeto emisor de luz se aproxima o se aleja del punto de observación (es decir, un telescopio sobre o cerca de la Tierra) por medio del efecto Doppler. Imagine cada fuente de luz que emite pulsos de ondas de luz a intervalos regulares. Imagínese que un objeto se está moviendo hacia el observador. Las ondas de luz de tal objeto aparecerán acortadas en longitud de onda. Las “huellas” espectrales particulares aparecerán a longitudes de onda más cortas de lo esperado. Es decir, serán blueshifted. Por otro lado, si el objeto se aleja del observador, las ondas de luz del objeto se alargarán y las “huellas dactilares” espectrales se desplazarán al rojo. Una razón por la que creemos que la galaxia de Andrómeda está en curso de colisión con nuestra propia galaxia de la Vía Láctea es que las “huellas dactilares” espectrales de sustancias en su espectro son de desplazamiento azul cuando se observan con un espectroscopio.

Sin embargo, la gran mayoría de otras galaxias observadas en el universo por espectroscopio muestran “huellas” espectrales que están corridas al rojo. El astrónomo estadounidense Edwin Hubble demostró, en 1929, que el grado de desplazamiento al rojo de una galaxia es proporcional a su distancia de nosotros. Cada galaxia o cúmulo de galaxias en el universo se está alejando de todos los demás: el universo en su conjunto se está expandiendo. Si el universo se está expandiendo actualmente, entonces teóricamente podemos revertir el tiempo a cuando las galaxias estaban más juntas, y finalmente todo el universo se fusionó en un estado temprano cálido y denso. Según la teoría del Big Bang, el universo evolucionó de un estado temprano tan caliente y denso a su estado actual. En la teoría general de la relatividad de Einstein, fue el espacio mismo el que se expandió. No hubo explosión con la materia expandiéndose hacia un espacio vacío. El estado temprano denso caliente llenó todo el espacio. Si usamos las ecuaciones de la relatividad general para sondear desde el principio, predicen que el espacio, el tiempo, la materia y la energía se fusionan en un punto de densidad infinita y volumen cero, la singularidad. Esta singularidad es así en el centro de un agujero negro, de manera que el Big Bang se asemeja al colapso de una estrella en reversa.

La teoría del Big Bang fue confirmada en 1964 por Robert Wilson y Arno Penzias. Descubrieron la llamada radiación cósmica de fondo de microondas; radiación electromagnética que impregna todo el espacio del universo y se cree que es un remanente de las densas y calientes etapas tempranas del universo que siguen al Big Bang. La detección de esta radiación cósmica de fondo de microondas fue una confirmación de la teoría del Big Bang; la teoría se aceptó poco después.

Al invertir el tiempo a los orígenes del universo, físicos y astrónomos estaban pisando los dedos de los pies de los teólogos que habían relegado la creación del universo a Dios. En respuesta, algunos teólogos razonaron que, aunque Dios no hubiera creado el universo en su estado actual y el universo es en cambio un producto del Big Bang, todavía había espacio para que Dios hubiera iniciado ese Big Bang. Quizás Dios no creó la vida, pero sí inició el proceso que eventualmente conduciría a la creación de la vida, o eso argumentaron. Dado que los teólogos de cosmovisiones anteriores reclamaban autoridad sobre asuntos como los orígenes de la vida y el universo, por lo tanto parecería que incluso con la aceptación de la teoría del Big Bang, el monoteísmo —la creencia de que existe un solo dios, como en las creencias cristiana, judía e islámica— puede seguir siendo un elemento metafísico implícito de la cosmovisión contemporánea para los miembros de las respectivas comunidades.

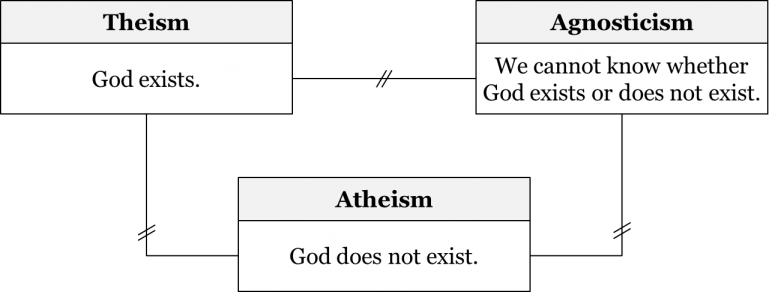

Pero el mosaico contemporáneo no contiene monoteísmo ni ninguna otra concepción teísta (el teísmo es la idea general de que Dios existe; así, el monoteísmo es un subtipo de teísmo). Uno podría luego razonar que hemos rechazado la teología y el monoteísmo de nuestro mosaico actual y lo reemplazamos por ateísmo —la creencia de que Dios no existe. Pero esto, también, actualmente no se acepta. Hoy en día, la idea del agnosticismo está implícita en el mosaico. El agnosticismo es la visión de que no podemos saber si Dios existe o no. Si se les pregunta sobre qué causó el Big Bang, los físicos probablemente responderían que simplemente no sabemos.

Estos físicos pueden estar preocupados por algunas incógnitas importantes en las teorías del universo primitivo. La alta densidad de materia y el espacio-tiempo fuertemente curvado cerca del comienzo del Big Bang solo pueden entenderse adecuadamente utilizando la teoría general de la relatividad de Einstein. Según algunos físicos, la singularidad del Big Bang puede, de hecho, representar un desglose de la teoría. Si la singularidad era efectivamente físicamente real, es un límite de tiempo. Entonces no tendría sentido preguntar qué le precedió, o qué lo causó. Sin embargo, hay razones para dudar de que la relatividad general sea suficiente por sí sola para comprender el universo muy temprano, ya que sus diminutas dimensiones también lo sitúan dentro del ámbito de la mecánica cuántica. La mecánica cuántica y la relatividad general son lógicamente inconsistentes y nunca se han unificado adecuadamente. Se aceptan dentro del mismo mosaico porque la teoría de Einstein se aplica típicamente al reino de lo muy grande, y la mecánica cuántica a la de lo muy pequeño. Las condiciones extremas del Big Bang requieren la aplicación de ambas teorías en conjunto, algo en las fronteras mismas del conocimiento actual. Un mayor avance puede requerir la unificación de las dos teorías en una teoría de la gravedad cuántica, actualmente un objetivo perseguido de la física teórica. Algunos físicos especulan que el Big Bang pudo haber sido un evento cuántico aleatorio, como la aparición de partículas virtuales en la espuma cuántica. Otros argumentan a favor de modelos en los que se eviten las condiciones extremas de la singularidad, y el Big Bang fue causado por el colapso de un universo anterior. Entonces, las mismas objeciones que David Hume planteó a la teología natural de su tiempo (ver capítulo 9) se aplican con igual fuerza a la idea de que Dios causó el Big Bang o “afinó” las propiedades físicas del universo para hacerlas compatibles con nuestra forma de vida.

Hay otra razón por la que los físicos y astrónomos modernos pueden ser profundamente reacios a aceptar conclusiones teológicas con respecto al Big Bang. La búsqueda de signos de otros seres inteligentes en el cosmos es un objetivo perseguido de la astronomía moderna. Cualquier reclamo de tal inteligencia debe cumplir con los criterios del método empleado contemporáneo resumido por la máxima del astrónomo Carl Sagan de que “las afirmaciones extraordinarias exigen pruebas extraordinarias”. Esta búsqueda ha ocasionado una serie de falsas alarmas —cada una es una ilustración de la preocupación de David Hume de que fenómenos naturales desconocidos puedan confundirse fácilmente con los artefactos diseñados de una poderosa inteligencia. Por el método empleado actualmente para evaluar hipótesis relativas a la inteligencia extraterrestre, no se aceptaría ninguna afirmación de que un fenómeno cósmico fuera diseñado por una inteligencia no humana a menos que se descartaran primero todas las explicaciones plausibles que involucran fenómenos naturales no inteligentes. En el caso de las afirmaciones teológicas sobre el Big Bang, la discusión anterior ilustra por qué es poco probable que físicos y astrónomos, como comunidad, crean que se han cumplido los estándares de este método.

Las preguntas de lo que sucedió antes del Big Bang son, en el mejor de los casos, consideradas como altamente especulativas por los científicos contemporáneos. Un fuerte indicio de esta reticencia entre los científicos hacia las cuestiones religiosas sería mirar a los ganadores exitosos de subvenciones en las ciencias duras y reconocer que los tipos de preguntas que están tratando de responder no tienen nada que ver con Dios y el papel de Dios en el universo. Si bien los científicos individuales tienen visiones religiosas variadas, la visión aceptada de la comunidad científica parece ser una visión de agnosticismo sobre la existencia de Dios. Dios puede o no haber jugado un papel en los orígenes del universo, pero esta es una cuestión incontestable por nuestro mosaico actual, así que simplemente declaramos que no sabemos.

Responder exactamente cómo y cuándo la teología fue exiliada del mosaico es bastante difícil. ¿Fue con la observación del corrimiento al rojo y posterior aceptación de la teoría del Big Bang? ¿Fue consecuencia de los desarrollos de la biología evolutiva lo que eliminó de manera similar el papel de Dios en la creación de la humanidad? ¿Fue la crítica de David Hume a la teología natural el factor crítico? En este punto, simplemente no lo sabemos. Baste decir, si bien el monoteísmo estaba implícito en las cosmovisiones aristotélico-medieval, cartesiana y newtoniana, el agnosticismo está implícito en la cosmovisión contemporánea.

Métodos Contemporáneos

¿Cuáles son los métodos empleados en la cosmovisión contemporánea? En lo que respecta a los requisitos fundamentales de la ciencia empírica, no ha cambiado mucho desde la cosmovisión newtoniana. Los científicos contemporáneos que trabajan en las ciencias empíricas continúan empleando el método hipotético-deductivo (HD). Entonces, para llegar a ser aceptada, generalmente se espera que una teoría empírica proporcione una predicción novedosa confirmada (si sucede que introduce cambios en la ontología aceptada) o bien sea suficientemente precisa y precisa (en todos los demás casos).

Es importante señalar que esto no quiere decir que no haya habido cambios en los métodos desde el siglo XVIII. De hecho, desde entonces se han empleado muchos métodos más concretos; cada uno de estos métodos se basa en los requisitos generales del método HD. Un ejemplo obvio son los diferentes métodos de prueba de drogas que consideramos en el capítulo 4: todos ellos fueron implementaciones más específicas de los requisitos del método HD. Por ejemplo, el método de ensayo doble ciego tiene los mismos requisitos que el método de la EH más algunos requisitos adicionales: que el efecto del medicamento se confirme en un ensayo doble ciego. En términos generales, existen muchos métodos concretos, que imponen requisitos adicionales además de los estipulados por el método HD.

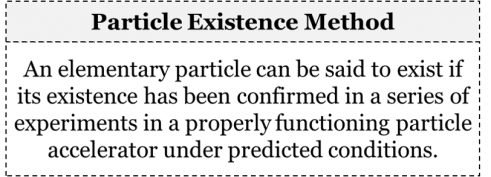

Consideremos, por ejemplo, nuestros requerimientos contemporáneos en cuanto a la aceptabilidad de nuevas partículas elementales. Supongamos que hay una nueva teoría que plantea la hipótesis de la existencia de un nuevo tipo de partícula. ¿Bajo qué circunstancias estaríamos preparados para aceptar la existencia de esa hipotética partícula? Probablemente esperaríamos que la hipótesis se pusiera a prueba tal como lo estipula el método HD. Sin embargo, probablemente esperaríamos algo aún más específico, es decir, esperaríamos que la partícula se observara en una serie de experimentos en un acelerador de partículas que funcione correctamente en condiciones predichas. Así, podríamos decir que nuestro método de existencia de partículas puede explicarse siguiendo estas líneas:

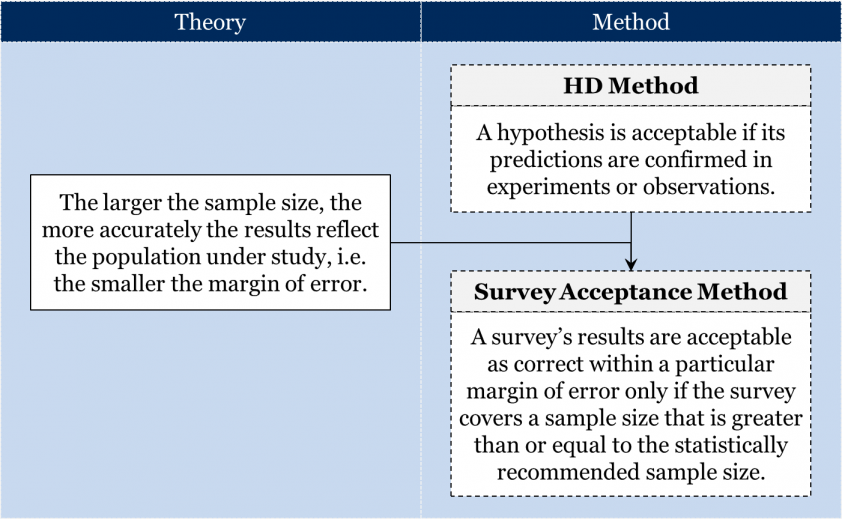

Considera otro ejemplo. Supongamos que existe una hipótesis sociológica que propone una cierta correlación entre el tamaño de la familia y el consumo de medios: digamos, que las familias más grandes dedican menos tiempo a consumir contenido mediático que las más pequeñas. Nótese que esto no es proponer una relación causal entre el tamaño de la familia y el tiempo de consumo de medios, sino meramente sugerir una correlación. Ahora bien, ¿cómo evaluaríamos esta hipótesis? Probablemente esperaríamos que se confirmara mediante una adecuada encuesta sociológica de una muestra poblacional adecuadamente seleccionada. Es claro que no esperaríamos que se encuestara al 100% de la población; eso no es factible. En cambio, esperaríamos que la encuesta abarcara cierta muestra menor de la población. Pero, ¿qué tan pequeño puede ser el tamaño de la muestra sin que los resultados de la encuesta sean inaceptables? Aquí es donde entra en juego nuestro conocimiento de la teoría de la probabilidad y la estadística. De acuerdo con la teoría de la probabilidad, si una muestra se selecciona aleatoriamente, entonces un tamaño de muestra mayor normalmente da como resultado una encuesta más precisa. Por lo tanto, cada encuesta de este tipo tendrá necesariamente un cierto margen de error, el rango de valores dentro del cual se puede decir que la cifra refleja correctamente el estado real de las cosas. Cuanto mayor sea el tamaño de la muestra, menor será el margen de error. Existen ecuaciones estadísticas que permiten calcular el margen de error dado el tamaño de la población y el tamaño de la muestra. Por ejemplo, si estudiáramos la relación entre el tamaño de la familia y el consumo de medios en todo Canadá con su población de alrededor de 37 millones de personas, entonces un tamaño de muestra de 1,500 tendría un margen de error de 2.53%. En definitiva, aceptaríamos los resultados de una encuesta sociológica como correctos dentro de un determinado margen de error solo si la encuesta cubriera un tamaño muestral mayor o igual al tamaño muestral estadísticamente recomendado.

Además del método HD, la ciencia contemporánea también parece emplear el método axiomático-deductivo. Según este método, una proposición es aceptable ya sea si es un axioma de una teoría o si es un teorema que lógicamente se desprende de los axiomas aceptados. Este es el método empleado actualmente en las ciencias formales, como las matemáticas o la lógica. Cada teoría matemática postula un conjunto de axiomas que definen la estructura matemática en estudio para luego proceder a deducir todo tipo de teoremas sobre estas estructuras. Recordemos, por ejemplo, los axiomas de distintas geometrías del capítulo 2 que proporcionaban distintas definiciones de “triángulo”. En cada una de estas diferentes geometrías, todos los teoremas sobre triángulos siguen lógicamente de los respectivos axiomas.

Este método suena similar al método intuitivo-deductivo, y de hecho lo es: después de todo, ambos métodos requieren que los teoremas sean consecuencias deductivas de los axiomas aceptados. Pero una diferencia clave es que el método de la intuición requiere que los axiomas sean intuitivamente ciertos, mientras que el método axiomático-deductivo no lo requiere. El método axiomático-deductivo considera que los axiomas son meramente definiendo el objeto formal en estudio independientemente de que aparezcan intuitivamente verdaderos o contradictorios.

En resumen, es importante tener en cuenta que puede haber muchos métodos diferentes en diferentes campos de investigación. Algunos métodos pueden ser muy generales y aplicables a una amplia gama de fenómenos (por ejemplo, el método HD, el método axiomático-deductivo), mientras que otros métodos pueden ser aplicables solo a un conjunto muy específico de fenómenos (por ejemplo, métodos de prueba de drogas). En todo caso, estos métodos serán las consecuencias deductivas de nuestras teorías aceptadas.

Resumen

La siguiente tabla resume algunos de los principios metafísicos de la cosmovisión contemporánea:

También hemos dejado algunos interrogantes aquí y allá:

Esto concluye nuestra discusión sobre nuestras cuatro instantáneas de la historia de la ciencia.