4.8: Resolviendo Sistemas Lineales de Ecuaciones

- Page ID

- 82446

Ahora estamos equipados para configurar sistemas de ecuaciones lineales como ecuaciones matriz-vectoriales para que puedan resolverse de manera estándar en una computadora. Supongamos que queremos resolver las ecuaciones del Ejemplo 1 de “Álgebra Lineal: Introducción” para\(x_1\) y\(x_2\) usando una computadora. Recordemos que las Ecuaciones 1 y 2 del Álgebra Lineal: Introducción son

\[x_{1}+x_{2}=85 \nonumber \]

\[\frac{x_{1}}{1.2}=\frac{x_{2}}{1.5-1.2} \nonumber \]

El primer paso es organizar cada ecuación con todas las referencias a\(x_1\) en la primera columna, todas las referencias a\(x_2\) en la segunda columna, etc., y todas las constantes en el lado derecho:

\ (\ comenzar {reunido}

x_ {1} +x_ {2} =85\\

0.3 x_ {1} -1.2 x_ {2} =0

\ end {reunido}\)

Entonces las ecuaciones se pueden convertir en una sola ecuación matriz-vector. Los coeficientes forman una matriz, manteniendo sus mismas posiciones relativas, y las variables y constantes forman cada una un vector:

\ [\ left [\ begin {array} {ll}

1 & 1\\

0.3 & -1.2

\ end {array}\ right]\ left [\ begin {array} {l}

x_ {1}\\

x_ {2}

\ end {array}\ right] =\ left [\ begin {array} {l}

85\\

0

\ end {array}\ derecha] \ nonumber\]

Verificar por las reglas de multiplicación matricial que el sistema de ecuaciones en 2 sea equivalente a la ecuación matricial en 3.

La ecuación 3 es de la forma general

\[A x=b \nonumber \]

donde en este caso

\ [\ mathrm {A} =\ left [\ begin {array} {ll}

1 & 1\\

0.3 & -1.2

\ end {array}\ right],\ mathrm {x} =\ left [\ begin {array} {l}

x_ {1}\\

x_ {2}

\ end {array}\ derecha],\ mathrm {b} =\ left [\ begin {array} {l}

85\\

0

\ end {array}\ right]. \ nonumber\]

Dado cualquiera\(A \in \mathscr{R}^{n \times n}\) y\(\mathrm{b} \in \mathscr{R}^{n}\), MATLAB puede resolver la Ecuación 4 para\(x\) (siempre y cuando exista una solución). Las ideas clave en el proceso de solución son la matriz de identidad y la inversa de una matriz.

Cuando la matriz A es la matriz 1×1\(a\), el vector\(x\) es el vector l\(x\), y el vector\(b\) es el vector l\(b\), entonces la ecuación matricial\(Ax=b\) se convierte en la ecuación escalar

\[a x=b \text { . } \nonumber \]

El escalar\(a^{−1}\) es el inverso del escalar aa, por lo que podemos multiplicar en ambos lados de la Ecuación 6 para obtener el resultado

\(a^{-1}(a x)=a^{-1} b\)

\[1 x=a^{-1} b \nonumber \]

Nos gustaría generalizar esta idea simple a la ecuación matricial para que\(Ax=b\) podamos encontrar una inversa de la matriz\(A\), llamada\(A^{−1}\), y escribir

\(\mathrm{A}^{-1}(A x)=\mathrm{A}^{-1} \mathrm{~b}\)

\[I x=\mathrm{A}^{-1} \mathrm{~b} \nonumber \]

En esta ecuación la matriz\(I\) es la matriz de identidad

\ [\ mathrm {I} =\ left [\ begin {array} {ccccc}

1 & 0 & 0 &\ ldots & 0\\\

0 & 1 & 0 &\ ldots & 0\\ ldots &

0\\ ldots & 0\\ vdots &

\ vdots &\ vdots &\ vdots &\ ddots &\ vdots &\ vdots\\

0 & amp; 0 &\ ldots & 1

\ end {array}\ derecha]\ nonumber\]

Es claro que la matriz de identidad\(I\) y la inversa de una matriz,\(A^{−1}\), juegan un papel clave en la solución de ecuaciones lineales. Vamos a estudiarlos con más detalle.

La identidad matricial

Cuando multiplicamos un escalar por 1, recuperamos ese mismo escalar. Por esta razón, al número 1 se le llama el elemento de identidad multiplicativa. Esto puede parecer trivial, pero la generalización a matrices es más interesante. La pregunta es, ¿existe una matriz que, cuando multiplica otra matriz, no cambia la otra matriz? La respuesta es sí. La matriz se llama la matriz de identidad y se denota por\(I\). La matriz de identidad siempre es cuadrada, con cualquier tamaño que sea apropiado para la multiplicación de la matriz. La matriz de identidad tiene 1 en su diagonal principal y 0 en todas partes. Por ejemplo,

\ [I_ {5} =\ left [\ begin {array} {lllll}

1 & 0 & 0 & 0 & 0 &

0 & 0 & 0 & 0 & 0 & 0\\

0 & 0 & 0 & 1 & 0 &

0 & 0 & 0 & 0 & 0 & 0 &

0 & 0 & 0 & 0 & 1

\ end { array}\ derecha]\ texto {.}\ nonumber\]

El subíndice 5 indica el tamaño. En términos de los vectores de coordenadas unitarias\(e_i\), también podemos escribir la matriz de\(n×n\) identidad como

\ [\ mathrm {I} _ {n} =\ left [\ begin {array} {cccc}

\ mid &\ mid & & & 1\\

\ mathrm {e} _ {1} _ {1} &\ mathrm {e} _ {2} &\ ldots &\ mathrm {e} _ {n}

\\ mediados &\ mediados &\ mediados &

\ end {array}\ derecho]\ nonumber\]

Para cualquier matriz\(A \in \mathscr{R}^{n \times n}\), tenemos

\[\mathrm{A}=\mathrm{I}_{n} \mathrm{~A} \nonumber \]

Para\(p=1\), obtenemos la siguiente forma especial para cualquier vector\(\mathrm{x} \in \mathscr{R}^{n}\):

\[\mathrm{x}=\mathrm{I}_{n} \mathrm{x} \nonumber \]

Esta última ecuación se puede escribir como la suma

\[\mathrm{x}=\sum_{i=1}^{n} x_{i} \mathrm{e}_{i} \nonumber \]

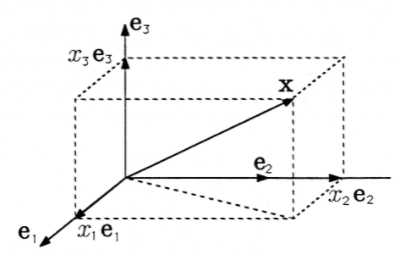

Este es un caso especial de uno de los resultados que probaste en el Ejercicio 3 de “Álgebra Lineal: Matrices”. La Figura 1 ilustra la Ecuación 14 y muestra cómo el vector\(x\) puede dividirse en vectores componentes\(x_ie_i\), cada uno de los cuales se encuentra en la dirección de un eje de coordenadas. Los valores de los\(x_i\)'s son las coordenadas de\(x\), y sus magnitudes son también las longitudes de los vectores componentes.

Usa la Ecuación 13 y las reglas para la multiplicación matricial para mostrar que también se\(\mathrm{x} \in \mathscr{R}^{n}\) puede escribir como

\[\mathrm{x}=\sum_{i=1}^{n}\left(\mathrm{x}, \mathrm{e}_{i}\right) \mathrm{e}_{i} \nonumber \]

Esto verifica la Ecuación 11 a partir de “Álgebra Lineal: Cosenos de Dirección”.

Cuando el producto de dos números es 1 (el elemento de identidad), decimos que son inversos el uno del otro, como 2 y 0.5. Así mismo, decimos que dos matrices cuadradas son inversas entre sí si su producto es la matriz de identidad:

\[A B=\mathrm{I} \Leftrightarrow \mathrm{B}=\mathrm{A}^{-1} \nonumber \]

Un resultado interesante y útil está implícito en esta definición. Toma la primera forma de la Ecuación 16 y multiplica por\(B\) desde la izquierda:

\ [\ begin {align}

A B &=\ mathrm {I}\ nonumber\\

\ Rightarrow B (A B) &=\ mathrm {BI}\ nonumber\\ nonumber

\\ Rightarrow (B A) B&=\ mathrm {B}\ nonumber

\\ Rightarrow\ quad B A&=\ mathrm {I}

\ end {align}\ nonumber\]

Destacamos que la inferencia que se hace en el último paso aquí sólo es válida cuando\(B\) y\(A\) son matrices cuadradas. El resultado significa que, aunque la multiplicación matricial no sea conmutativa en general, tenemos un caso especial donde es conmutativa. Si\(A\) y\(B\) son inversos el uno del otro, entonces

\[A B=\mathrm{BA}=\mathrm{I} \nonumber \]

Demostrar que la inversa de la matriz de rotación 2x2\(R(\theta)\) es\(R^T(\theta)\).

Las matrices que no son cuadradas no tienen inversas. De hecho, no todas las matrices cuadradas tienen inversas. Por lo que se convierte en un tema importante determinar qué matrices sí tienen inversas. Si una matriz tiene una inversa, la inversa es única. Si una matriz cuadrada no tiene inversa, se llama matriz singular. El determinante de una matriz cuadrada es un escalar calculado a partir de los números en la matriz. Nos dice si una matriz tendrá una inversa o no. Una matriz es singular si y sólo si su determinante es cero. 1 En MATLAB, la notación det (A) se utiliza para calcular el determinante. Siempre que la matriz A en la Ecuación 4 es singular, significa una de dos cosas sobre el sistema de ecuaciones representado: o las ecuaciones son inconsistentes y no hay solución, o las ecuaciones son dependientes y hay infinitamente muchas soluciones.

Resolviendo

\(Ax = b\). Estudiemos ahora formas de resolver la ecuación matricial\(Ax=b\). Asumiremos que\(x\) existe una solución única para. Así\(A^{−1}\) existe una matriz única con la propiedad\(A^{−1}A=I\). El truco es encontrarla. Aquí hay un procedimiento.

Para mayor comodidad, reescriba la ecuación de la matriz\(Ax =b\) como

\ [[A b]\ left [\ begin {array} {l}

x\\

-1

\ end {array}\ right] =0\ nonumber\]

La matriz\([A b] \in \mathscr{R}^{n \mathrm{X}(n+1)}\) se denomina matriz aumentada para el sistema de ecuaciones. La matriz aumentada puede ser vista como una forma sistemática de escribir toda la información necesaria para resolver las ecuaciones.

La ventaja de la Ecuación 19 es que podemos premultiplicar ambos lados por cualquier matriz\(C_1\) (de tamaño compatible), y el lado derecho permanece cero (aunque esto equivale a multiplicar en ambos lados de la Ecuación 4, que algunos pueden preferir). Podemos repetir esta operación tantas veces como queramos con matrices\(C_2\)\(C_3\), etc. El resultado general es

\ [\ left [\ mathrm {C} _ {m}\ cdots\ mathrm {C} _ {2}\ mathrm {C} _ {1}\ mathrm {AC} _ {m}\ cdots\ mathrm {C} _ {2}\ mathrm {C} _ {1}\ mathrm {~b}\ derecha]\ izquierda [\ comenzar {matriz} {l}

\ mathrm rm {x}\\

-1

\ end {array}\ derecha] =0\ nonumber\]

Ahora supongamos que hemos encontrado una secuencia de matrices\(C_1\),...,\(C_m\) que transforma la matriz en\(A\) la matriz de identidad:

\(C_m \cdots C_2C_1A=I\). La ecuación matricial aumentada en 20 simplifica a

\ [\ left [I\ mathrm {C} _ {m}\ cdots\ mathrm {C} _ {2}\ mathrm {C} _ _ {1}\ mathrm {~b}\ derecha]\ left [\ begin {array} {l}

\ mathrm {x}\\

-1

\ end {array}\ derecha] =0\ nonumber\]

que se puede multiplicar para revelar que la solución para\(x\)

\[\mathrm{x}=\mathrm{C}_{m} \cdots \mathrm{C}_{2} \mathrm{C}_{1} \mathrm{~b} \nonumber \]

El método puede resumirse de la siguiente manera:

- formar la matriz aumentada\([Ab]\) para el sistema;

- premultiplicar\([Ab]\) por una secuencia de matrices seleccionadas\(C_i\), diseñadas para llevar\(A\) a\(I\); y

- cuando\(A\) se transforma a\(I\), se\(b\) transformará a\(x\), por lo que la solución aparecerá como la última columna de la matriz aumentada transformada.

También podemos concluir que el producto de las matrices\(C_i\) debe ser el inverso de A ya que\(A^{−1}\) es la matriz única para la cual\(A^{−1}A=I\). Al resolver\(x\) por este método, hemos encontrado\(A^{−1}\) implícitamente como el producto\(C_m \cdots C_2C_1\).

Considera la ecuación

\ (\ left [\ begin {array} {ll}

3 & 1\\

2 & 4

\ end {array}\ right]\ quad\ left [\ begin {array} {l}

x_ {1}\\

x_ {2}

\ end {array}\ right] =\ left [\ begin {array} {l}

6\\

5

\ end {array}\ right]\ )

\(Ax = b\)

La matriz aumentada para esta ecuación es

\ (\ left [\ begin {array} {ll}

A & b

\ end {array}\ right] =\ left [\ begin {array} {lll}

3 & 1 & 6\\

2 & 4 & 5

\ end {array}\ right]\)

Ahora bien, si pudiéramos sumar −2/3 veces la primera fila a la segunda fila, obtendríamos 0 en la esquina inferior izquierda. Este es el primer paso para transformar A en la identidad I. Podemos lograr esta operación de fila con la matriz

\ (\ mathrm {C} _ {1} =\ left [\ begin {array} {ll}

1 & 0\\

-2/3 & 1

\ end {array}\ right]\)

\ (\ mathrm {C} _ _ {1}\ left [\ begin {array} {ll}

A & b

\ end {array}\ right] =\ left [\ begin {array} {lll}

3 & 1 & 6\\

0 & 10/3 & 1

\ end {array}\ right]\)

Ahora añadiendo −3/10 veces la nueva segunda fila a la primera fila introducirá 0 en la posición (1,2), acercándonos aún más a la identidad. Así

\ (C_ {2} =\ left [\ begin {array} {ll}

1 & -3/10\\

0 & 1

\ end {array}\ right]\)

\ (\ mathrm {C} _ _ {2}\ mathrm {C} _ _ {1}\ quad\ left [\ begin {array} {lll}

A & b

\ end {array}\ right] =\ left [\ begin {array} {lll}

3 & 0 & 57/10\\

0 & 10/3 & 1

\ end {array}\ right]\)

Ahora completamos la transformación a identidad normalizando cada fila para obtener las l necesarias:

\ (\ mathrm {C} _ {3} =\ left [\ begin {array} {ll}

1/3 & 0\\

0 & 3/10

\ end {array}\ derecha]\)

\ (\ mathrm {C} _ _ {3}\ mathrm {C} _ {2}\ mathrm {C} _ {1}\ quad\ left [\ begin {array} {ll}

A &\ mathrm {~b}

\ end {array}\ right] =\ left [\ begin {array} {lll}

1 & 0 & 19/10\

0 & 1 & 3/10

\ end {array}\ derecho]\)

Según la última columna, la solución es

\ (\ mathrm {x} =\ left [\ begin {array} {l}

19/10\\

3/10

\ end {array}\ right]\)

Observamos de pasada que la inversa de\(A\) es el producto de las C′s, por lo que

\ (\ begin {alineado}

\ mathrm {A} ^ {-1} =\ mathrm {C} _ {3}\ mathrm {C} _ {2}\ mathrm {C} _ {1} &=\ qquad\ izquierda [\ begin {array} {ll}

1/3 & 0\\

0 & 3/10

\ end {array}\ derecha]\ izquierda [\ begin {array} {ll}

1 y -3/10\\

0 y 1

\ end {array}\ right]\ left [\ begin {array} {ll}

1 & 0\\

-2/3 & 1

\ end {array}\ right]\\

&=\ left [\ begin {array} {ll}

1/3 & -1/10\

0 & 3/10

\ end {array}\ right]\ left [\ left [\ begin {array} {ll}

1 & 0\\

-2/3 & 1

\ end {array}\ right] =\ left [\ begin {array} {ll}

2/5 & -1/10\\

-1/5 & 3/10

\ end {array}\ right].

\ end {alineado}\)

El método que acabamos de utilizar, combinado con una forma particular de elegir las\(C_i\) matrices, se llama eliminación de Gauss. La eliminación de Gauss requiere menos cómputos que encontrar la inversa de A porque solo\(b\) se calcula el efecto de\(A^{−1}\) sobre el vector específico. MATLAB puede resolver\(x\) por cualquiera de los dos métodos, como se muestra en Demo 4.2. Para los cálculos manuales, sugerimos elegir las\(C_i\) matrices de manera que\(C_1\) produzca O′s en todas partes por debajo de la diagonal en la primera columna,\(C_2\) produzca O′s por debajo de la diagonal en la segunda columna, y así sucesivamente hasta\(C_{n−1}\). Entonces\(C_n\) produce O′s por encima de la diagonal en la\(n^{th}\) columna,\(C_{n+1}\) produce O′s por encima de la diagonal en columna\(n−1\), etc. el último,\(C_{2n−1}\), normaliza los elementos diagonales a l's. Hemos asumido por simplicidad que no se encontrarán O′s en la diagonal en los cálculos manuales.

Compruébalo\(A^{−1}A=I\) en el Ejemplo 1.

Aumente la Ecuación 3 como en la Ecuación 19 y utilice la técnica de eliminación de Gauss para resolver para\(x\).

Demostración 1 (MATLAB)

Desde el nivel de comando de MATLAB, resuelva la ecuación matricial del Ejemplo 1 a partir de “Álgebra lineal: Introducción” escribiendo

>> A = [1 1; 0.3 - 1.2] >> b = [85;0]

Usted ha ingresado a las matrices\(A\) y\(b\), que describen el problema. Ahora puedes resolver\(x\) por encontrando la inversa de\(A\) y multiplicando\(b\):

>> x = inv(A) * b

En este ejemplo la inversa se calcula rápidamente porque\(A\) es una matriz pequeña. Para una matriz grande (digamos, 30×30), la respuesta tardaría más en calcularse, y el método más eficiente de eliminación de Gauss reduciría el tiempo de espera. Puedes usar la eliminación de Gauss en MATLAB escribiendo

>> x = A \ b

Deberías obtener la misma respuesta. Ahora escriba el código MATLAB requerido para calcular\(Ax\) y mostrar\(Ax−b=0\).

(MATLAB) Escribe el siguiente sistema de ecuaciones como\(Ax=b\) y resuelve usando MATLAB:

\ (\ begin {reunió}

3\ izquierda (x_ {1} -x_ {3}\ derecha) +2\ izquierda (x_ {2} -1\ derecha) -6=x_ {3}\\

4 x_ {3} =7 x_ {2} -5\\

6\ izquierda (x_ {1} +x_ {2} +2\ derecha) =x_ {3} +1.

\ end {reunido}\)

Notas al pie

- Ahora no es importante entender cómo se define y calcula el determinante a partir de los elementos de una matriz. En tus cursos más avanzados estudiarás el determinante con cierto detalle.