8.4: Audiencia

- Page ID

- 144001

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\( \newcommand{\dsum}{\displaystyle\sum\limits} \)

\( \newcommand{\dint}{\displaystyle\int\limits} \)

\( \newcommand{\dlim}{\displaystyle\lim\limits} \)

\( \newcommand{\id}{\mathrm{id}}\) \( \newcommand{\Span}{\mathrm{span}}\)

( \newcommand{\kernel}{\mathrm{null}\,}\) \( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\) \( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\) \( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\id}{\mathrm{id}}\)

\( \newcommand{\Span}{\mathrm{span}}\)

\( \newcommand{\kernel}{\mathrm{null}\,}\)

\( \newcommand{\range}{\mathrm{range}\,}\)

\( \newcommand{\RealPart}{\mathrm{Re}}\)

\( \newcommand{\ImaginaryPart}{\mathrm{Im}}\)

\( \newcommand{\Argument}{\mathrm{Arg}}\)

\( \newcommand{\norm}[1]{\| #1 \|}\)

\( \newcommand{\inner}[2]{\langle #1, #2 \rangle}\)

\( \newcommand{\Span}{\mathrm{span}}\) \( \newcommand{\AA}{\unicode[.8,0]{x212B}}\)

\( \newcommand{\vectorA}[1]{\vec{#1}} % arrow\)

\( \newcommand{\vectorAt}[1]{\vec{\text{#1}}} % arrow\)

\( \newcommand{\vectorB}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\( \newcommand{\vectorC}[1]{\textbf{#1}} \)

\( \newcommand{\vectorD}[1]{\overrightarrow{#1}} \)

\( \newcommand{\vectorDt}[1]{\overrightarrow{\text{#1}}} \)

\( \newcommand{\vectE}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash{\mathbf {#1}}}} \)

\( \newcommand{\vecs}[1]{\overset { \scriptstyle \rightharpoonup} {\mathbf{#1}} } \)

\(\newcommand{\longvect}{\overrightarrow}\)

\( \newcommand{\vecd}[1]{\overset{-\!-\!\rightharpoonup}{\vphantom{a}\smash {#1}}} \)

\(\newcommand{\avec}{\mathbf a}\) \(\newcommand{\bvec}{\mathbf b}\) \(\newcommand{\cvec}{\mathbf c}\) \(\newcommand{\dvec}{\mathbf d}\) \(\newcommand{\dtil}{\widetilde{\mathbf d}}\) \(\newcommand{\evec}{\mathbf e}\) \(\newcommand{\fvec}{\mathbf f}\) \(\newcommand{\nvec}{\mathbf n}\) \(\newcommand{\pvec}{\mathbf p}\) \(\newcommand{\qvec}{\mathbf q}\) \(\newcommand{\svec}{\mathbf s}\) \(\newcommand{\tvec}{\mathbf t}\) \(\newcommand{\uvec}{\mathbf u}\) \(\newcommand{\vvec}{\mathbf v}\) \(\newcommand{\wvec}{\mathbf w}\) \(\newcommand{\xvec}{\mathbf x}\) \(\newcommand{\yvec}{\mathbf y}\) \(\newcommand{\zvec}{\mathbf z}\) \(\newcommand{\rvec}{\mathbf r}\) \(\newcommand{\mvec}{\mathbf m}\) \(\newcommand{\zerovec}{\mathbf 0}\) \(\newcommand{\onevec}{\mathbf 1}\) \(\newcommand{\real}{\mathbb R}\) \(\newcommand{\twovec}[2]{\left[\begin{array}{r}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\ctwovec}[2]{\left[\begin{array}{c}#1 \\ #2 \end{array}\right]}\) \(\newcommand{\threevec}[3]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\cthreevec}[3]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \end{array}\right]}\) \(\newcommand{\fourvec}[4]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\cfourvec}[4]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \end{array}\right]}\) \(\newcommand{\fivevec}[5]{\left[\begin{array}{r}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\cfivevec}[5]{\left[\begin{array}{c}#1 \\ #2 \\ #3 \\ #4 \\ #5 \\ \end{array}\right]}\) \(\newcommand{\mattwo}[4]{\left[\begin{array}{rr}#1 \amp #2 \\ #3 \amp #4 \\ \end{array}\right]}\) \(\newcommand{\laspan}[1]{\text{Span}\{#1\}}\) \(\newcommand{\bcal}{\cal B}\) \(\newcommand{\ccal}{\cal C}\) \(\newcommand{\scal}{\cal S}\) \(\newcommand{\wcal}{\cal W}\) \(\newcommand{\ecal}{\cal E}\) \(\newcommand{\coords}[2]{\left\{#1\right\}_{#2}}\) \(\newcommand{\gray}[1]{\color{gray}{#1}}\) \(\newcommand{\lgray}[1]{\color{lightgray}{#1}}\) \(\newcommand{\rank}{\operatorname{rank}}\) \(\newcommand{\row}{\text{Row}}\) \(\newcommand{\col}{\text{Col}}\) \(\renewcommand{\row}{\text{Row}}\) \(\newcommand{\nul}{\text{Nul}}\) \(\newcommand{\var}{\text{Var}}\) \(\newcommand{\corr}{\text{corr}}\) \(\newcommand{\len}[1]{\left|#1\right|}\) \(\newcommand{\bbar}{\overline{\bvec}}\) \(\newcommand{\bhat}{\widehat{\bvec}}\) \(\newcommand{\bperp}{\bvec^\perp}\) \(\newcommand{\xhat}{\widehat{\xvec}}\) \(\newcommand{\vhat}{\widehat{\vvec}}\) \(\newcommand{\uhat}{\widehat{\uvec}}\) \(\newcommand{\what}{\widehat{\wvec}}\) \(\newcommand{\Sighat}{\widehat{\Sigma}}\) \(\newcommand{\lt}{<}\) \(\newcommand{\gt}{>}\) \(\newcommand{\amp}{&}\) \(\definecolor{fillinmathshade}{gray}{0.9}\)Universidad de Minnesota

La audición nos permite percibir el mundo de las vibraciones acústicas a nuestro alrededor, y nos proporciona nuestros canales de comunicación más importantes. Este módulo revisa los mecanismos básicos de la audición, comenzando por la anatomía y fisiología del oído y una breve revisión de las vías auditivas hasta la corteza auditiva. Un esquema de los atributos perceptuales básicos del sonido, incluyendo sonoridad, tono y timbre, es seguido por una revisión de los principios de organización tonotópica, establecidos en la cóclea. Una visión general del enmascaramiento y la selectividad de frecuencia es seguida por una revisión de la percepción y los mecanismos neuronales subyacentes a la audición espacial. Finalmente, se brinda una visión general del análisis de escenas auditivas, que aborda la importante cuestión de cómo el sistema auditivo es capaz de dar sentido a las complejas mezclas de sonidos que se encuentran en los entornos acústicos cotidianos.

objetivos de aprendizaje

- Describir los atributos auditivos básicos del sonido.

- Describir la estructura y función general de las vías auditivas desde el oído externo hasta la corteza auditiva.

- Discutir formas en las que somos capaces de localizar sonidos en el espacio.

- Describir diversas señales acústicas que contribuyen a nuestra capacidad de segregar perceptualmente sonidos que llegan simultáneamente.

La audición forma una parte crucial de nuestra vida cotidiana. La mayor parte de nuestra comunicación con los demás, vía el habla o la música, nos llega a través de los oídos. En efecto, un dicho, muchas veces atribuido a Helen Keller, es que la ceguera nos separa de las cosas, pero la sordera nos separa de las personas. Los oídos responden a la información acústica, o sonido, variaciones diminutas y rápidas en la presión del aire. Las ondas sonoras viajan desde la fuente y producen variaciones de presión en los canales auditivos del oyente, haciendo que los tímpanos (o membranas timpánicas) vibren. Este módulo proporciona una visión general de los eventos que siguen, que convierten estas simples vibraciones mecánicas en nuestra rica experiencia conocida como audición, o percepción auditiva.

Atributos perceptuales del sonido

Hay muchas maneras de describir un sonido, pero los atributos perceptuales de un sonido normalmente se pueden dividir en tres categorías principales: sonoridad, tono y timbre. Aunque los tres se refieren a la percepción, y no a los propios sonidos físicos, están fuertemente relacionados con diversas variables físicas.

Sonoridad

El correlato físico más directo de la sonoridad es la intensidad del sonido (o presión sonora) medida cerca del tímpano. Sin embargo, muchos otros factores también influyen en la sonoridad de un sonido, incluyendo su contenido de frecuencia, su duración y el contexto en el que se presenta. Algunos de los primeros estudios psicofísicos de la percepción auditiva, que se remontan a más de un siglo, tenían como objetivo examinar las relaciones entre el volumen percibido, la intensidad del sonido físico y las diferencias apenas perceptibles en el volumen (Fechner, 1860; Stevens, 1957). Se ha dedicado mucho tiempo y esfuerzo a refinar diversos métodos de medición. Estos métodos involucran técnicas como la estimación de magnitud, donde una serie de sonidos (a menudo sinusoides, o tonos puros de una sola frecuencia) se presentan secuencialmente a diferentes niveles de sonido, y se pide a los sujetos que asignen números a cada tono, correspondientes a la sonoridad percibida. Otros estudios han examinado cómo cambia la sonoridad en función de la frecuencia de un tono, dando como resultado el estándar internacional de contornos iso-loudness-level (ISO, 2003), que se utilizan en muchas áreas de la industria para evaluar problemas de ruido y molestias. Tales estudios han llevado al desarrollo de modelos computacionales que están diseñados para predecir la sonoridad de sonidos arbitrarios (e.g., Moore, Glasberg, & Baer, 1997).

Pitch

El tono juega un papel crucial en la comunicación acústica. Las variaciones de tono a lo largo del tiempo proporcionan la base de la melodía para la mayoría de los tipos de música; los contornos de tono en el habla nos proporcionan información prosódica importante en idiomas que no son tonos, como el inglés, y ayudan a definir el significado de las palabras en idiomas de tono, como el chino mandarín. El tono es esencialmente el correlato perceptual de la periodicidad de la forma de onda, o tasa de repetición: Cuanto más rápido se repite una forma de onda con el tiempo, mayor es su tono percibido. Los sonidos evocadores de tono más comunes se conocen como tonos complejos armónicos. Son complejos porque constan de más de una frecuencia, y son armónicos porque las frecuencias son todas múltiplos enteros de una frecuencia fundamental común (F0). Por ejemplo, un tono complejo armónico con un F0 de 100 Hz también contendría energía a frecuencias de 200, 300, 400 Hz, y así sucesivamente. Estas frecuencias más altas se conocen como armónicos o armónicos, y también juegan un papel importante en la determinación del tono de un sonido. De hecho, aunque la energía en el F0 esté ausente o enmascarada, generalmente todavía percibimos que el sonido restante tiene un tono correspondiente al F0. Este fenómeno es conocido como el “tono de lo fundamental faltante”, y ha jugado un papel importante en la formación de teorías y modelos sobre el tono (de Cheveigné, 2005). Escuchamos el tono con suficiente precisión para percibir melodías en un rango de F0 desde aproximadamente 30 Hz (Pressnitzer, Patterson, & Krumbholz, 2001) hasta aproximadamente 4—5 kHz (Attneave & Olson, 1971; Oxenham, Micheyl, Keebler, Loper, & Santurete, 2011). Este rango también corresponde bastante bien al rango que cubren los instrumentos musicales; por ejemplo, el piano de cola moderno tiene notas que se extienden de 27.5 Hz a 4.186 Hz. Somos capaces de discriminar cambios de frecuencia por encima de los 5,000 Hz, pero ya no somos muy precisos en reconocer melodías o juzgar intervalos musicales.

Timbre

Timbre se refiere a la calidad del sonido, y a menudo se describe usando palabras como brillante, opaco, áspero y hueco. Técnicamente, el timbre incluye cualquier cosa que nos permita distinguir dos sonidos que tienen la misma sonoridad, tono y duración. Por ejemplo, un violín y un piano tocando la misma nota suenan muy diferentes, en función de su calidad de sonido o timbre.

Un aspecto importante del timbre es el contenido espectral de un sonido. Los sonidos con más energía de alta frecuencia tienden a sonar más brillantes, más turbios o más duros que los sonidos con más contenido de baja frecuencia, que podrían describirse como profundos, ricos o aburridos. Otros aspectos importantes del timbre incluyen la envolvente temporal (o contorno) del sonido, especialmente cómo comienza y termina. Por ejemplo, un piano tiene un inicio rápido, o ataque, producido por el martillo golpeando la cuerda, mientras que el ataque de una nota de clarinete puede ser mucho más gradual. Cambiar artificialmente el inicio de una nota de piano, por ejemplo, tocando una grabación al revés, puede alterar dramáticamente su carácter para que ya no sea reconocible como una nota de piano. En general, el contenido espectral global y la envolvente temporal pueden proporcionar una buena primera aproximación a cualquier sonido, pero resulta que los cambios sutiles en el espectro a lo largo del tiempo (o variaciones espectrotemporales) son cruciales para crear imitaciones plausibles de instrumentos musicales naturales (Risset & Wessel, 1999).

Una visión general del sistema auditivo

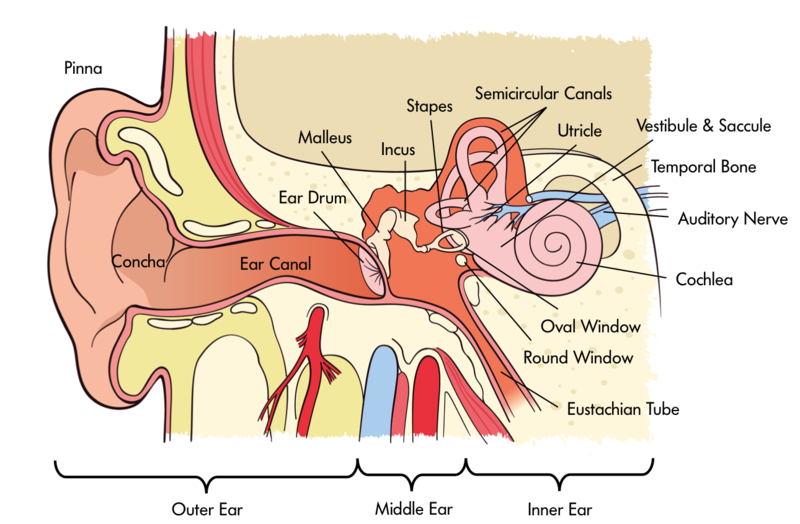

Nuestra percepción auditiva depende de cómo se procesa el sonido a través del oído. El oído se puede dividir en tres partes principales: el oído externo, medio e interno (ver Figura 8.4.1). El oído externo consiste en el pabellón auricular (la parte visible del oído, con todos sus pliegues y protuberancias únicas), el canal auditivo (o meato auditivo) y la membrana timpánica. Por supuesto, la mayoría de nosotros tenemos dos oídos funcionales, que resultan particularmente útiles cuando estamos tratando de averiguar de dónde viene un sonido. Como se analiza a continuación en la sección sobre audición espacial, nuestro cerebro puede comparar las sutiles diferencias en las señales en los dos oídos para localizar sonidos en el espacio. No obstante, este truco no siempre ayuda: por ejemplo, un sonido directamente delante o directamente detrás de ti no producirá una diferencia entre los oídos. En estos casos, el filtrado producido por las pinnas nos ayuda a localizar sonidos y resolver posibles confusiones front-back y up-down. De manera más general, los pliegues y protuberancias del pabellón auricular producen distintos picos y caídas en la respuesta de frecuencia que dependen de la ubicación de la fuente de sonido. Luego, el cerebro aprende a asociar ciertos patrones de picos espectrales y caídas con ciertas ubicaciones espaciales. Curiosamente, esta asociación aprendida sigue siendo maleable, o plástica, incluso en la edad adulta. Por ejemplo, un estudio que alteró las pinnas usando moldes encontró que las personas podían aprender a usar sus “nuevas” orejas con precisión en cuestión de unas semanas (Hofman, Van Riswick, & Van Opstal, 1998). Debido al pequeño tamaño del pabellón auricular, este tipo de señales acústicas solo se encuentran a altas frecuencias, por encima de aproximadamente 2 kHz. A frecuencias más bajas, el sonido es básicamente inalterado ya sea que provenga de arriba, de frente o de abajo. El canal auditivo en sí es un tubo que ayuda a amplificar el sonido en la región de aproximadamente 1 a 4 kHz, una región particularmente importante para la comunicación del habla.

El oído medio consiste en una cavidad llena de aire, que contiene los huesos del oído medio, conocidos como el incus, el maleo y el estribo, o yunque, martillo y estribo, debido a sus respectivas formas. Tienen la distinción de ser los huesos más pequeños del cuerpo. Su función principal es transmitir las vibraciones desde la membrana timpánica a la ventana oval de la cóclea y, a través de una forma de acción de palanca, ajustar mejor la impedancia del aire que rodea la membrana timpánica con la del fluido dentro de la cóclea.

El oído interno incluye la cóclea, encerrada en el hueso temporal del cráneo, en la que las vibraciones mecánicas del sonido son transducidas en señales neuronales que son procesadas por el cerebro. La cóclea es una estructura en forma de espiral que se llena de líquido. A lo largo de la espiral discurre la membrana basilar, la cual vibra en respuesta a las diferencias de presión producidas por las vibraciones de la ventana oval. Sentado sobre la membrana basilar se encuentra el órgano de Corti, que recorre toda la longitud de la membrana basilar desde la base (por la ventana oval) hasta el ápice (la “punta” de la espiral). El órgano de Corti incluye tres filas de células ciliadas externas y una fila de células ciliadas internas. Las células ciliadas perciben las vibraciones a través de sus diminutos pelos, o estereocillia. Las células ciliadas externas parecen funcionar para amplificar mecánicamente las vibraciones inducidas por el sonido, mientras que las células ciliadas internas forman sinapsis con el nervio auditivo y transducen esas vibraciones en potenciales de acción, o picos neuronales, que se transmiten a lo largo del nervio auditivo a centros superiores del auditivo vías.

Uno de los principios más importantes de la audiencia, el análisis de frecuencia, se establece en la cóclea. En cierto modo, la acción de la cóclea puede compararse con la de un prisma: las muchas frecuencias que componen un sonido complejo se descomponen en sus frecuencias constituyentes, con bajas frecuencias que crean máximas vibraciones basilar-membrana cerca del ápice de la cóclea y altas frecuencias que crean máxima basilar- vibraciones de membrana más cercanas a la base de la cóclea. Esta descomposición del sonido en sus frecuencias constituyentes, y el mapeo de frecuencia a lugar, o representación “tonotópica”, es un principio organizativo importante del sistema auditivo, y se mantiene en la representación neuronal de los sonidos desde la cóclea hasta la corteza auditiva primaria. La descomposición del sonido en sus componentes de frecuencia constituyentes es parte de lo que nos permite escuchar más de un sonido a la vez. Además de representar la frecuencia por lugar de excitación dentro de la cóclea, las frecuencias también están representadas por el momento de los picos dentro del nervio auditivo. Esta propiedad, conocida como “bloqueo de fase”, es crucial para comparar las diferencias de tiempo de llegada de las formas de onda entre los dos oídos (ver la sección sobre audición espacial, a continuación).

A diferencia de la visión, donde la corteza visual primaria (o V1) se considera una etapa temprana de procesamiento, las señales auditivas pasan por muchas etapas de procesamiento antes de que lleguen a la corteza auditiva primaria, ubicada en el lóbulo temporal. Aunque tenemos una comprensión bastante buena de las propiedades electromecánicas de la cóclea y sus diversas estructuras, nuestra comprensión del procesamiento realizado por etapas superiores de las vías auditivas sigue siendo algo incompleta. Con la posible excepción de la localización espacial y las neuronas sintonizadas a ciertas ubicaciones en el espacio (Harper & McAlpine, 2004; Knudsen & Konishi, 1978), hay muy poco consenso sobre el cómo, qué y dónde de la extracción y representación de rasgos auditivos. Existe evidencia de un “centro de tono” en la corteza auditiva tanto de estudios de neuroimagen humana (por ejemplo, Griffiths, Buchel, Frackowiak, & Patterson, 1998; Penagos, Melcher, & Oxenham, 2004) como de estudios de fisiología de una sola unidad (Bendor & Wang, 2005), pero incluso aquí quedan algunas preguntas sobre si una sola área de la corteza es responsable de codificar características individuales, como el tono, o si el código está más distribuido (Walker, Bizley, King, & Schnupp, 2011).

Audibilidad, enmascaramiento y selectividad de frecuencia

En general, la cóclea humana nos proporciona audición en un rango muy amplio de frecuencias. Los jóvenes con audición normal son capaces de percibir sonidos con frecuencias que van desde aproximadamente 20 Hz hasta 20 kHz. El rango de intensidades que podemos percibir también es impresionante: los sonidos más silenciosos que podemos escuchar en el rango de frecuencia media (entre aproximadamente 1 y 4 kHz) tienen una intensidad de sonido que es aproximadamente un factor de 1,000,000,000,000 menos intensa que el sonido más fuerte que podemos escuchar sin incurrir en rápidos y permanentes pérdida de audición. En parte debido a este enorme rango dinámico, tendemos a utilizar una escala logarítmica, conocida como decibelios (dB), para describir la presión o intensidad del sonido. En esta escala, el nivel de presión sonora (SPL) de 0 dB se define como 20 Micro-pascales (μPa), lo que corresponde aproximadamente al nivel de sonido perceptible más silencioso, y 120 dB SPL se considera peligrosamente ruidoso.

El enmascaramiento es el proceso por el cual la presencia de un sonido hace que otro sonido sea más difícil de escuchar. Todos nos encontramos con el enmascaramiento en nuestra vida cotidiana, cuando no escuchamos sonar el teléfono mientras nos duchamos, o cuando nos cuesta seguir una conversación en un restaurante ruidoso. En general, un sonido más intenso enmascarará un sonido menos intenso, siempre que se cumplan ciertas condiciones. La condición más importante es que el contenido de frecuencia de los sonidos se superponga, de tal manera que la actividad en la cóclea producida por un sonido de enmascaramiento “pantanos” que produce el sonido objetivo. Otro tipo de enmascaramiento, conocido como “supresión”, ocurre cuando la respuesta al enmascarador reduce la respuesta neuronal (y en algunos casos, la mecánica) al sonido objetivo. Debido a la forma en que funciona el filtrado en la cóclea, los sonidos de baja frecuencia tienen más probabilidades de enmascarar frecuencias altas que viceversa, particularmente a altas intensidades de sonido. Este aspecto asimétrico del enmascaramiento se conoce como la “propagación ascendente del enmascaramiento”. La pérdida de afinación coclear aguda que a menudo acompaña al daño coclear conduce a un filtrado más amplio y más enmascaramiento, un fenómeno fisiológico que probablemente contribuya a las dificultades que experimentan las personas con pérdida auditiva en entornos ruidosos (Moore, 2007).

Aunque mucho enmascaramiento puede explicarse en términos de interacciones dentro de la cóclea, existen otras formas que no se pueden explicar con tanta facilidad, y que pueden ocurrir incluso cuando las interacciones dentro de la cóclea son improbables. Estas formas más centrales de enmascaramiento vienen en diferentes formas, pero a menudo se han categorizado juntas bajo el término “enmascaramiento informativo” (Durlach et al., 2003; Watson & Kelly, 1978). Se sabe relativamente poco sobre las causas del enmascaramiento informativo, aunque la mayoría de las formas pueden atribuirse a una “fusión” perceptual del enmascarador y los sonidos objetivo, o al menos a una falla en la segregación del objetivo de los sonidos de enmascaramiento. También se sabe relativamente poco sobre el locus fisiológico del enmascaramiento informativo, excepto que al menos algunas formas parecen originarse en la corteza auditiva y no antes (Gutschalk, Micheyl, & Oxenham, 2008).

Audiencia espacial

A diferencia de la visión, tenemos un campo auditivo de 360°. Nuestra agudeza auditiva es, sin embargo, al menos un orden de magnitud peor que la visión en la localización de un objeto en el espacio. En consecuencia, nuestras habilidades de localización auditiva son más útiles para alertarnos y permitirnos orientarnos hacia las fuentes, con nuestro sentido visual generalmente proporcionando el análisis de grano más fino. Por supuesto, existen diferencias entre especies, y algunas, como las lechuzas comunes y los murciélagos ecolocalizantes, han desarrollado sistemas de localización sonora altamente especializados.

Nuestra capacidad para localizar fuentes de sonido en el espacio es una hazaña impresionante de computación neuronal. Las dos principales fuentes de información provienen ambas de una comparación de los sonidos en los dos oídos. El primero se basa en diferencias de tiempo interaurales (ITD) y se basa en el hecho de que una fuente de sonido a la izquierda generará un sonido que llegará al oído izquierdo ligeramente antes de que llegue al oído derecho. Aunque el sonido es mucho más lento que la luz, su velocidad todavía significa que las diferencias de tiempo de llegada entre los dos oídos es una fracción de milisegundo. Los ITD más grandes que encontramos en el mundo real (cuando los sonidos están directamente a la izquierda o a la derecha de nosotros) son solo un poco más de medio milisegundo. Con cierta práctica, los humanos pueden aprender a detectar un ITD de entre 10 y 20 μs (es decir, 20 millonésimas de segundo) (Klump & Eady, 1956).

La segunda fuente de información se basa en las diferencias de nivel interaural (ILD). A frecuencias más altas (superiores a aproximadamente 1 kHz), la cabeza proyecta una “sombra” acústica, de modo que cuando se presenta un sonido desde la izquierda, el nivel sonoro en el oído izquierdo es algo más alto que el nivel sonoro en el oído derecho. A frecuencias muy altas, el ILD puede ser de hasta 20 dB, y somos sensibles a diferencias tan pequeñas como 1 dB.

Como se mencionó brevemente en la discusión del oído externo, la información relativa a la elevación de una fuente de sonido, o si proviene de delante o detrás, está contenida en detalles espectrales de alta frecuencia que resultan de los efectos filtrantes de las pinnas.

En general, somos más sensibles a los ITD a bajas frecuencias (por debajo de aproximadamente 1.5 kHz). A frecuencias más altas todavía podemos percibir cambios en el tiempo basados en la envolvente temporal del sonido que varía lentamente pero no en la estructura fina temporal (Bernstein & Trahiotis, 2002; Smith, Delgutte, & Oxenham, 2002), tal vez debido a una pérdida de bloqueo de fase neural a la estructura fina temporal en frecuencias altas. En contraste, los ILD son más útiles a altas frecuencias, donde la sombra de la cabeza es mayor. Este uso de diferentes señales acústicas en diferentes regiones de frecuencia condujo a la clásica y muy temprana “teoría dúplex” de la localización del sonido (Rayleigh, 1907). Para sonidos cotidianos con amplio espectro de frecuencias, parece que nuestra percepción de la ubicación espacial está dominada por diferencias interaurales de tiempo en la estructura fina temporal de baja frecuencia (Macpherson & Middlebrooks, 2002).

Al igual que con la visión, nuestra percepción de la distancia depende en gran medida del contexto. Si escuchamos a alguien gritar a un nivel sonoro muy bajo, inferimos que el gritador debe estar muy lejos, a partir de nuestro conocimiento de las propiedades sonoras de los gritos. En habitaciones y otros lugares cerrados, la reverberación también puede proporcionar información sobre la distancia: A medida que un altavoz se aleja, el nivel de sonido directo disminuye pero el nivel de sonido de la reverberación permanece aproximadamente el mismo; por lo tanto, la relación de energía directa a reverberante disminuye (Zahorik y Wightman, 2001).

Análisis de Escena Auditiva

Por lo general, hay más de una fuente de sonido en el ambiente en cualquier momento; imagínese hablar con un amigo en un café, con algo de música de fondo sonando, el traqueteo de tazas de café detrás del mostrador, el tráfico afuera y una conversación en la mesa al lado de la suya. Todas estas fuentes producen ondas sonoras que se combinan para formar una sola forma de onda compleja en el tímpano, cuya forma puede tener muy poca relación con cualquiera de las ondas producidas por las fuentes de sonido individuales. De alguna manera el sistema auditivo es capaz de descomponer, o descomponer, estas complejas formas de onda y nos permiten darle sentido a nuestro entorno acústico formando “objetos” auditivos separados o “corrientes”, que podemos seguir a medida que los sonidos se despliegan a lo largo del tiempo (Bregman, 1990).

Se han formulado varios principios heurísticos para describir cómo los elementos sonoros se agrupan para formar un solo objeto o se segregan para formar múltiples objetos. Muchos de estos se originan a partir de las primeras ideas propuestas en visión por los llamados psicólogos de la Gestalt, como Max Wertheimer. Según estas reglas generales, los sonidos que están muy cerca, en tiempo o frecuencia, tienden a agruparse. Además, los sonidos que comienzan y terminan al mismo tiempo tienden a formar un solo objeto auditivo. Curiosamente, la ubicación espacial no siempre es una señal de agrupación fuerte o confiable, quizás porque la información de ubicación de componentes de frecuencia individuales a menudo es ambigua debido a los efectos de la reverberación. Varios estudios han analizado la importancia relativa de diferentes señales “intercambiando” una señal contra otra. En algunos casos, esto ha llevado al descubrimiento de interesantes ilusiones auditivas, donde melodías que no están presentes en los sonidos presentados a cualquiera de los oídos emergen en la percepción (Deutsch, 1979), o donde un elemento sonoro se “pierde” perceptualmente en organizaciones perceptuales competitivas (Shinn-Cunningham, Lee, & Oxenham, 2007).

Los intentos más recientes han utilizado enfoques computacionales y de base neutra para descubrir los mecanismos del análisis de escenas auditivas (por ejemplo, Elhilali, Ma, Micheyl, Oxenham, & Shamma, 2009), y el campo del análisis computacional de escenas auditivas (CASA) ha surgido en parte como un esfuerzo para avanzar hacia más enfoques basados en principios y menos heurísticos para comprender el análisis y la percepción de escenas auditivas complejas (e.g., Wang & Brown, 2006). Resolver este problema no solo nos proporcionará una mejor comprensión de la percepción auditiva humana, sino que puede proporcionar nuevos enfoques para los audífonos e implantes cocleares “inteligentes”, así como sistemas automáticos de reconocimiento del habla que son más robustos al ruido de fondo.

Conclusión

La audición nos proporciona nuestra conexión más importante con las personas que nos rodean. La intrincada fisiología del sistema auditivo transforma las pequeñas variaciones en la presión del aire que llegan a nuestro oído en la amplia gama de experiencias auditivas que percibimos como el habla, la música y los sonidos del entorno que nos rodea. Apenas estamos comenzando a comprender los principios básicos de la codificación neuronal en etapas superiores del sistema auditivo, y cómo se relacionan con la percepción. Sin embargo, incluso nuestra comprensión rudimentaria ha mejorado la vida de cientos de miles a través de dispositivos como los implantes cocleares, que recrean algunas de las funciones del oído para personas con pérdida auditiva profunda.

Recursos externos

- Audio: Demostraciones auditivas del laboratorio de Richard Warren en la Universidad de Wisconsin, Milwaukee

- www4.uwm.edu/APL/demostraciones.html

- Audio: Demostraciones Auditivas. CD publicado por la Sociedad Acústica de América (ASA). Puedes escuchar las demostraciones aquí

- www.feilding.net/sfuad/musi30... 1/demos/audio/

- Web: Demostraciones e ilustraciones de mecánica coclear se pueden encontrar aquí

- http://lab.rockefeller.edu/hudspeth/...calSimulations

- Web: Más demostraciones e ilustraciones de mecánica coclear

- www.neurophys.wisc.edu/animations/

Preguntas de Discusión

- Con base en las señales acústicas disponibles, ¿qué tan buenos crees que somos para juzgar si un sonido de baja frecuencia viene de delante o detrás de nosotros? ¿Cómo podríamos resolver este problema en el mundo real?

- Las células ciliadas externas contribuyen no solo a la amplificación sino también a la sintonización de frecuencia en la cóclea. ¿Cuáles son algunas de las dificultades que pueden surgir para las personas con pérdida auditiva coclear, debido a estos dos factores? ¿Por qué los audífonos no resuelven todos estos problemas?

- ¿Por qué crees que el sistema auditivo tiene tantas etapas de procesamiento antes de que las señales lleguen a la corteza auditiva, en comparación con el sistema visual? ¿Hay alguna diferencia en la velocidad de procesamiento requerida?

El vocabulario

- Cóclea

- Órgano en forma de concha de caracol que transduce vibraciones mecánicas en señales neuronales.

- Diferencias interaurales

- Diferencias (generalmente en tiempo o intensidad) entre las dos orejas.

- Pinna

- Parte visible del oído externo.

- Membrana timpánica

- Tambor, que separa el oído externo del oído medio.

Referencias

- Attneave, F., & Olson, R. K. (1971). El tono como medio: Una nueva aproximación al escalado psicofísico. American Journal of Psychology, 84, 147—166.

- Bendor, D., & Wang, X. (2005). La representación neuronal del tono en la corteza auditiva de primates. Naturaleza, 436, 1161—1165.

- Bernstein, L. R., & Trahiotis, C. (2002). Mejora de la sensibilidad a los retardos interaurales a altas frecuencias mediante el uso de “estímulos transpuestos”. Revista de la Sociedad Acústica de América, 112, 1026—1036.

- Bregman, A. S. (1990). Análisis de escena auditiva: La organización perceptual del sonido. Cambridge, MA: Prensa MIT.

- Deutsch, D. (1979). Integración binaural de patrones melódicos. Percepción y Psicofísica, 25, 399—405.

- Durlach, N. I., Mason, C. R., Kidd, G., Jr., Arbogast, T. L., Colburn, H. S., & Shinn-Cunningham, B. G. (2003). Nota sobre el enmascaramiento informativo. Revista de la Sociedad Acústica de América, 113, 2984—2987.

- Elhilali, M., Ma, L., Micheyl, C., Oxenham, A. J., & Shamma, S. (2009). Coherencia temporal en la organización perceptual y representación cortical de escenas auditivas. Neurona, 61, 317—329.

- Fechner, G. T. (1860). Elemente der Psychophysik (Vol. 1). Leipzig, Alemania: Breitkopf und Haertl.

- Griffiths, T. D., Buchel, C., Frackowiak, R. S., & Patterson, R. D. (1998). Análisis de la estructura temporal en el sonido por el cerebro humano. Naturaleza Neurociencia, 1, 422—427.

- Gutschalk, A., Micheyl, C., & Oxenham, A. J. (2008). Correlatos neuronales de la conciencia perceptual auditiva bajo enmascaramiento informativo. PLoS Biology, 6, 1156—1165 (e1138).

- Harper, N. S., & McAlpine, D. (2004). Codificación óptima de población neural de una señal espacial auditiva. Naturaleza, 430, 682—686.

- Hofman, P. M., Van Riswick, J. G. A., & Van Opstal, A. J. (1998). Reaprendizaje de la localización del sonido con nuevos oídos. Naturaleza Neurociencia, 1, 417—421.

- ISO. (2003). ISO:226 Acústica - Contornos normales de igual nivel de loudness. Ginebra, Suiza: Organización Internacional de Normalización.

- Klump, R. G., & Eady, H. R. (1956). Algunas mediciones de umbrales de diferencia de tiempo interaural. Revista de la Sociedad Acústica de América, 28, 859—860.

- Knudsen, E. I., & Konishi, M. (1978). Un mapa neural del espacio auditivo en el búho. Ciencia, 200, 795—797.

- Macpherson, E. A., & Middlebrooks, J. C. (2002). Ponderación del oyente de las señales para el ángulo lateral: La teoría dúplex de la localización del sonido revisitada. Revista de la Sociedad Acústica de América, 111, 2219—2236.

- Moore, B. C. J. (2007). Hipoacusia coclear: Problemas fisiológicos, psicológicos y técnicos. Chichester: Wiley.

- Moore, B. C. J., Glasberg, B. R., & Baer, T. (1997). Un modelo para la predicción de umbrales, sonoridad y sonoridad parcial. Revista de la Sociedad de Ingeniería de Audio, 45, 224—240.

- Oxenham, A. J., Micheyl, C., Keebler, M. V., Loper, A., & Santurete, S. (2011). Percepción de tono más allá de la región de existencia tradicional del tono Actas de la Academia Nacional de Ciencias USA, 108, 7629—7634.

- Penagos, H., Melcher, J. R., & Oxenham, A. J. (2004). Una representación neural de la prominencia de tono en la corteza auditiva humana no primaria revelada con fMRI. Revista de Neurociencia, 24, 6810—6815.

- Pressnitzer, D., Patterson, R. D., & Krumbholz, K. (2001). El límite inferior de tono melódico. Revista de la Sociedad Acústica de América, 109, 2074—2084.

- Rayleigh, L. (1907). Sobre nuestra percepción de la dirección del sonido. Revista Filosófica, 13, 214—232.

- Risset, J. C., & Wessel, D. L. (1999). Exploración del timbre por análisis y síntesis. En D. Deutsch (Ed.), La psicología de la música (2a ed., pp. 113—168): Prensa académica.

- Shinn-Cunningham, B. G., Lee, A. K., & Oxenham, A. J. (2007). Un elemento sonoro se pierde en la competencia perceptual. Actas de la Academia Nacional de Ciencias USA, 104, 12223—12227.

- Smith, Z. M., Delgutte, B., & Oxenham, A. J. (2002). Los sonidos quiméricos revelan dicotomías en la percepción auditiva. Naturaleza, 416, 87—90.

- Stevens, S. S. (1957). Sobre la ley psicofísica. Revisión Psicológica, 64, 153—181.

- Walker, K. M., Bizley, J. K., King, A. J., & Schnupp, J. W. (2011). Representaciones multiplexadas y robustas de características sonoras en corteza auditiva. Revista de Neurociencia, 31, 14565—14576.

- Wang, D., & Brown, G. J. (Eds.). (2006). Análisis computacional de escenas auditivas: Principios, algoritmos y aplicaciones. Hoboken, NJ: Wiley.

- Watson, C. S., & Kelly, W. J. (1978). Enmascaramiento informativo en patrones auditivos. Revista de la Sociedad Acústica de América, 64, S39.

- Zahorik, P., & Wightman, F. L. (2001). Constancia de sonoridad con distancia de fuente de sonido variable. Naturaleza Neurociencia, 4, 78—83.

- de Cheveigné, A. (2005). Modelos de percepción de tono. En C. J. Plack, A. J. Oxenham, A. N. Popper, & R. Fay (Eds.), Pitch: Neural coding and perception (pp. 169—233). Nueva York, NY: Springer Verlag.