4.3: Algunas propiedades importantes de los eventos

- Page ID

- 75183

Si conocemos las probabilidades de los posibles resultados de un ensayo, podemos calcular las probabilidades de combinaciones de resultados. Estos cálculos se basan en dos reglas, a las que llamamos las leyes de la probabilidad. Si dividimos los resultados en eventos exhaustivos y mutuamente excluyentes, las leyes de probabilidad también se aplican a los eventos. Ya que, como los definimos, “eventos” es un término más general que “resultados”, los llamamos la ley de la probabilidad de eventos alternativos y la ley de la probabilidad de eventos compuestos. Estas leyes son válidas siempre y cuando se cumplan tres condiciones. Ya hemos discutido las dos primeras de estas condiciones, que son que los resultados posibles en cualquier ensayo individual deben ser exhaustivos y mutuamente excluyentes. La tercera condición es que, si hacemos más de un ensayo, los resultados deben ser independientes; es decir, el resultado de un ensayo no debe estar influenciado por los resultados de los demás.

Podemos ver las leyes de probabilidad como reglas para inferir información sobre combinaciones de eventos. La ley de probabilidad de eventos alternativos se aplica a los eventos que pertenecen a la misma distribución. La ley de probabilidad de eventos compuestos se aplica a los eventos que pueden provenir de una o más distribuciones. Un caso especial importante ocurre cuando los eventos compuestos son muestreos\(N\) sucesivos de una distribución dada que identificamos como la distribución principal. Si la variable aleatoria es un número, y promediamos los números que obtenemos de muestreos\(N\) sucesivos de la distribución padre, estos “promedios de-\(N\)” en sí mismos constituyen una distribución. Si conocemos ciertas propiedades de la distribución padre, podemos calcular las propiedades correspondientes de la “distribución de promedios de-\(N\) valores obtenidos por muestreo de la distribución padre”. Estos cálculos están especificados por el teorema del límite central, que discutimos en la Sección 3.11.

En general, cuando combinamos eventos de dos distribuciones, podemos ver el resultado como un evento que pertenece a una tercera distribución. En el primer encuentro, la idea de combinar eventos y distribuciones puede parecer esotérica. Algunos ejemplos sirven para mostrar que lo que tenemos en mente es muy sencillo.

Dado que un evento es un conjunto de resultados, un evento ocurre cada vez que ocurre alguno de los resultados en el conjunto. La división de los resultados de lanzar un dado en “resultados pares” y “resultados impares” ilustra esta idea. El evento “resultado uniforme” ocurre siempre que el resultado de un juicio sea\(2\),\(4,\) o\(6\). La probabilidad de un evento se puede calcular a partir de las probabilidades de los resultados subyacentes. Llamamos a la regla para este cálculo la ley de las probabilidades de eventos alternativos. (Aquí creamos la oportunidad de confusión porque estamos ilustrando la idea de eventos alternativos usando un ejemplo en el que llamamos a las alternativas “resultados alternativos” en lugar de “eventos alternativos”. Debemos recordar que “evento” es un término más general que “resultado”. Una posible partición es aquella que asigna cada resultado a su propio evento.) A continuación se discuten las probabilidades de eventos alternativos.

Para ilustrar la idea de eventos compuestos, consideremos una primera distribución que comprende “lanzar una moneda” y una segunda distribución que comprende “sacar una carta de una baraja de póquer”. La primera distribución tiene dos posibles resultados; la segunda distribución tiene\(52\) posibles resultados. Si combinamos estas distribuciones, creamos una tercera distribución que comprende “lanzar una moneda y sacar una carta de una baraja de póquer”. La tercera distribución tiene\(104\) posibles resultados. Si conocemos las probabilidades de los resultados de la primera distribución y las probabilidades de los resultados de la segunda distribución, y estas probabilidades son independientes entre sí, podemos calcular la probabilidad de cualquier resultado que pertenezca a la tercera distribución. Llamamos a la regla para este cálculo la ley de la probabilidad de eventos compuestos. Lo discutimos más adelante.

Una situación similar ocurre cuando consideramos los resultados de lanzar dos monedas. Suponemos que podemos distinguir las dos monedas por separado. Llámalos moneda\(1\) y moneda\(2\). Designamos cabezas y colas para monedas\(1\) y\(2\) como\(H_1\),\(T_1\),\(H_2\), y\(T_2\), respectivamente. Hay cuatro posibles resultados en la distribución que llamamos “lanzando dos monedas:”\(H_1H_2\),\(H_1T_2\),\(T_1H_2\), y\(T_1T_2\). (Si no pudiéramos distinguir las monedas aparte,\(H_1T_2\) sería lo mismo que\(T_1H_2\); sólo habría tres posibles resultados.) Podemos ver la distribución “lanzar dos monedas” como una combinación de las dos distribuciones que podemos llamar “lanzar moneda\(1\)” y “lanzar moneda”\(\ 2\). También podemos ver la distribución “lanzar dos monedas” como una combinación de dos distribuciones que llamamos “lanzar una moneda por primera vez” y “lanzar una moneda por segunda vez”. Consideramos la distribución “lanzando dos monedas” como equivalente a la distribución “lanzando una moneda dos veces”. Este es un ejemplo de ensayos repetidos, que es un tipo de distribución frecuente. En general, llamamos a tal distribución una “distribución de eventos de un ensayo repetido N veces”, y consideramos que esta distribución es completamente equivalente a N ensayos simultáneos del mismo tipo. El capítulo 19 considera la distribución de los resultados cuando un ensayo se repite muchas veces. Comprender las propiedades de tales distribuciones es el elemento más esencial para entender la teoría de la termodinámica estadística. El teorema del límite central relaciona las propiedades de la distribución de ensayos repetidos con las propiedades de la distribución padre.

La probabilidad de eventos alternativos

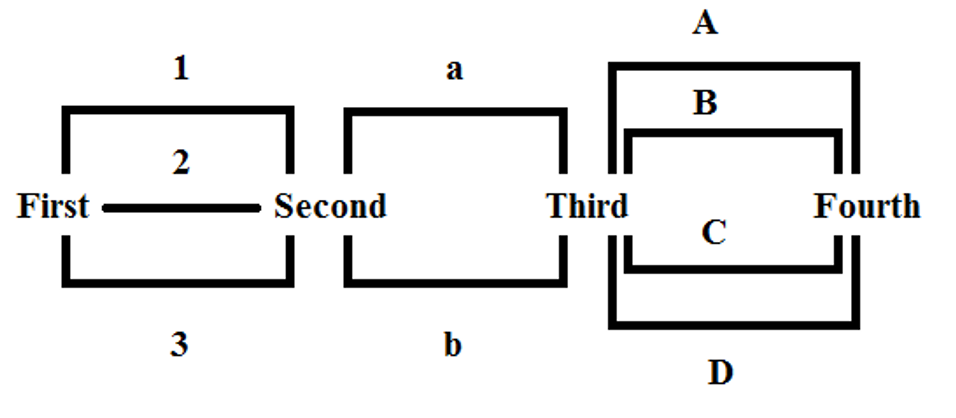

Si conocemos la probabilidad de cada uno de dos eventos mutuamente excluyentes que pertenecen a un conjunto exhaustivo, la probabilidad de que uno u otro de ellos ocurra en un solo ensayo es igual a la suma de las probabilidades individuales. Llamemos a los eventos independientes A y B, y representemos sus probabilidades como\(P(A)\) y\(P(B)\), respectivamente. La probabilidad de que ocurra uno de estos eventos es lo mismo que la probabilidad de que ocurra A o B ocurre. Podemos representar esta probabilidad como\(P(A\ or\ B)\). La probabilidad de esta combinación de eventos es la suma:\(P(A)+P(B)\). Es decir,

\[P\left(A\ or\ B\right)=P\left(A\right)+P(B)\]

Arriba definimos Y como el evento de que un solo tirada de un dado surge\(1\) o bien\(3\). Porque cada uno de estos resultados es uno de seis, mutuamente exclusivo, resultados igualmente probables, la probabilidad de cualquiera de ellos es\({1}/{6}\):\(P\left(tossing\ a\ 1\right)=P\left(tossing\ a\ 3\right)\)\(={1}/{6}\). De la ley de la probabilidad de eventos alternativos, tenemos

\[\begin{align*} P\left(event\ Y\right) &=(tossing\ a\ 1\ or\ tossing\ a\ 3) \\[4pt] &=P\left(tossing\ a\ 1\right)\ or P\left(tossing\ a\ 3\right) \\[4pt] &= {1}/{6}+{1}/{6} \\[4pt] &={2}/{6} \end{align*}\]

Definimos\(X\) como el suceso de que un solo tirada de un dado surja parejo. De la ley de la probabilidad de eventos alternativos, tenemos

\[\begin{align*} P\left(event\ X\right) &=P\left(tossing\ 2\ or\ 4\ or\ 6\right) \\[4pt] &=P\left(tossing\ a\ 2\right)+P\left(tossing\ a\ 4\right)+P\left(tossing\ a\ 6\right) \\[4pt] &={3}/{6} \end{align*}\]

Definimos\(Z\) como el evento que surge un solo tirada\(5\).

\[P\left(event\ Z\right)=P\left(tossing\ a\ 5\right)=1/6\]

Si hay eventos\(\omega\) independientes (denotados\(E_1,E_2,\dots ,E_i,\dots ,E_{\omega }\)), la ley de probabilidad de eventos alternativos afirma que la probabilidad de que uno de estos eventos ocurra en un solo juicio es

\[ \begin{align*} P\left(E_1\ or\ E_2\ or\dots E_i\dots or\ E_{\omega }\right) &=P\left(E_1\right)+P\left(E_2\right)+\dots +P\left(E_i\right)+\dots +P\left(E_{\omega }\right) \\[4pt] &=\sum^{\omega }_{i=1} P\left(E_i\right) \end{align*}\]

Si estos eventos\(\omega\) independientes abarcan todos los resultados posibles, la suma de sus probabilidades individuales debe ser la unidad.

La probabilidad de eventos compuestos

Supongamos ahora que hacemos dos juicios en circunstancias en las que el hecho\(A\) es posible en el primer juicio y el suceso\(B\) es posible en el segundo juicio. Representamos las probabilidades de estos eventos por\(P\left(A\right)\)\(P(B)\) y estipulamos que son independientes entre sí; es decir, la probabilidad que\(B\) ocurre en el segundo juicio es independiente del resultado del primer juicio. Entonces, la probabilidad que\(A\) ocurre en el primer ensayo y\(B\) ocurre en el segundo ensayo\(P(A\ and\ B)\),, es igual al producto de las probabilidades individuales.

\[P\left(A\ and\ B\right)=P\left(A\right)\times P(B)\]

Para ilustrar esto usando los resultados del lanzamiento de matrices, supongamos que el evento\(A\) está arrojando un\(1\) y el evento\(B\) está arrojando un\(3\). Entonces,\(P\left(A\right)={1}/{6}\) y\(P\left(B\right)={1}/{6}\). La probabilidad de lanzar un 1 en un primer ensayo y lanzar un\(3\) en un segundo juicio es entonces

\[\begin{align*} P\left( \text{tossing a 1 first and tossing a 3 second}\right) &=P\left(\text{tossing a 1}\right)\times P\left(\text{tossing a 3}\right) \\[4pt] &={1}/{6}\times {1}/{6} \\[4pt] &={1}/{36} \end{align*}\]

Si queremos la probabilidad de obtener uno\(1\) y uno\(3\) de cada dos tiradas, debemos sumar a esto la probabilidad de lanzar un\(3\) primero y un\(1\) segundo.

Si hay eventos\(\omega\) independientes (denotados\(E_1,E_2,\dots ,E_i,\dots ,E_{\omega }\)), la ley de probabilidad de eventos compuestos afirma que la probabilidad que\(E_1\) ocurrirá en un primer juicio, y\(E_2\) ocurrirá en un segundo juicio, etc., es

\[\begin{align*} P\left(E_1\ and\ E_2\ and\dots E_i\dots and\ E_{\omega }\right) &=P\left(E_1\right)\times P\left(E_2\right)\times \dots \times P\left(E_i\right)\times \dots \times P\left(E_{\omega }\right)\\[4pt] &=\prod^{\omega }_{i=1}{P(E_i)} \end{align*}\]